| [1] |

MARR D. Vision: A Computational Investigation into the Human Representation and Processing of Visual Information[M]. New York: W. H. Freeman, 1982.

|

| [2] |

OHZAWA I, DEANGELIS G C, and FREEMAN R D. Stereoscopic depth discrimination in the visual cortex: Neurons ideally suited as disparity detectors[J]. Science, 1990, 249(4972): 1037–1041. doi: 10.1126/science.2396096

|

| [3] |

HAEFNER R M and CUMMING B G. Adaptation to natural binocular disparities in primate V1 explained by a generalized energy model[J]. Neuron, 2008, 57(1): 147–158. doi: 10.1016/j.neuron.2007.10.042

|

| [4] |

BRENNER E and SMEETS J B. Depth Perception[M]. WIXTED J. Stevens’ Handbook of Experimental Psychology and Cognitive Neuroscience: Sensation, Perception, and Attention. 4th ed. New York: John Wiley & Sons, 2018: 385–414.

|

| [5] |

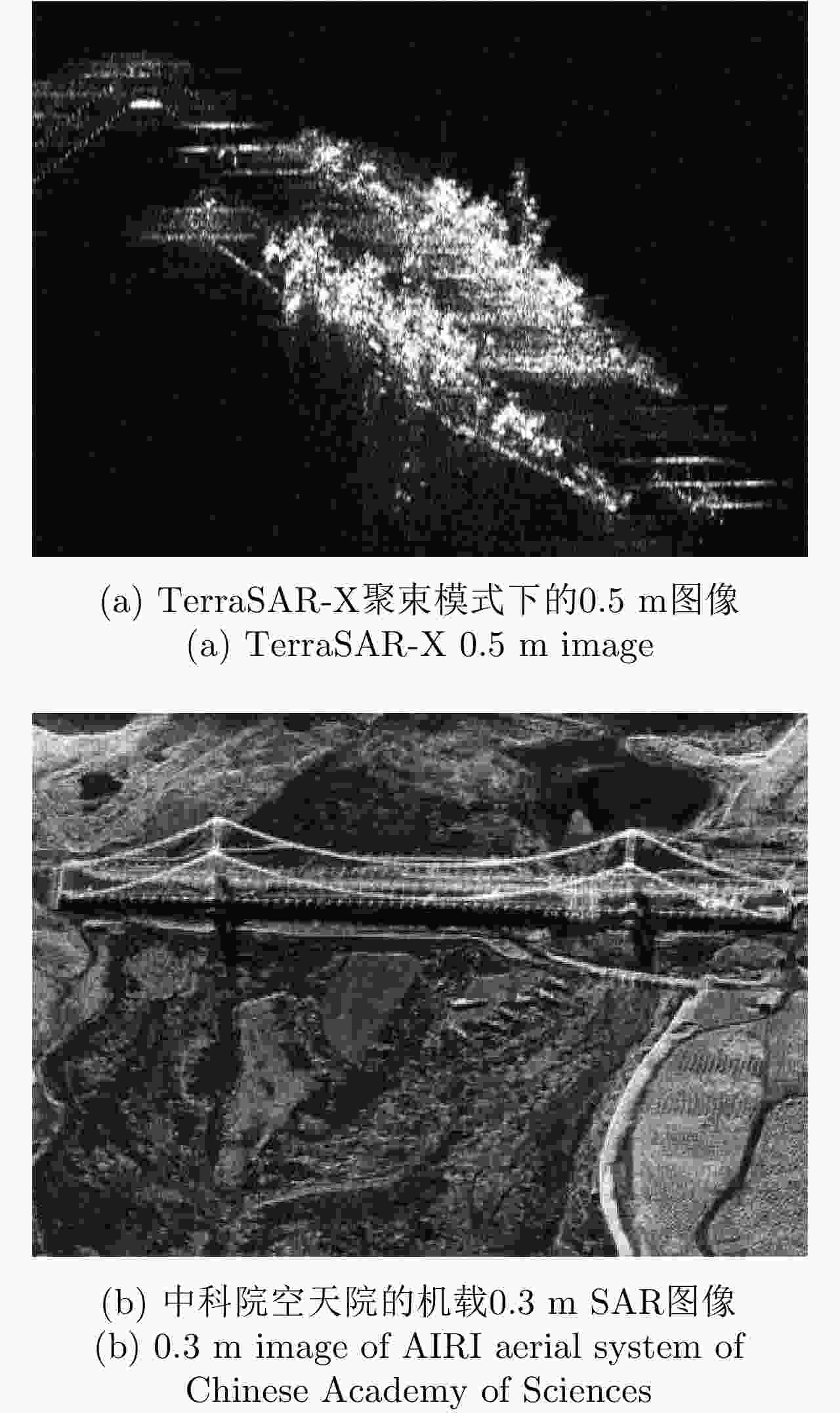

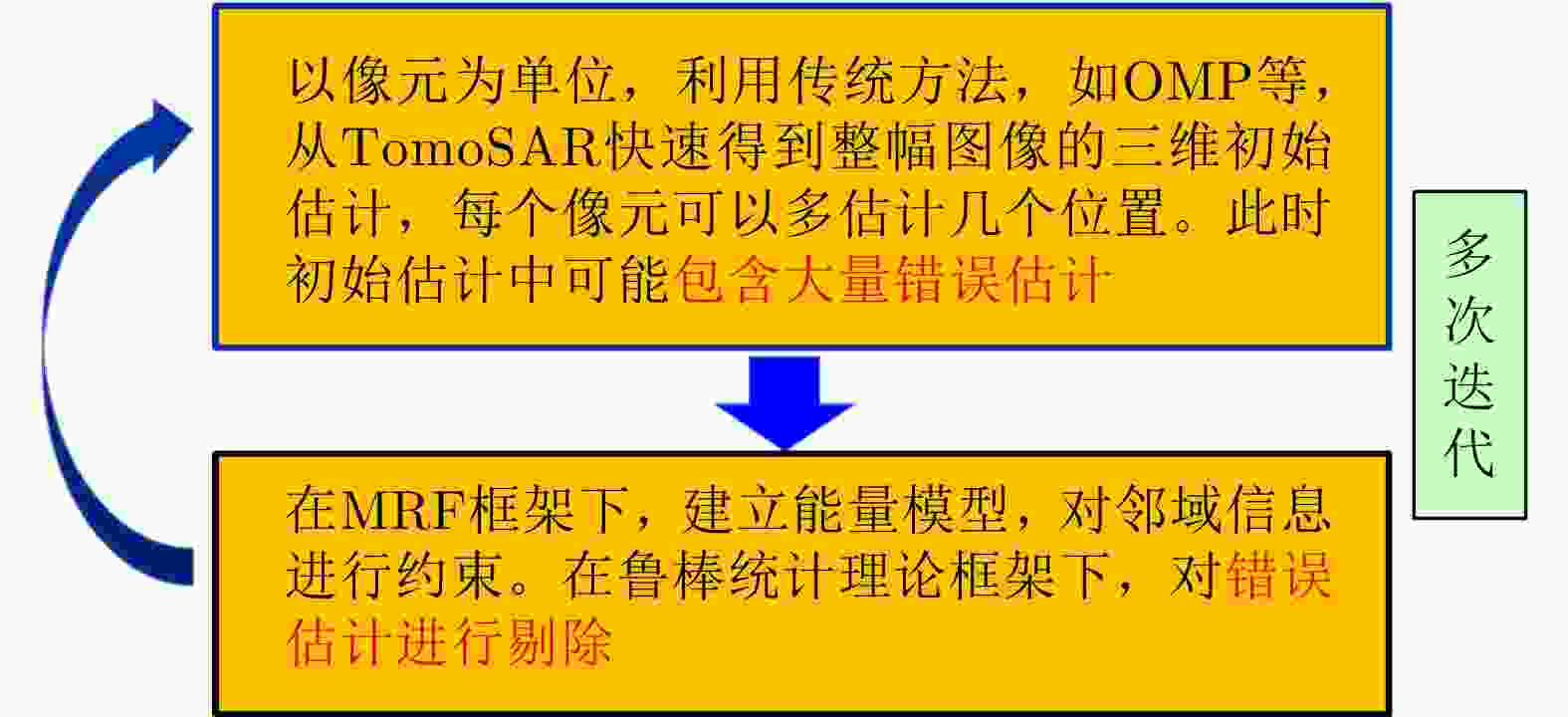

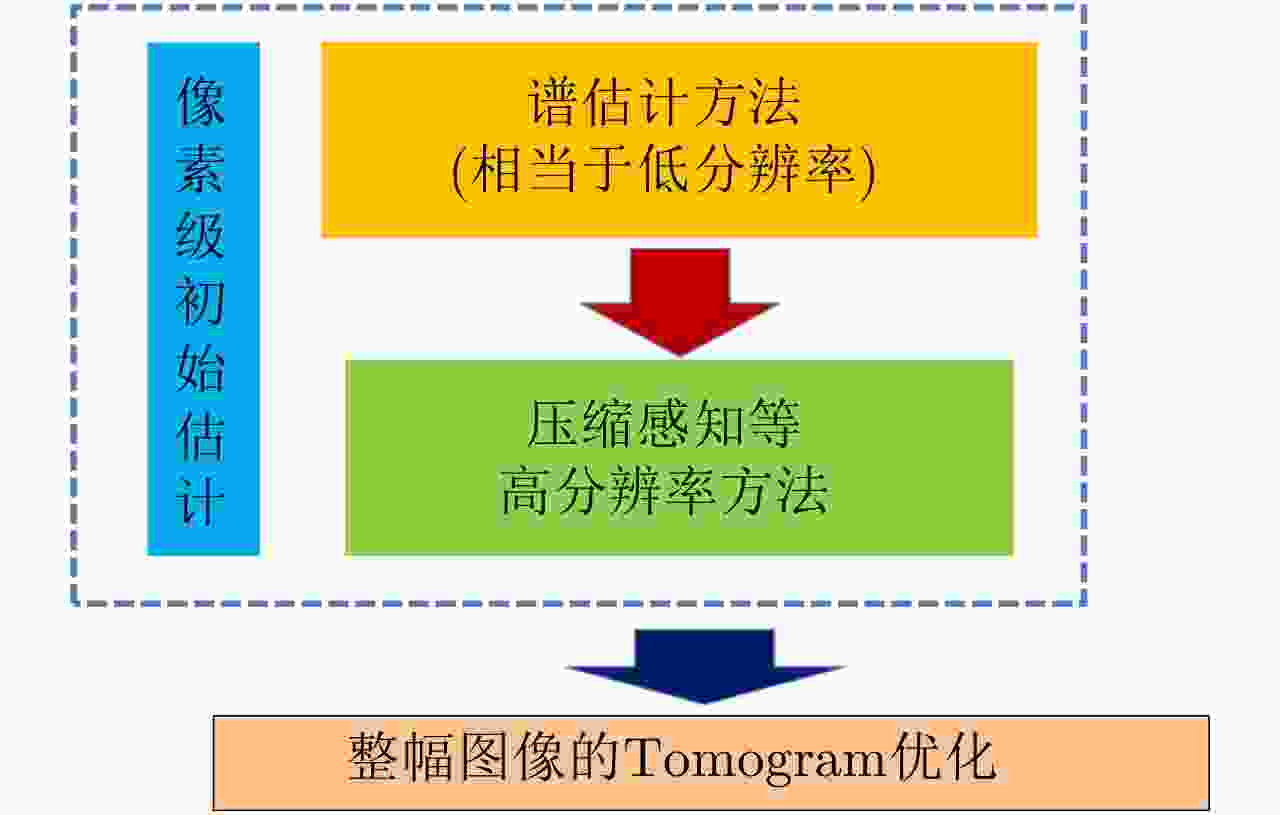

丁赤飚, 仇晓兰, 徐丰, 等. 合成孔径雷达三维成像——从层析、阵列到微波视觉[J]. 雷达学报, 2019, 8(6): 693–709. doi: 10.12000/JR19090DING Chibiao, QIU Xiaolan, XU Feng, et al. Synthetic aperture radar three-dimensional imaging—from TomoSAR and array InSAR to microwave vision[J]. Journal of Radars, 2019, 8(6): 693–709. doi: 10.12000/JR19090

|

| [6] |

DEL CAMPO G M, NANNINI M, and REIGBER A. Statistical regularization for enhanced TomoSAR imaging[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2020, 13: 1567–1589. doi: 10.1109/JSTARS.2020.2970595

|

| [7] |

ZHU Xiaoxiang and BAMLER R. Tomographic SAR inversion by L1-norm regularization—The compressive sensing approach[J]. IEEE Transactions on Geoscience and Remote Sensing, 2010, 48(10): 3839–3846. doi: 10.1109/TGRS.2010.2048117

|

| [8] |

RAMBOUR C, DENIS L, TUPIN F, et al. Introducing spatial regularization in SAR tomography reconstruction[J]. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(11): 8600–8617. doi: 10.1109/TGRS.2019.2921756

|

| [9] |

VIOLA P and JONES M. Rapid object detection using a boosted cascade of simple features[C]. 2001 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, Kauai, USA, 2001: I–I. doi: 10.1109/CVPR.2001.990517.

|

| [10] |

FISCHLER M A and BOLLES R C. Random sample consensus: A paradigm for model fitting with applications to image analysis and automated cartography[J]. Communications of the ACM, 1981, 24(6): 381–395. doi: 10.1145/358669.358692

|

| [11] |

RAMBOUR C, DENIS L, TUPIN F, et al. Urban surface reconstruction in SAR tomography by graph-cuts[J]. Computer Vision and Image Understanding, 2019, 188: 102791. doi: 10.1016/j.cviu.2019.07.011

|

| [12] |

LINDEBERG T. Scale-space[M]. WAH B W. Wiley Encyclopedia of Computer Science and Engineering. Hoboken: John Wiley & Sons, Inc. , 2008: 2495–2504. doi: 10.1002/9780470050118.ecse609.

|

| [13] |

CUI Hainan, GAO Xiang, SHNE Shuhan, et al. HSfM: Hybrid Structure-from-motion[C]. 2017 IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, USA, 2017: 2393–2402. doi: 10.1109/CVPR.2017.257.

|

| [14] |

LOWE D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision, 2004, 60(2): 91–110. doi: 10.1023/B:VISI.0000029664.99615.94

|

| [15] |

KOLMOGOROV V and ZABIN R. What energy functions can be minimized via graph cuts?[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2004, 26(2): 147–159. doi: 10.1109/TPAMI.2004.1262177

|

| [16] |

COSTANTE G, CIARFUGLIA T A, and BIONDI F. Towards monocular digital elevation model (DEM) estimation by convolutional neural networks - Application on synthetic aperture radar images[J]. arXiv: 1803.05387, 2018: 1–6.

|

| [17] |

BUDILLON A, JOHNSY A C, SCHIRINZI G, et al. SAR tomography based on deep learning[C]. 2019 IEEE International Geoscience and Remote Sensing Symposium, Yokohama, Japan, 2019: 3625–3628. doi: 10.1109/IGARSS.2019.8900616.

|

| [18] |

WU Chunxiao, ZHANG Zenghui, CHEN Longyong, et al. Super-resolution for MIMO array SAR 3-D imaging based on compressive sensing and deep neural network[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2020, 13: 3109–3124. doi: 10.1109/JSTARS.2020.3000760

|

| [19] |

XU Dan, RICCI E, OUYANG Wanli, et al. Multi-scale continuous CRFs as sequential deep networks for monocular depth estimation[C]. 2017 IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, USA, 2017: 161–169. doi: 10.1109/CVPR.2017.25.

|

| [20] |

WANG Yuanyuan and ZHU Xiaoxiang. SAR tomography via nonlinear blind scatterer separation[J]. IEEE Transactions on Geoscience and Remote Sensing, 2021, 59(7): 5751–5763. doi: 10.1109/TGRS.2020.3022209

|

| [21] |

FORNARO G, VERDE S, REALE D, et al. CAESAR: An approach based on covariance matrix decomposition to improve multibaseline-multitemporal interferometric SAR processing[J]. IEEE Transactions on Geoscience and Remote Sensing, 2015, 53(4): 2050–2065. doi: 10.1109/TGRS.2014.2352853

|

作者中心

作者中心 专家审稿

专家审稿 责编办公

责编办公 编辑办公

编辑办公

下载:

下载: