- Home

-

Articles & Issues

-

Data

- Dataset of Radar Detecting Sea

- SAR Dataset

- SARGroundObjectsTypes

- SARMV3D

- 3DRIED

- UWB-HA4D

- LLS-LFMCWR

- FAIR-CSAR

- FUSAR

- MSAR

- SDD-SAR

- DatasetinthePaper

- SpaceborneSAR3Dimaging

- DatasetintheCompetition

- Sea-land Segmentation

- SAR-Airport

- Hilly and mountainous farmland time-series SAR and ground quadrat dataset

-

Report

-

Course

-

About

-

Publish

- Editorial Board

- Chinese

| Citation: | DING Chuanwei, LIU Zhilin, ZHANG Li, et al. Tangential human posture recognition with sequential images based on MIMO radar[J]. Journal of Radars, 2025, 14(1): 151–167. doi: 10.12000/JR24116 |

Tangential Human Posture Recognition with Sequential Images Based on MIMO Radar

DOI: 10.12000/JR24116 CSTR: 32380.14.JR24116

More Information-

Abstract

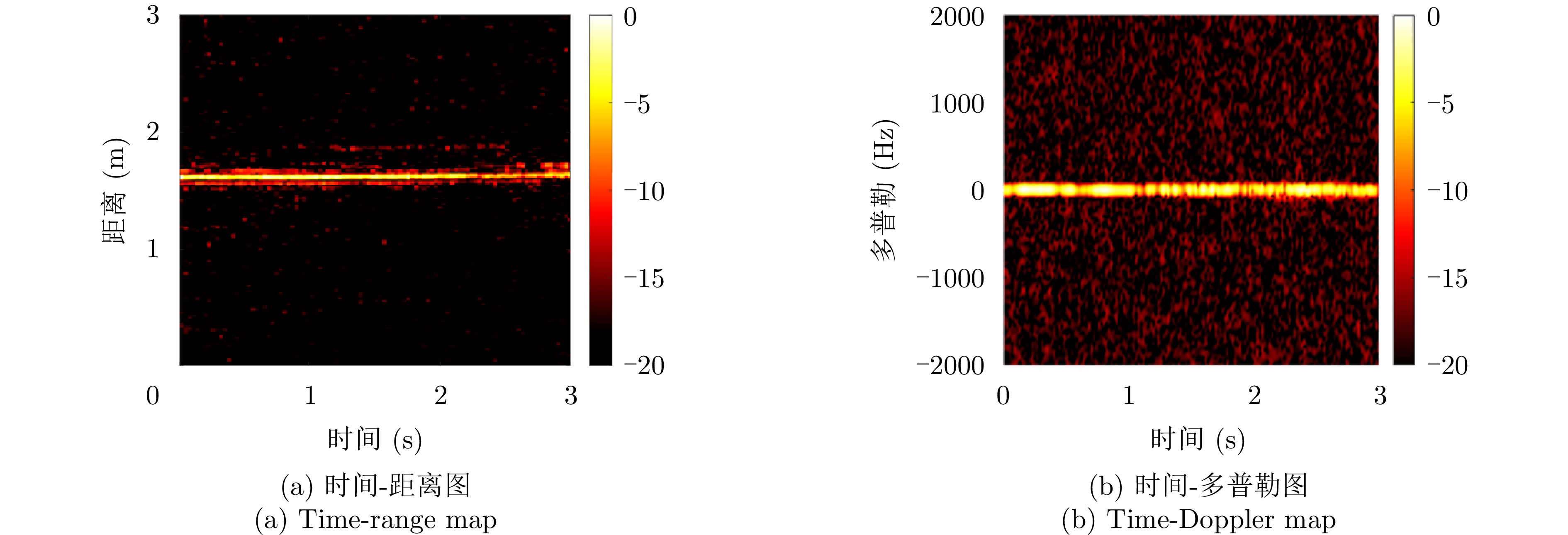

Recent research on radar-based human activity recognition has typically focused on activities that move toward or away from radar in radial directions. Conventional Doppler-based methods can barely describe the true characteristics of nonradial activities, especially static postures or tangential activities, resulting in a considerable decline in recognition performance. To address this issue, a method for recognizing tangential human postures based on sequential images of a Multiple-Input Multiple-Output (MIMO) radar system is proposed. A time sequence of high-quality images is achieved to describe the structure of the human body and corresponding dynamic changes, where spatial and temporal features are extracted to enhance the recognition performance. First, a Constant False Alarm Rate (CFAR) algorithm is applied to locate the human target. A sliding window along the slow time axis is then utilized to divide the received signal into sequential frames. Next, a fast Fourier transform and the 2D Capon algorithm are performed on each frame to estimate range, pitch angle, and azimuth angle information, which are fused to create a tangential posture image. They are connected to form a time sequence of tangential posture images. To improve image quality, a modified joint multidomain adaptive threshold-based denoising algorithm is applied to improve the image quality by suppressing noises and enhancing human body outline and structure. Finally, a Spatio-Temporal-Convolution Long Short Term Memory (ST-ConvLSTM) network is designed to process the sequential images. In particular, the ConvLSTM cell is used to extract continuous image features by combining convolution operation with the LSTM cell. Moreover, spatial and temporal attention modules are utilized to emphasize intraframe and interframe focus for improving recognition performance. Extensive experiments show that our proposed method can achieve an accuracy rate of 96.9% in classifying eight typical tangential human postures, demonstrating its feasibility and superiority in tangential human posture recognition. -

1. 引言

自动目标识别(Automatic Target Recognition, ATR)伴随着传感器探测能力与数据处理技术的进步,得到越来越广泛的重视和发展,已成为无人系统智能化、自主化的核心。

事实上,对于自动目标识别甚至“识别(Recognition)”本身,学术领域和工程应用领域目前都还没有一个明确一致、广泛接受的定义。Tait[1], Ratches[2], Bir Bhanu[3]以及美国林肯实验室[4]从技术维度将ATR视为是处理传感器数据并进行自动目标捕获与辨识的过程。Schachter[5]则从狭义的技术角度、广义的技术角度和工程系统的角度来解释了ATR。文献[6]从应用任务的角度将“识别(Recognition)”放置在一个包括6个层级的分类树中(即检测、分类、识别、辨识、特性和指纹),并将ATR定义为确定目标特性以及类型的过程,以便能够为半自主、自主系统提供高置信度实时决策。

本文从工程应用的角度来理解ATR,认为ATR是一个面向应用任务的感知与决策过程,其功能贯穿于目标搜索、定位、跟踪、鉴别与决策、引导等任务链的每个环节,其系统包含了一系列自动化、智能化的目标信号和信息处理算法以及相应的软硬件,以实现目标种类和类型等属性的高置信度辨识。本文重点从ATR工程应用系统的不同视角与维度,来阐述ATR的内涵与特点,并简要回顾了该领域发展动态,重点梳理了ATR的核心技术体系与系统开发模式,最后对未来的发展做了展望。

2. 认知ATR的视角

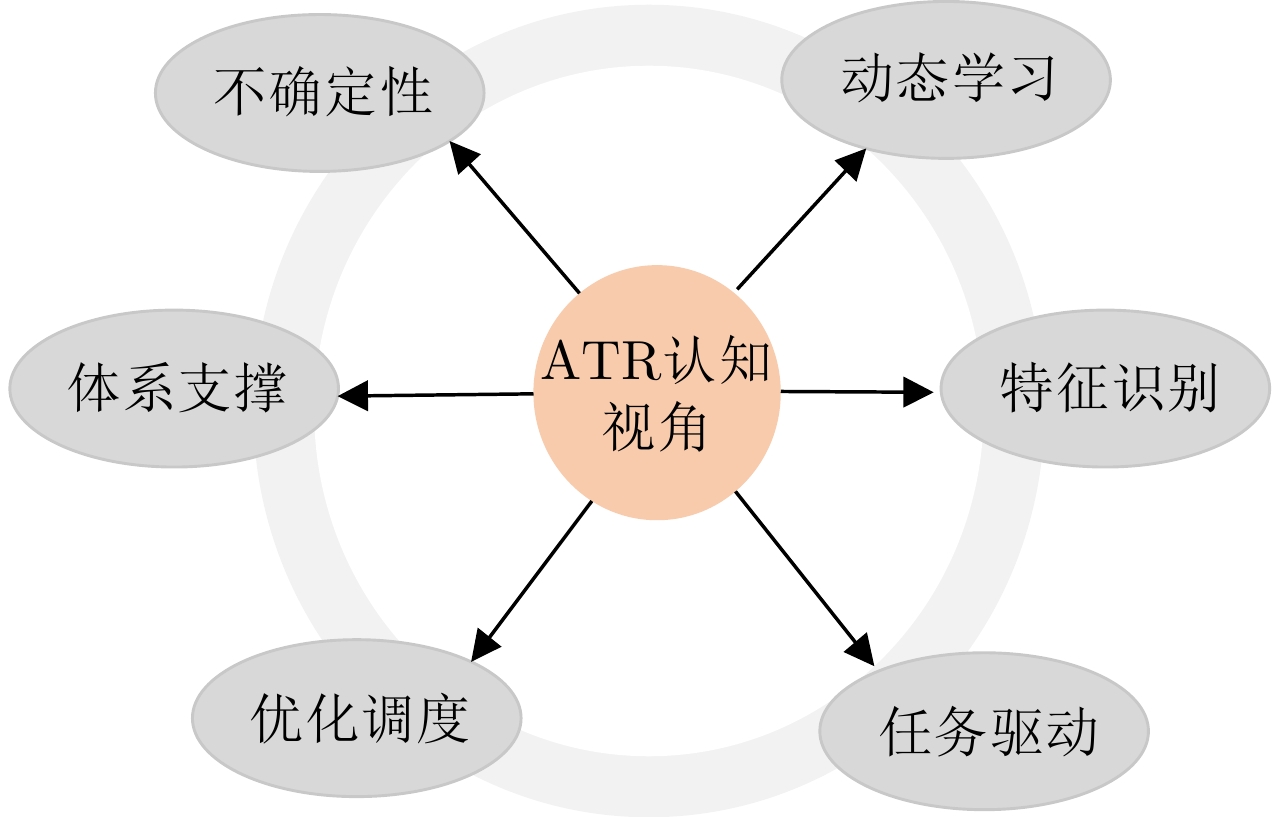

从识别的基本原理来看,ATR可归于模式识别范畴,关注的是目标特征问题,这是从特征识别的视角来认知ATR。ATR系统的性能与任务需求、探测器及平台特性、目标环境状态以及整个探测体系支持等都直接相关,其能力是系统各相关功能的集成,因此需要从任务驱动、系统资源优化调度以及整个探测体系支撑等视角来分析与理解。ATR系统具有固有的不确定性,需要从不确定性的视角来认知ATR。学习能力是任何识别系统的核心支撑,因此要从开放环境动态学习的视角来认知ATR系统自组织、自生长的内在需求。 图1示意了从特征识别、任务驱动、优化调度、体系支撑、不确定性和动态学习6个不同视角来认知ATR的内涵与特点。

2.1 特征识别

目标识别有赖于目标的特征信息。每类目标在特定环境中都有其固有特性,与大多数物理现象一样,目标特性是客观存在的,而不同目标在特性上具有差异性或唯一性,这从源头上为目标识别提供了基础。特征是目标特性在探测器观测域内的外在表现,可认为是目标特性在识别域的物理数学表征,也是对目标具备的空间、几何、电磁、运动等特性的感知、分析与描述。

从信息的角度理解,各种测量仪器设备获取的目标数据可看作特定介质下目标特性的调制,这种调制是本源的目标特性与现实世界环境叠加、耦合所产生的信号响应,蕴含了丰富的目标信息。因而,ATR的核心任务正是通过揭示探测空间中复杂的耦合作用机理、挖掘获取信号的信息,以实现目标特性的反演。特征提取是从现实测量信号中寻求目标差异性和唯一性的数学表征过程,实际应用中,为了实现可靠的目标识别,关键是快速发现并获取特定场景下易于计算且稳健的目标特征。

2.2 任务驱动

ATR服务于具体场景下的任务,与ATR相关的任务描述与表征是ATR系统开发的基础。与任务描述相关的要素包括目标探测范围与环境条件、目标数量与目标类型、识别距离与时间约束、目标识别精度要求、重要目标识别要求、探测平台特性、探测传感器配置与功能协同性、系统数据处理能力、数据传输与通信保障性能、人在环路特性、先验知识的支撑能力等。任务需求不是固定不变的,而是随实际过程动态调整的。

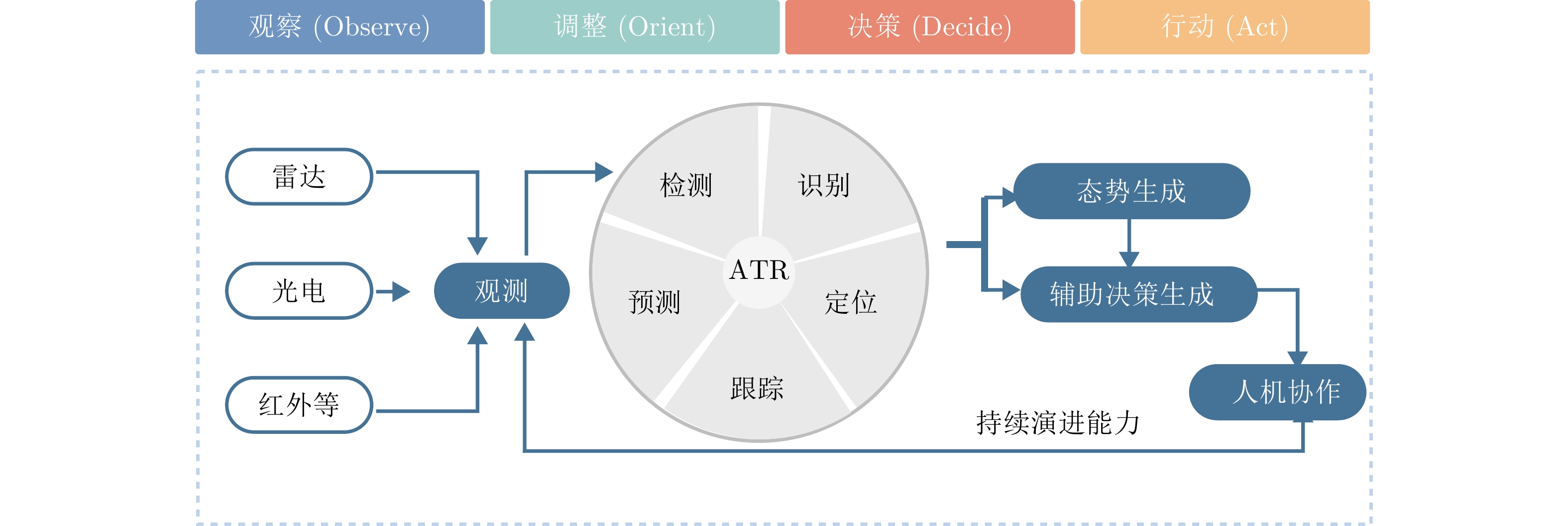

任务过程可以利用OODA环来进行描述。OODA环包含观察(Observe)-调整(Orient)-决策(Decide)-行动(Act) 4个环节,是由约翰-博伊德于1977年提出的理论,它简明而深刻地阐释了如何高效执行任务。图2是ATR在无人机区域目标搜索识别与跟踪探测中的概念性图示,贯穿任务过程的关键是对目标的精准识别。

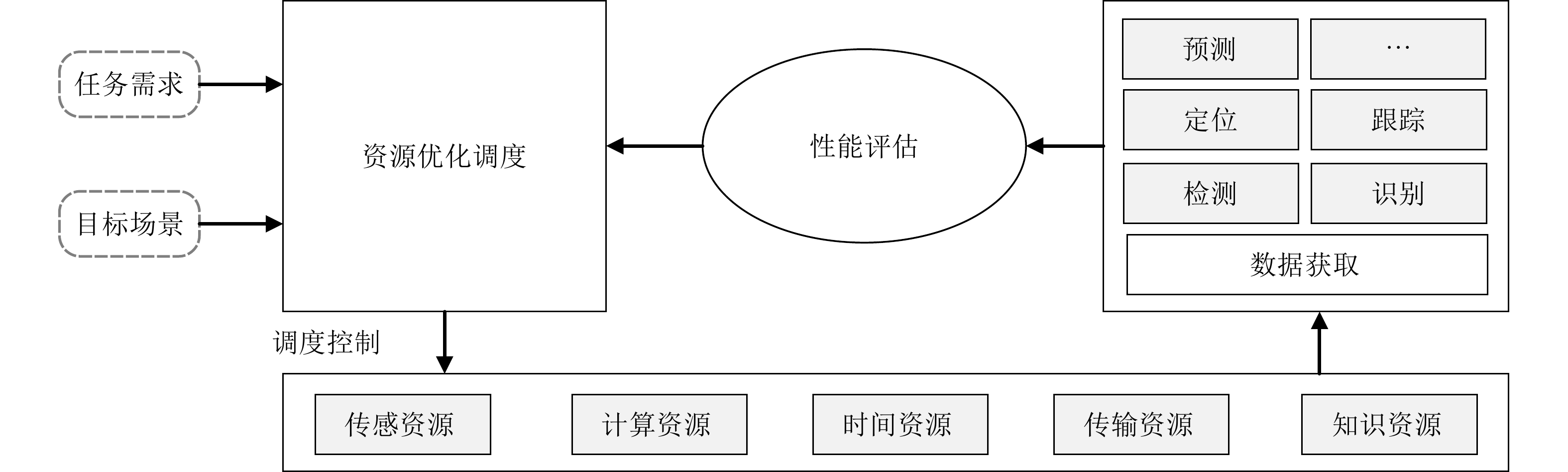

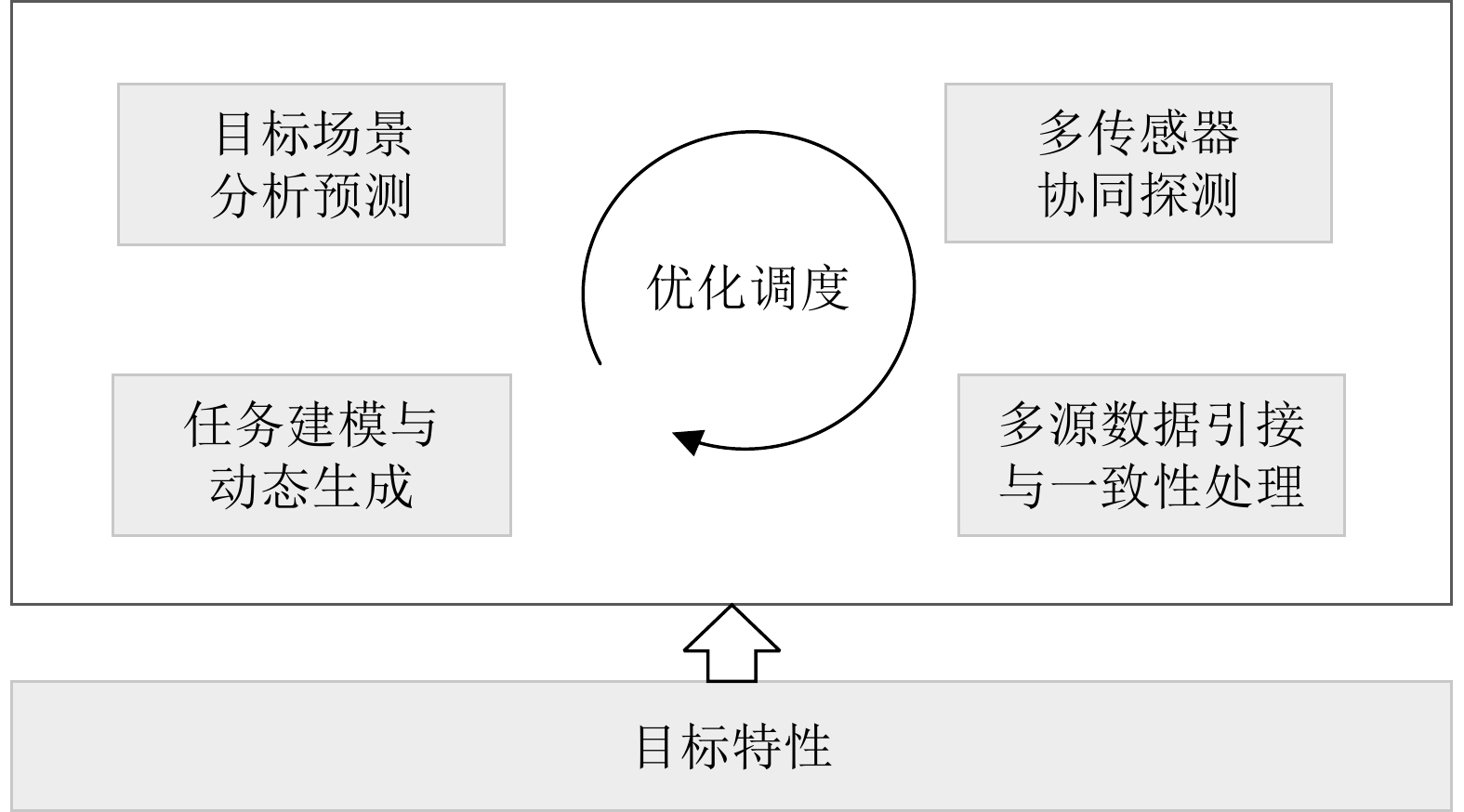

2.3 优化调度

ATR系统需要针对识别任务要求,依据目标场景信息、平台和传感器特性以及其他相关要素,优化调度系统探测资源和计算资源才能实现面向识别任务的最佳匹配效能。任务规划和资源调度受相关实际变量的约束,如识别目标类型、环境与范围、传感器类型与性能等,因此在实际应用中需要结合这些约束变量进行综合分析,如图3所示,根据实际识别任务与场景,对相关资源(如传感资源、传输资源、计算资源等)进行优化调度,实现目标数据获取与处理,然后对任务结果进行评估,并结合评估结果继续对资源调度环节进行优化,以期最佳完成任务。

2.4 体系支撑

通过对整个体系中目标情报信息的共享和探测能力的协同,可有效提升每个感知单元的ATR能力,但也对ATR提出了更多的需求和挑战。一是面向任务要求,如何实现相关目标探测数据与信息的智能化高效引接;二是如何实现不同探测系统目标数据的一致性处理、关联配准与融合;三是各类数据与信息处理结果的置信度可信评估、一体化更新和统一目标视图的形成;四是面向高速运转的任务进程,如何在最短时间内以最适合的方式向不同任务节点提供精准的ATR信息。

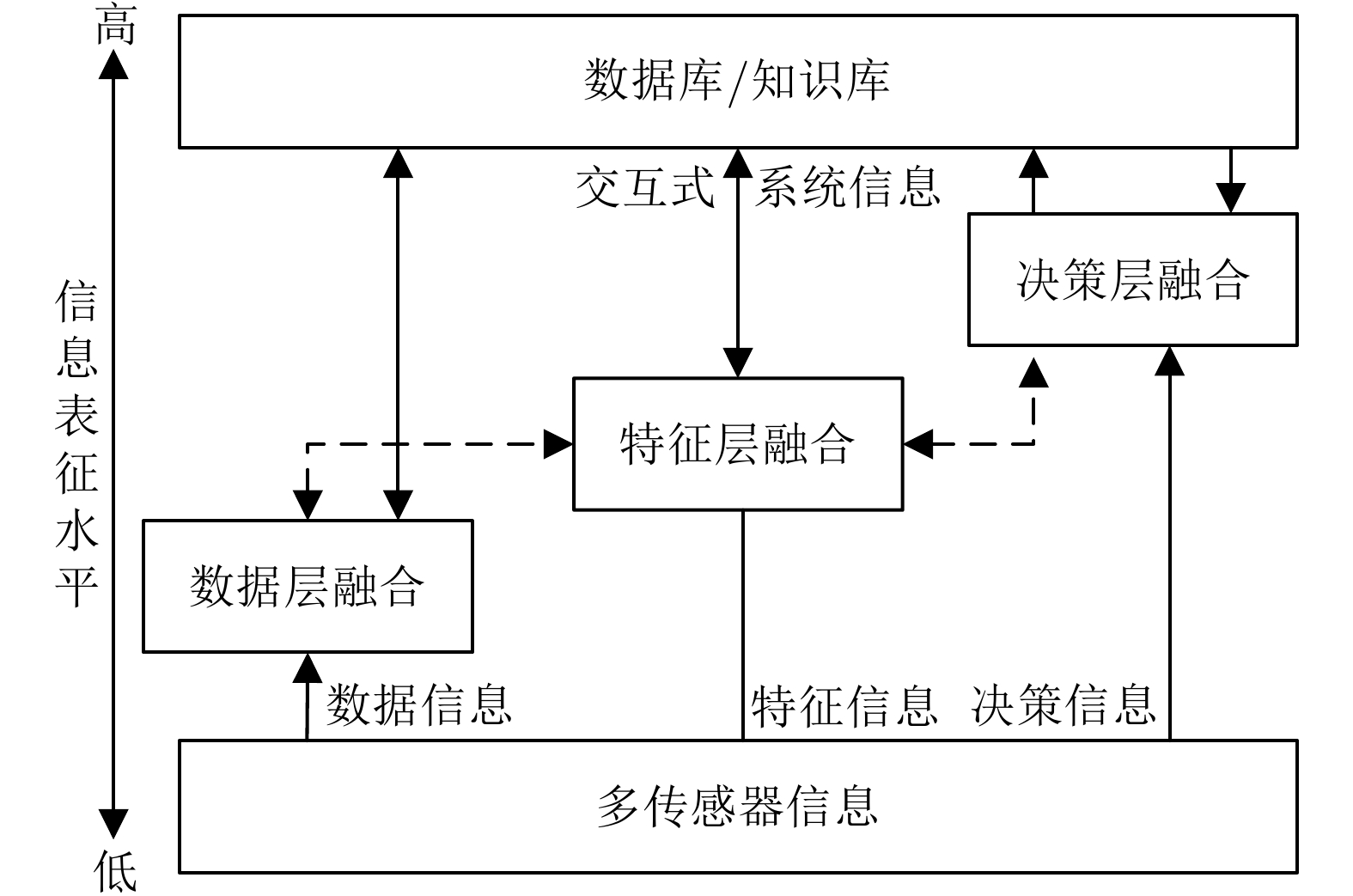

2.5 不确定性

ATR结果的不确定性源于诸多因素。预设目标场景的变化、目标对象的未知性、目标与环境先验信息与知识的有限性、新型“低、小、隐身”目标、目标实际观测数据的稀少性等,都给目标的搜索发现、定位跟踪、干扰鉴别、识别确认与决策执行等带来不确定性。需要对各类数据与信息的不确定性来源及特点进行梳理和分析,并成体系地采用针对性的方法进行抑制或消减。应将各类不确定性因素进行合理建模,并纳入到实际ATR系统的设计与开发中。一般通过多源信息融合来消减不确定性对目标识别和决策的影响,其中融合可在数据层、特征层或决策层3个层面实现,如图4所示[7]。

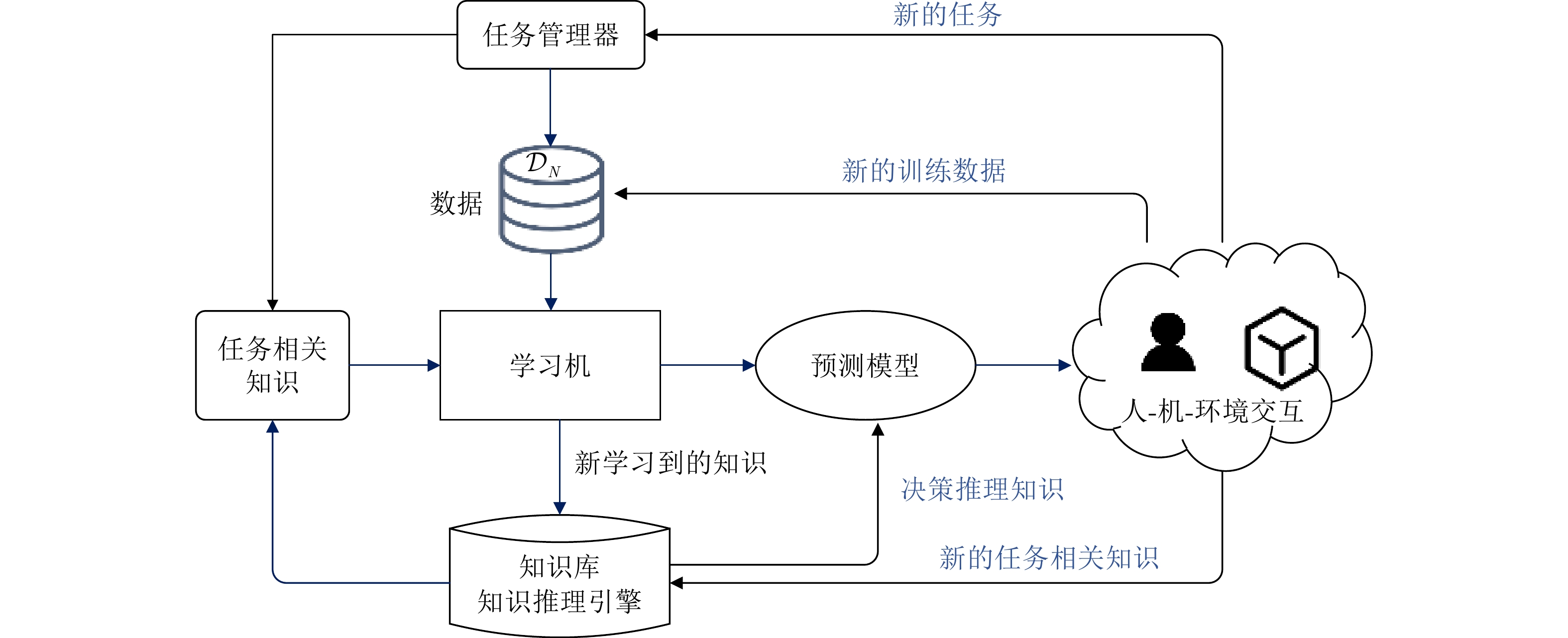

2.6 动态学习

ATR最终是过程实践与学习积累形成的能力。无论是通过实际应用场景学习积累,还是通过基于先验模型的虚拟场景数据训练,复杂多变的目标场景决定了ATR系统必须具备高效率的增量学习、迁移学习、联想学习等动态学习能力,识别系统也应随着任务与场景数据的不断积累,动态实现系统数据、算法软件的更新与识别能力的跃升。以在线持续学习为例,图5给出了其自演进架构[8]。

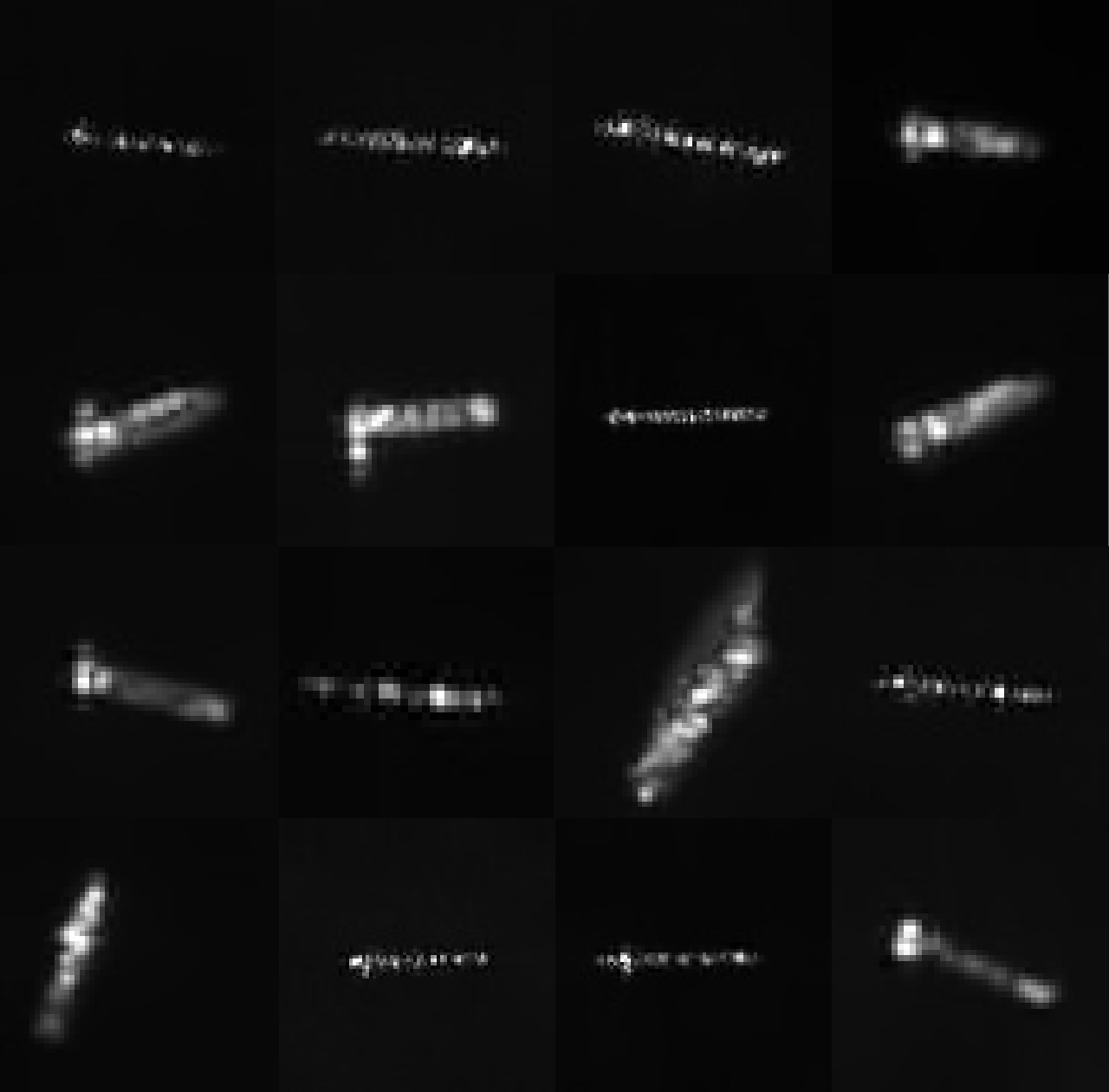

3. ATR发展的简要回顾

ATR领域真正得到广泛关注还是从20世纪80年代开始[9]。美国国防高级研究计划局(Defense Advanced Research Projects Agency, DARPA)把ATR列为国防关键技术方向,20世纪90年代启动的移动和固定目标自动识别项目(Moving and Stationary Target Automatic Recognition, MSTAR)[10]和2015年启动的对抗环境目标识别与适应项目(Target Recognition and Adaption in Contested Environments, TRACE)[11]等,都对推进ATR技术的研究与应用起到了积极作用。图6是 MSTAR部分数据样本的示意。

ATR领域的研究内容非常丰富,本文从整体的技术发展特点并结合ATR试验验证技术来对ATR领域的发展做一个概略性分析。

3.1 经典识别方法

从20世纪60年代开始直至21世纪初,该阶段研究涉及了所有的传感器以及各类ATR识别理论与方法,也普遍采用了知识库系统、人工神经网络等人工智能技术[12-16],但主要基于特征提取与模式匹配的传统模式识别基础框架[17],我们把这类方法统称为经典识别方法。

光学、红外图像目标识别主要是基于20世纪60年代的矩不变理论[18],重点提取二维不变矩特征和建立基于Hu不变矩等矩不变量的识别系统。雷达目标识别方面,主要依赖目标电磁散射特征、极化特征与多普勒特征等,这些特征的获取与雷达的探测状态相关[19-21]。对于窄带雷达,雷达目标的自然谐振频率、目标雷达散射截面积(Radar Cross Section, RCS)等被用于目标分类识别[22-24]。对于宽带雷达,主要关注雷达高分辨距离像(High Resolution Range Profile, HRRP)特征提取。HRRP通常具有方位敏感性和平移敏感性,需采用非相干平均、平移不变性等方法得到稳定特征[25-30]。对合成孔径雷达(Synthetic Aperture Radar, SAR)与逆合成孔径雷达(Inverse Synthetic Aperture Radar, ISAR)图像的目标识别方法,一般都是融合了图像识别与雷达目标电磁特征识别的共性方法[31-35]。激光雷达的目标识别主要依赖于测距图像中的几何形状特征提取[36-38],利用目标模型特征可以实现与姿势无关的激光雷达ATR[39]。

早期的识别方法采用的目标数据样本数大多较小,算法更多依靠人工设计出的特征和分类器,且采用小规模的神经网络分类器[40-44]。在卷积神经网络出现之前,出现了一些“端到端”的神经网络雏形,他们只需要输入原始图像或信号,从原始数据中学习特征并进行目标识别[45-51],这类方法的问题在于人工选择的特征通常不完整。

3.2 深度学习方法

借助新一代人工智能深度学习理论与方法的不断迭代进步,ATR进入了一个新的发展阶段,其研究不再局限于“特征”模式识别框架,我们把相应方法归类为深度学习ATR方法。2012年,AlexNet网络首次将深度卷积神经网络(Convolutional Neural Networks, CNN)用于大规模图像识别大幅提高了识别精度[52]。早期的研究将CNN作为特征提取工具,发现其相比传统方法拥有更高的目标识别率,这一点在声呐图像、雷达图像的现实识别应用中得到了反复验证[53-55]。随后,越来越多的方法开始扬弃“特征”这一传统模式识别概念,利用CNN实现“端到端”目标识别,即利用CNN来完成特征提取和分类识别全过程[56]。

CNN已被应用于导引头一维距离像识别、红外图像识别与雷达图像目标识别等[57-66]。文献[67]利用完全学习机来学习CNN特征,在识别的泛化性能和训练速度方面优势明显。文献[68]将CNN与联合稀疏表示相结合,在噪声样本和小样本的条件下都取得了较好的性能。文献[69]提出的深度嵌套CNN有效提取了雷达回波信号特征,可更好地识别目标。文献[70]表明,CNN结合注意力机制可有效聚焦于重要目标区域,能为SAR识别带来显著的性能增益。近期研究也发现CNN在抗欺骗、干扰等方面具备先天缺陷,在输入中插入轻微的不可察觉扰动就能轻易实现模型欺骗[71,72]。文献[73]提出了一种新型的网络“防御层”,旨在阻止对抗性噪声的产生,并防止黑盒和灰盒环境中的对抗性攻击。此外,开展噪声、干扰及多视角情况下的高鲁棒性目标识别神经网络研究已成为当前研究热点[74-76]。

深度学习ATR方法,在识别率上取得了突破,但其“可解释性”较差,这会导致ATR系统在应用时存在决策风险。可解释对于增强ATR系统的可信任至关重要,是ATR技术更好落地应用的关键之一[77]。ATR识别的准确性取决于预测目标场景模型的精度和实际任务场景的匹配性,对ATR的可解释性需要充分结合预测模型、目标和任务场景知识,从物理、统计和知识等多方面来解释ATR的计算与决策过程。

同时,在ATR领域,要获得合适的目标数据集是一大挑战,很多情况下甚至是不可能的。当缺乏足够数量真实标记数据时,迁移学习可将一个训练好的网络应用到另一个相似任务中进行识别[78]。文献[79]首次展示了模拟数据集和真实SAR图像集之间的迁移学习。文献[80,81]利用域自适应迁移学习,准确地检测识别出SAR图像中密集分布的舰船目标。利用生成对抗网络(Generative Adversarial Network, GAN)学习分布相近的新样本,可实现对目标数据集的增强[82,83],而通过目标物理模型和对模型目标特征的假设,来实现训练样本扩充也是常见的方法[84]。

3.3 ATR试验验证技术

ATR是一个系统层面的任务功能,数据与场景化试验验证是推动ATR系统发展与应用的关键。这里从系统试验验证技术的角度来介绍ATR的相关发展。

各类场景化目标数据集的构建对推动ATR技术研发、验证ATR系统的性能等发挥着关键作用。数据集在构建时应对实际应用中的各类复杂环境和影响因素进行细分并予以考虑[85]。美国“无暇”号水声监测船等搜集全球各类水面、水下目标的特征数据,形成了目标与威胁特性数据库系统(National Target/Threat Signatures Data System, NTSDS)。MSTAR数据集被广泛应用于ATR研究领域[10],并成为目标识别的基准测试数据集。在国内,上海交通大学构建了国内首个SAR图像解译数据开放共享平台OpenSARShip,提供了4万个以上精确标注的SAR图像海上舰船目标切片[86],如图7所示。中国科学院空天信息创新研究院基于高分三号卫星数据构建了面向宽幅场景的SAR舰船目标公开样本数据集[87];海军航空大学提出了“雷达对海探测数据共享计划”,并分批次公开发布共享规范化数据集[88];国防科技大学构建了空中弱小目标检测跟踪数据库[89]。

通过实测验证和评估ATR系统的应用效能,可形成系统技术演进闭环。在2001—2006年,国防科技大学ATR实验室[90]开展了现役窄带雷达舰船目标自动识别试验验证,在试验中持续提升了算法的场景适应性,平均识别准确率可达85%以上。但依赖实测构建的数据集通常会面临场景有限与目标样本稀少的问题。20世纪80年代起,DARPA开展了一系列基于模型的ATR数据集构建,这包括前面提到的MSTAR。而1986年开展的测量与特征情报(Measurement and Signature Intelligence, MASINT)系统,采取基于目标实测数据的模型仿真和数据增强、增广来取得高置信度数据,在结合目标实测的情况下,大幅提升了数据集的规模与可用性。

在试验验证中引入人在环路的标注、验证与判别也是辅助ATR系统演进的重要因素。文献[91]提出了利用人工判别知识的ATR技术来进行海上目标识别。文献[92]则在水下识别领域应用了相似策略,通过人类感知与ATR算法协同使用的方式完成各类水下物体的标注、筛选及识别任务。文献[93]同样针对水下物体识别,在ATR算法基础上将操作人员纳入整体识别系统以扩展及完善系统的识别能力。文献[94]则在人机结合基础上,分析比较不同人机协同方案在不同海况、尺寸目标情况下真实试验中的识别能力。

动态多变的目标场景决定了ATR系统需要适应不同任务场景需求才能实现对目标的可靠识别。美国在20世纪90年代就开展了以任务场景为驱动的ATR系统技术研究,早期典型的案例是1996年起开展的半自动图像处理(Semi-Automated IMINT(Image Intelligence) Processing, SAIP)项目[95]。2015年起,DARPA开展了一系列以TRACE计划为代表的智能化识别技术研究,将发展重点聚焦于任务场景驱动的复杂环境、有限数据、高实时性、高动态环境下的ATR技术。包括复杂部署环境的低虚警率检测技术、有限数据集下的新目标快速学习技术以及低功耗系统下的快速目标识别技术等[95]。2020年开展的动目标识别(Moving Target Recognition, MTR)计划重点发展在没有对方先验信息或仅有少量信息的情况下,完成对对方高价值目标的自动搜索、识别及跟踪[96]。

要强调的是,当前有关ATR的试验测试评估还并不成熟。研究ATR系统的评估理论,构建有效的体系化、场景化的测试方法,对促进ATR技术进步和加快ATR工程化应用具有重要意义。

4. ATR核心技术体系与系统开发模式

4.1 ATR核心技术体系

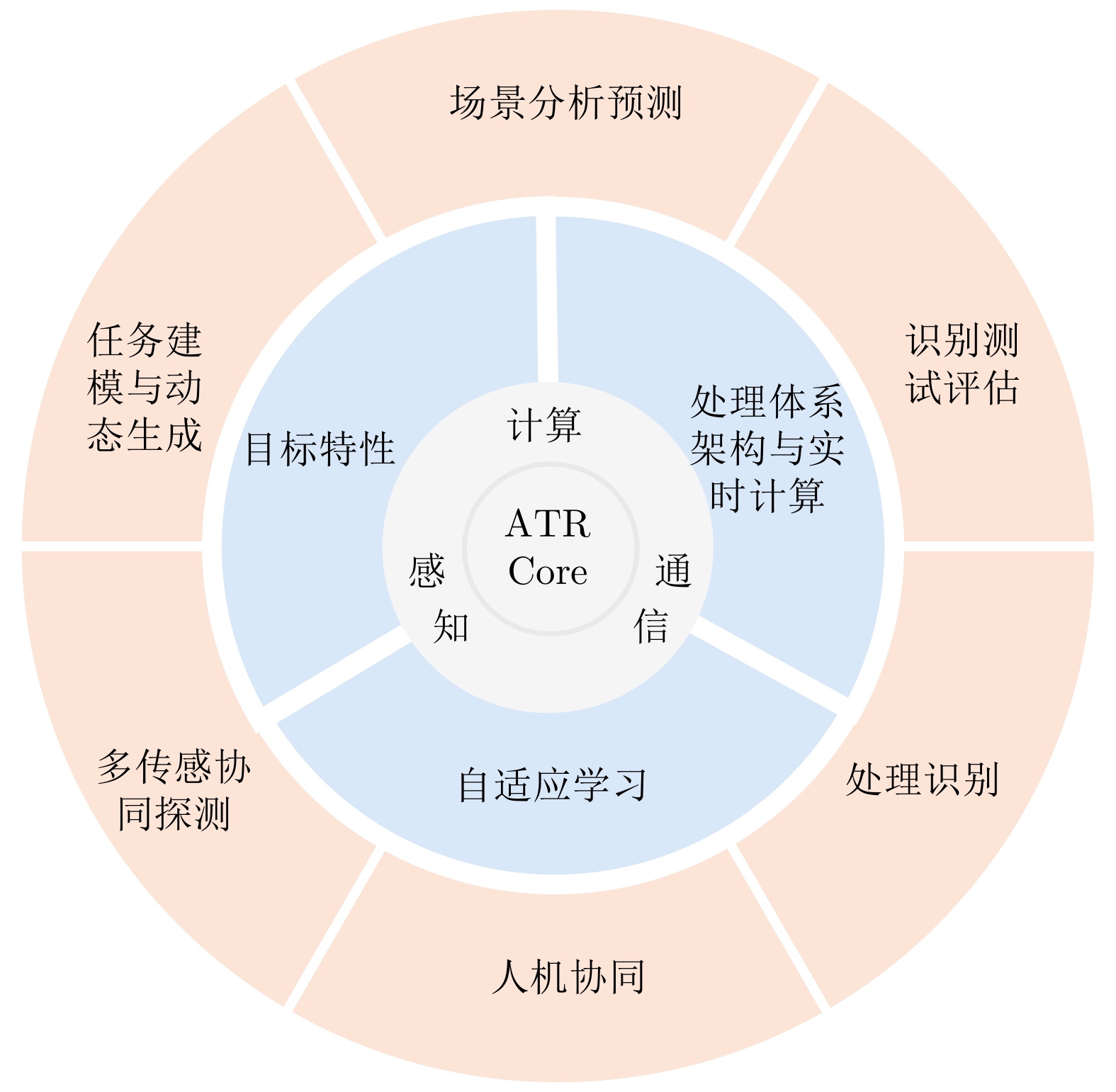

ATR核心技术体系的描述与构建可以从ATR系统核心能力的构成来梳理,这需要首先明确ATR能力的核(Core)是什么。这里将ATR系统的核心能力归纳为任务链中与ATR密切相关且有机衔接的3个能力:数据信息能力、信息认知能力和感知通信计算支撑能力。

数据信息能力是指ATR系统在任务时空窗口内,最佳地使用探测器以及数据链路所获得的目标数据的识别信息量。如图8,提升数据信息能力涉及的核心技术有:目标场景分析预测、任务建模与动态生成、多传感器协同探测、多源数据引接与一致性处理等。要强调的是,这些核心技术都涉及目标特性这一共性基础,只有掌握了目标特性蕴含的规律,才能有效支撑目标场景分析预测、识别任务生成与最优化的协同探测。同时可以看出,优化调度是数据信息能力形成过程中的一个共性问题。要说明的是,在实际复杂环境中,发现即识别一般是不可能的,因此ATR系统需要多次或连续的观测目标才能获得更多的识别信息,所以数据信息能力的提升也和ATR系统的目标检测与精确定位跟踪等能力密切相关。

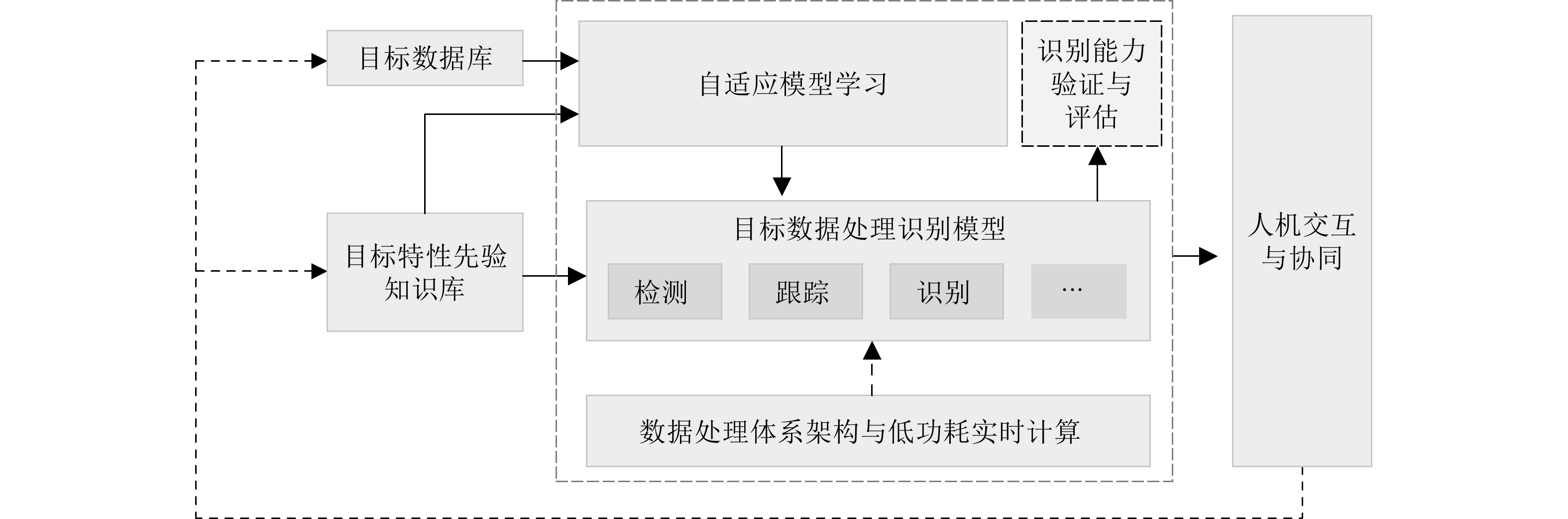

信息认知能力是指ATR系统从数据中有效提取信息并实现目标检测、定位、跟踪、识别与态势预测的能力以及系统动态学习演进的能力。如图9,提升信息认知能力涉及的核心技术有:目标特性先验知识库、目标数据处理识别算法、人机交互与协同、系统自适应学习、数据处理体系架构与低功耗实时计算、识别能力验证与评估等。其中目标特性先验知识库是目标数据特征信息认知的基础,各类目标数据处理与检测、跟踪、识别等算法用于实现目标不同层级与维度的信息认知任务,人机交互与协同可以增强目标认知能力,自适应学习能力是ATR系统不断演进的关键,合理的处理体系架构可以确保ATR最佳的计算资源保障,而面向工程化应用的ATR测试评估可以加速形成ATR系统的任务实现能力。ATR的信息认知能力不是一蹴而就的,需要ATR系统日积月累的场景化目标数据训练与性能迭代演进。

感知通信计算支撑能力是指ATR所依赖并紧耦合的探测、通信与计算资源、以及运动平台载体资源等,是目标数据获取、传输与计算的基础支撑能力。运动平台与载荷决定了目标感知的时间跨度与空间范围、目标探测的时域、频域与空间域的分辨能力,通信链路提供了数据的可靠及时传输,各类数据处理基础软硬件等构成的计算系统为算法软件的运行提供了支持。

图10是ATR核心技术能力(ATR Core)的构成示意图。从软件定义系统来看,所有软硬件都是ATR系统中获取、传输与处理数据的不同功能模块;因此,在感知通信计算支撑能力确定的情况下,ATR系统的核心关键能力主要在于数据信息能力与信息认知能力。其中,目标特性与特征、处理体系架构以及支撑ATR在开放场景现实应用的自适应学习演进是核心技术中的基础支撑技术,而图10外环中的场景分析预测、任务建模与动态生成、多传感协同探测、人机协同、处理识别、识别测试评估等技术构成了ATR应用的核心技术链。

4.2 ATR系统实现模式

ATR系统的实现模式是指ATR工程化开发过程中具有一般性、结构性、稳定性、可操作性的特征的归纳和总结[97]。ATR的任务特点与技术框架决定了ATR系统的实现模式,技术驱动了架构和模式的不断演进[98,99]。

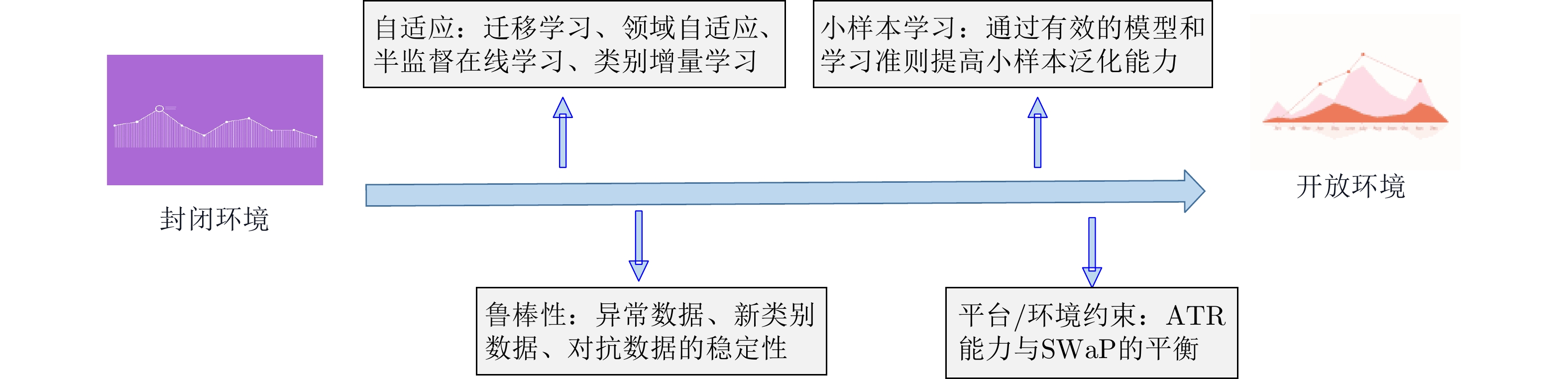

如图11所示,ATR系统在实际工程应用中,面临着从封闭环境(即目标集是有限集、背景确定的环境)到开放环境(即目标集包含目标环境背景变化、目标种类不确定等)的挑战。

根据ATR系统的研究实践[7,100-102],ATR工程应用系统的开发重点遵循如下两种模式: 一是迭代演进模式,这类开发模式是一种迭代和增量开发过程;二是开放生态模式,这类开发模式是一种基于开放平台与环境的ATR实现模式。这两种模式实际上是需要相互关联与叠加的,这里只是从不同的维度来对ATR系统的工程实现方式进行阐述与讨论。由于任务与应用环境的特殊性,ATR系统实现的迭代方式和开放生态范围都有其自身的特点。

4.2.1 迭代演进实现模式

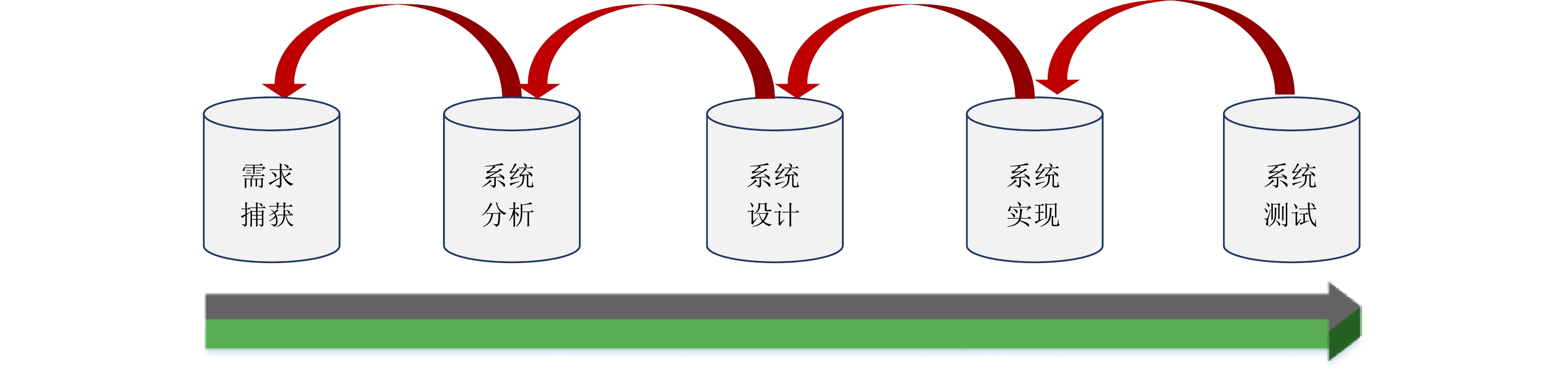

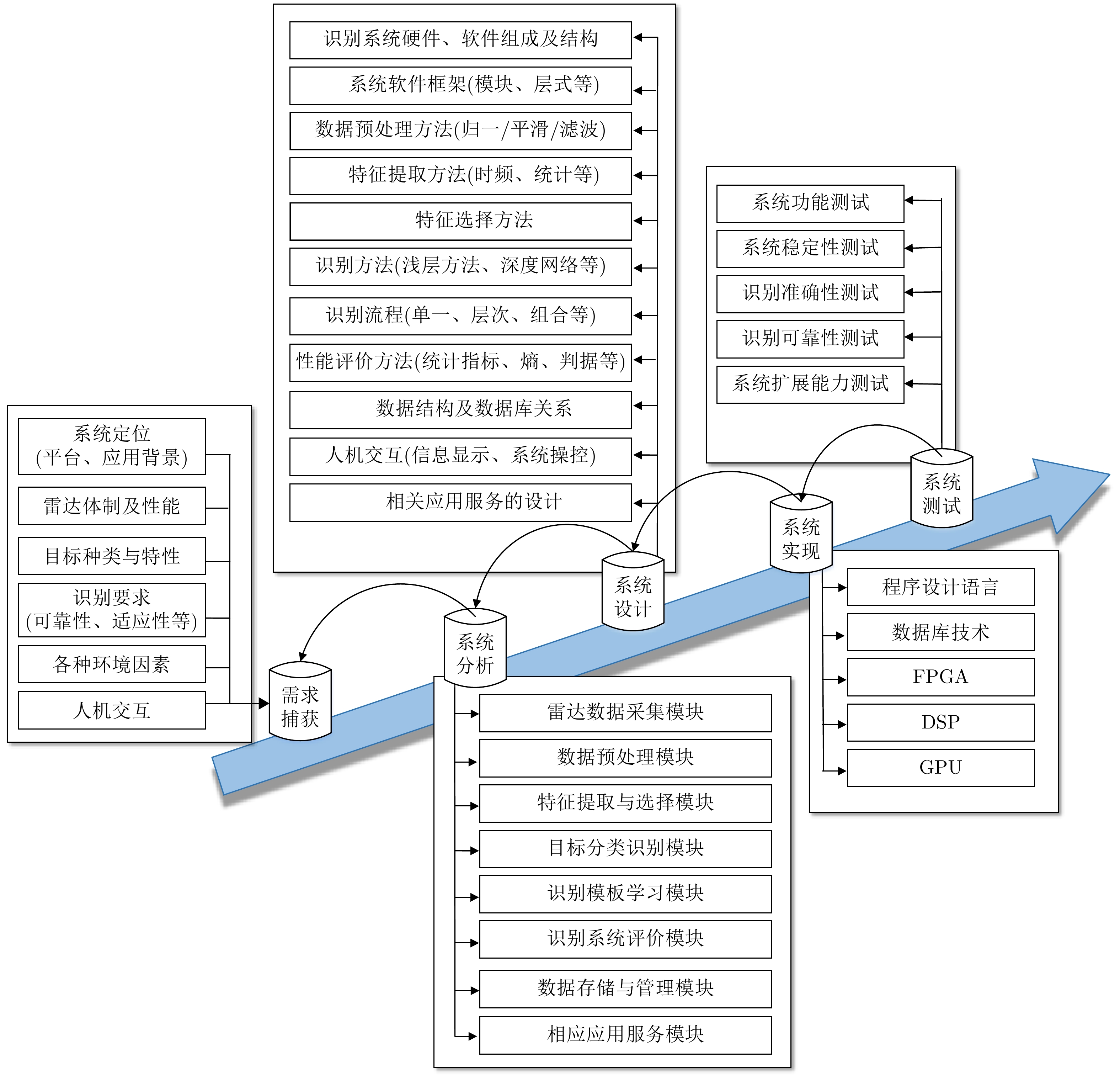

ATR系统的实现,需要经过需求捕获、系统分析、设计、实现和测试5个过程(如图12)[102]。

迭代演进开发模式充分考虑到ATR任务与系统的特点,旨在解决开发过程中需求的多样性、不确定性等难点,将试验设计技术应用到目标识别系统,依托快速原型系统或者通用平台,在现场试验中逐步明确需求、突破关键技术、促进使用和发现问题,这一过程循环往复,不断完善、更新并逐步固化所开发的算法和系统功能,促使系统在每一次循环迭代中,功能和性能增量迭代上升,使之不断接近用户真正的使用要求[97]。图13总结了笔者团队开发的一类雷达目标识别系统具体的工程开发流程和所使用的方法,由此可见,模式既是复杂系统本身,也是该系统的实现流程[102]。

4.2.2 开放生态实现模式

现有ATR系统高度封闭的实现模式存在以下问题:对特定任务需求高度定制化,系统缺乏泛化能力;与现有软硬件环境紧耦合,系统移植性差、升级困难;接口与边界定义无统一规范,重复开发现象普遍;算法、数据、模型较封闭,导致重复建设、资源浪费。

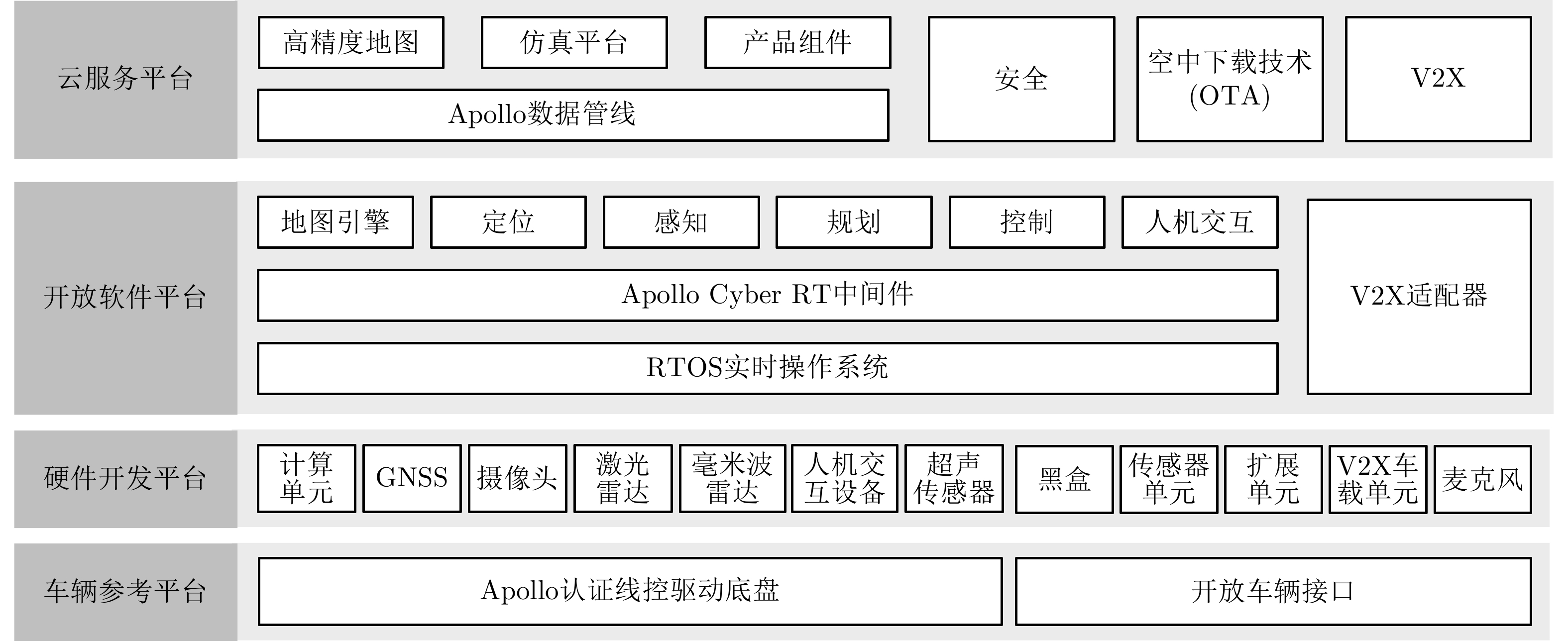

构建开放生态环境是解决以上问题的重要途径。这在机器人与自动驾驶领域有成功案例值得借鉴。例如机器人领域的操作系统(Robot Operating System, ROS)[103]与自动驾驶领域的百度阿波罗(Apollo)等开放生态环境,如图14所示。ROS提供了通信框架、应用功能、开发工具、社区系统“四位一体”的生态环境,其核心是为机器人软件系统提供了统一框架,将复杂的机器人软件系统功能模块划分成独立运行的程序。百度阿波罗开放平台与ROS类似,阿波罗平台还通过云端数据服务进行仿真数据生成、测试,旨在提升研发人员快速搭建自动驾驶系统的效率。

ROS与Apollo等开放生态环境的成功对ATR系统研发有极高参考价值。结合ATR应用特点,面向ATR的开放生态环境应包含以下方面:统一的接口规范与通信机制、功能模块的独立组件化、开发工具、共享仓库、数据集仓库、功能模块仓库、目标信息仓库、应用场景信息仓库等。

ATR开放生态的核心在于向相关开发人员开放场景、开放数据、开放平台。20世纪90年代开始,国防科技大学ATR实验室[104,105]针对多个观测站舰船目标识别场景和实际使用中的窄带雷达,基于自主开发的柔性雷达ATR原型平台,建立了跨海域、20余类目标、20万批次的雷达目标信号数据仓,为ATR研究人员提供了开放的海上ATR识别场景和快速开发平台,将ATR系统的开发与部署时间从早期需要八九个月逐步降到一周,直至几个小时。

5. 未来发展挑战

ATR的发展永远在路上。ATR领域当前与未来面临的挑战性技术与工程应用问题主要集中在ATR技术与任务的耦合、识别系统的预测水平、与场景的适应能力3个方面。

5.1 ATR技术链与应用任务链的高效构建与耦合

ATR能力服务于识别任务,不同任务阶段的需求构成了ATR工程应用任务链。ATR系统根据任务过程中的需求实时提供目标识别与决策支持。但现实情况下,ATR技术链与应用任务链的构建与耦合长期面临着众多困难。这些问题主要有:

(1) ATR能力受限于任务需求存在的固有不确定性。目前识别任务的需求一般都是定性为主,任务想定与实际场景可能存在较大差距,同时也缺乏任务需求的规范化表征与生成。任务需求的不确定性将给ATR系统的开发,尤其是核心算法的开发带来困难。

(2) ATR技术创新与系统集成之间存在隔阂。ATR是系统的功能集成体现,ATR指标不能简单的看成是一个数据的统计指标,它实际上都是系统性的总体指标。但实际情况是,很多研究ATR的技术人员,难以了解、参与任务总体,ATR技术的创新研究和工程应用之间存在很大的缝隙。

(3) ATR效能受限于传感器自身能力与探测模式。大量的探测设备,尤其是雷达,都是以目标发现跟踪为目的,系统设计通常遵循的是点目标处理思想,因此传感器本身就不提供或仅提供很少的精细化描述信息。这种传统的探测模式在机理上决定了不适用于目标识别模式,即使通过各种处理方法,也难以实现信息“补齐”。这将涉及设备观测与使用方式的调整。

(4) ATR能力的形成与拓展受多元创新协同不足制约。ATR系统能力的形成需要在使用中迭代,但研制方交付用户后,一般难以提供、也很少提供与目标识别紧密相关的数据处理、管理与更新等软件及服务。在设备用户、设备研制方和ATR技术与服务提供方之间还难以形成高效的技术创新协同链路。

5.2 ATR系统的识别性能受制于预测目标模型的能力

ATR之难,源于对识别对象不完备、不确定的观测。目标的非合作性与欺骗性、干扰的引入、环境的变化以及受限的观测手段、有限的观测时空窗口等,都使得通过有限训练样本与模型建立的ATR方法很难满足实际要求。需重点关注:

(1) 要解决目标与环境的有效建模问题。建模的要求不是单纯为了精确,而是要尽可能覆盖各类可能的目标模型。这需要建立一个复杂的层次化、网络化的目标分类模型空间,在不同的识别层次上采用不同的建模方法。

(2) 要解决特定应用场景预测目标模型的有效选择、裁剪和快速学习训练与装订问题。要针对各类应用场景,快速形成任务模型与流程,设置可能目标集合与相应的预测目标模型,快速训练形成面向特定应用任务的ATR算法软件。需要通过有效预测目标场景状态或缩小目标场景空间,来降低目标模型预测的复杂性,从而提高ATR的可靠性。

(3) 要发展可解释性ATR技术。通过多维度构建和表达ATR领域知识,并与任务驱动、数据驱动技术相结合,将领域知识更好地嵌入到深度模型的学习和推理过程中,发展解释性强、泛化性好、鲁棒性高ATR模型和技术。

5.3 ATR系统面临的场景适应性挑战

ATR处于动态开放环境下,新需求、新任务、新数据、新目标不断出现,目标特性的变化和应用场景多样性要求ATR系统具备快速自学习、自组织、自生长的能力。

(1) 发展软件定义的柔性ATR系统架构和以识别为核心ATR操作系统,以适应快速、灵活定制或更新不同环境条件下的ATR系统的需要。发展敏捷、轻量化的ATR系统架构和识别处理技术产品,以适应各类灵巧型智能设备的发展需求。

(2) 加强目标场景表征与分类研究,形成规范化的分类、分级ATR目标场景视图。在此基础上,发展ATR跨场景高效迁移学习、融合学习方法,提升跨域、跨场景下的ATR系统能力。

(3) 发展ATR领域更为有效的系统学习演进理论与方法,使得ATR系统能够在使用过程中进行持续高效的进化与扩展,保持对新出现目标类型、样本特性和场景状态稳定的识别能力;建立适应ATR任务特点的虚实混合训练模型与模式,最大程度地构建开放的ATR生态,形成场景、数据、算法的闭环,加速ATR系统的泛化应用。

ATR是一个永恒的挑战。ATR的发展需要领域相关技术的进步与应用整合,需要更多的领域研究人员面向应用场景深耕细作,不断的把ATR技术的研究和工程应用推向极限,成就ATR之美。

-

References

[1] 金添, 宋永坤, 戴永鹏, 等. UWB-HA4D-1.0: 超宽带雷达人体动作四维成像数据集[J]. 雷达学报, 2022, 11(1): 27–39. doi: 10.12000/JR22008.JIN Tian, SONG Yongkun, DAI Yongpeng, et al. UWB-HA4D-1.0: An ultra-wideband radar human activity 4D imaging dataset[J]. Journal of Radars, 2022, 11(1): 27–39. doi: 10.12000/JR22008.[2] LE KERNEC J, FIORANELLI F, DING Chuanwei, et al. Radar signal processing for sensing in assisted living: The challenges associated with real-time implementation of emerging algorithms[J]. IEEE Signal Processing Magazine, 2019, 36(4): 29–41. doi: 10.1109/MSP.2019.2903715.[3] QI Fugui, LV Hao, WANG Jianqi, et al. Quantitative evaluation of channel micro-Doppler capacity for MIMO UWB radar human activity signals based on time-frequency signatures[J]. IEEE Transactions on Geoscience and Remote Sensing, 2020, 58(9): 6138–6151. doi: 10.1109/TGRS.2020.2974749.[4] TANG Longzhen, GUO Shisheng, JIAN Qiang, et al. Through-wall human activity recognition with complex-valued range-time-Doppler feature and region-vectorization ConvGRU[J]. IEEE Transactions on Geoscience and Remote Sensing, 2023, 61: 5111014. doi: 10.1109/TGRS.2023.3329561.[5] LI Zhi, JIN Tian, LI Lianlin, et al. Spatiotemporal processing for remote sensing of trapped victims using 4-D imaging radar[J]. IEEE Transactions on Geoscience and Remote Sensing, 2023, 61: 5103412. doi: 10.1109/TGRS.2023.3266039.[6] YANG Shufan, LE KERNEC J, ROMAIN O, et al. The human activity radar challenge: Benchmarking based on the ‘radar signatures of human activities’ dataset from Glasgow university[J]. IEEE Journal of Biomedical and Health Informatics, 2023, 27(4): 1813–1824. doi: 10.1109/JBHI.2023.3240895.[7] BAI Xueru, HUI Ye, WANG Li, et al. Radar-based human gait recognition using dual-channel deep convolutional neural network[J]. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(12): 9767–9778. doi: 10.1109/TGRS.2019.2929096.[8] LI Changzhi, PENG Zhengyu, HUANG T Y, et al. A review on recent progress of portable short-range noncontact microwave radar systems[J]. IEEE Transactions on Microwave Theory and Techniques, 2017, 65(5): 1692–1706. doi: 10.1109/TMTT.2017.2650911.[9] KIM Y and LING Hao. Human activity classification based on micro-Doppler signatures using a support vector machine[J]. IEEE Transactions on Geoscience and Remote Sensing, 2009, 47(5): 1328–1337. doi: 10.1109/TGRS.2009.2012849.[10] DING Chuanwei, HONG Hong, ZOU Yu, et al. Continuous human motion recognition with a dynamic range-Doppler trajectory method based on FMCW radar[J]. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(9): 6821–6831. doi: 10.1109/TGRS.2019.2908758.[11] EROL B and AMIN M G. Radar data cube processing for human activity recognition using multisubspace learning[J]. IEEE Transactions on Aerospace and Electronic Systems, 2019, 55(6): 3617–3628. doi: 10.1109/TAES.2019.2910980.[12] DING Chuanwei, ZHANG Li, CHEN Haoyu, et al. Sparsity-based human activity recognition with pointnet using a portable FMCW radar[J]. IEEE Internet of Things Journal, 2023, 10(11): 10024–10037. doi: 10.1109/JIOT.2023.3235808.[13] LI Xinyu, HE Yuan, FIORANELLI F, et al. Semisupervised human activity recognition with radar micro-Doppler signatures[J]. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 5103112. doi: 10.1109/TGRS.2021.3090106.[14] KIM W Y and SEO D H. Radar-based human activity recognition combining range-time-Doppler maps and range-distributed-convolutional neural networks[J]. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 1002311. doi: 10.1109/TGRS.2022.3162833.[15] QIAO Xingshuai, AMIN M G, SHAN Tao, et al. Human activity classification based on micro-Doppler signatures separation[J]. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 5105014. doi: 10.1109/TGRS.2021.3105124.[16] LUO Fei, BODANESE E, KHAN S, et al. Spectro-temporal modeling for human activity recognition using a radar sensor network[J]. IEEE Transactions on Geoscience and Remote Sensing, 2023, 61: 5103913. doi: 10.1109/TGRS.2023.3270365.[17] DING Chuanwei, CHAE R, WANG Jing, et al. Inattentive driving behavior detection based on portable FMCW radar[J]. IEEE Transactions on Microwave Theory and Techniques, 2019, 67(10): 4031–4041. doi: 10.1109/TMTT.2019.2934413.[18] WANG Bo, ZHANG Hao, and GUO Yongxin. Radar-based soft fall detection using pattern contour vector[J]. IEEE Internet of Things Journal, 2023, 10(3): 2519–2527. doi: 10.1109/JIOT.2022.3213693.[19] 元志安, 周笑宇, 刘心溥, 等. 基于RDSNet的毫米波雷达人体跌倒检测方法[J]. 雷达学报, 2021, 10(4): 656–664. doi: 10.12000/JR21015.YUAN Zhi’an, ZHOU Xiaoyu, LIU Xinpu, et al. Human fall detection method using millimeter-wave radar based on RDSNet[J]. Journal of Radars, 2021, 10(4): 656–664. doi: 10.12000/JR21015.[20] TAHMOUSH D and SILVIOUS J. Radar micro-Doppler for long range front-view gait recognition[C]. 3rd IEEE International Conference on Biometrics: Theory, Applications, and Systems (BTAS), Washington, USA, 2009: 1–6. doi: 10.1109/BTAS.2009.5339049.[21] ALNUJAIM I, RAM S S, OH D, et al. Synthesis of micro-Doppler signatures of human activities from different aspect angles using generative adversarial networks[J]. IEEE Access, 2021, 9: 46422–46429. doi: 10.1109/ACCESS.2021.3068075.[22] QI Fugui, LI Zhao, MA Yangyang, et al. Generalization of channel micro-Doppler capacity evaluation for improved finer-grained human activity classification using MIMO UWB radar[J]. IEEE Transactions on Microwave Theory and Techniques, 2021, 69(11): 4748–4761. doi: 10.1109/TMTT.2021.3076055.[23] FIORANELLI F, PATEL J, GÜRBÜZ S Z, et al. Multistatic human micro-Doppler classification with degraded/jammed radar data[C]. 2019 IEEE Radar Conference (RadarConf), Boston, USA, 2019: 1–6. doi: 10.1109/RADAR.2019.8835618.[24] THIEL M and SARABANDI K. Ultrawideband multi-static scattering analysis of human movement within buildings for the purpose of stand-off detection and localization[J]. IEEE Transactions on Antennas and Propagation, 2011, 59(4): 1261–1268. doi: 10.1109/TAP.2011.2109349.[25] FIORANELLI F, RITCHIE M, and GRIFFITHS H. Aspect angle dependence and multistatic data fusion for micro-Doppler classification of armed/unarmed personnel[J]. IET Radar, Sonar & Navigation, 2015, 9(9): 1231–1239. doi: 10.1049/iet-rsn.2015.0058.[26] FAIRCHILD D P and NARAYANAN R M. Multistatic micro-Doppler radar for determining target orientation and activity classification[J]. IEEE Transactions on Aerospace and Electronic Systems, 2016, 52(1): 512–521. doi: 10.1109/TAES.2015.130595.[27] FIORANELLI F, RITCHIE M, GÜRBÜZ S Z, et al. Feature diversity for optimized human micro-Doppler classification using multistatic radar[J]. IEEE Transactions on Aerospace and Electronic Systems, 2017, 53(2): 640–654. doi: 10.1109/TAES.2017.2651678.[28] QIAO Xingshuai, LI Gang, SHAN Tao, et al. Human activity classification based on moving orientation determining using multistatic micro-Doppler radar signals[J]. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 5104415. doi: 10.1109/TGRS.2021.3100482.[29] YU J T, YEN Li, and TSENG P H. mmWave radar-based hand gesture recognition using range-angle image[C]. 2020 IEEE 91st Vehicular Technology Conference (VTC2020-Spring), Antwerp, Belgium, 2020: 1–5. doi: 10.1109/VTC2020-Spring48590.2020.9128573.[30] ZHAO Yubin, YAROVOY A, and FIORANELLI F. Angle-insensitive human motion and posture recognition based on 4D imaging radar and deep learning classifiers[J]. IEEE Sensors Journal, 2022, 22(12): 12173–12182. doi: 10.1109/JSEN.2022.3175618.[31] YANG Yang, HOU Chunping, LANG Yue, et al. Omnidirectional motion classification with monostatic radar system using micro-Doppler signatures[J]. IEEE Transactions on Geoscience and Remote Sensing, 2020, 58(5): 3574–3587. doi: 10.1109/TGRS.2019.2958178.[32] YANG Yang, ZHANG Yutong, SONG Chunying, et al. Omnidirectional spectrogram generation for radar-based omnidirectional human activity recognition[J]. IEEE Transactions on Geoscience and Remote Sensing, 2023, 61: 5105513. doi: 10.1109/TGRS.2023.3278409.[33] YANG Yang, LI Junhan, LI Beichen, et al. Few-shot omnidirectional human motion recognition using monostatic radar system[J]. IEEE Transactions on Instrumentation and Measurement, 2023, 72: 2531414. doi: 10.1109/TIM.2023.3328079.[34] 张哲熙. 基于BM3D的图像去噪算法研究[D]. [硕士论文], 西安电子科技大学, 2017.ZHANG Zhexi. Research on image denoising algorithm based on BM3D[D]. [Master dissertation], Xidian University, 2017.[35] DABOV K, FOI A, KATKOVNIK V, et al. Image denoising with block-matching and 3D filtering[C]. Image Processing: Algorithms and Systems, Neural Networks, and Machine Learning, San Jose, USA, 2006: 606414. doi: 10.1117/12.643267.[36] WANG Xinheng, ISTEPANIAN R S H, and SONG Yonghua. Microarray image enhancement by denoising using stationary wavelet transform[J]. IEEE Transactions on Nanobioscience, 2003, 2(4): 184–189. doi: 10.1109/TNB.2003.816225.[37] 王安义, 战金龙, 卢建军. 一种新的二维Capon算法的研究[J]. 西安科技学院学报, 2003, 23(4): 437–440. doi: 10.3969/j.issn.1672-9315.2003.04.023.WANG Anyi, ZHAN Jinlong, and LU Jianjun. A new 2-D Capon algorithm[J]. Journal of Xi’an University of Science and Technology, 2003, 23(4): 437–440. doi: 10.3969/j.issn.1672-9315.2003.04.023.[38] RAHMAN S A and ADJEROH D A. Deep learning using convolutional LSTM estimates biological age from physical activity[J]. Scientific Reports, 2019, 9(1): 11425. doi: 10.1038/s41598-019-46850-0.[39] SUDHAKARAN S and LANZ O. Convolutional long short-term memory networks for recognizing first person interactions[C]. The IEEE International Conference on Computer Vision Workshops (ICCVW), Venice, Italy, 2017: 2339–2346. doi: 10.1109/ICCVW.2017.276.[40] KIM Y and MOON T. Human detection and activity classification based on micro-Doppler signatures using deep convolutional neural networks[J]. IEEE Geoscience and Remote Sensing Letters, 2016, 13(1): 8–12. doi: 10.1109/LGRS.2015.2491329.[41] LI Wenxuan, ZHANG Dongheng, LI Yadong, et al. Real-time fall detection using mmWave radar[C]. IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), Singapore, 2022: 16–20. doi: 10.1109/ICASSP43922.2022.9747153.[42] KIM Y, ALNUJAIM I, and OH D. Human activity classification based on point clouds measured by millimeter wave MIMO radar with deep recurrent neural networks[J]. IEEE Sensors Journal, 2021, 21(12): 13522–13529. doi: 10.1109/JSEN.2021.3068388. Relative Articles

[1] ZHANG Rui, GONG Hanqin, SONG Ruiyuan, LI Yadong, LU Zhi, ZHANG Dongheng, HU Yang, CHEN Yan. Through-wall Human Pose Reconstruction and Action Recognition Using Four-dimensional Imaging Radar[J]. Journal of Radars, 2025, 14(1): 44-61. doi: 10.12000/JR24132 [2] WANG Xiang, WANG Yumiao, CHEN Xingyu, ZANG Chuanfei, CUI Guolong. Deep Learning-based Marine Target Detection Method with Multiple Feature Fusion[J]. Journal of Radars, 2024, 13(3): 554-564. doi: 10.12000/JR23105 [3] XIAO Jiong, TANG Bo, WANG Hai. Sparse Reconstruction-based Direction of Arrival Estimation for MIMO Radar in the Presence of Unknown Mutual Coupling[J]. Journal of Radars, 2024, 13(5): 1123-1133. doi: 10.12000/JR24061 [4] TIAN Ye, DING Chibiao, ZHANG Fubo, SHI Min’an. SAR Building Area Layover Detection Based on Deep Learning[J]. Journal of Radars, 2023, 12(2): 441-455. doi: 10.12000/JR23033 [5] HE Mi, PING Qinwen, DAI Ran. Fall Detection Based on Deep Learning Fusing Ultrawideband Radar Spectrograms[J]. Journal of Radars, 2023, 12(2): 343-355. doi: 10.12000/JR22169 [6] CHEN Xiang, WANG Liandong, XU Xiong, SHEN Xujian, FENG Yuntian. A Review of Radio Frequency Fingerprinting Methods Based on Raw I/Q and Deep Learning[J]. Journal of Radars, 2023, 12(1): 214-234. doi: 10.12000/JR22140 [7] DING Zihang, XIE Junwei, WANG Bo. Missing Covariance Matrix Recovery with the FDA-MIMO Radar Using Deep Learning Method[J]. Journal of Radars, 2023, 12(5): 1112-1124. doi: 10.12000/JR23002 [8] HE Zishu, CHENG Ziyang, LI Jun, ZHANG Wei, SHI Jingxi, SU Yang, DENG Minglong. A Survey of Collocated MIMO Radar[J]. Journal of Radars, 2022, 11(5): 805-829. doi: 10.12000/JR22128 [9] CHEN Siwei, CUI Xingchao, LI Mingdian, TAO Chensong, LI Haoliang. SAR Image Active Jamming Type Recognition Based on Deep CNN Model[J]. Journal of Radars, 2022, 11(5): 897-908. doi: 10.12000/JR22143 [10] HUANG Zhongling, YAO Xiwen, HAN Junwei. Progress and Perspective on Physically Explainable Deep Learning for Synthetic Aperture Radar Image Interpretation(in English)[J]. Journal of Radars, 2022, 11(1): 107-125. doi: 10.12000/JR21165 [11] ZHANG Guoxin, YI Wei, KONG Lingjiang. Direct Position Determination for Massive MIMO System with One-bit Quantization[J]. Journal of Radars, 2021, 10(6): 970-981. doi: 10.12000/JR21062 [12] LUO Ying, NI Jiacheng, ZHANG Qun. Synthetic Aperture Radar Learning-imaging Method Based onData-driven Technique and Artificial Intelligence[J]. Journal of Radars, 2020, 9(1): 107-122. doi: 10.12000/JR19103 [13] Zhao Feixiang, Liu Yongxiang, Huo Kai. A Radar Target Classification Algorithm Based on Dropout Constrained Deep Extreme Learning Machine[J]. Journal of Radars, 2018, 7(5): 613-621. doi: 10.12000/JR18048 [14] Gong Pengcheng, Liu Gang, Huang He, Wang Wenqin. Multidimensional Parameter Estimation Method Based on Sparse Iteration in FDA-MIMO Radar[J]. Journal of Radars, 2018, 7(2): 194-201. doi: 10.12000/JR16121 [15] Luo Ying, Gong Yishuai, Chen Yijun, Zhang Qun. Multi-target Micro-motion Feature Extraction Based on Tracking Pulses in MIMO Radar[J]. Journal of Radars, 2018, 7(5): 575-584. doi: 10.12000/JR18035 [16] Wang Jun, Zheng Tong, Lei Peng, Wei Shaoming. Study on Deep Learning in Radar[J]. Journal of Radars, 2018, 7(4): 395-411. doi: 10.12000/JR18040 [17] Xu Xiaojian, Liu Yongze. Three-dimensional Interferometric MIMO Radar Imaging for Target Scattering Diagnosis[J]. Journal of Radars, 2018, 7(6): 655-663. doi: 10.12000/JR18088 [18] Xu Feng, Wang Haipeng, Jin Yaqiu. Deep Learning as Applied in SAR Target Recognition and Terrain Classification[J]. Journal of Radars, 2017, 6(2): 136-148. doi: 10.12000/JR16130 [19] Liang Hao, Cui Chen, Yu Jian. Two-dimensional DOA Estimation with High Accuracy for MIMO Radar Using Cross Array[J]. Journal of Radars, 2016, 5(3): 254-264. doi: 10.12000/JR16016 [20] Wang Ting, Zhao Yong-jun, Hu Tao. Overview of Space-Time Adaptive Processing for Airborne Multiple-Input Multiple-Output Radar[J]. Journal of Radars, 2015, 4(2): 136-148. doi: 10.12000/JR14091 -

Proportional views

- Figure 1. Conventional feature maps of the example “tangential bow” posture

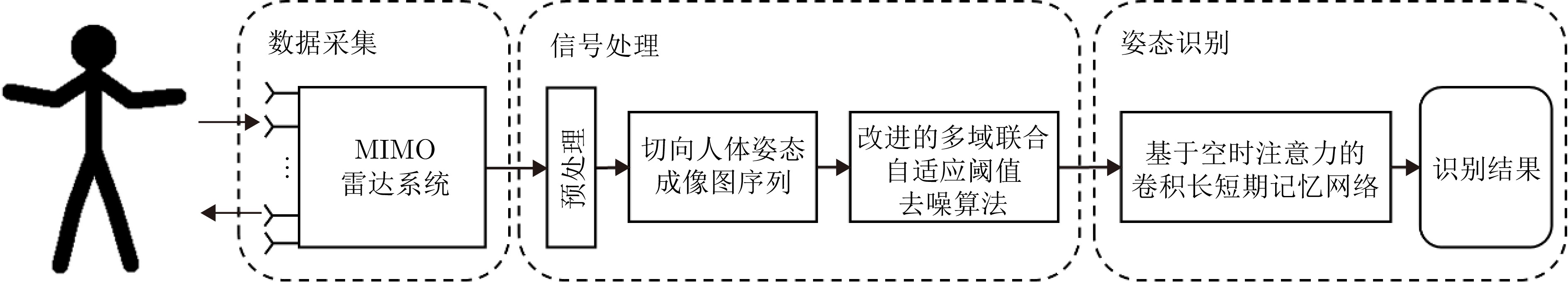

- Figure 2. The framework of the proposed tangential human posture recognition with sequential images based on MIMO radar

- Figure 3. The flow chart of tangential human posture sequential images based on MIMO radar

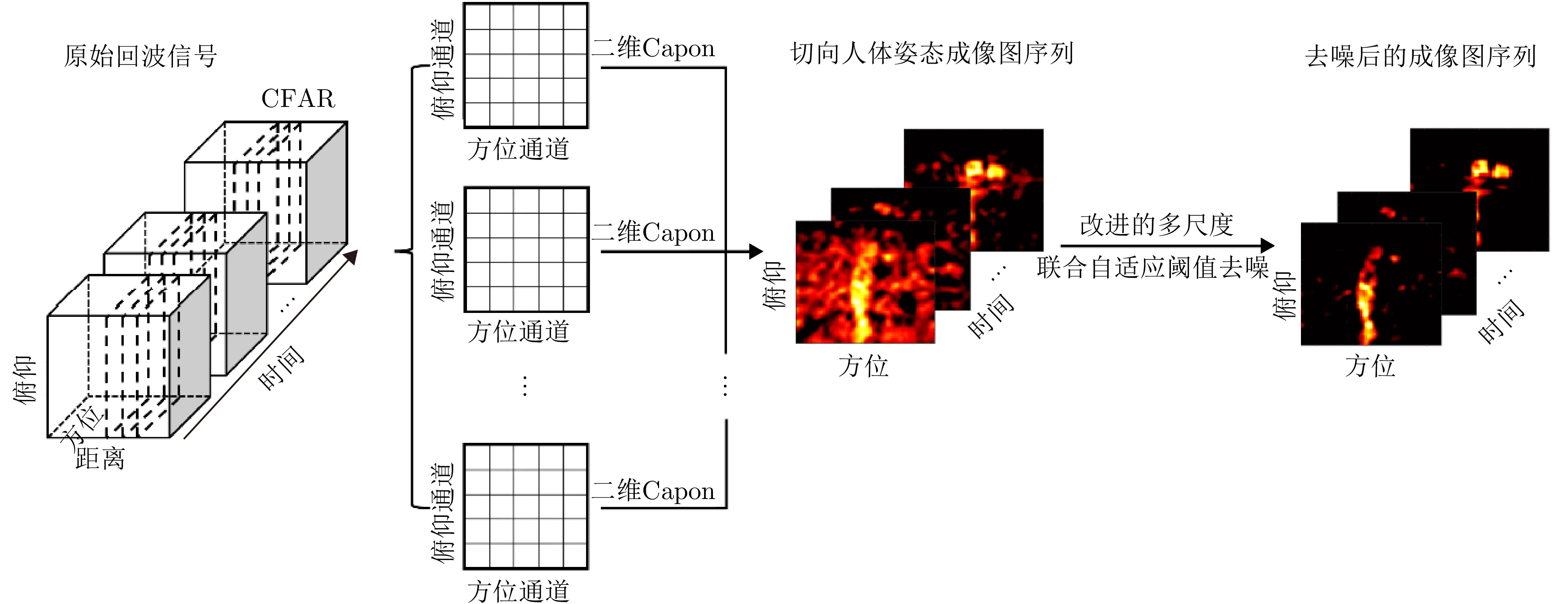

- Figure 4. The flow chart of modified joint multi-domain adaptive threshold-based image denoising algorithm

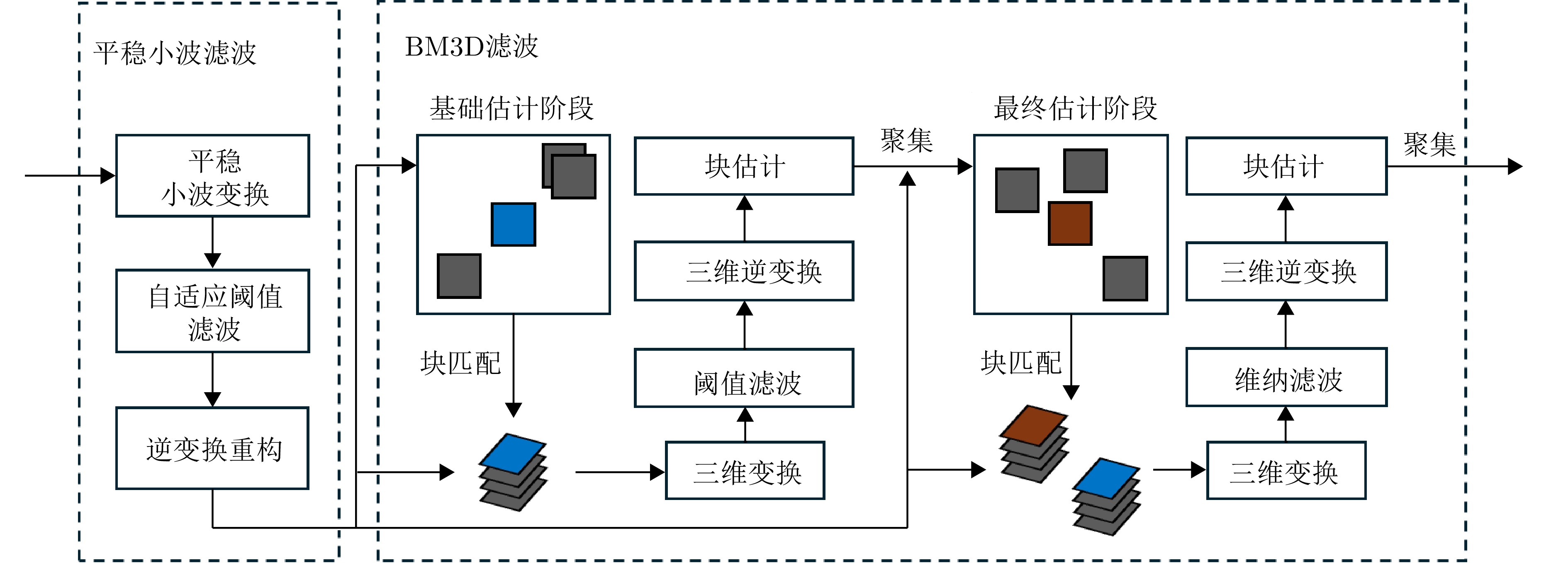

- Figure 5. Sequential images of “tangential bow” human posture

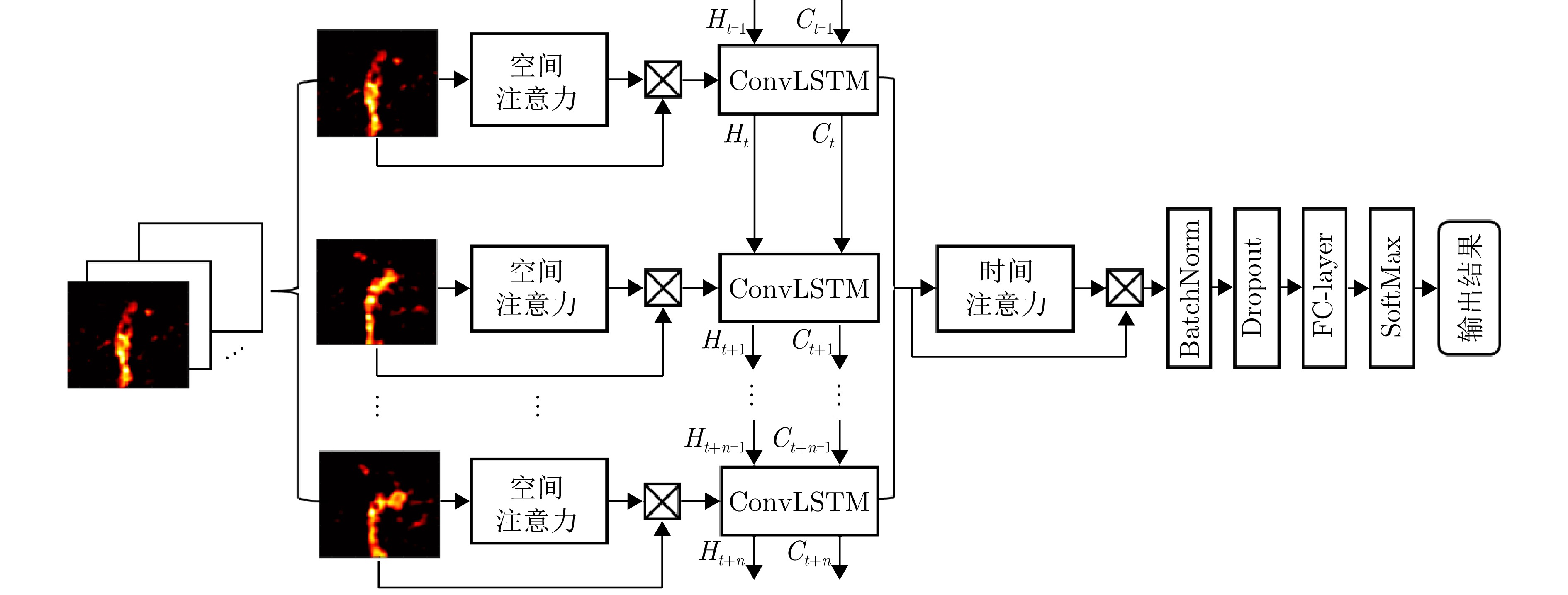

- Figure 6. ST-ConvLSTM network structure diagram

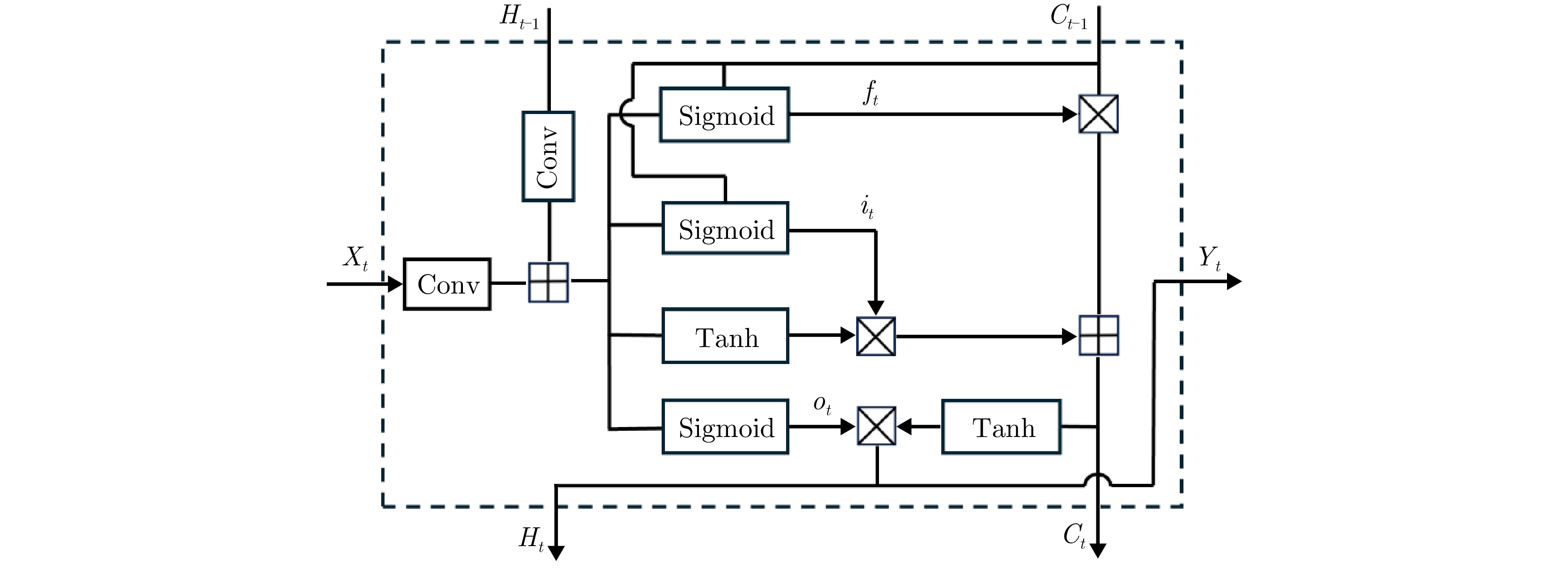

- Figure 7. The architecture of ConvLSTM cell

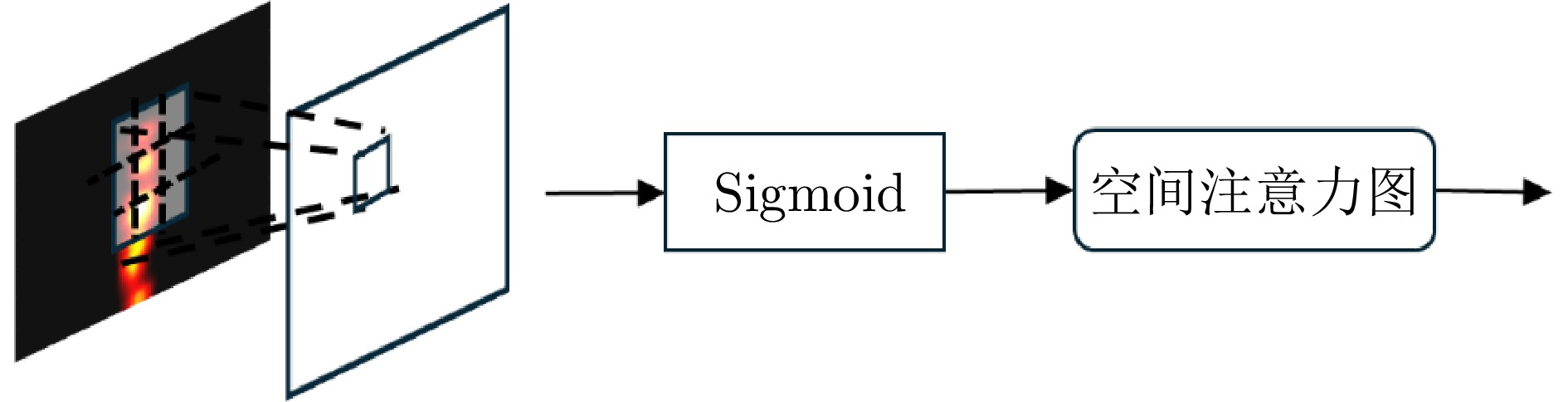

- Figure 8. The architecture of the spatial attention module

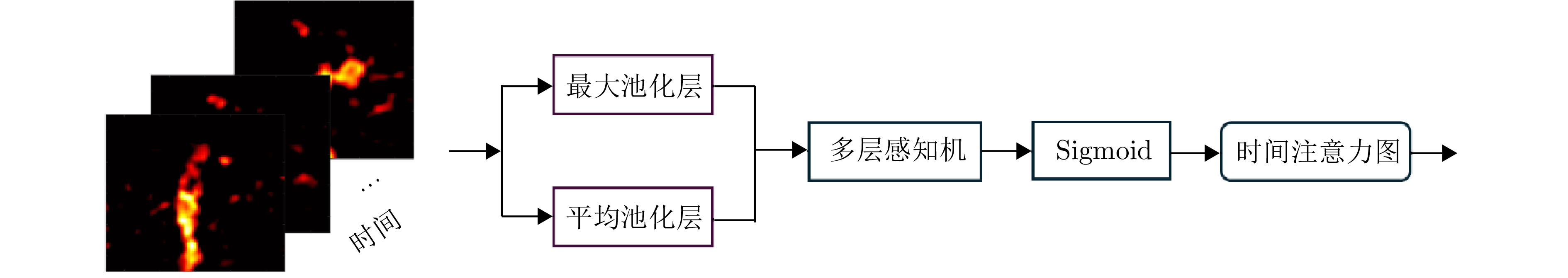

- Figure 9. The architecture of the temporal attention module

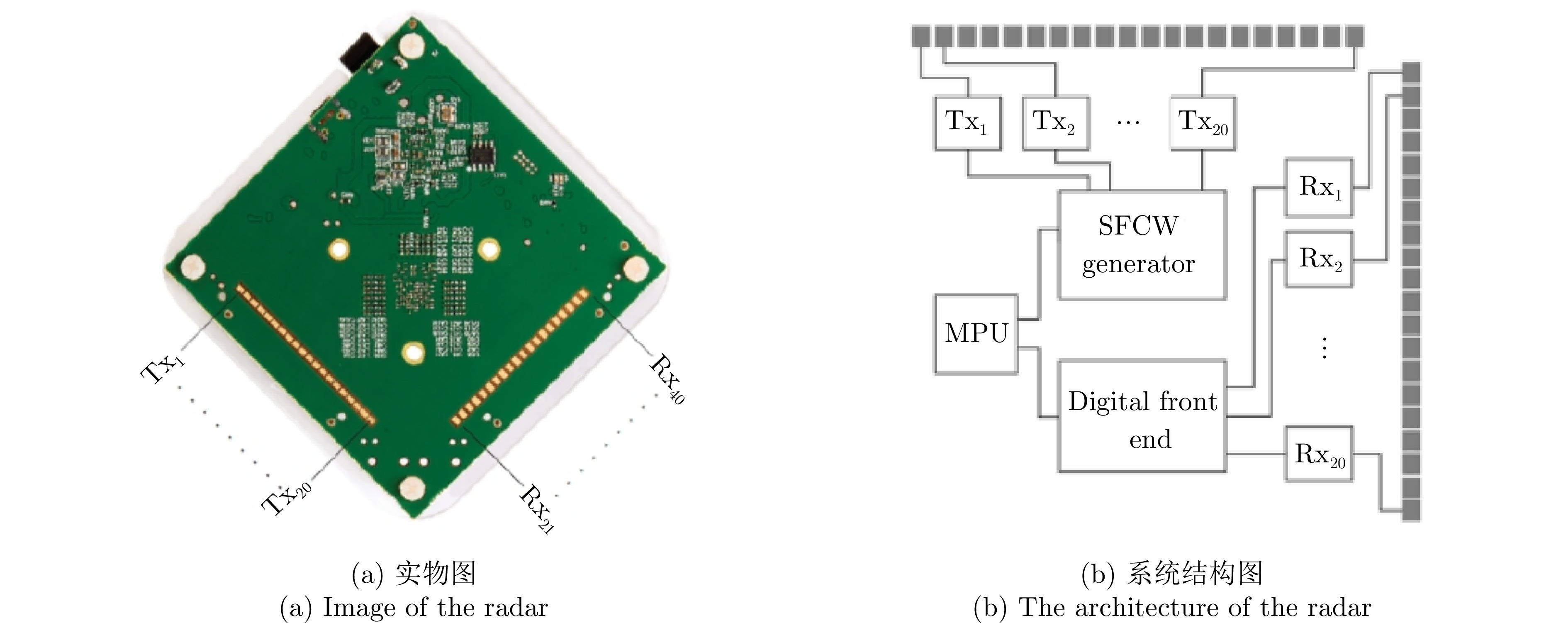

- Figure 10. IMAGEVK-74 radar schematic

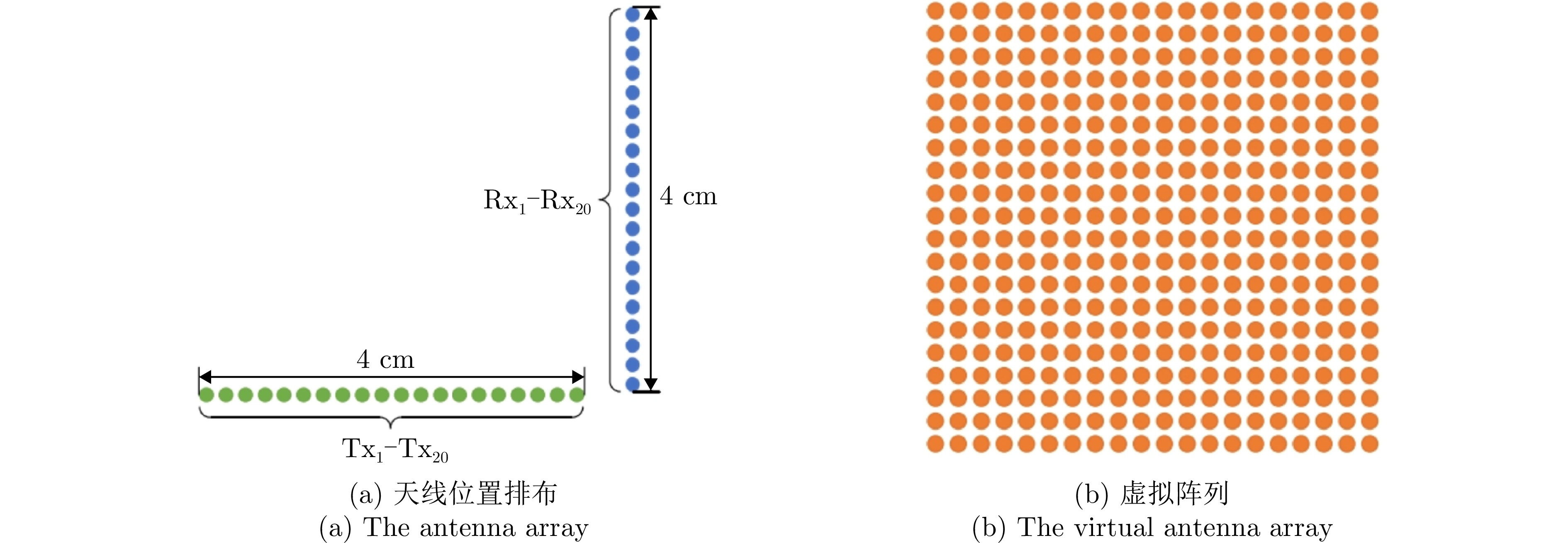

- Figure 11. IMAGEVK-74 antenna array

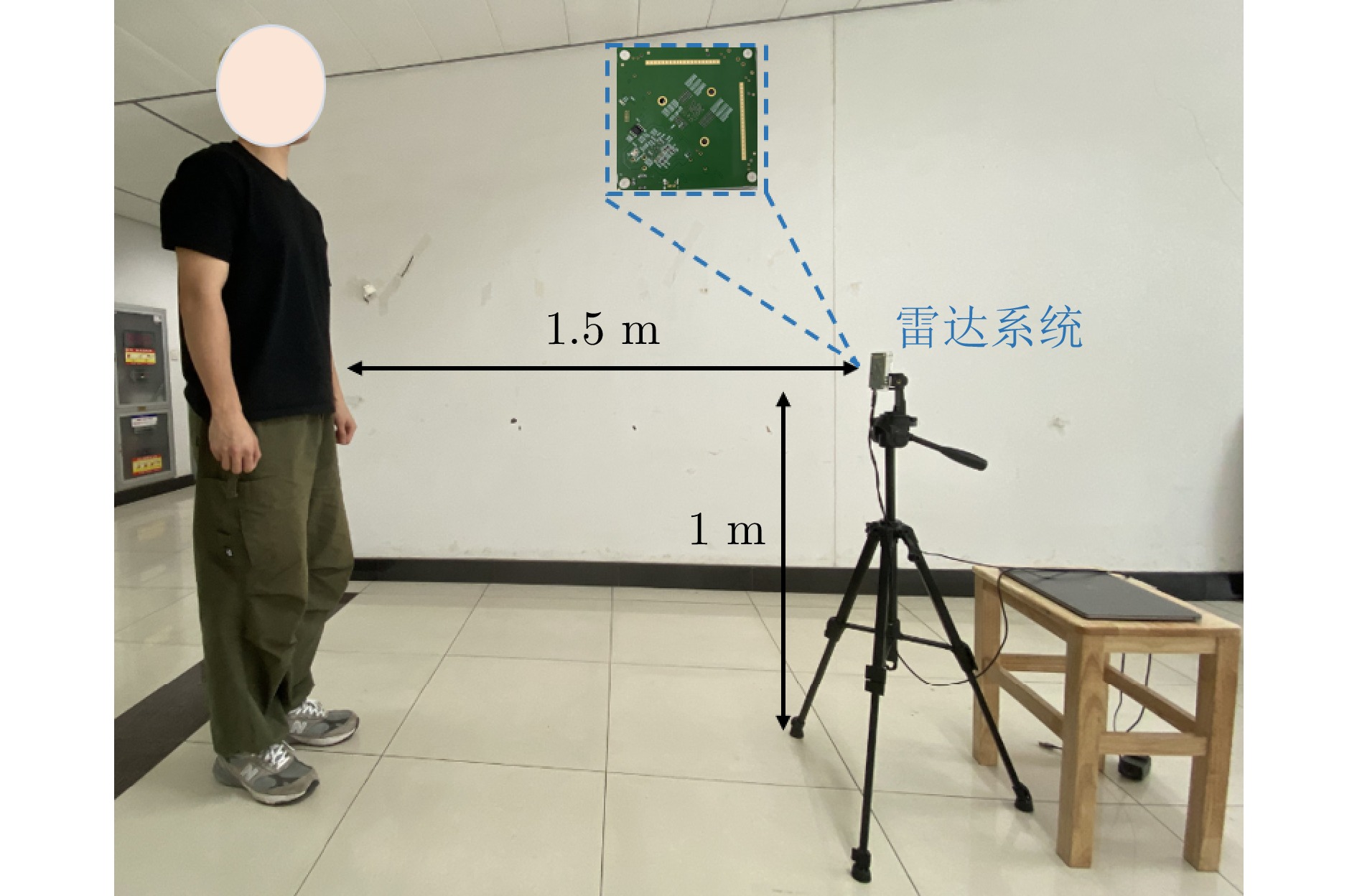

- Figure 12. The experiment setup

- Figure 13. Illustrations of eight typical tangential human postures

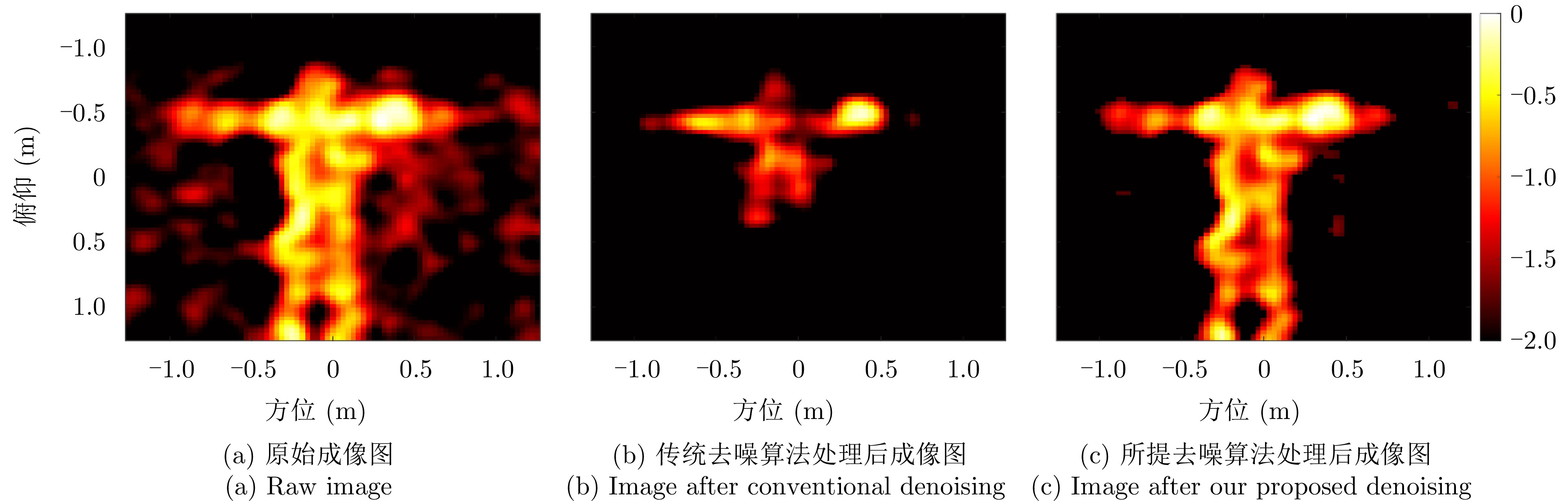

- Figure 14. Images of “arm spread” posture before and after denoising processing

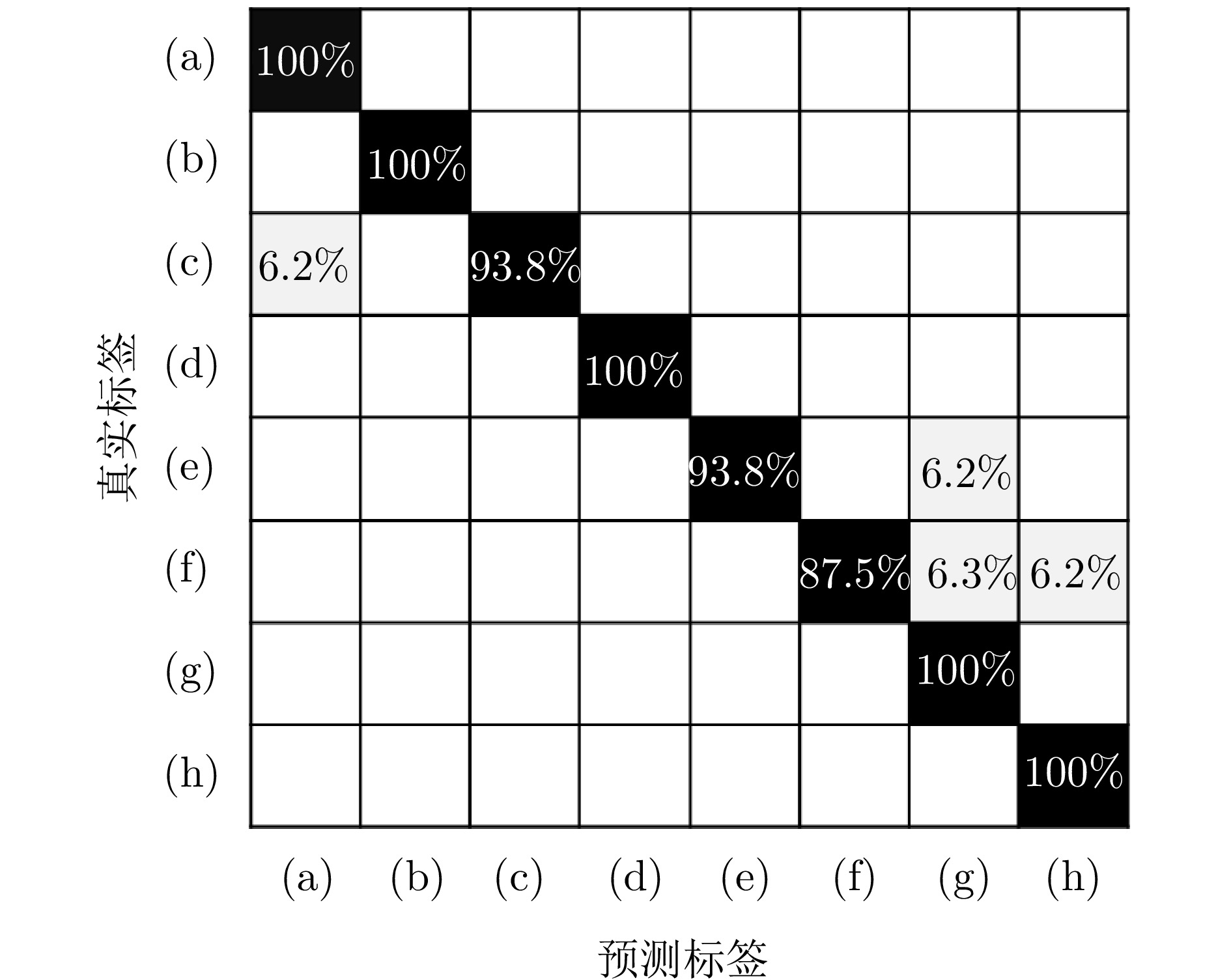

- Figure 15. Recognition results of tangential human postures by ST-ConvLSTM network based on imaging sequence ((a)—(h) indicate tangential human activities, respectively)

- Figure 16. 2D t-SNE visualization results of tangential human postures recognition methods

Submit Manuscript

Submit Manuscript Peer Review

Peer Review Editor Work

Editor Work

下载:

下载:

DownLoad:

DownLoad: