A Novel Approach to Change Detection in SAR Images with CNN Classification

-

摘要:

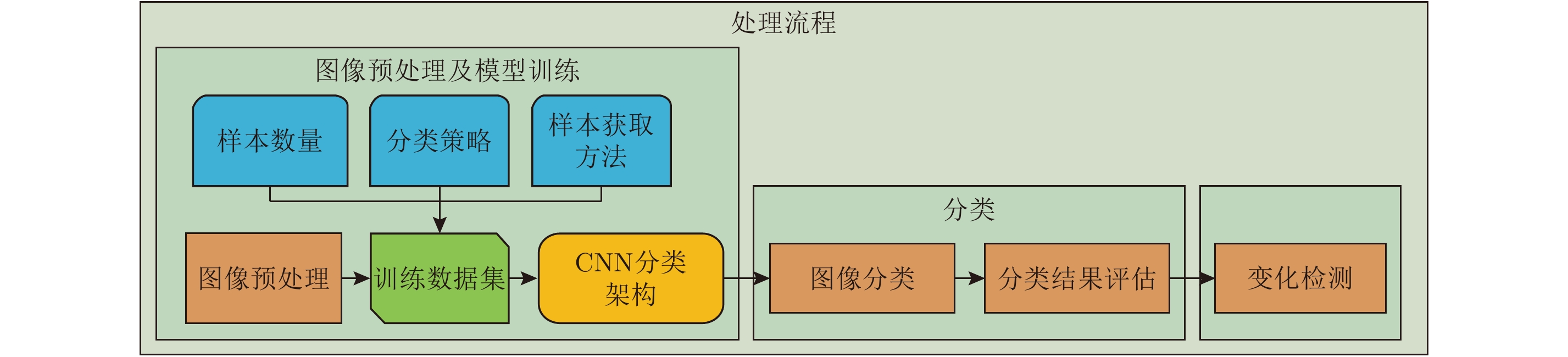

该文提出了一种基于卷积神经网络(CNN)及有效图像预处理的合成孔径雷达(SAR)图像变化检测方法。为了验证方法的有效性,以2011年日本仙台地区地震导致的城区变化为例进行了研究。在预处理中分别利用DEM模型以及Otsu方法对SAR图像中的山体和水体进行了提取和去除。利用多层卷积神经网络从SAR图像中自动学习目标特征,再利用学习到的特征对图像进行分类。训练集和测试集的分类精度分别达到了98.25%和97.86%。利用图像差值法得到分类后的SAR图像变化检测结果,并验证了该方法的准确性和有效性。另外,文中给出了基于CNN的变化检测方法和传统方法的对比结果。结果表明,相对于传统方法,基于CNN的变化检测方法具有更高的检测精度。

Abstract:This paper presents a novel Synthetic Aperture Radar (SAR)-image-change-detection method, which integrates effective-image preprocessing and Convolutional Neural Network (CNN) classification. To validate the efficiency of the proposed method, two SAR images of the same devastated region obtained by TerraSAR-X before and after the 2011 Tohoku earthquake are investigated. During image preprocessing, the image backgrounds such as mountains and water bodies are extracted and removed using Digital Elevation Model (DEM) model and Otsu’s thresholding method. A CNN is employed to automatically extract hierarchical feature representation from the data. The SAR image is then classified with the theoretically obtained features. The classification accuracies of the training and testing datasets are 98.25% and 97.86%, respectively. The changed areas between two SAR images are detected using image difference method. The accuracy and efficiency of the proposed method are validated. In addition, with other traditional methods as comparison, this paper presents change-detection results using the proposed method. Results show that the proposed method has higher accuracy in comparison with traditional change-detection methods.

-

表 1 几种变化检测方法精度对比

Table 1. Accuracy comparison of several change detection methods

方法 检测率(%) 虚警率(%) 总误差率(%) Kappa系数 基于CNN的方法 93.93 6.09 9.69 0.91 Log-ratio方法 93.68 36.62 29.29 0.90 PCA方法 86.62 10.92 20.11 0.84 MRF方法 88.36 14.65 20.06 0.85 -

[1] Cumming I G and Wong F H. Digital Processing of Synthetic Aperture Radar Data: Algorithms and Implementation[M]. Norwood, MA: Artech House, 2005. [2] Wikipedia. 2011 Tohoku earthquake and tsunami[OL]. http://en.wikipedia.org/wiki/2011_Tohoku_earthquake_ and_tsunami. [3] Chini M, Pacifici F, Emery W, et al. Comparing statistical and neural network methods applied to very high resolution satellite images showing changes in man-made structures at rocky flats[J]. IEEE Transactions on Geoscience and Remote Sensing, 2008, 46(6): 1812–1821. DOI: 10.1109/TGRS.2008.916223. [4] Liao P S, Chen T S, and Chung P C. A fast algorithm for multilevel thresholding[J]. Journal of Information Science and Engineering, 2001, 17(5): 713–727. [5] Bovolo F and Bruzzone L. A detail-preserving scale-driven approach to change detection in multitemporal SAR images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2005, 43(12): 2963–2972. DOI: 10.1109/TGRS.2005.857987. [6] Celik T. Unsupervised change detection in satellite images using principal component analysis and k-means clustering[J]. IEEE Geoscience and Remote Sensing Letters, 2009, 6(4): 772–776. DOI: 10.1109/LGRS.2009.2025059. [7] 杨祥立, 徐德伟, 黄平平, 等. 融合相干/非相干信息的高分辨率SAR图像变化检测[J]. 雷达学报, 2015, 4(5): 582–590. doi: 10.12000/JR15073Yang Xiang-li, Xu De-wei, Huang Ping-ping, et al. Change detection of high resolution SAR images by the fusion of coherent/incoherent information[J]. Journal of Radars, 2015, 4(5): 582–590. DOI: 10.12000/JR15073. [8] Wu Ke, Zhong Yan-fei, Wang Xian-min, et al. A novel approach to subpixel land-cover change detection based on a supervised back-propagation neural network for remotely sensed images with different resolutions[J].IEEE Geoscience and Remote Sensing Letters, 2017, 14(10): 1750–1754. DOI: 10.1109/LGRS.2017.2733558. [9] Feng Wen-qing, Sui Hai-gang, and Tu Ji-hui. Object-oriented change detection for remote sensing images based on multi-scale fusion[C]. The International Archives of the Photogrammetry, Remote Sensing and Spatial Information Sciences, Volume XLI-B7, 2016: 483–491. DOI: 10.5194/isprs-archives-XLI-B7-483-2016. [10] Yu Wen-juan, Zhou Wei-qi, Qian Yu-guo, et al. A new approach for land cover classification and change analysis: Integrating backdating and an object-based method[J]. Remote Sensing of Environment, 2016, 177: 37–47. DOI: 10.1016/j.rse.2016.02.030. [11] Blaschke T. Object based image analysis for remote sensing[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2010, 65(1): 2–16. DOI: 10.1016/j.isprsjprs.2009.06.004. [12] Wu Chen, Du Bo, Cui Xiao-hui, et al. A post-classification change detection method based on iterative slow feature analysis and Bayesian soft fusion[J]. Remote Sensing of Environment, 2017, 199: 241–255. DOI: 10.1016/j.rse.2017.07.009. [13] 田壮壮, 占荣辉, 胡杰民, 等. 基于卷积神经网络的SAR图像目标识别研究[J]. 雷达学报, 2016, 5(3): 320–325. doi: 10.12000/JR16037Tian Zhuang-zhuang, Zhan Rong-hui, Hu Jie-min, et al. SAR ATR based on convolutional neural network[J]. Journal of Radars, 2016, 5(3): 320–325. DOI: 10.12000/JR16037. [14] Wei X, Huang P P, Wang R, et al. Processing of multichannel sliding spotlight and TOPS synthetic aperture radar data[J]. IEEE Transactions on Geoscience and Remote Sensing, 2013, 51(8): 4417–4429. DOI: 10.1109/TGRS.2013.2265306. [15] Simonyan K and Zisserman A. Very deep convolutional networks for large-scale image recognition[R]. International Conference on Learning Representations (ICLR), San Diego, CA, America, May, 2015. [16] 杜康宁, 邓云凯, 王宇, 等. 基于多层神经网络的中分辨SAR图像时间序列建筑区域提取[J]. 雷达学报, 2016, 5(4): 410–418. doi: 10.12000/JR16060Du Kangning, Deng Yunkai, Wang Yu, et al. Medium resolution SAR image time-series built-up area extraction based on multilayer neural network[J]. Journal of Radars, 2016, 5(4): 410–418. DOI: 10.12000/JR16060. [17] Sezgin, M and Sankur B. Survey over image thresholding techniques and quantitative performance evaluation[J]. Journal of Electronic Imaging, 2004, 13(1): 146–165. DOI: 10.1117/1.1631315. [18] Glorot X, Bordes A, and Bengio Y. Deep sparse rectifier neural networks[C]. 14th International Conference on Artificial Intelligence and Statistics, Fort Lauderdale, USA, 2011: 315–323. [19] Ioffe S and Szegedy C. Batch normalization: Accelerating deep network training by reducing internal covariate shift[C]. 32nd International Conference on Machine Learning, Lille, France, 2015: 448–456. [20] Kingma D P and Ba J. Adam: A method for stochastic optimization[C]. 3rd International Conference for Learning Representations, San Diego, arXiv: 1412.6980, 2015. [21] Goodfellow I, Bengio Y, and Courville A. Deep Learning[OL]. 2016. http://www.deeplearningbook.org/. [22] ©ZKI/DLR. 2011. Earthquake and Tsunami in Japan[OL]. http://www.zki.dlr.de/article/1893. [23] Okajima Y, Yoshikawa K, and Shibayama T. Recent experiences utilizing TerraSAR-X for the monitoring of natural disasters in different parts of the world[C]. 2011 IEEE International Geoscience and Remote Sensing Symposium (IGARSS), Vancouver, BC, Canada, July, 2011: 4296–4299. DOI: 10.1109/IGARSS.2011.6050181. [24] Dumitru C O, Cui S Y, Faur D, et al. Data analytics for rapid mapping: Case study of a flooding event in Germany and the tsunami in Japan using very high resolution SAR images[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2015, 8(1): 114–129. DOI: 10.1109/JSTARS.2014.2320777. [25] Bruzzone L and Prieto D F. Automatic analysis of the difference image for unsupervised change detection[J]. IEEE Transactions on Geoscience and Remote Sensing, 2000, 38(3): 1171–1182. DOI: 10.1109/36.843009. -

作者中心

作者中心 专家审稿

专家审稿 责编办公

责编办公 编辑办公

编辑办公

下载:

下载: