An Aircraft Detection Method Based on Convolutional Neural Networks in High-Resolution SAR Images

-

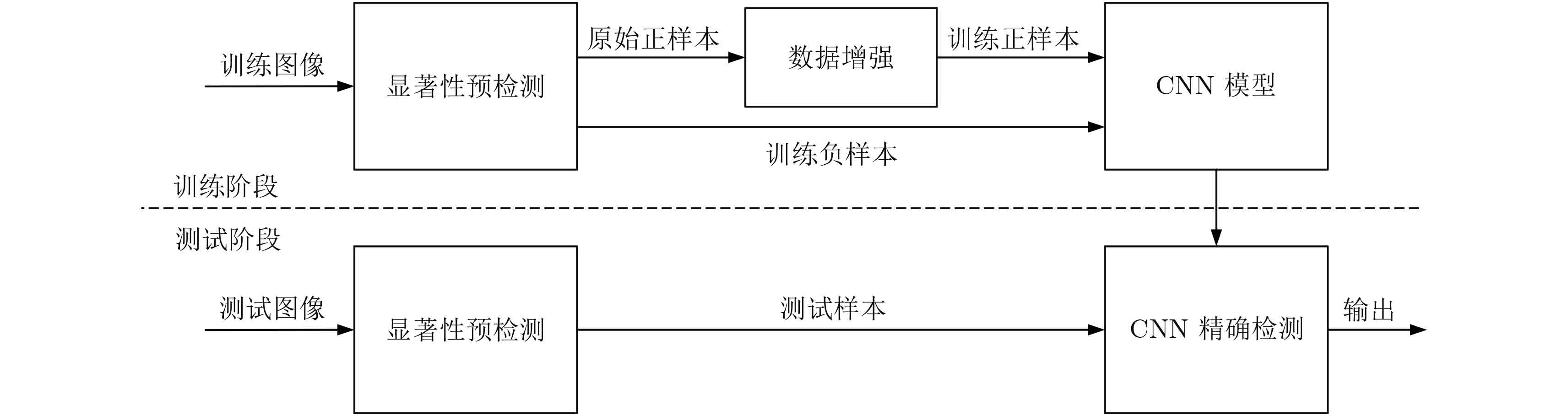

摘要: 传统的合成孔径雷达(Synthetic Aperture Radar, SAR)图像飞机检测方法一般利用像素对比度信息进行图像分割,从而提取待定目标。然而这些方法只考虑了像素亮度信息而忽视了目标的结构特征,进而导致目标的不精确定位和大量虚警的产生。基于上述问题,该文构建了一个全新的SAR图像飞机目标检测算法框架。首先,针对大场景SAR图像应用需求,提出了改进的显著性预检测方法,从而实现SAR图像候选飞机目标多尺度快速粗定位;然后,设计并调优了含4个权重层的卷积神经网络(Convolutional Neural Network, CNN),实现对候选目标的精确检测和鉴别;最后,因为SAR数据量有限、易导致过拟合,提出4种适用于SAR图像的数据增强方法,具体包括平移、斑点加噪、对比度增强和小角度旋转。实验证实该飞机检测算法在高分辨率TerraSAR-X数据集上效果显著,与传统的SAR飞机检测方法相比,该方法检测效率更高,泛化能力更强。

-

关键词:

- 合成孔径雷达(SAR) /

- 飞机检测 /

- 卷积神经网络(CNN) /

- 数据增强 /

- 视觉显著性

Abstract: In the field of image processing using Synthetic Aperture Radar (SAR), aircraft detection is a challenging task. Conventional approaches always extract targets from the background of an image using image segmentation methods. Nevertheless, these methods mainly focus on pixel contrast and neglect the integrity of the target, which leads to locating the object inaccurately. In this study, we build a novel SAR aircraft detection framework. Compared to traditional methods, an improved saliency-based method is proposed to locate candidates coarsely and quickly in large scenes. This proposed method is verified to be more efficient compared with the sliding window method. Next, we design a convolutional neural network fitting in SAR images to accurately identify the candidates and obtain the final detection result. Moreover, to overcome the problem of limited available SAR data, we propose four data augmentation methods comprising translation, speckle noising, contrast enhancement, and small-angle rotation. Experimental results show that our framework achieves excellent performance on the high-resolution TerraSAR-X dataset. -

表 1 CNN参数

Table 1. Parameters of our CNN

层结构 核结构 输出尺寸 输入层 – 120×120 C1 32@5×5 116×116 S1 2×2 58×58 C2 64@5×5 54×54 S2 2×2 27×27 C3 128@6×6 22×22 S3 2×2 11×11 表 2 不同预检测方法性能比较

Table 2. The performance of different pre-detection methods

方法 预检测 正确率(%) 候选目标 个数 预检测 时间(s) Selective search 100 569 47.50 原始显著性预检测 94.12 298 6.07 改进的显著性预检测 100 242 10.67 表 3 不同数据增强方法的检测正确率

Table 3. Accuracy rates of CNN with different augmentation methods

操作 检测正确率(%) 原始 86.33 平移 92.01 斑点加噪 93.74 对比度增强 93.64 小角度旋转 92.76 综合4种增强方法 96.36 表 4 不同网络层数的检测正确率比较

Table 4. Accuracy rates of CNN with different number of layers

网络结构 检测正确率(%) C1: 32@5×5, S1, C2: 64@5×5, S2, C3: 128@6×6, S3, C4: 256@6×6, S4 95.99 C1: 32@5×5, S1, C2: 64@5×5, S2, C3: 128@6×6, S3 (本文) 96.36 C1: 32@5×5, S1, C2: 64@5×5, S2 93.70 表 5 不同卷积核个数的检测正确率比较

Table 5. Accuracy rates of CNN with different number of kernels

网络结构 检测正确率(%) C1: 16@5×5, S1, C2: 32@5×5, S2, C3: 64@6×6, S3 93.93 C1: 32@5×5, S1, C2: 64@5×5, S2, C3: 128@6×6, S3 (本文) 96.36 C1: 64@5×5, S1, C2: 128@5×5, S2, C3: 256@6×6, S3 95.05 表 6 不同卷积核大小的检测正确率比较

Table 6. Accuracy rates of CNN with different size of kernels

网络结构 检测正确率(%) C1: 32@3×3, S1, C2: 64@3×3, S2, C3: 128@3×3, S3 95.96 C1: 32@5×5, S1, C2: 64@5×5, S2, C3: 128@6×6, S3 (本文) 96.36 C1: 32@5×5, S1, C2: 64@5×5, S2, C3: 128@5×5, S3 96.16 表 7 不同方法在同一数据集上的平均检测率

Table 7. Average detection rates of different methods on the same dataset

方法 检测正确率(%) CNN 96.36 SVM 92.64 HOG+SVM 93.79 AdaBoost 92.28 -

[1] El-Darymli K, McGuire P, Power D, et al. Target detection in synthetic aperture radar imagery: A state-of-the-art survey[J].Journal of Applied Remote Sensing, 2013, 7(1): 071598. doi: 10.1117/1.JRS.7.071598 [2] Steenson B O. Detection performance of a mean-level threshold[J].IEEE Transactions on Aerospace and Electronic Systems, 1968, 4(4): 529–534. [3] Gandhi P P and Kassam S A. Analysis of CFAR processors in homogeneous background[J].IEEE Transactions on Aerospace and Electronic Systems, 1988, 24(4): 427–445. doi: 10.1109/7.7185 [4] Novak L M and Hesse S R. On the performance of order-statistics CFAR detectors[C]. IEEE 25th Asilomar Conference on Signals, Systems and Computers, Pacific Grove, California, USA, Nov. 1991: 835–840. [5] Smith M E and Varshney P K. VI-CFAR: A novel CFAR algorithm based on data variability[C]. IEEE National Radar Conference, Syracuse, NY, May 1997: 263–268. [6] Ai Jia-qiu, Qi Xiang-yang, Yu Wei-dong, et al. A new CFAR ship detection algorithm based on 2-D joint log-normal distribution in SAR images[J].IEEE Geoscience and Remote Sensing Letters, 2010, 7(4): 806–810. doi: 10.1109/LGRS.2010.2048697 [7] di Bisceglie M and Galdi C. CFAR detection of extended objects in high-resolution SAR images[J].IEEE Transactions on Geoscience and Remote Sensing, 2005, 43(4): 833–843. doi: 10.1109/TGRS.2004.843190 [8] Jung C H, Kwag Y K, and Song W Y. CFAR detection algorithm for ground target in heterogeneous clutter using high resolution SAR image[C]. 3rd International Asia-Pacific Conference on Synthetic Aperture Radar (APSAR), Seoul, South Korea, Sep. 2011: 1–4. [9] Olson C F and Huttenlocher D P. Automatic target recognition by matching oriented edge pixels[J].IEEE Transactions on Image Processing, 1997, 6(1): 103–113. doi: 10.1109/83.552100 [10] Kaplan L M. Improved SAR target detection via extended fractal features[J].IEEE Transactions on Aerospace and Electronic Systems, 2001, 37(2): 436–451. doi: 10.1109/7.937460 [11] Sandirasegaram N M. Spot SAR ATR using wavelet features and neural network classifier[R]. Defence Research and Development Canada Ottawa (Ontario), 2005. [12] Tan Yi-hua, Li Qing-yun, Li Yan-sheng, et al. Aircraft detection in high-resolution SAR images based on a gradient textural saliency map[J].Sensors, 2015, 15(9): 23071–23094. doi: 10.3390/s150923071 [13] Jao J K, Lee C E, and Ayasli S. Coherent spatial filtering for SAR detection of stationary targets[J].IEEE Transactions on Aerospace and Electronic Systems, 1999, 35(2): 614–626. doi: 10.1109/7.766942 [14] Zhao Q and Principe J C. Support vector machines for SAR automatic target recognition[J].IEEE Transactions on Aerospace and Electronic Systems, 2001, 37(2): 643–654. doi: 10.1109/7.937475 [15] Sun Yi-jun, Liu Zhi-peng, Todorovic S, et al. Adaptive boosting for SAR automatic target recognition[J].IEEE Transactions on Aerospace and Electronic Systems, 2007, 43(1): 112–125. doi: 10.1109/TAES.2007.357120 [16] Keydel E R, Lee S W, and Moore J T. MSTAR extended operating conditions: A tutorial[C]. Proc. SPIE 2757, Algorithms for Synthetic Aperture Radar Imagery III, Orlando, FL, Apr. 1996: 228–242. [17] Krizhevsky A, Sutskever I, and Hinton G E. ImageNet classification with deep convolutional neural networks[C]. International Conference on Neural Information Processing Systems, South Lake Tahoe, Nevada, USA, Dec. 2012: 1097–1105. [18] Ding Jun, Chen Bo, Liu Hong-wei, et al. Convolutional neural network with data augmentation for SAR target recognition[J].IEEE Geoscience and Remote Sensing Letters, 2016, 13(3): 364–368. [19] Chen Si-zhe, Wang Hai-peng, Xu Feng, et al. Target classification using the deep convolutional networks for SAR images[J].IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(8): 4806–4817. doi: 10.1109/TGRS.2016.2551720 [20] Diao Wen-hui, Sun Xian, Zheng Xin-wei, et al. Efficient saliency-based object detection in remote sensing images using deep belief networks[J].IEEE Geoscience and Remote Sensing Letters, 2016, 13(2): 137–141. doi: 10.1109/LGRS.2015.2498644 [21] Chen Jie-hong, Zhang Bo, and Wang Chao. Backscattering feature analysis and recognition of civilian aircraft in TerraSAR-X images[J].IEEE Geoscience and Remote Sensing Letters, 2015, 12(4): 796–800. doi: 10.1109/LGRS.2014.2362845 [22] Srivastava N, Hinton G, Krizhevsky A, et al. Dropout: A simple way to prevent neural networks from overfitting[J].The Journal of Machine Learning Research, 2014, 15(1): 1929–1958. [23] Glorot X, Bordes A, and Bengio Y. Deep sparse rectifier neural networks[C]. 14th International Conference on Artificial Intelligence and Statistics, Fort Lauderdale, FL, USA, 2011: 315–323. [24] Qian Ning. On the momentum term in gradient descent learning algorithms[J].Neural Networks, 1999, 12(1): 145–151. doi: 10.1016/S0893-6080(98)00116-6 -

作者中心

作者中心 专家审稿

专家审稿 责编办公

责编办公 编辑办公

编辑办公

下载:

下载: