Probability Model-driven Airborne Bayesian Forward-looking Super-resolution Imaging for Multitarget Scenario

-

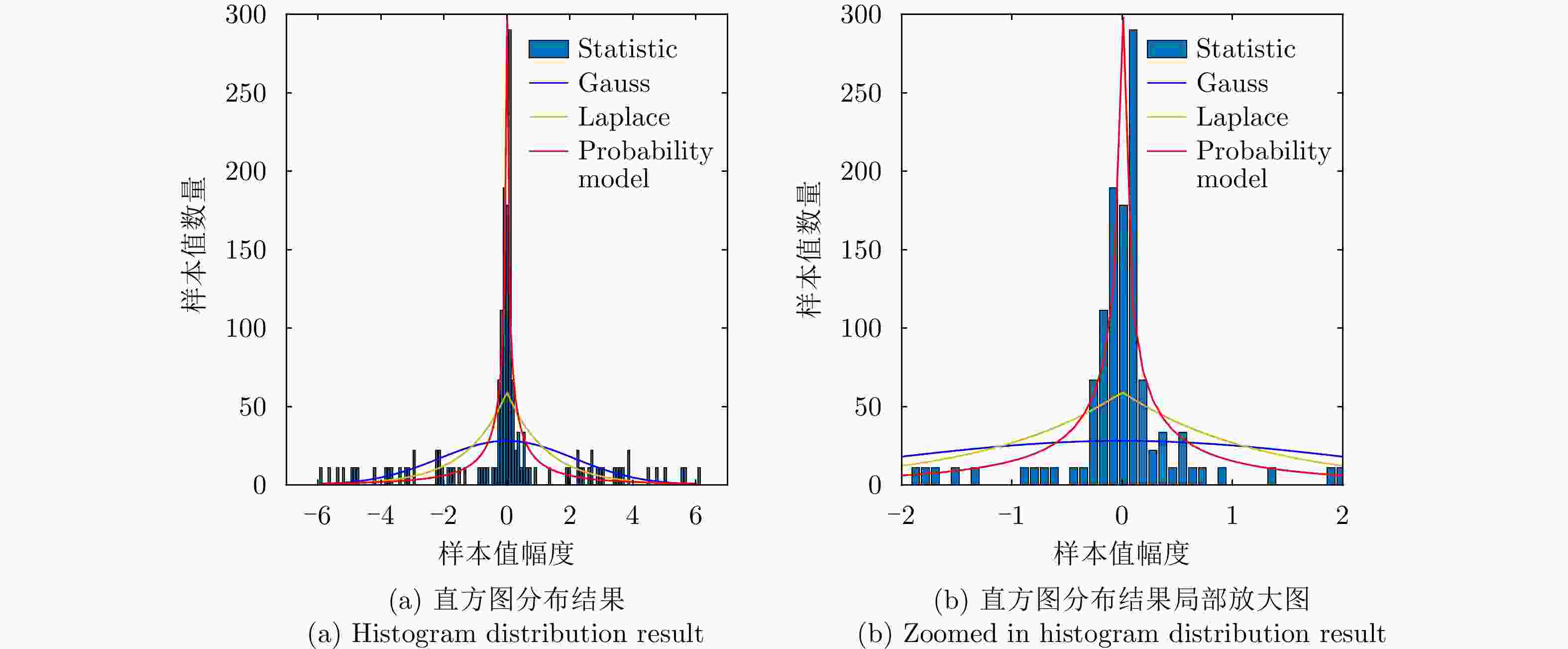

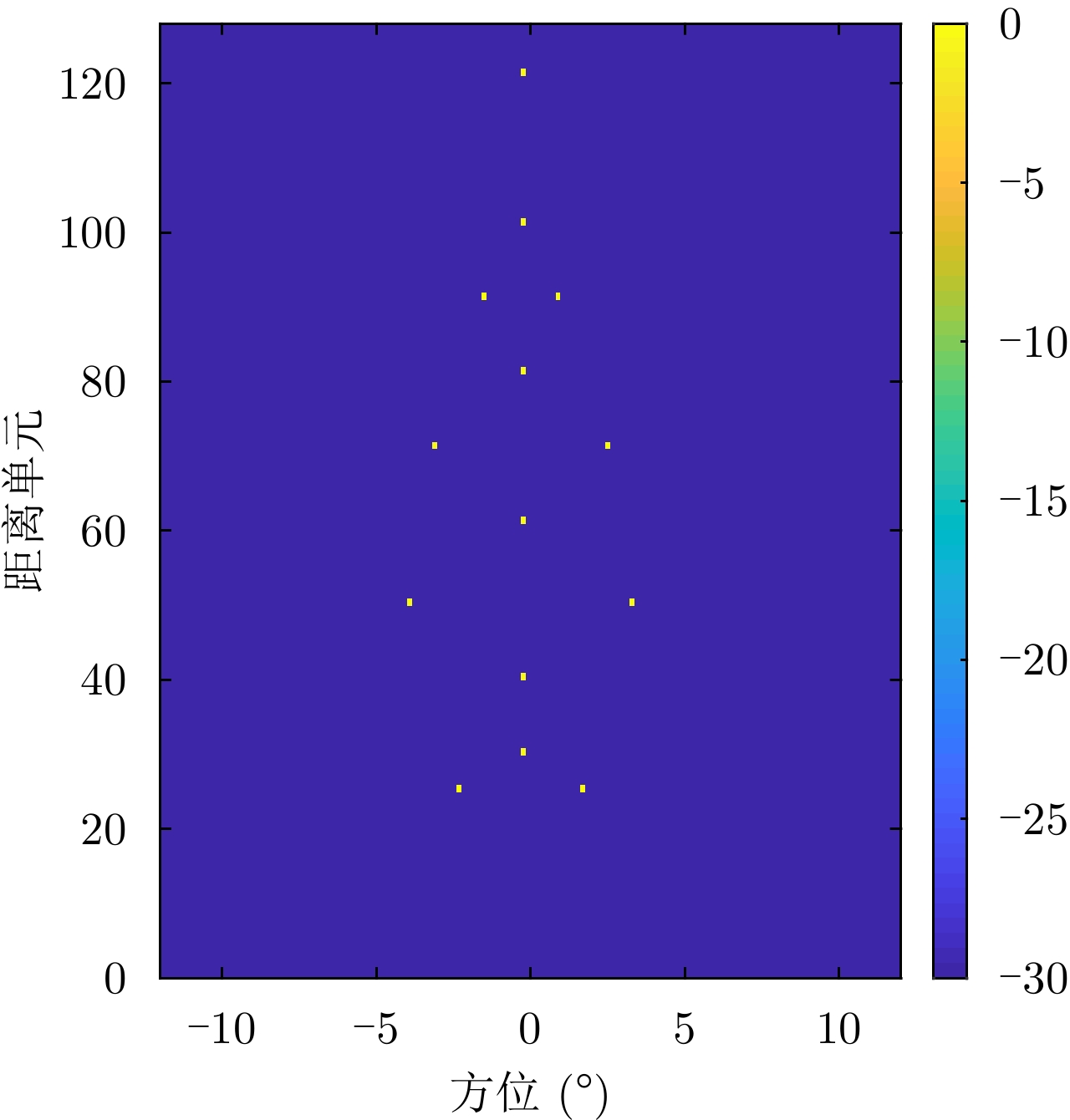

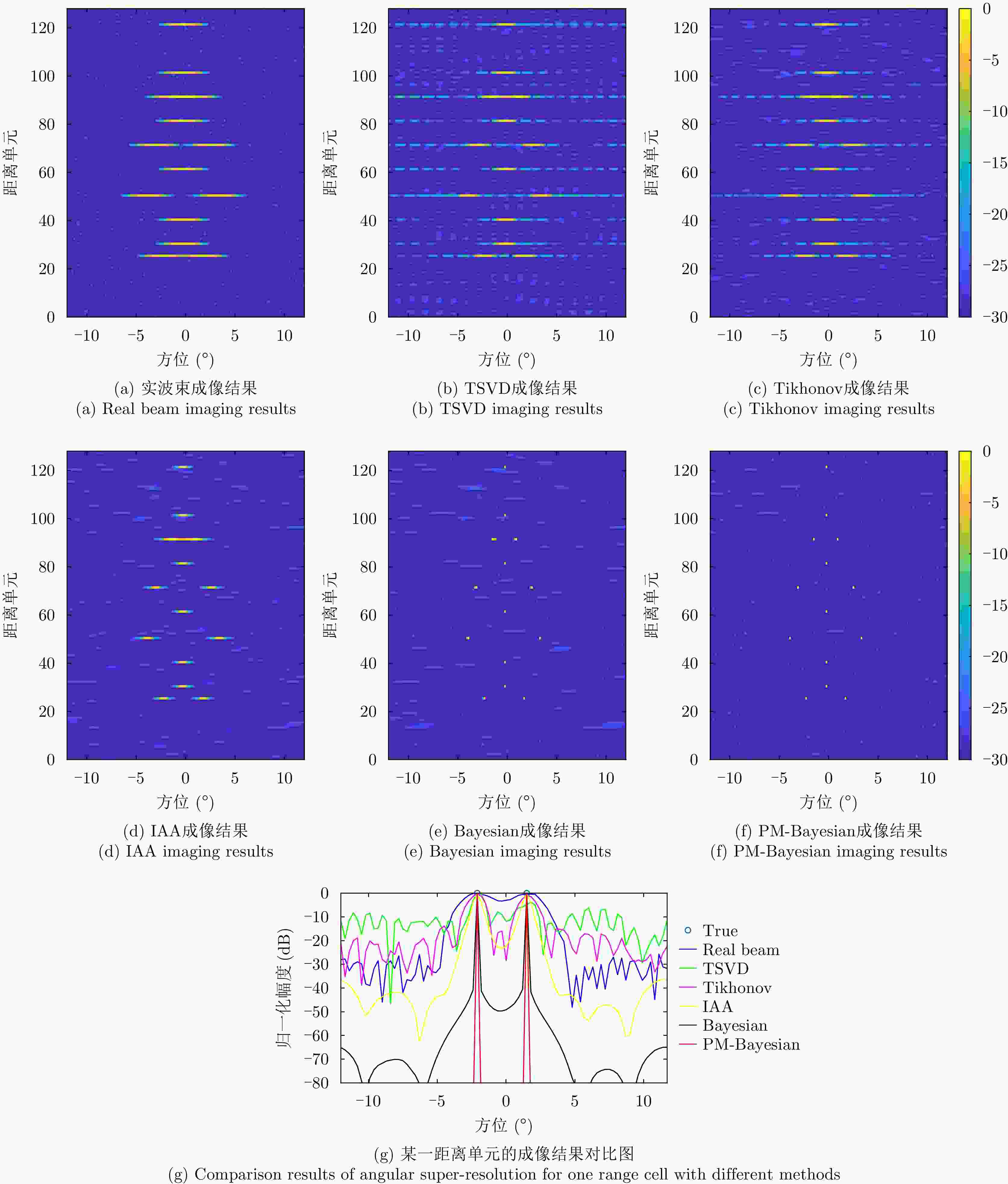

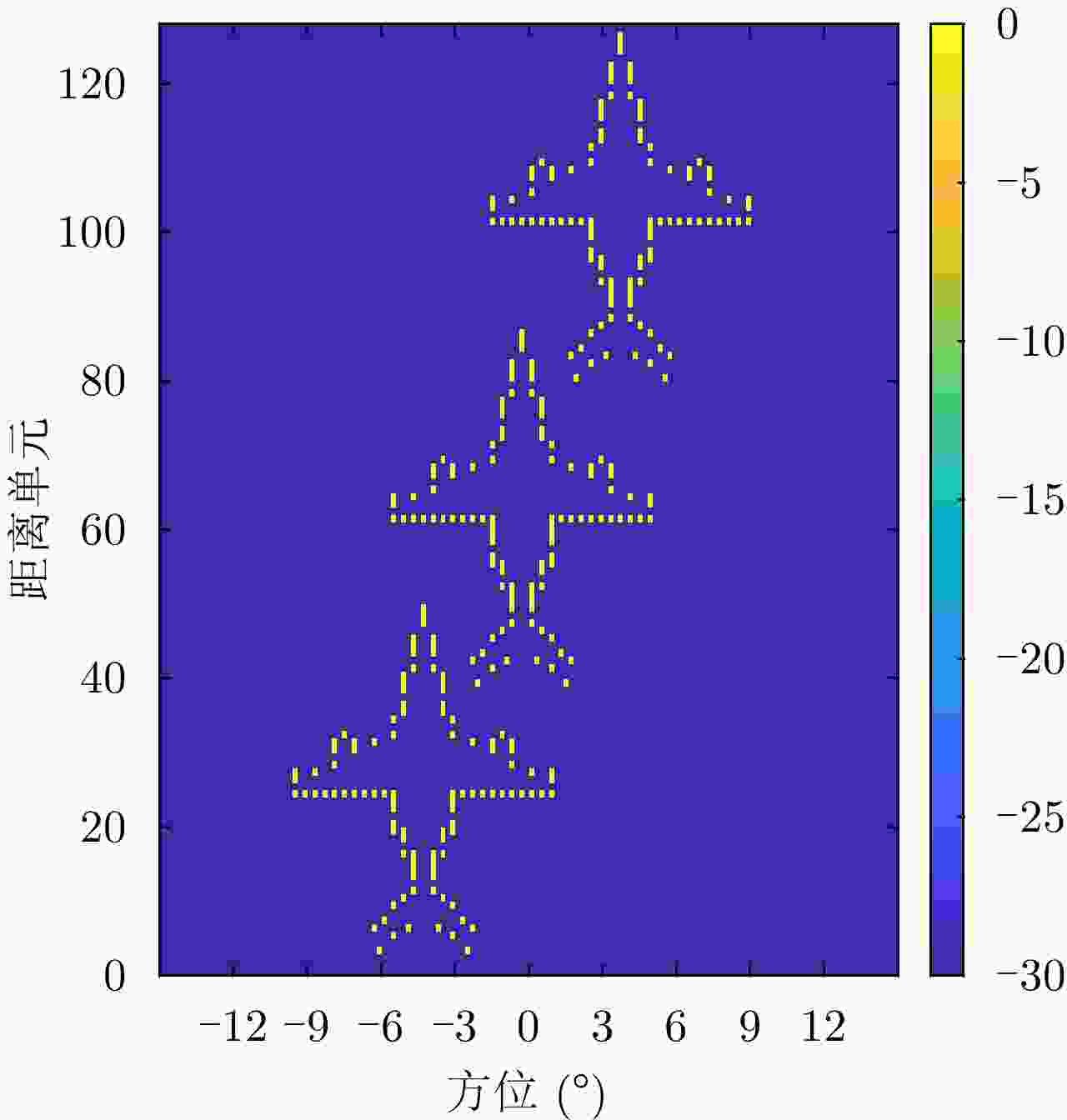

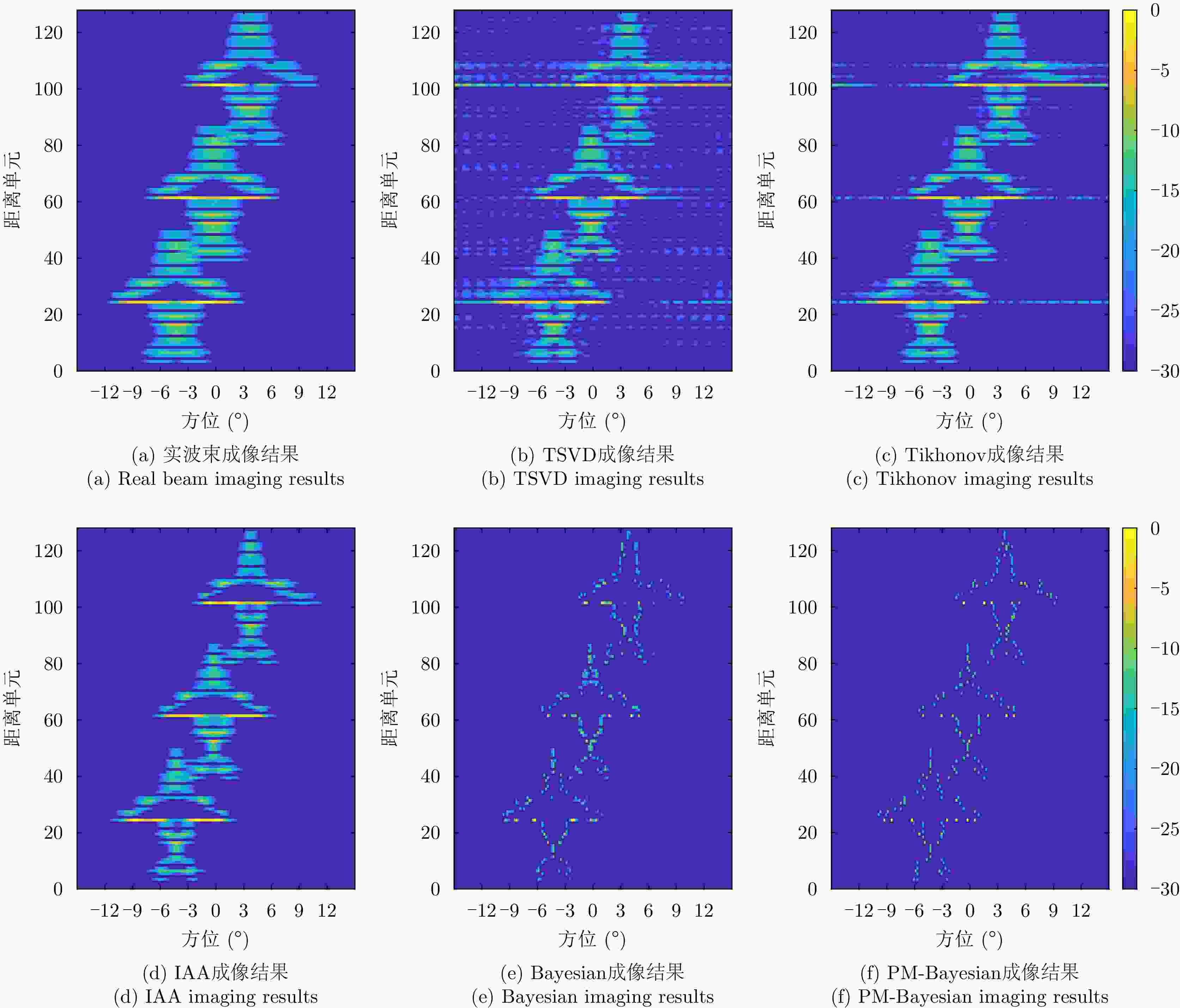

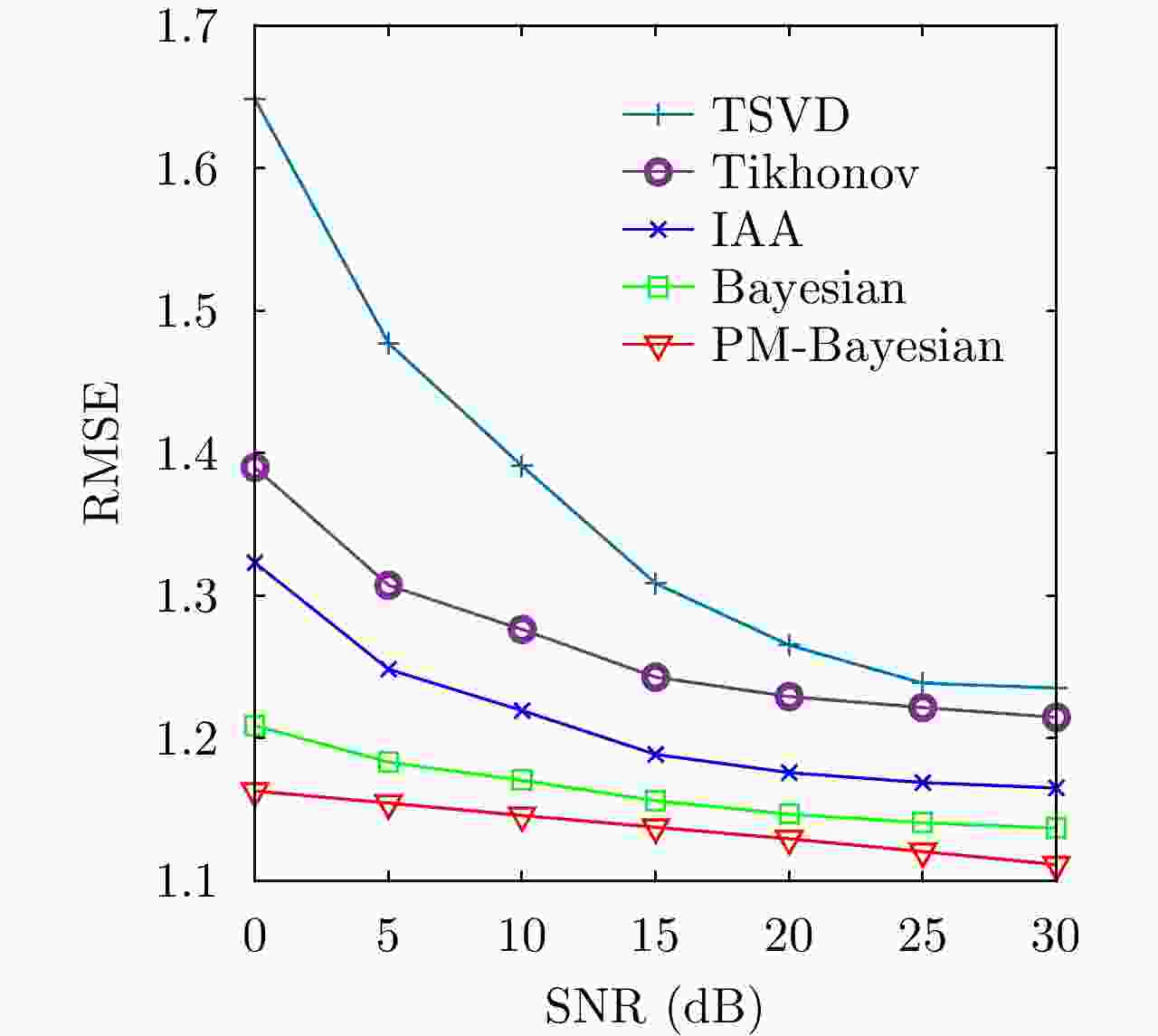

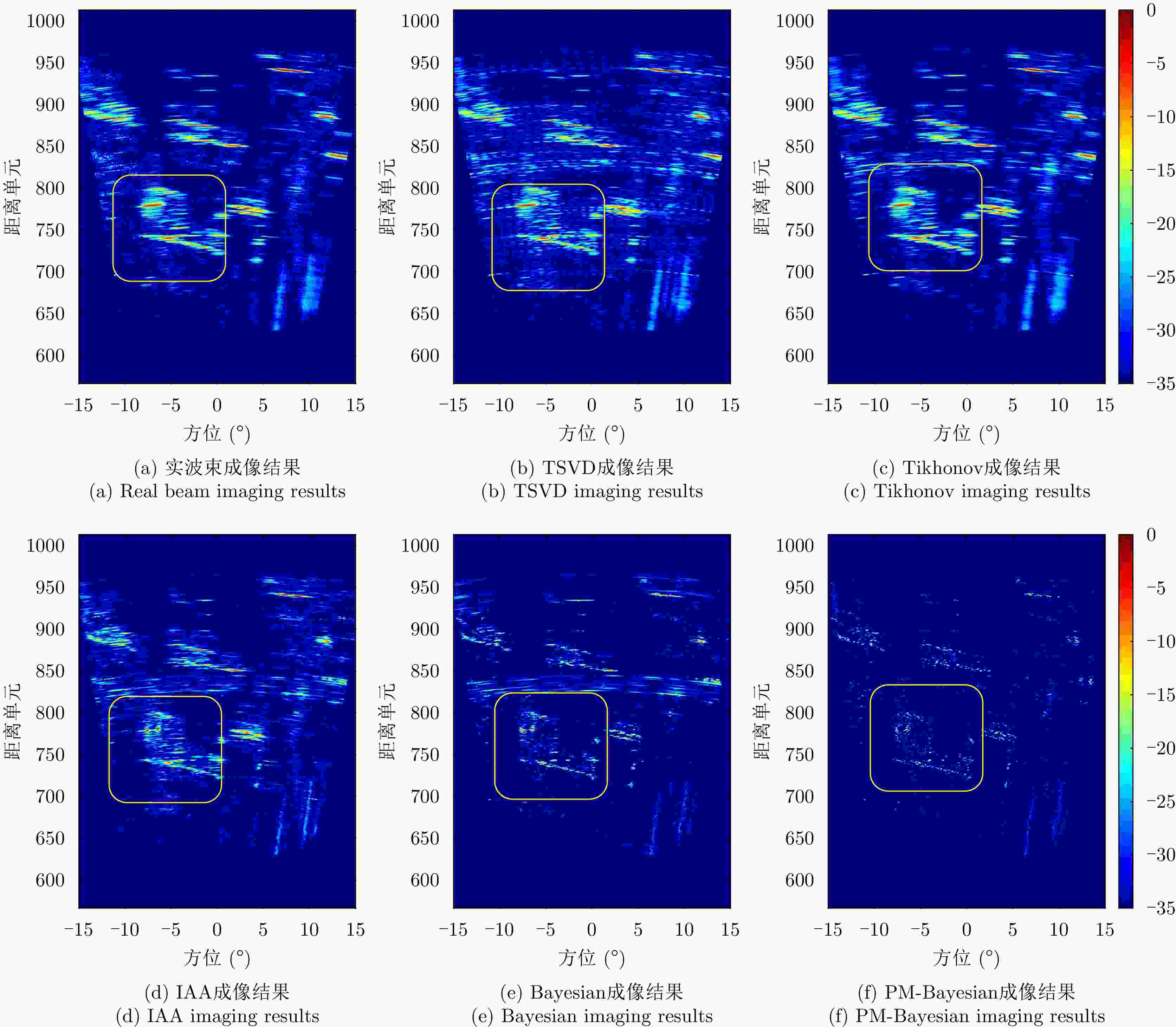

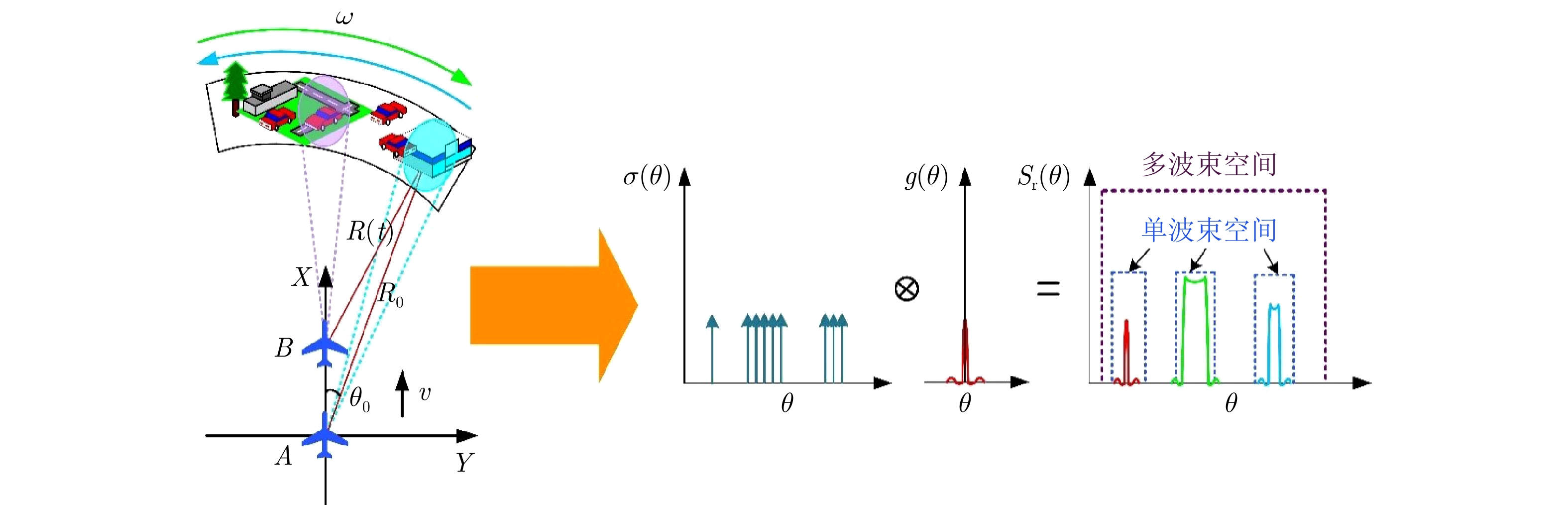

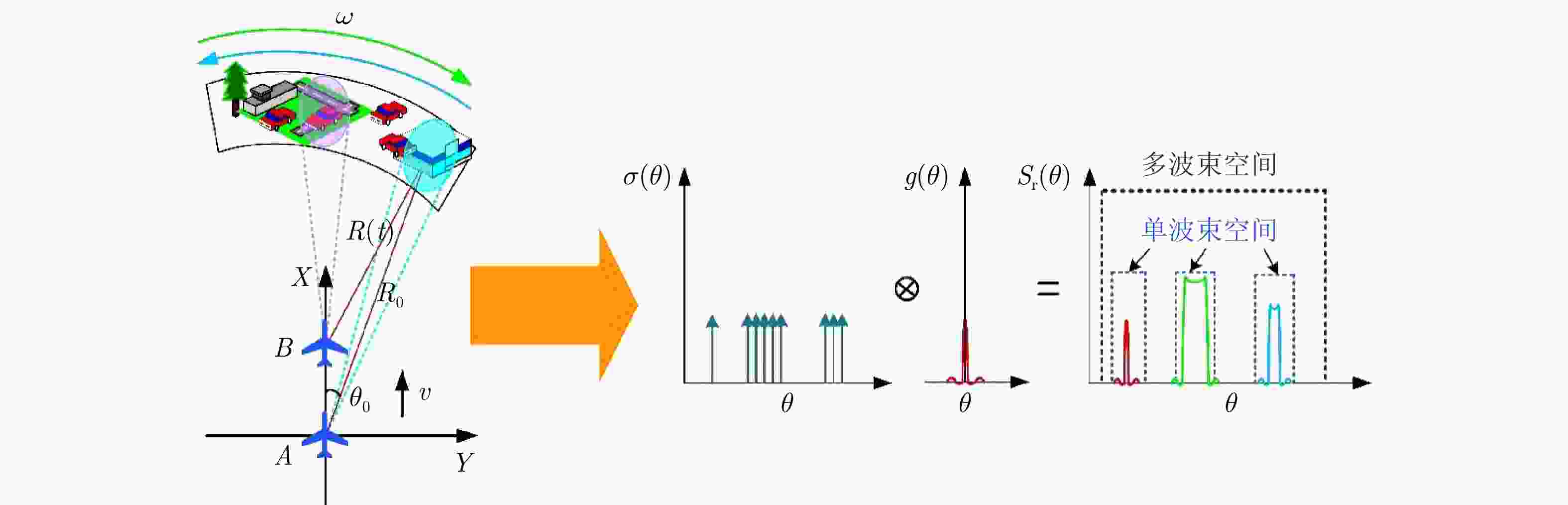

摘要: 雷达前视成像技术在精确制导打击、自主下降着陆、汽车自动驾驶等军民领域具有广阔的应用前景。由于多普勒相位历程的限制,机载平台的前视成像分辨率较低。解卷积方法可以进行前视成像,但当前视成像场景复杂时,现有的前视成像方法的成像质量会下降。针对复杂前视成像构型下的场景稀疏度度量和表征问题,该文提出一种基于概率模型驱动的机载贝叶斯前视超分辨多目标成像方法。首先通过将前视成像场景的数据维度由单帧空间扩展到多帧空间提升场景的稀疏度,然后基于广义高斯概率模型对成像场景的稀疏特性进行统计建模和稀疏度求解,最后基于贝叶斯框架完成稀疏前视成像。由于选取的稀疏度表征参数嵌入到前视成像的整个过程中,在每次迭代期间都会进行前视成像参数的更新,从而保证了前视成像算法的稳健性。通过计算机结果和实测数据处理,验证了该文方法的有效性。Abstract: Forward-looking imaging is crucial in many civil and military fields, such as precision guidance, autonomous landing, and autonomous driving. The forward-looking imaging performance of airborne radar may deteriorate significantly due to the constraint of the Doppler history. The deconvolution method can be used to improve the quality of forward-looking imaging; however, it will not work well for complex imaging scenes. To solve the problem of scene sparsity measurement and characterization in complex forward-looking imaging configurations, an efficient probability model-driven airborne Bayesian forward-looking super-resolution imaging algorithm is proposed for multitarget scenarios to improve the azimuth resolution. First, the data dimension of the forward-looking imaging scene was expanded from single-frame to multiframe spaces to enhance the sparsity of the imaging scene. Then, the sparse characteristics of the imaging scene were statistically modeled using the generalized Gaussian probability model. Finally, the super-resolution imaging problem was solved using the Bayesian framework. Because the sparsity characterization parameters are embedded in the entire process of imaging, the forward-looking imaging parameters will be updated during each iteration. The effectiveness of the proposed algorithm was verified using simulation and real data.

-

表 1 点目标仿真实验雷达参数

Table 1. Radar parameters for simulation experiment with point targets

参数 数值 参数 数值 平台速度(m/s) 300 时宽(μs) 10 平台高度(m) 1000 方位波束(°) 3 带宽(MHz) 512 扫描范围(°) –15~15 1 前视超分辨成像方法求解流程

1. Solution flow of the proposed algorithm

输入:天线方向图矩阵H,扩展的多普勒卷积矩阵${\boldsymbol{\varPhi}}$,观测数

据Y初始化:迭代次数$m = 1$,${\hat {\boldsymbol{X} }^1} = {\boldsymbol{Y}}$ 更新迭代过程: (1) 更新p:

$p = {F^{ { { - } }1} }\left( {\frac{ { { {\left( {\dfrac{1}{M}\displaystyle\sum\limits_{i = 1}^M {\left| { {X_i} } \right|} } \right)}^2} } }{ {\dfrac{1}{M}{ {\displaystyle\sum\limits_{i = 1}^M {\left( { {X_i} - \dfrac{1}{M}\displaystyle\sum\limits_{i = 1}^M {\left| { {X_i} } \right|} } \right)} }^2} } } } \right)$,

$F\left( x \right) = \dfrac{ { {\Gamma ^2}\left( { {2 \mathord{\left/ {\vphantom {2 p} } \right. } p} } \right)} }{ {\Gamma \left( { {1 \mathord{\left/ {\vphantom {1 p} } \right. } p} } \right)\Gamma \left( { {3 \mathord{\left/ {\vphantom {3 p} } \right. } p} } \right)} }$(2) 更新${\boldsymbol{J}}\left( { { {\hat {\boldsymbol{X}}}^n} } \right)$: ${\boldsymbol{J} }\left( { { {\hat {\boldsymbol{X} } }^n} } \right) = \arg {\text{min} }\left\{ {\left\| { {\boldsymbol{Y} }{ { - } }{\boldsymbol{H} } \odot {\boldsymbol{\varPhi} } { {\boldsymbol{X} }^n} } \right\|_2^2 + \mu { {\displaystyle\sum\limits_{i = 1}^L {\left( {\left| { {x^n} } \right|_i^2 + \varepsilon } \right)} }^{\textstyle\frac{p}{2} } } } \right\}$ (3) 更新$\nabla {\boldsymbol{J}}\left( { { {\hat {\boldsymbol{X}}}^n} } \right)$: $\nabla {\boldsymbol{J} }\left( { { {\hat {\boldsymbol{X} } }^n} } \right) = \left[ {2{ {\left( { {\boldsymbol{H} } \odot {\boldsymbol{\varPhi} } } \right)}^{\text{H} } }{\boldsymbol{H} } \odot {\boldsymbol{\varPhi}} + \mu {\boldsymbol{\varLambda } }\left( { { {\hat {\boldsymbol{X} } }^n} } \right)} \right]{\boldsymbol{X} } - 2{\left( { {\boldsymbol{H} } \odot {\boldsymbol{\varPhi} } } \right)^{\text{H} } }{\boldsymbol{Y} }$ (4) 更新${A^n}$: ${A^n}{\text{ = } }2{\left( {{\boldsymbol{H}} \odot {\boldsymbol{\varPhi}} } \right)^{\text{H} } }{\boldsymbol{H}} \odot {\boldsymbol{\varPhi}} + \mu {\boldsymbol{\varLambda } }$ (5) 更新${\hat {\boldsymbol{X}}^n}$: ${\hat {\boldsymbol{X} }^{n + 1} } = {\hat {\boldsymbol{X} }^n} - {\left[ {A\left( { { {\hat {\boldsymbol{X} } }^n} } \right)} \right]^{ { { - } }1} } \cdot \nabla {\boldsymbol{J}}\left( { { {\hat {\boldsymbol{X} } }^n} } \right)$ 输出:图像矩阵${\hat {\boldsymbol{X}}^{n + 1} }$ 表 2 面目标仿真实验雷达参数

Table 2. Radar parameters for simulation experiment with surface targets

参数 数值 参数 数值 平台速度(m/s) 300 时宽(μs) 10 平台高度(m) 1000 方位波束(°) 3 带宽(MHz) 300 扫描范围(°) –15~15 -

[1] SKOLNIK M I. Radar Handbook[M]. 3rd ed. New York, USA: McGraw-Hill, 2008: 23.1–23.36. [2] 保铮, 邢孟道, 王彤. 雷达成像技术[M]. 北京: 电子工业出版社, 2005, 2–18.BAO Zheng, XING Mengdao, and WANG Tong. Radar Imaging Technique[M]. Beijing, China: Publishing House of Electronics Industry, 2005, 2–18. [3] RICHARDS M A. Fundamentals of Radar Signal Processing[M]. New York, USA: McGraw-Hill, 2005, 385–401. [4] CUMMING I G and WONG F H. Digital Processing of Synthetic Aperture Radar Data: Algorithms and Implementation[M]. Boston, USA: Artech House, 2005, 3–17. [5] LONG Teng, LU Zheng, DING Zegang, et al. A DBS Doppler centroid estimation algorithm based on entropy minimization[J]. IEEE Transactions on Geoscience and Remote Sensing, 2011, 49(10): 3703–3712. doi: 10.1109/TGRS.2011.2142316 [6] 李亚超, 王家东, 张廷豪, 等. 弹载雷达成像技术发展现状与趋势[J]. 雷达学报, 2022, 11(6): 943–973. doi: 10.12000/JR22119LI Yachao, WANG Jiadong, ZHANG Tinghao, et al. Present situation and prospect of missile-borne radar imaging technology[J]. Journal of Radars, 2022, 11(6): 943–973. doi: 10.12000/JR22119 [7] CHEN Hongmeng, LI Ming, WANG Zeyu, et al. Cross-range resolution enhancement for DBS imaging in a scan mode using aperture-extrapolated sparse representation[J]. IEEE Geoscience and Remote Sensing Letters, 2017, 14(9): 1459–1463. doi: 10.1109/LGRS.2017.2710082 [8] MOREIRA A and HUANG Yonghong. Airborne SAR processing of highly squinted data using a chirp scaling approach with integrated motion compensation[J]. IEEE Transactions on Geoscience and Remote Sensing, 1994, 32(5): 1029–1040. doi: 10.1109/36.312891 [9] MOREIRA A, PRATS-IRAOLA P, YOUNISM, et al. A tutorial on synthetic aperture radar[J]. IEEE Geoscience and Remote Sensing Magazine, 2013, 1(1): 6–43. doi: 10.1109/MGRS.2013.2248301 [10] LI Zhenyu, XING Mengdao, LIANG Yi, et al. A frequency-domain imaging algorithm for highly squinted SAR mounted on maneuvering platforms with nonlinear trajectory[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(7): 4023–4038. doi: 10.1109/TGRS.2016.2535391 [11] RAN Lei, LIU Zheng, ZHANG Lei, et al. An autofocus algorithm for estimating residual trajectory deviations in synthetic aperture radar[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(6): 3408–3425. doi: 10.1109/TGRS.2017.2670785 [12] SUN Guangcai, LIU Yanbin, XIANG Jixiang, et al. Spaceborne synthetic aperture radar imaging algorithms: An overview[J]. IEEE Geoscience and Remote Sensing Magazine, 2022, 10(1): 161–184. doi: 10.1109/MGRS.2021.3097894 [13] LU Jingyue, ZHANG Lei, WEI Shaopeng, et al. Resolution enhancement for forwarding looking multi-channel SAR imagery with exploiting space-time sparsity[J]. IEEE Transactions on Geoscience and Remote Sensing, 2023, 61: 5200617. doi: 10.1109/TGRS.2022.3232392 [14] WU Junjie, LI Zhongyu, HUANG Yulin, et al. Focusing bistatic forward-looking SAR with stationary transmitter based on Keystone transform and nonlinear chirp scaling[J]. IEEE Geoscience and Remote Sensing Letters, 2014, 11(1): 148–152. doi: 10.1109/LGRS.2013.2250904 [15] ZENG Tao, WANG Rui, LI Feng, et al. A modified nonlinear chirp scaling algorithm for spaceborne/stationary bistatic SAR based on series reversion[J]. IEEE Transactions on Geoscience and Remote Sensing, 2013, 51(5): 3108–3118. doi: 10.1109/TGRS.2012.2219057 [16] MENG Ziqiang, LI Yachao, LI Chunbiao, et al. A raw data simulator for bistatic forward-looking high-speed maneuvering-platform SAR[J]. Signal Processing, 2015, 117: 151–164. doi: 10.1016/j.sigpro.2015.05.008 [17] PU Wei, WU Junjie, HUANG Yulin, et al. Fast factorized backprojection imaging algorithm integrated with motion trajectory estimation for bistatic forward-looking SAR[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2019, 12(10): 3949–3965. doi: 10.1109/JSTARS.2019.2945118 [18] 梅海文, 孟自强, 李亚超, 等. 双基前视SAR几何定位及同步误差分析[J]. 电子与信息学报, 2018, 40(4): 882–889. doi: 10.11999/JEIT170677MEI Haiwen, MENG Ziqiang, LI Yachao, et al. Bistatic forward-looking SAR geometrical positioning and analysis of synchronization error[J]. Journal of Electronics &Information Technology, 2018, 40(4): 882–889. doi: 10.11999/JEIT170677 [19] LI Yachao, ZHANG Tinghao, MEI Haiwen, et al. Focusing translational-variant bistatic forward-looking SAR data using the modified Omega-K algorithm[J]. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 5203916. doi: 10.1109/TGRS.2021.3063780 [20] LIU Zhutian, LI Zhongyu, YU Huaiqin, et al. Bistatic forward-looking SAR moving target detection method based on joint clutter cancellation in echo-image domain with three receiving channels[J]. Sensors, 2018, 18(11): 3835. doi: 10.3390/s18113835 [21] LI Yachao, XU Gaotian, ZHOU Song, et al. A novel CFFBP algorithm with noninterpolation image merging for bistatic forward-looking SAR focusing[J]. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 5225916. doi: 10.1109/TGRS.2022.3162230 [22] 吴迪, 杨成杰, 朱岱寅, 等. 一种用于单脉冲成像的自聚焦算法[J]. 电子学报, 2016, 44(8): 1962–1968. doi: 10.3969/j.issn.0372-2112.2016.08.027WU Di, YANG Chengjie, ZHU Daiyin, et al. An autofocusing algorithm for monopulse imaging[J]. Acta Electronica Sinica, 2016, 44(8): 1962–1968. doi: 10.3969/j.issn.0372-2112.2016.08.027 [23] CHEN Hongmeng, LU Yaobing, MU Heqiang, et al. Knowledge-aided mono-pulse forward-looking imaging for airborne radar by exploiting the antenna pattern information[J]. Electronics Letters, 2017, 53(8): 566–568. doi: 10.1049/el.2017.0324 [24] 李悦丽, 马萌恩, 赵崇辉, 等. 基于单脉冲雷达和差通道多普勒估计的前视成像[J]. 雷达学报, 2021, 10(1): 131–142. doi: 10.12000/JR20111LI Yueli, MA Meng’en, ZHAO Chonghui, et al. Forward-looking imaging via Doppler estimates of sum-difference measurements in scanning monopulse radar[J]. Journal of Radars, 2021, 10(1): 131–142. doi: 10.12000/JR20111 [25] 杨志伟, 贺顺, 廖桂生. 机载单通道雷达实波束扫描的前视探测[J]. 航空学报, 2012, 33(12): 2240–2245.YANG Zhiwei, HE Shun, and LIAO Guisheng. Forward-looking detection for airborne single-channel radar with beam scanning[J]. Acta Aeronauticaet AstronauticaSinica, 2012, 33(12): 2240–2245. [26] 王军, 赵宜楠, 乔晓林. 基于压缩感知的雷达前视向稀疏目标分辨[J]. 电子与信息学报, 2014, 36(8): 1978–1984. doi: 10.3724/SP.J.1146.2013.01936WANG Jun, ZHAO Yin’an, and QIAO Xiaolin. A sparse target-scenario determination strategy based on compressive sensing for active radar in the line of sight[J]. Journal of Electronics &Information Technology, 2014, 36(8): 1978–1984. doi: 10.3724/SP.J.1146.2013.01936 [27] 温晓杨, 匡纲要, 胡杰民, 等. 基于实波束扫描的相控阵雷达前视成像[J]. 航空学报, 2014, 35(7): 1977–1991. doi: 10.7527/S1000-6893.2013.0545WEN Xiaoyang, KUANG Gangyao, HU Jiemin, et al. Forward-looking imaging based on real beam scanning phased array radars[J]. Acta Aeronauticaet AstronauticaSinica, 2014, 35(7): 1977–1991. doi: 10.7527/S1000-6893.2013.0545 [28] RICHARDS M A. Iterative noncoherent angular superresolution (radar)[C]. 1988 IEEE National Radar Conference, Ann Arbor, USA, 1988: 100–105. [29] 李悦丽, 梁甸农, 黄晓涛. 一种单脉冲雷达多通道解卷积前视成像方法[J]. 信号处理, 2007, 23(5): 699–703. doi: 10.3969/j.issn.1003-0530.2007.05.013LI Yueli, LIANG Diannong, and HUANG Xiaotao. A multi-channel deconvolution based on forword-looking imaging method in monopulse radar[J]. Signal Processing, 2007, 23(5): 699–703. doi: 10.3969/j.issn.1003-0530.2007.05.013 [30] 陈洪猛, 李明, 王泽玉, 等. 基于多帧数据联合处理的机载单通道雷达贝叶斯前视成像[J]. 电子与信息学报, 2015, 37(10): 2328–2334. doi: 10.11999/JEIT150153CHEN Hongmeng, LI Ming, WANG Zeyu, et al. Bayesian forward-looking imaging for airborne single-channel radar based on combined multiple frames data[J]. Journal of Electronics &Information Technology, 2015, 37(10): 2328–2334. doi: 10.11999/JEIT150153 [31] GAMBARDELLA A and MIGLIACCIO M. On the superresolution of microwave scanning radiometer measurements[J]. IEEE Geoscience and Remote Sensing Letters, 2008, 5(4): 796–800. doi: 10.1109/LGRS.2008.2006285 [32] CHEN Hongmeng, LI Ming, WANG Zeyu, et al. Sparse super-resolution imaging for airborne single channel forward-looking radar in expanded beam space via l p regularisation[J]. Electronics Letters, 2015, 51(11): 863–865. doi: 10.1049/el.2014.3978 [33] ZHANG Yongchao, JAKOBSSON A, ZHANG Yin, et al. Wideband sparse reconstruction for scanning radar[J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(10): 6055–6068. doi: 10.1109/TGRS.2018.2830100 [34] LI Yueli, LIU Jianguo, JIANG Xiaoqing, et al. Angular superresol for signal model in coherent scanning radars[J]. IEEE Transactions on Aerospace and Electronic Systems, 2019, 55(6): 3103–3116. doi: 10.1109/TAES.2019.2900133 [35] HUANG Yulin, ZHA Yuebo, WANG Yue, et al. Forward looking radar imaging by truncated singular value decomposition and its application for adverse weather aircraft landing[J]. Sensors, 2015, 15(6): 14397–14414. doi: 10.3390/s150614397 [36] TUO Xingyu, ZHANG Yin, HUANG Yulin, et al. Fast sparse-TSVD super-resolution method of real aperture radar forward-looking imaging[J]. IEEE Transactions on Geoscience and Remote Sensing, 2021, 59(8): 6609–6620. doi: 10.1109/TGRS.2020.3027053 [37] ZHANG Yongchao, ZHANG Yin, LI Wenchao, et al. Super-resolution surfacemapping for scanning radar: Inverse filtering based on the fast iterativeadaptive approach[J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(1): 127–144. doi: 10.1109/TGRS.2017.2743263 [38] ÇETIN M and KARL W C. Feature-enhanced synthetic aperture radar image formation based on nonquadratic regularization[J]. IEEE Transactions on Image Processing, 2001, 10(4): 623–631. doi: 10.1109/83.913596 [39] ZHANG Yin, TUO Xingyu, HUANG Yulin, et al. A TV forward-looking super-resolution imaging method based on TSVD strategy for scanning radar[J]. IEEE Transactions on Geoscience and Remote Sensing, 2020, 58(7): 4517–4528. doi: 10.1109/TGRS.2019.2958085 [40] ZHANG Qiping, ZHANG Yin, HUANG Yulin, et al. TV-sparse super-resolution method for radar forward-looking imaging[J]. IEEE Transactions on Geoscience and Remote Sensing, 2020, 58(9): 6534–6549. doi: 10.1109/TGRS.2020.2977719 [41] YANG Jianyu, KANG Yao, ZHANG Yin, et al. A Bayesian angular superresolution method with lognormal constraint for sea-surface target[J]. IEEE Access, 2020, 8: 13419–13428. doi: 10.1109/ACCESS.2020.2965973 [42] ZHANG Yin, ZHANG Qiping, LI Changlin, et al. Sea-Surface target angular superresolution in forward-looking radar imaging based on maximum a posteriori algorithm[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2019, 12(8): 2822–2834. doi: 10.1109/JSTARS.2019.2918189 [43] ZHANG Qiping, ZHANG Yin, HUANG Yulin, et al. Azimuth superresolutionof forward-looking radar imaging which relies on linearized Bregman[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2019, 12(7): 2032–2043. doi: 10.1109/JSTARS.2019.2912993 [44] CHEN Hongmeng, LI Yachao, GAO Wenquan, et al. Bayesian forward-looking superresolution imaging using Doppler deconvolution in expanded beam space for high-speed platform[J]. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 5105113. doi: 10.1109/TGRS.2021.3107717 [45] LI Weixin, LI Ming, ZUO Lei, et al. Real aperture radar forward-looking imaging based on variational Bayesian in presence of outliers[J]. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 5117113. doi: 10.1109/TGRS.2022.3203807 [46] ZHANG Yin, SHEN Jiahao, TUO Xingyu, et al. Scanning radar forward-looking superresolution imaging based on the Weibull distribution for a sea-surface target[J]. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 5116111. doi: 10.1109/TGRS.2022.3194118 [47] LI Weixin, LI Ming, ZUO Lei, et al. A computationally efficient airborne forward-looking super-resolution imaging method based on sparse Bayesian learning[J]. IEEE Transactions on Geoscience and Remote Sensing, 2023, 61: 5102613. doi: 10.1109/TGRS.2023.3260094 [48] XU Gang, XING Mengdao, XIA Xianggen, et al. Sparse regularization of interferometric phase and amplitude for InSAR image formation based on Bayesian representation[J]. IEEE Transactions on Geoscience and Remote Sensing, 2015, 53(4): 2123–2136. doi: 10.1109/TGRS.2014.2355592 -

作者中心

作者中心 专家审稿

专家审稿 责编办公

责编办公 编辑办公

编辑办公

下载:

下载: