Convolutional Neural Network Based on Feature Decomposition for Target Detection in SAR Images

-

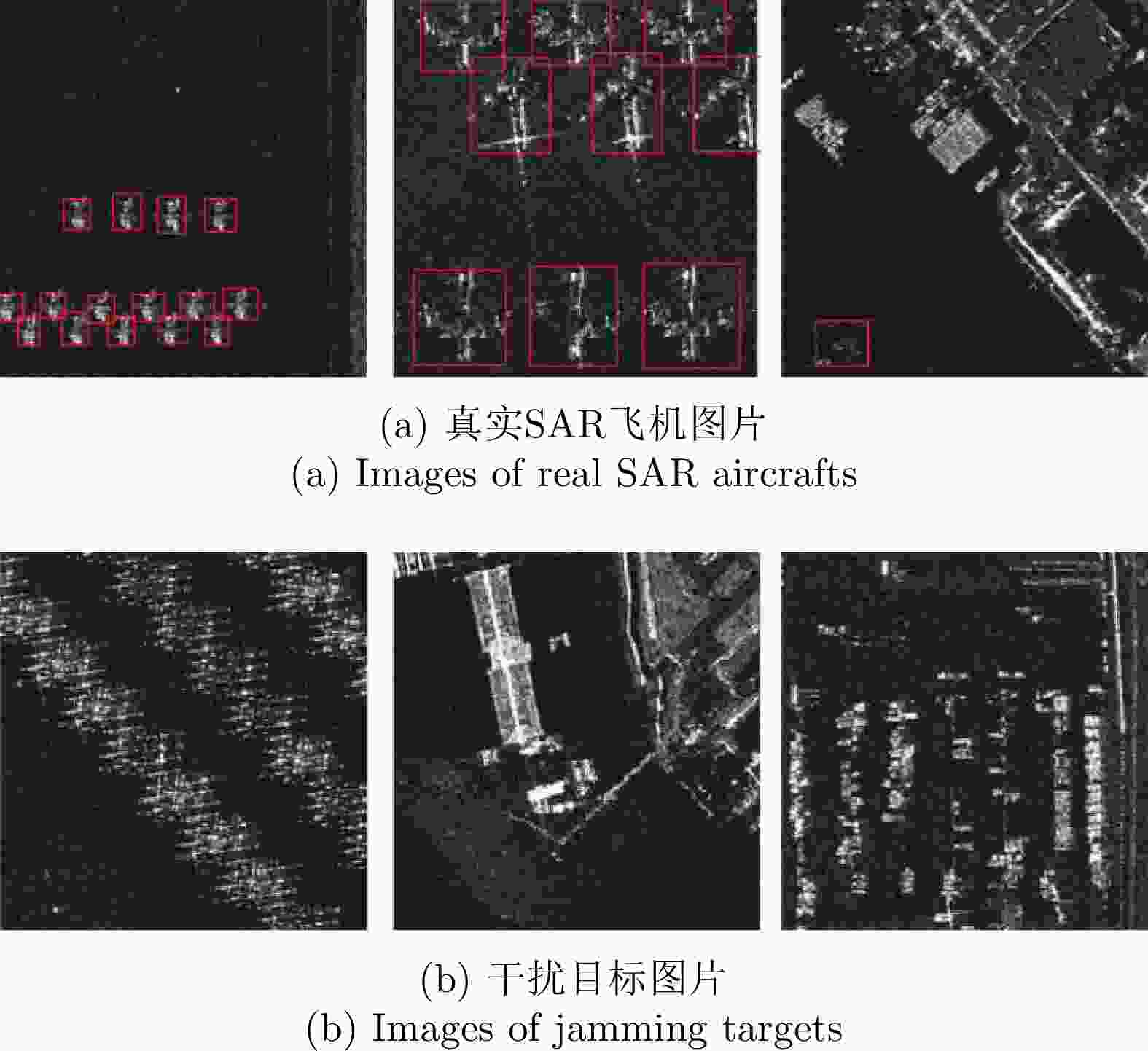

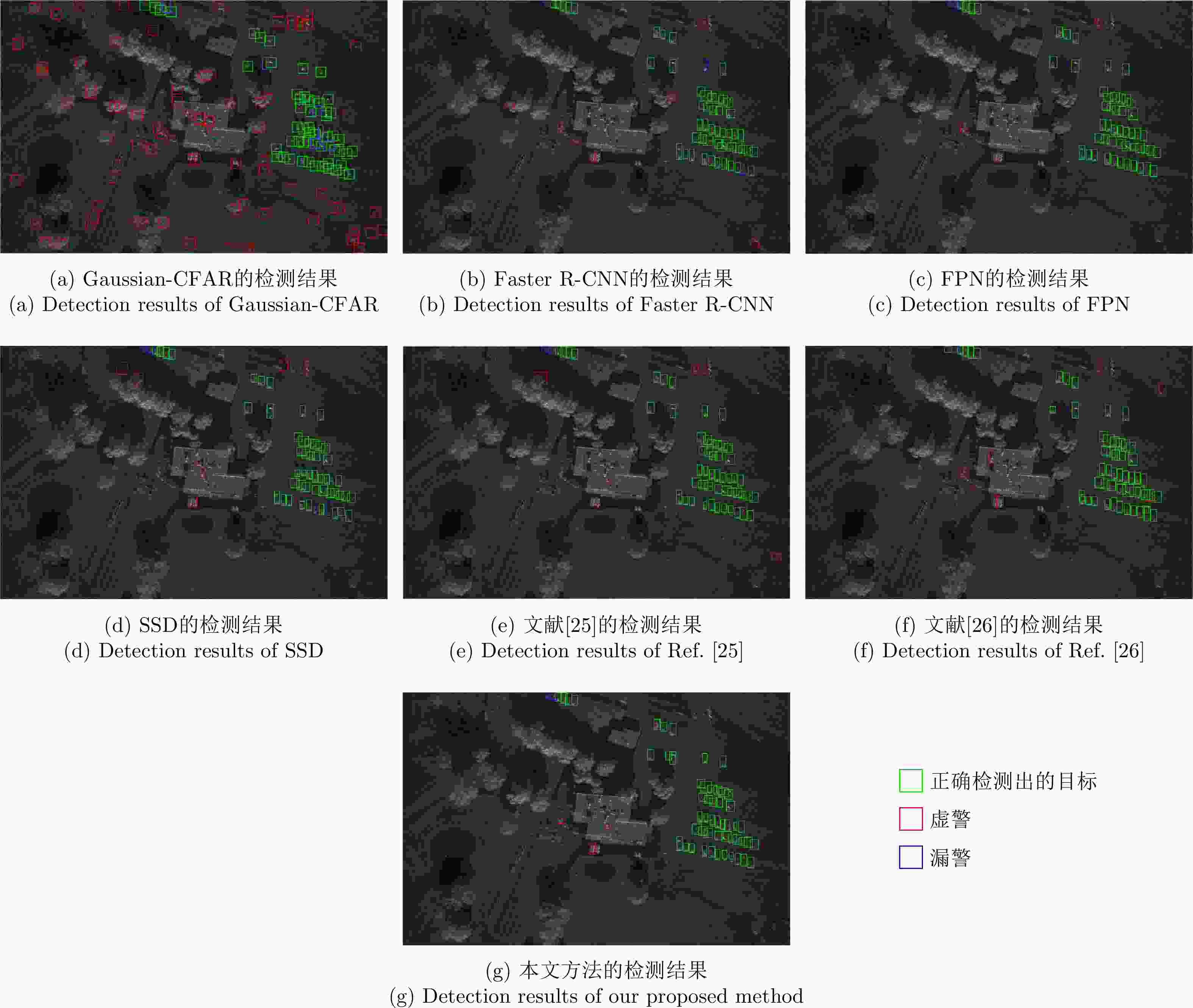

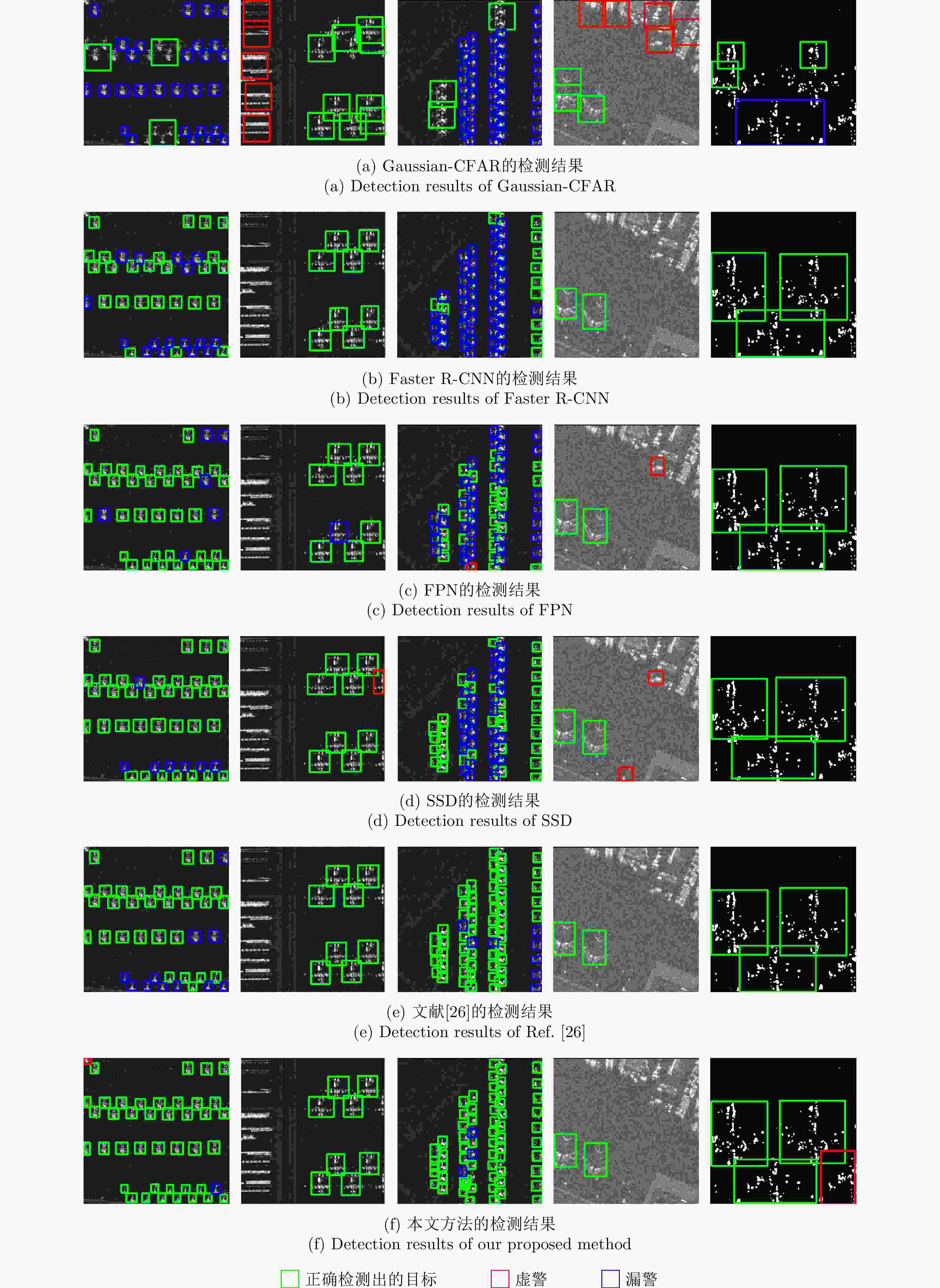

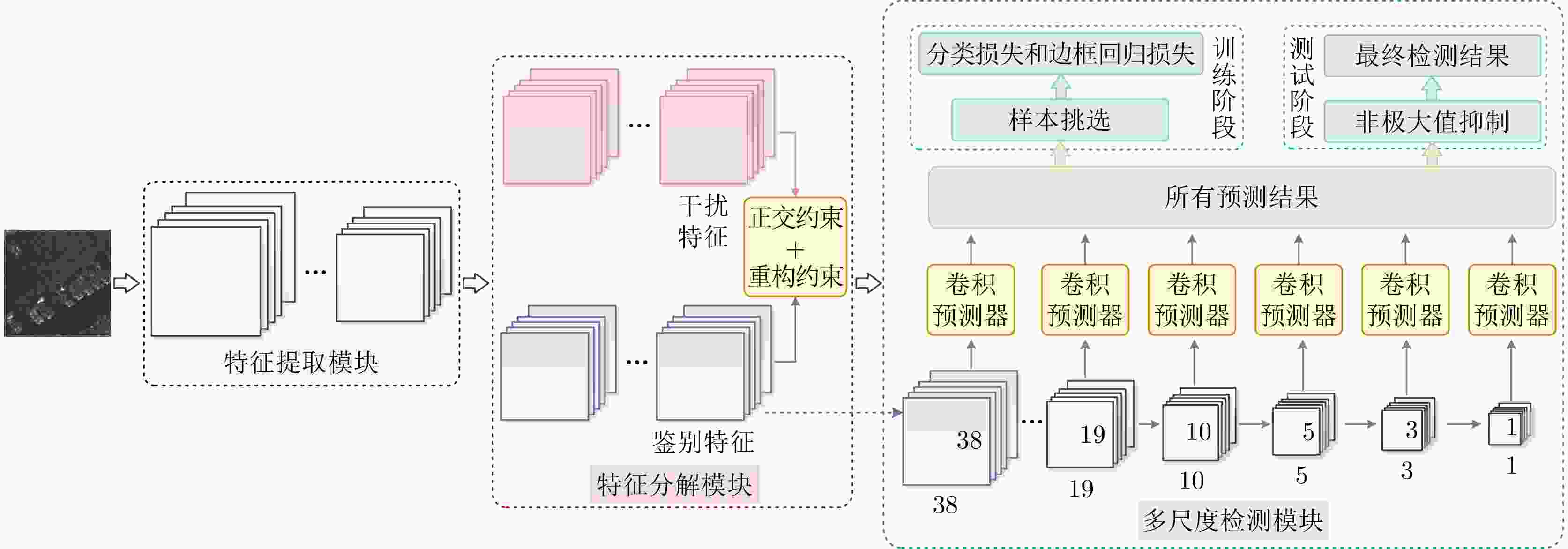

摘要: 真实场景的高分辨率合成孔径雷达(SAR)图像大多是复杂的,对于地物场景来说,其背景中存在草地、树木、道路和建筑物等杂波,这些复杂背景杂波使得传统SAR图像目标检测算法的结果包含大量虚警和漏警,严重影响了SAR目标检测性能。该文提出一种基于特征分解卷积神经网络(CNN)的SAR图像目标检测方法,该方法在特征提取模块对输入图像提取特征后,通过特征分解模块分解出鉴别特征和干扰特征,最后将鉴别特征输入到多尺度检测模块进行目标检测。特征分解后去除的干扰特征是对目标检测不利的部分,其中包括复杂背景杂波,而保留的鉴别特征是对目标检测有利的部分,其中包括感兴趣目标,从而有效降低虚警和漏警,提高SAR目标检测性能。该文所提方法在MiniSAR实测数据集和SAR飞机检测实测数据集(SADD)上的F1-score值分别为0.9357和0.9211,与不加特征分解模块的单步多框检测器相比,所提方法的F1-score值分别提升了0.0613和0.0639。基于实测数据集的实验结果证明了所提方法对复杂场景SAR图像进行目标检测的有效性。Abstract: Most high-resolution Synthetic Aperture Radar (SAR) images of real-life scenes are complex due to clutter, such as grass, trees, roads, and buildings, in the background. Traditional target detection algorithms for SAR images contain numerous false and missed alarms due to such clutter, adversely affecting the performance of SAR images target detection. Herein we propose a feature decomposition-based Convolutional Neural Network (CNN) for target detection in SAR images. The feature extraction module first extracts features from the input images, and these features are then decomposed into discriminative and interfering features using the feature decomposition module. Furthermore, only the discriminative features are input into the multiscale detection module for target detection. The interfering features that are removed after feature decomposition are the parts that are unfavorable to target detection, such as complex background clutter, whereas the discriminative features that are retained are the parts that are favorable to target detection, such as the targets of interest. Hence, an effective reduction in the number of false and missed alarms, as well as an improvement in the performance of SAR target detection, is achieved. The F1-score values of the proposed method are 0.9357 and 0.9211 for the MiniSAR dataset and SAR Aircraft Detection Dataset (SADD), respectively. Compared to the single shot multibox detector without the feature extraction module, the F1-score values of the proposed method for the MiniSAR and SADD datasets show an improvement of 0.0613 and 0.0639, respectively. Therefore, the effectiveness of the proposed method for target detection in SAR images of complex scenes was demonstrated through experimental results based on the measured datasets.

-

表 1 特征提取模块的详细结构

Table 1. Detailed structure of feature extraction module

层数 操作 超参数 1 卷积,ReLU k = (3,3), s = 1, p = 1, n = 64 2 卷积,ReLU k = (3,3), s = 1, p = 1, n = 64 3 最大池化 k = (2,2), s = 2, p = 0 4 卷积,ReLU k = (3,3), s = 1, p = 1, n = 128 5 卷积,ReLU k = (3,3), s = 1, p = 1, n = 128 6 最大池化 k = (2,2), s = 2, p = 0 7 卷积,ReLU k = (3,3), s = 1, p = 1, n = 256 8 卷积,ReLU k = (3,3), s = 1, p = 1, n = 256 9 卷积,ReLU k = (3,3), s = 1, p = 1, n = 256 10 最大池化 k = (2,2), s = 2, p = 0 注:k, s, p, n分别为核尺寸、步长、填充数、核个数。 表 2 不同目标检测方法在MiniSAR数据集上的实验结果

Table 2. Experimental results of different target detection methods based on the MiniSAR dataset

表 3 不同目标检测方法在SADD数据集上的实验结果

Table 3. Experimental results of different target detection methods based on the SADD

方法 Precision Recall F1-score Gaussian-CFAR 0.4610 0.5272 0.4919 Faster R-CNN 0.9036 0.8086 0.8535 FPN 0.8550 0.8703 0.8626 SSD 0.8464 0.8682 0.8572 文献[26]的方法 0.9014 0.8797 0.8904 本文方法 0.8788 0.9676 0.9211 表 4 消融实验结果

Table 4. Experimental results of ablation experiments

实验编号 损失 定量评价 正交损失 重构损失 Precision Recall F1-score 1 × × 0.8629 0.8862 0.8744 2 √ × 0.9091 0.9268 0.9179 3 × √ 0.8926 0.9024 0.8975 4 √ √ 0.9206 0.9512 0.9357 -

[1] NOVAK L M, BURL M C, and IRVING W W. Optimal polarimetric processing for enhanced target detection[J]. IEEE Transactions on Aerospace and Electronic Systems, 1993, 29(1): 234–244. doi: 10.1109/7.249129 [2] XING Xiangwei, CHEN Zhenlin, ZOU Huanxin, et al. A fast algorithm based on two-stage CFAR for detecting ships in SAR images[C]. The 2nd Asian-Pacific Conference on Synthetic Aperture Radar, Xi’an, China, 2009: 506–509. [3] LENG Xiangguang, JI Kefeng, YANG Kai, et al. A bilateral CFAR algorithm for ship detection in SAR images[J]. IEEE Geoscience and Remote Sensing Letters, 2015, 12(7): 1536–1540. doi: 10.1109/LGRS.2015.2412174 [4] LECUN Y, BOTTOU L, BENGIO Y, et al. Gradient-based learning applied to document recognition[J]. Proceedings of the IEEE, 1998, 86(11): 2278–2324. doi: 10.1109/5.726791 [5] HINTON G E and SALAKHUTDINOV R R. Reducing the dimensionality of data with neural networks[J]. Science, 2006, 313(5786): 504–507. doi: 10.1126/science.1127647 [6] KRIZHEVSKY A, SUTSKEVER I, and HINTON G E. ImageNet classification with deep convolutional neural networks[C]. The 25th International Conference on Neural Information Processing Systems, Lake Tahoe, USA, 2012: 1097–1105. [7] SIMONYAN K and ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[C]. 3rd International Conference on Learning Representations, San Diego, USA, 2015. [8] SZEGEDY C, LIU Wei, JIA Yangqing, et al. Going deeper with convolutions[C]. 2015 IEEE Conference on Computer Vision and Pattern Recognition, Boston, USA, 2015: 1–9. [9] HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition[C]. 2016 IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, USA, 2016: 770–778. [10] GIRSHICK R. Fast R-CNN[C]. 2015 IEEE International Conference on Computer Vision, Santiago, Chile, 2015: 1440–1448. [11] REN Shaoqing, HE Kaiming, GIRSHICK R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[C]. The 28th International Conference on Neural Information Processing Systems, Montréal, Canada, 2015: 91–99. [12] LIU Wei, ANGUELOV D, ERHAN D, et al. SSD: Single shot multibox detector[C]. 14th European Conference on Computer Vision, Amsterdam, The Netherlands, 2016: 21–37. [13] NEUBECK A and VAN GOOL L. Efficient non-maximum suppression[C]. The 18th International Conference on Pattern Recognition, Hong Kong, China, 2006: 850–855. [14] 王思雨, 高鑫, 孙皓, 等. 基于卷积神经网络的高分辨率SAR图像飞机目标检测方法[J]. 雷达学报, 2017, 6(2): 195–203. doi: 10.12000/JR17009WANG Siyu, GAO Xin, SUN Hao, et al. An aircraft detection method based on convolutional neural networks in high-resolution SAR images[J]. Journal of Radars, 2017, 6(2): 195–203. doi: 10.12000/JR17009 [15] WANG Zhaocheng, DU Lan, MAO Jiashun, et al. SAR target detection based on SSD with data augmentation and transfer learning[J]. IEEE Geoscience and Remote Sensing Letters, 2019, 16(1): 150–154. doi: 10.1109/LGRS.2018.2867242 [16] 李健伟, 曲长文, 彭书娟, 等. 基于卷积神经网络的SAR图像舰船目标检测[J]. 系统工程与电子技术, 2018, 40(9): 1953–1959. doi: 10.3969/j.issn.1001-506X.2018.09.09LI Jianwei, QU Changwen, PENG Shujuan, et al. Ship detection in SAR images based on convolutional neural network[J]. Systems Engineering and Electronics, 2018, 40(9): 1953–1959. doi: 10.3969/j.issn.1001-506X.2018.09.09 [17] ZHANG Shaoming, WU Ruize, XU Kunyuan, et al. R-CNN-based ship detection from high resolution remote sensing imagery[J]. Remote Sensing, 2019, 11(6): 631. doi: 10.3390/rs11060631 [18] 陈慧元, 刘泽宇, 郭炜炜, 等. 基于级联卷积神经网络的大场景遥感图像舰船目标快速检测方法[J]. 雷达学报, 2019, 8(3): 413–424. doi: 10.12000/JR19041CHEN Huiyuan, LIU Zeyu, GUO Weiwei, et al. Fast detection of ship targets for large-scale remote sensing image based on a cascade convolutional neural network[J]. Journal of Radars, 2019, 8(3): 413–424. doi: 10.12000/JR19041 [19] WEI Di, DU Yuang, DU Lan, et al. Target detection network for SAR images based on semi-supervised learning and attention mechanism[J]. Remote Sensing, 2021, 13(14): 2686. doi: 10.3390/RS13142686 [20] GLOROT X, BORDES A, and BENGIO Y. Deep sparse rectifier neural networks[C]. The 14th International Conference on Artificial Intelligence and Statistics, Fort Lauderdale, USA, 2011: 315–323. [21] LONG J, SHELHAMER E, and DARRELL T. Fully convolutional networks for semantic segmentation[C]. 2015 IEEE Conference on Computer Vision and Pattern Recognition, Boston, USA, 2015: 3431–3440. [22] GUTIERREZ D. MiniSAR: A review of 4-inch and 1-foot resolution Ku-band imagery[EB/OL]. https://www.sandia.gov/radar/Web/images/SAND2005-3706P-miniSAR-flight-SAR-images.pdf, 2005. [23] ZHANG Peng, XU Hao, TIAN Tian, et al. SEFEPNet: Scale expansion and feature enhancement pyramid network for SAR aircraft detection with small sample dataset[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2022, 15: 3365–3375. doi: 10.1109/JSTARS.2022.3169339 [24] LIN Tsungyi, DOLLÁR Piotr, GIRSHICK Ross, et al. Feature pyramid networks for object detection[C]. 2017 IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, USA, 2017: 936–944. [25] LI Lu, DU Yuang, and DU Lan. Vehicle target detection network in SAR images based on rectangle-invariant rotatable convolution[J]. Remote Sensing, 2022, 14(13): 3086. doi: 10.3390/rs14133086 [26] 杜兰, 王梓霖, 郭昱辰, 等. 结合强化学习自适应候选框挑选的SAR目标检测方法[J]. 雷达学报, 2022, 11(5): 884–896. doi: 10.12000/JR22121DU Lan, WANG Zilin, GUO Yuchen, et al. Adaptive region proposal selection for SAR target detection using reinforcement learning[J]. Journal of Radars, 2022, 11(5): 884–896. doi: 10.12000/JR22121 -

作者中心

作者中心 专家审稿

专家审稿 责编办公

责编办公 编辑办公

编辑办公

下载:

下载: