SAR-AIRcraft-1.0: High-resolution SAR Aircraft Detection and Recognition Dataset(in English)

-

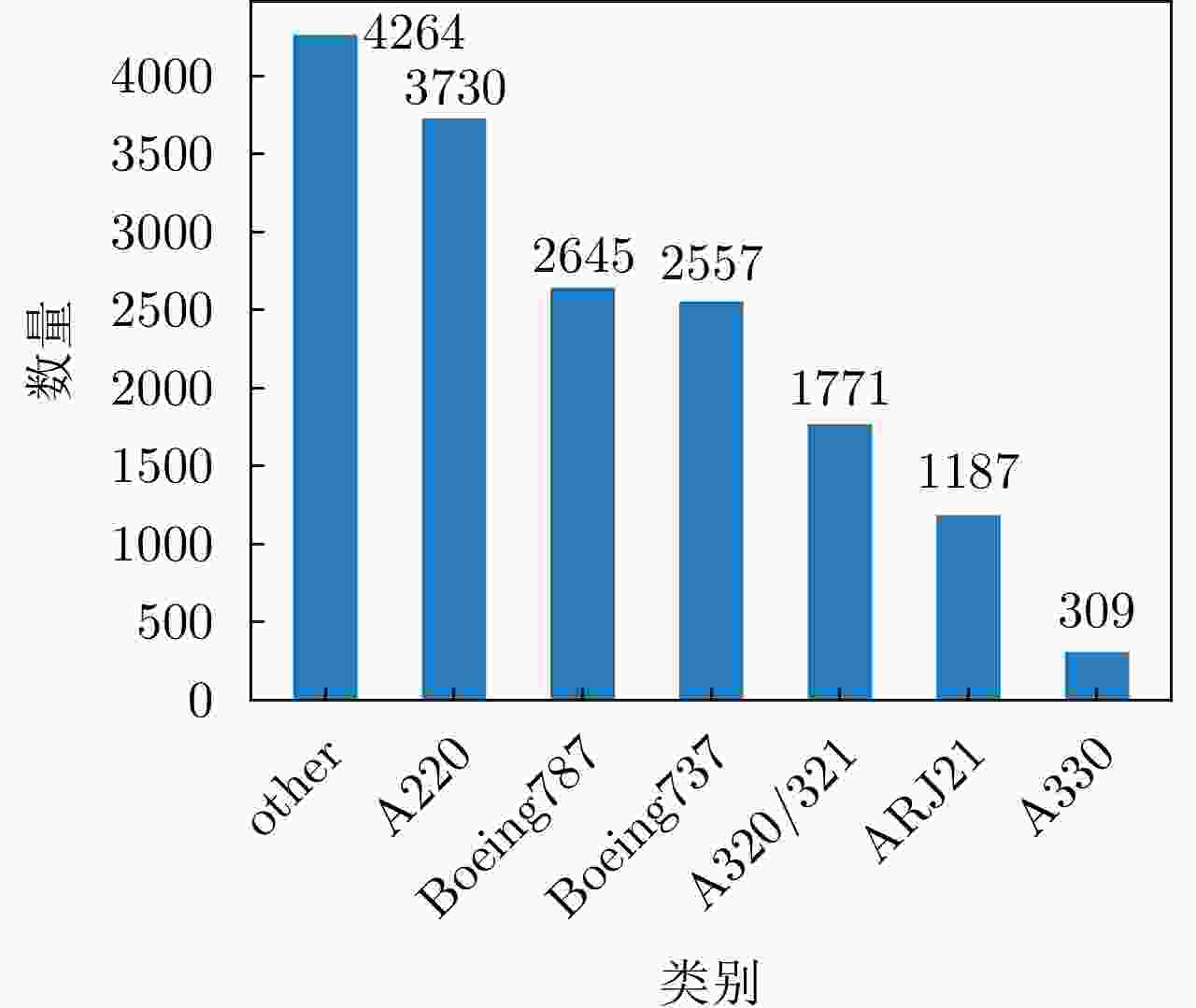

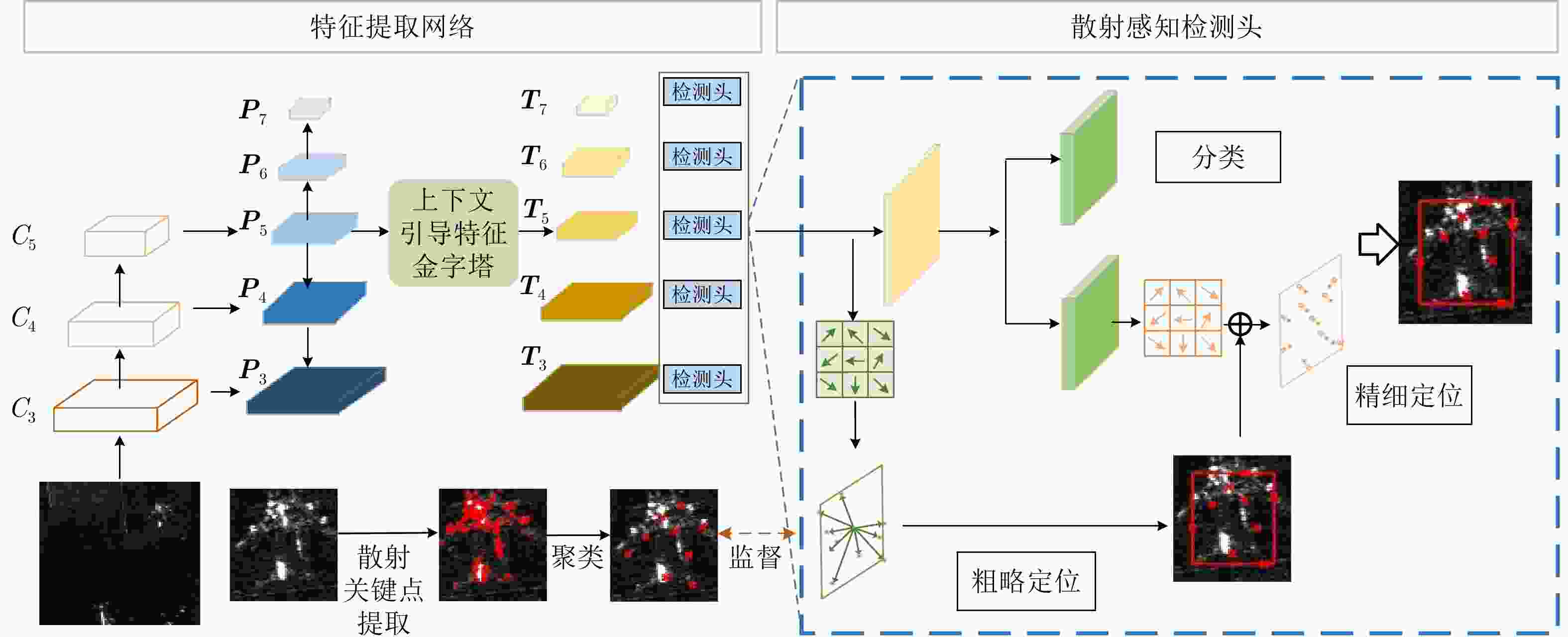

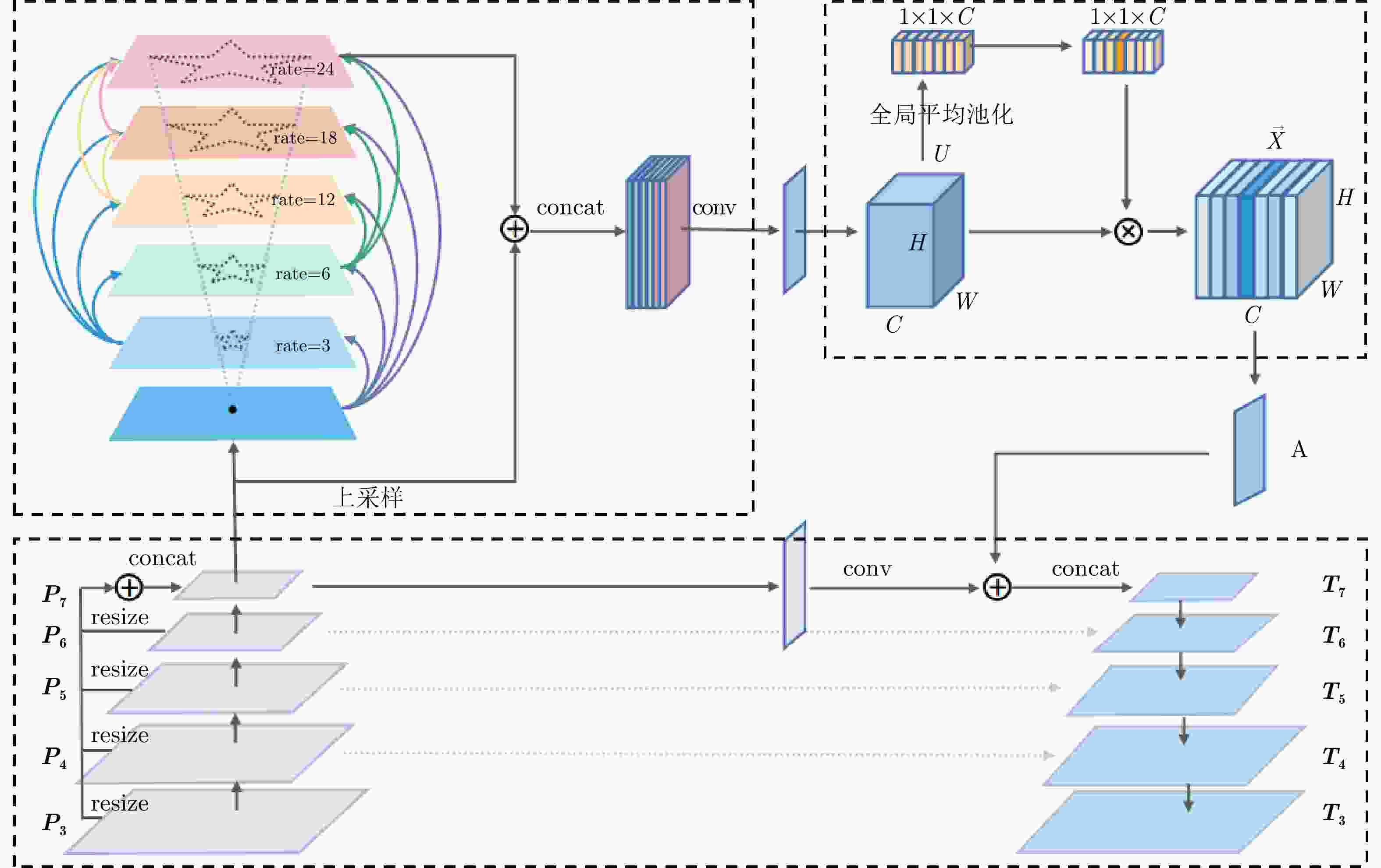

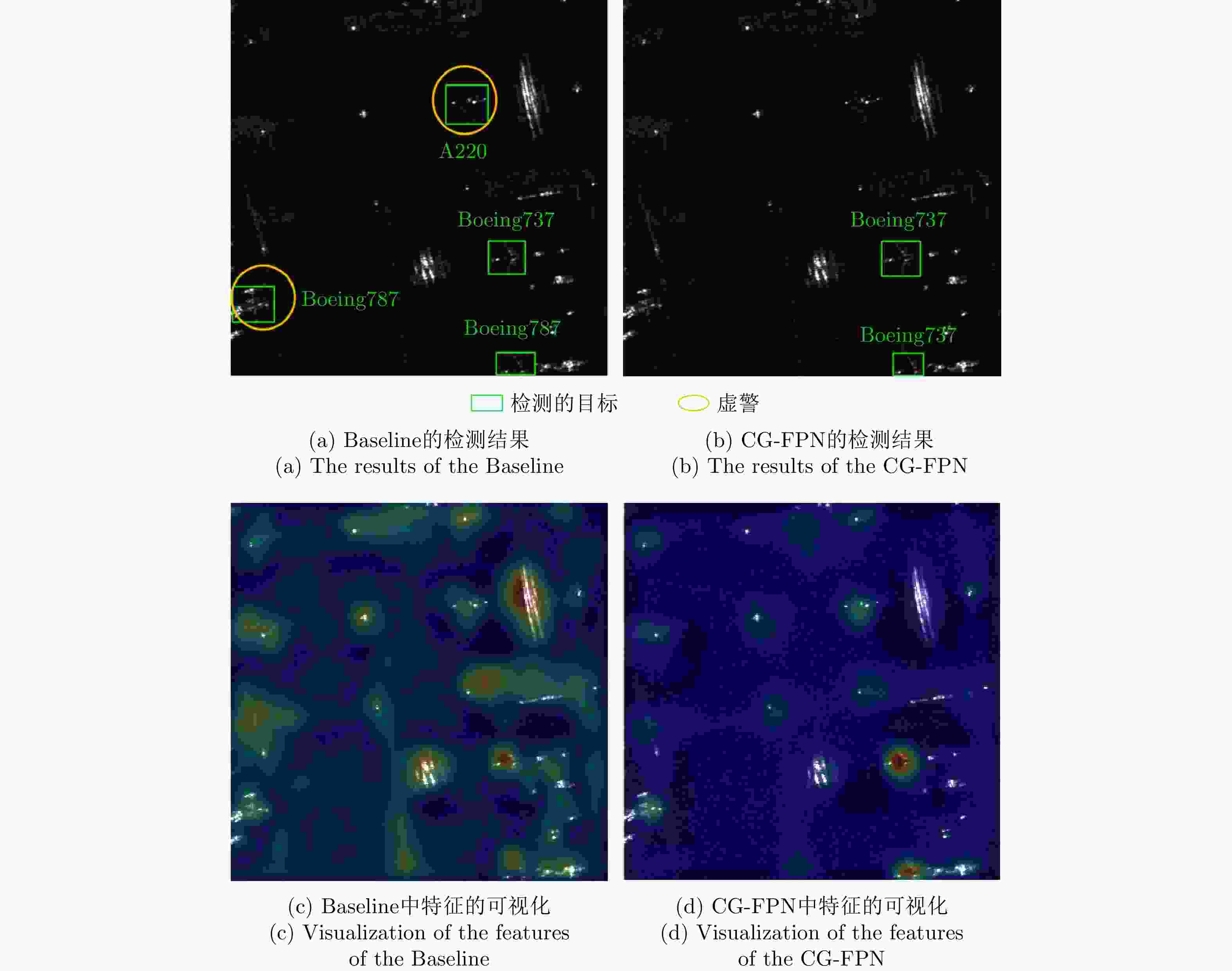

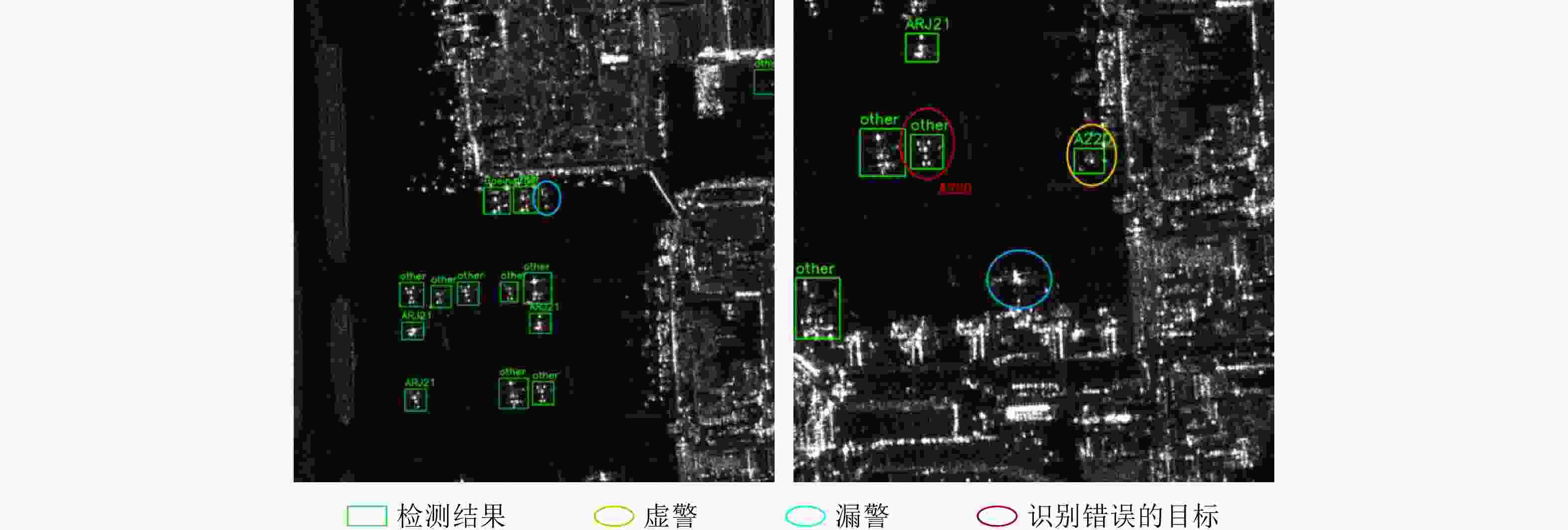

摘要: 针对合成孔径雷达(SAR)图像中飞机散射点离散以及背景强干扰造成虚警的问题,该文提出了一种结合散射感知的SAR飞机检测识别方法。一方面,通过上下文引导的特征金字塔模块来增强全局信息,减弱复杂场景中强干扰的影响,提高检测识别的准确率。另一方面,利用散射关键点对目标进行定位,设计散射感知检测模块实现对回归框的细化校正,增强目标的定位精度。为了验证方法有效性、同时促进SAR飞机检测识别领域的研究发展,该文制作并公开了一个高分辨率SAR-AIRcraft-1.0数据集。该数据集图像来自高分三号卫星,包含4,368张图片和16,463个飞机目标实例,涵盖A220, A320/321, A330, ARJ21, Boeing737, Boeing787和other共7个类别。该文将提出的方法和常见深度学习算法在构建的数据集上进行实验,实验结果证明了散射感知方法的优异性能,并且形成了该数据集在SAR飞机检测、细粒度识别、检测识别一体化等不同任务中性能指标的基准。Abstract: This study proposes a Synthetic Aperture Radar (SAR) aircraft detection and recognition method combined with scattering perception to address the problem of target discreteness and false alarms caused by strong background interference in SAR images. The global information is enhanced through a context-guided feature pyramid module, which suppresses strong disturbances in complex images and improves the accuracy of detection and recognition. Additionally, scatter key points are used to locate targets, and a scatter-aware detection module is designed to realize the fine correction of the regression boxes to improve target localization accuracy. This study generates and presents a high-resolution SAR-AIRcraft-1.0 dataset to verify the effectiveness of the proposed method and promote the research on SAR aircraft detection and recognition. The images in this dataset are obtained from the satellite Gaofen-3, which contains 4,368 images and 16,463 aircraft instances, covering seven aircraft categories, namely A220, A320/321, A330, ARJ21, Boeing737, Boeing787, and other. We apply the proposed method and common deep learning algorithms to the constructed dataset. The experimental results demonstrate the excellent effectiveness of our method combined with scattering perception. Furthermore, we establish benchmarks for the performance indicators of the dataset in different tasks such as SAR aircraft detection, recognition, and integrated detection and recognition.

-

表 1 SAR-AIRcraft-1.0数据集与其他SAR目标检测识别数据集的比较

Table 1. Comparison between the SAR-AIRcraft-1.0 dataset and other SAR object detection datasets

名称 类别 实例数量 图片数量 大小 发布年份 任务 MSTAR 10 5,950 5,950 128×128 1998 车辆识别 OpenSARShip 17 11,346 11,346 256×256 2017 舰船检测识别 SSDD 1 2,456 1,160 190~668 2017 舰船检测 SAR-Ship-Dataset 1 59,535 43,819 256×256 2019 舰船检测 AIR-SARShip-1.0 1 461 31 3000 ×3000 2019 舰船检测 HRSID 1 16,951 5,604 800×800 2020 舰船检测和实例分割 FUSAR-Ship 15 16,144 16,144 512×512 2020 舰船检测识别 SADD 1 7,835 2,966 224×224 2022 飞机检测 MSAR-1.0 4 60,396 28,449 256~2048 2022 飞机、油罐、桥梁、舰船检测 SAR-AIRcraft-1.0 7 16,463 4,368 800~ 1500 2023 飞机检测识别 表 2 不同方法的检测结果(%)

Table 2. The detection results of different methods (%)

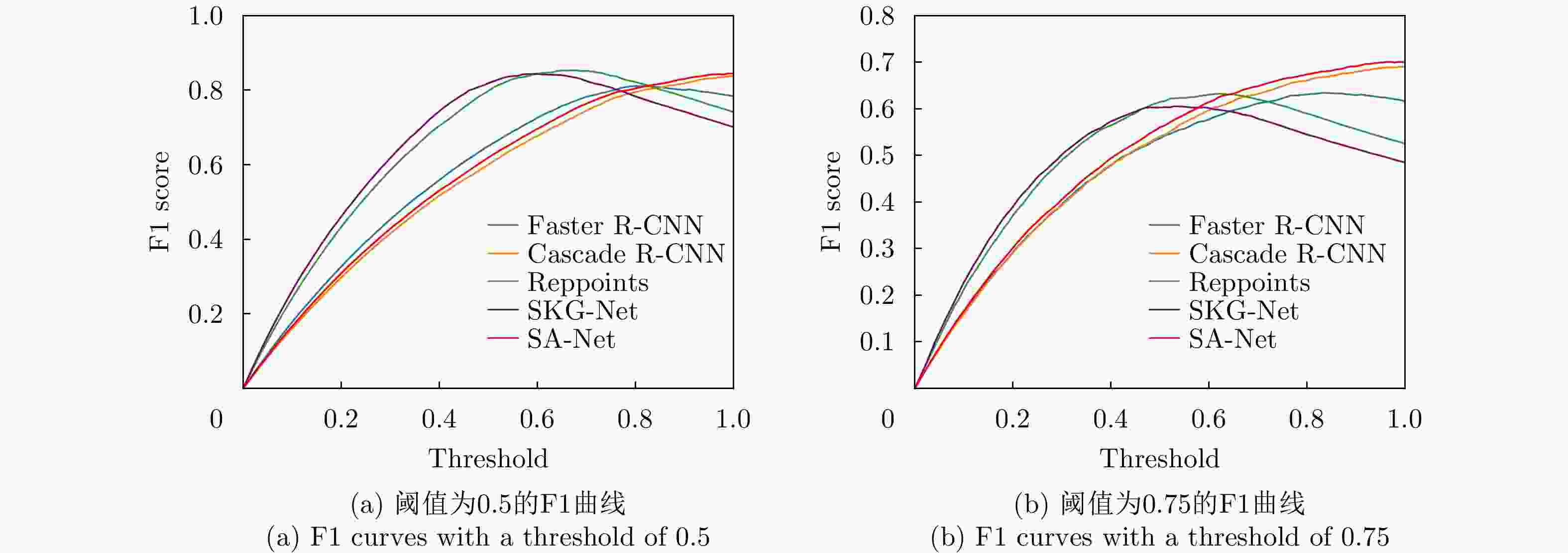

检测方法 P R F1 AP0.5 AP0.75 Faster R-CNN 77.6 78.1 77.8 71.6 53.6 Cascade R-CNN 89.0 79.5 84.0 77.8 59.1 Reppoints 62.7 88.7 81.2 80.3 52.9 SKG-Net 57.6 88.8 69.9 79.8 51.0 SA-Net 87.5 82.2 84.8 80.4 61.4 表 3 不同类别实例目标的数量

Table 3. The number of instance targets of different categories

类别 训练集样本数量 测试集样本数量 总计 A330 278 31 309 A320/321 1719 52 1771 A220 3270 460 3730 ARJ21 825 362 1187 Boeing737 2007 550 2557 Boeing787 2191 454 2645 other 3223 1041 4264 总计 13513 2950 16463 表 4 细粒度识别结果(%)

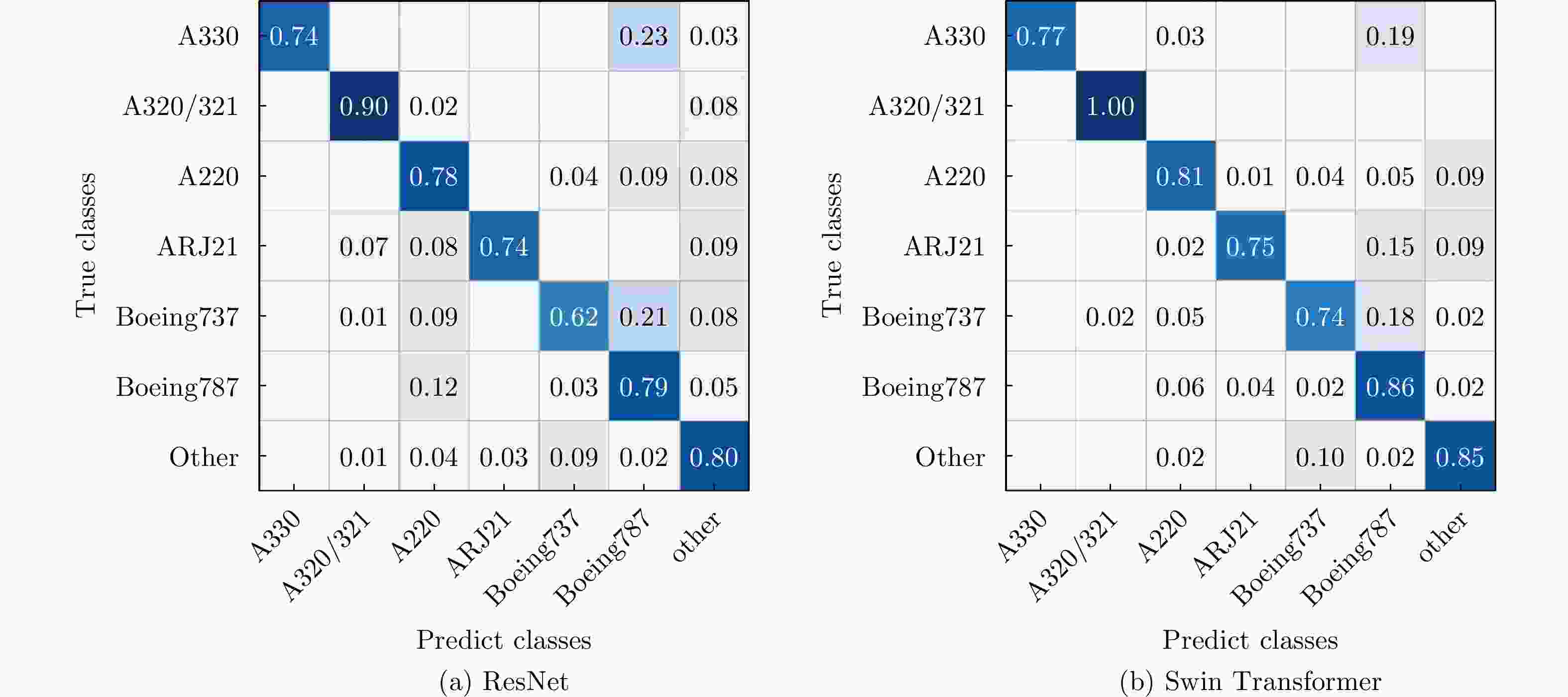

Table 4. Fine-grained recognition results (%)

方法 Acc (top-1/top-3) A330 A320/321 A220 ARJ21 Boeing737 Boeing787 other ResNet-50 75.59/89.19 74.19 90.38 78.04 73.76 61.64 78.63 80.50 ResNet-101 78.58/90.37 93.55 98.08 76.96 73.76 71.82 74.67 84.82 ResNeXt-50 80.61/89.46 83.87 94.23 78.91 74.86 73.27 83.04 85.40 ResNeXt-101 82.20/91.83 87.10 100 80.87 79.83 71.09 83.92 87.70 Swin Transformer 81.29/92.51 77.42 100 80.87 74.59 73.82 86.12 84.82 表 5 基于深度学习算法的检测结果(IoU=0.5)

Table 5. The performance of the algorithms based on deep learning (IoU=0.5)

类别 Faster

R-CNNCascade

R-CNNReppoints SKG-Net SA-Net A330 85.0 87.4 89.8 79.3 88.6 A320/321 97.2 97.5 97.9 78.2 94.3 A220 78.5 74.0 71.4 66.4 80.3 ARJ21 74.0 78.0 73.0 65.0 78.6 Boeing737 55.1 54.5 55.7 65.1 59.7 Boeing787 72.9 68.3 51.8 69.6 70.8 other 70.1 69.1 68.4 71.4 71.3 平均值(mAP) 76.1 75.7 72.6 70.7 77.7 表 6 基于深度学习算法的检测结果(IoU=0.75)

Table 6. The performance of the algorithms based on deep learning (IoU=0.75)

类别 Faster

R-CNNCascade

R-CNNReppoints SKG-Net SA-Net A330 85.0 87.4 66.4 66.4 88.6 A320/321 87.7 73.9 84.9 49.6 86.6 A220 58.7 49.1 49.4 29.8 55.0 ARJ21 55.2 59.0 50.9 37.7 59.7 Boeing737 42.8 39.1 36.6 48.7 41.8 Boeing787 60.5 57.6 41.8 51.6 60.4 other 45.4 46.1 43.1 41.1 47.7 平均值(mAP) 62.2 58.9 53.3 46.4 62.8 表 7 所提方法中各个模块的影响(%)

Table 7. Influence of each component in the proposed method (%)

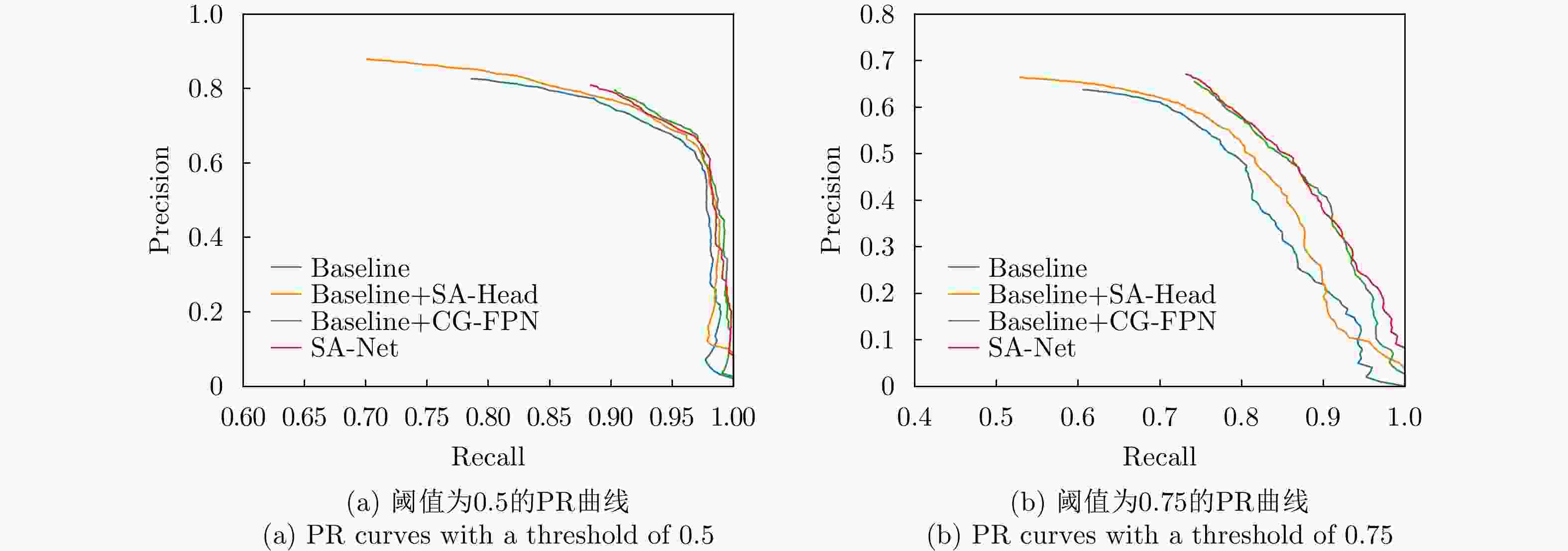

方法 P R F1 AP0.5 AP0.75 Baseline 88.1 81.2 84.5 79.6 60.7 Baseline+SA-Head 88.2 82.1 85.0 80.3 60.8 Baseline+CG-FPN 88.6 81.9 85.1 80.4 60.4 SA-Net 87.5 82.2 84.8 80.4 61.4 表 1 Comparison between the SAR-AIRcraft-1.0 dataset and other SAR object detection datasets

Dataset Category Instance Image Size Release year Task MSTAR 10 5,950 5,950 128×128 1998 Vehicle identification OpenSARShip 17 11,346 11,346 256×256 2017 Ship detection and recognition SSDD 1 2,456 1,160 190~668 2017 Ship detection SAR-Ship-Dataset 1 59,535 43,819 256×256 2019 Ship detection AIR-SARShip-1.0 1 461 31 3000 ×3000 2019 Ship detection HRSID 1 16,951 5,604 800×800 2020 Ship detection and segmentation FUSAR-Ship 15 16,144 16,144 512×512 2020 Ship detection and recognition SADD 1 7,835 2,966 224×224 2022 Aircraft detection MSAR-1.0 4 60,396 28,449 256~2048 2022 Aircraft, oil tanks, bridges, and ships detection SAR-AIRcraft-1.0 7 16,463 4,368 800~ 1500 2023 Aircraft detection and identification 表 2 Detection results of different methods (%)

Detection methods P R F1 AP 0.5 AP 0.75 Faster R-CNN 77.6 78.1 77.8 71.6 53.6 Cascade R-CNN 89.0 79.5 84.0 77.8 59.1 RepPoints 62.7 88.7 81.2 80.3 52.9 SKG-Net 57.6 88.8 69.9 79.8 51.0 SA-Net 87.5 82.2 84.8 80.4 61.4 表 3 The number of instance targets of different categories

Category Training set number Test set number Total A330 278 31 309 A320/321 1719 52 1771 A220 3270 460 3730 ARJ21 825 362 1187 Boeing737 2007 550 2557 Boeing787 2191 454 2645 other 3223 1041 4264 Total 13513 2950 16463 表 4 Fine-grained recognition results (%)

Methods Acc (top-1/top-3) A330 A320/321 A220 ARJ21 Boeing737 Boeing787 Other ResNet-50 75.59/89.19 74.19 90.38 78.04 73.76 61.64 78.63 80.50 ResNet-101 78.58/90.37 93.55 98.08 76.96 73.76 71.82 74.67 84.82 ResNeXt-50 80.61/89.46 83.87 94.23 78.91 74.86 73.27 83.04 85.40 ResNeXt-101 82.20/91.83 87.10 100 80.87 79.83 71.09 83.92 87.70 Swin Trarsformer 81.29/ 92.51 77.42 100 80.87 74.59 73.82 86.12 84.82 表 5 The performance of the algorithms based on deep learning (IoU=0.5)

Category Faster

R-CNNCascade

R-CNNReppoints SKG-Net SA-Net A330 85.0 87.4 89.8 79.3 88.6 A320/321 97.2 97.5 97.9 78.2 94.3 A220 78.5 74.0 71.4 66.4 80.3 ARJ21 74.0 78.0 73.0 65.0 78.6 Boeing737 55.1 54.5 55.7 65.1 59.7 Boeing787 72.9 68.3 51.8 69.6 70.8 other 70.1 69.1 68.4 71.4 71.3 mAP 76.1 75.7 72.6 70.7 77.7 表 6 The performance of the algorithms based on deep learning (IoU=0.75)

Category Faster

R-CNNCascade

R-CNNReppoints SKG-Net SA-Net A330 85.0 87.4 66.4 66.4 88.6 A320/321 87.7 73.9 84.9 49.6 86.6 A220 58.7 49.1 49.4 29.8 55.0 ARJ21 55.2 59.0 50.9 37.7 59.7 Boeing737 42.8 39.1 36.6 48.7 41.8 Boeing787 60.5 57.6 41.8 51.6 60.4 other 45.4 46.1 43.1 41.1 47.7 mAP 62.2 58.9 53.3 46.4 62.8 表 7 Influence of each component in the proposed method (%)

Methods P R F1 AP 0.5 AP 0.75 Baseline 88.1 81.2 84.5 79.6 60.7 Baseline+SA-Head 88.2 82.1 85.0 80.3 60.8 Baseline+CG-FPN 88.6 81.9 85.1 80.4 60.4 SA-Net 87.5 82.2 84.8 80.4 61.4 -

[1] FU Kun, FU Jiamei, WANG Zhirui, et al. Scattering-keypoint-guided network for oriented ship detection in high-resolution and large-scale SAR images[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2021, 14: 11162–11178. doi: 10.1109/JSTARS.2021.3109469. [2] GUO Qian, WANG Haipeng, and XU Feng. Scattering enhanced attention pyramid network for aircraft detection in SAR images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2021, 59(9): 7570–7587. doi: 10.1109/TGRS.2020.3027762. [3] SHAHZAD M, MAURER M, FRAUNDORFER F, et al. Buildings detection in VHR SAR images using fully convolution neural networks[J]. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(2): 1100–1116. doi: 10.1109/TGRS.2018.2864716. [4] ZHANG Zhimian, WANG Haipeng, XU Feng, et al. Complex-valued convolutional neural network and its application in polarimetric SAR image classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(12): 7177–7188. doi: 10.1109/TGRS.2017.2743222. [5] FU Kun, DOU Fangzheng, LI Hengchao, et al. Aircraft recognition in SAR images based on scattering structure feature and template matching[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2018, 11(11): 4206–4217. doi: 10.1109/JSTARS.2018.2872018. [6] DU Lan, DAI Hui, WANG Yan, et al. Target discrimination based on weakly supervised learning for high-resolution SAR images in complex scenes[J]. IEEE Transactions on Geoscience and Remote Sensing, 2020, 58(1): 461–472. doi: 10.1109/TGRS.2019.2937175. [7] CUI Zongyong, LI Qi, CAO Zongjie, et al. Dense attention pyramid networks for multi-scale ship detection in SAR images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2019, 11: 8983–8997. doi: 10.1109/TGRS.2019.2923988. [8] ZHANG Jinsong, XING Mengdao, and XIE Yiyuan. FEC: A feature fusion framework for SAR target recognition based on electromagnetic scattering features and deep CNN features[J]. IEEE Transactions on Geoscience and Remote Sensing, 2021, 59(3): 2174–2187. doi: 10.1109/TGRS.2020.3003264. [9] ZHAO Yan, ZHAO Lingjun, LI Chuyin, et al. Pyramid attention dilated network for aircraft detection in SAR images[J]. IEEE Geoscience and Remote Sensing Letters, 2021, 18(4): 662–666. doi: 10.1109/LGRS.2020.2981255. [10] ZHAO Yan, ZHAO Lingjun, LIU Zhong, et al. Attentional feature refinement and alignment network for aircraft detection in SAR imagery[J]. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 5220616. doi: 10.1109/TGRS.2021.3139994. [11] FU Jiamei, SUN Xian, WANG Zhirui, et al. An anchor-free method based on feature balancing and refinement network for multiscale ship detection in SAR images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2021, 59(2): 1331–1344. doi: 10.1109/TGRS.2020.3005151. [12] SUN Yuanrui, WANG Zhirui, SUN Xian, et al. SPAN: Strong scattering point aware network for ship detection and classification in large-scale SAR imagery[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2022, 15: 1188–1204. doi: 10.1109/JSTARS.2022.3142025. [13] 郭倩, 王海鹏, 徐丰. SAR图像飞机目标检测识别进展[J]. 雷达学报, 2020, 9(3): 497–513. doi: 10.12000/JR20020.GUO Qian, WANG Haipeng, and XU Feng. Research progress on aircraft detection and recognition in SAR imagery[J]. Journal of Radars, 2020, 9(3): 497–513. doi: 10.12000/JR20020. [14] 吕艺璇, 王智睿, 王佩瑾, 等. 基于散射信息和元学习的SAR图像飞机目标识别[J]. 雷达学报, 2022, 11(4): 652–665. doi: 10.12000/JR22044.LYU Yixuan, WANG Zhirui, WANG Peijin, et al. Scattering information and meta-learning based SAR images interpretation for aircraft target recognition[J]. Journal of Radars, 2022, 11(4): 652–665. doi: 10.12000/JR22044. [15] KANG Yuzhuo, WANG Zhirui, FU Jiamei, et al. SFR-Net: Scattering feature relation network for aircraft detection in complex SAR images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 5218317. doi: 10.1109/TGRS.2021.3130899. [16] CHEN Jiehong, ZHANG Bo, and WANG Chao. Backscattering feature analysis and recognition of civilian aircraft in TerraSAR-X images[J]. IEEE Geoscience and Remote Sensing Letters, 2015, 12(4): 796–800. doi: 10.1109/LGRS.2014.2362845. [17] SUN Xian, LV Yixuan, WANG Zhirui, et al. SCAN: Scattering characteristics analysis network for few-shot aircraft classification in high-resolution SAR images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 5226517. doi: 10.1109/TGRS.2022.3166174. [18] KEYDEL E R, LEE S W, and MOORE J T. MSTAR extended operating conditions: A tutorial[C]. The SPIE 2757, Algorithms for Synthetic Aperture Radar Imagery III, Orlando, USA, 1996: 228–242. [19] HUANG Lanqing, LIU Bin, LI Boying, et al. OpenSARShip: A dataset dedicated to Sentinel-1 ship interpretation[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2018, 11(1): 195–208. doi: 10.1109/JSTARS.2017.2755672. [20] LI Jianwei, QU Changwen, and SHAO Jiaqi. Ship detection in SAR images based on an improved faster R-CNN[C]. 2017 SAR in Big Data Era: Models, Methods and Applications (BIGSARDATA), Beijing, China, 2017: 1–6. [21] WANG Yuanyuan, WANG Chao, ZHANG Hong, et al. A SAR dataset of ship detection for deep learning under complex backgrounds[J]. Remote Sensing, 2019, 11(7): 765. doi: 10.3390/rs11070765. [22] 孙显, 王智睿, 孙元睿, 等. AIR-SARShip-1.0: 高分辨率SAR舰船检测数据集[J]. 雷达学报, 2019, 8(6): 852–862. doi: 10.12000/JR19097.SUN Xian, WANG Zhirui, SUN Yuanrui, et al. AIR-SARShip-1.0: High-resolution SAR ship detection dataset[J]. Journal of Radars, 2019, 8(6): 852–862. doi: 10.12000/JR19097. [23] WEI Shunjun, ZENG Xiangfeng, QU Qizhe, et al. HRSID: A high-resolution SAR images dataset for ship detection and instance segmentation[J]. IEEE Access, 2020, 8: 120234–120254. doi: 10.1109/ACCESS.2020.3005861. [24] HOU Xiyue, AO Wei, SONG Qian, et al. FUSAR-Ship: Building a high-resolution SAR-AIS matchup dataset of Gaofen-3 for ship detection and recognition[J]. Science China Information Sciences, 2020, 63(4): 140303. doi: 10.1007/s11432-019-2772-5. [25] ZHANG Peng, XU Hao, TIAN Tian, et al. SEFEPNet: Scale expansion and feature enhancement pyramid network for SAR aircraft detection with small sample dataset[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2022, 15: 3365–3375. doi: 10.1109/JSTARS.2022.3169339. [26] 陈杰, 黄志祥, 夏润繁, 等. 大规模多类SAR目标检测数据集-1.0[J/OL]. 雷达学报. https://radars.ac.cn/web/data/getData?dataType=MSAR, 2022.CHEN Jie, HUANG Zhixiang, XIA Runfan, et al. Large-scale multi-class SAR image target detection dataset-1.0[J/OL]. Journal of Radars. https://radars.ac.cn/web/data/getData?dataType=MSAR, 2022. [27] HU Jie, SHEN Li, and SUN Gang. Squeeze-and-excitation networks[C]. IEEE/CVF Conference on Computer Vision and Pattern Recognition, Salt Lake City, USA, 2018: 7132–7141. [28] SUN Yuanrui, SUN Xian, WANG Zhirui, et al. Oriented ship detection based on strong scattering points network in large-scale SAR images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2021, 60: 5218018. doi: 10.1109/TGRS.2021.3130117. [29] HUANG Lichao, YANG Yi, DENG Yafeng, et al. DenseBox: Unifying landmark localization with end to end object detection[J]. arXiv preprint arXiv: 1509.04874, 2015. [30] MIKOLAJCZYK K and SCHMID C. Scale & affine invariant interest point detectors[J]. International Journal of Computer Vision, 2004, 60(1): 63–86. doi: 10.1023/B:VISI.0000027790.02288.f2. [31] OLUKANMI P O, NELWAMONDO F, and MARWALA T. K-means-MIND: An efficient alternative to repetitive k-means runs[C]. 2020 7th International Conference on Soft Computing & Machine Intelligence (ISCMI), Stockholm, Sweden, 2020: 172–176. [32] DAI Jifeng, QI Haozhi, XIONG Yuwen, et al. Deformable convolutional networks[C]. 2017 IEEE International Conference on Computer Vision, Venice, Italy, 2017: 764–773. [33] FAN Haoqiang, SU Hao, and GUIBAS L. A point set generation network for 3d object reconstruction from a single image[C]. 2017 IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, USA, 2017: 2463–2471. [34] LIN T Y, GOYAL P, GIRSHICK R, et al. Focal loss for dense object detection[C]. 2017 IEEE International Conference on Computer Vision, Venice, Italy, 2017: 2999–3007. [35] HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition[C]. 2016 IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, USA, 2016: 770–778. [36] GIRSHICK R. Fast R-CNN[C]. 2015 IEEE International Conference on Computer Vision, Santiago, Chile, 2015: 1440–1448. [37] CAI Zhaowei and VASCONCELOS N. Cascade R-CNN: Delving into high quality object detection[C]. 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, Salt Lake City, USA, 2018: 6154–6162. [38] YANG Ze, LIU Shaohui, HU Han, et al. RepPoints: Point set representation for object detection[C]. 2019 IEEE/CVF International Conference on Computer Vision, Seoul, Korea, 2019: 9656–9665. [39] XIE Saining, GIRSHICK R, DOLLÁR P, et al. Aggregated residual transformations for deep neural networks[C]. 2017 IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, USA, 2017: 5987–5995. [40] LIU Ze, LIN Yutong, CAO Yue, et al. Swin transformer: Hierarchical vision transformer using shifted windows[C]. 2021 IEEE/CVF International Conference on Computer Vision, Montreal, Canada, 2021: 9992–10002. [41] TIAN Zhi, SHEN Chunhua, CHEN Hao, et al. FCOS: Fully convolutional one-stage object detection[C]. 2019 IEEE/CVF International Conference on Computer Vision, Seoul, Korea, 2019: 9626–9635. -

作者中心

作者中心 专家审稿

专家审稿 责编办公

责编办公 编辑办公

编辑办公

下载:

下载: