Survey of Research Progress on Target Detection and Discrimination of Single-channel SAR Images for Complex Scenes

-

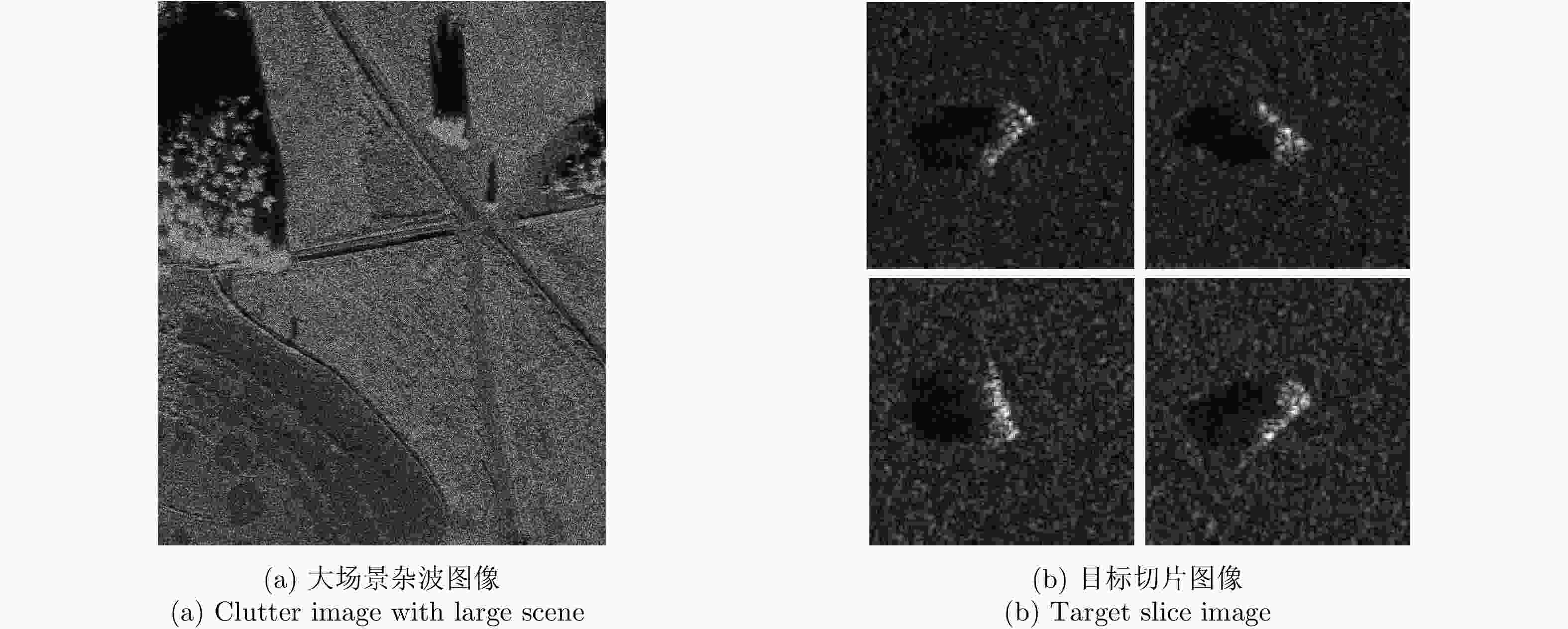

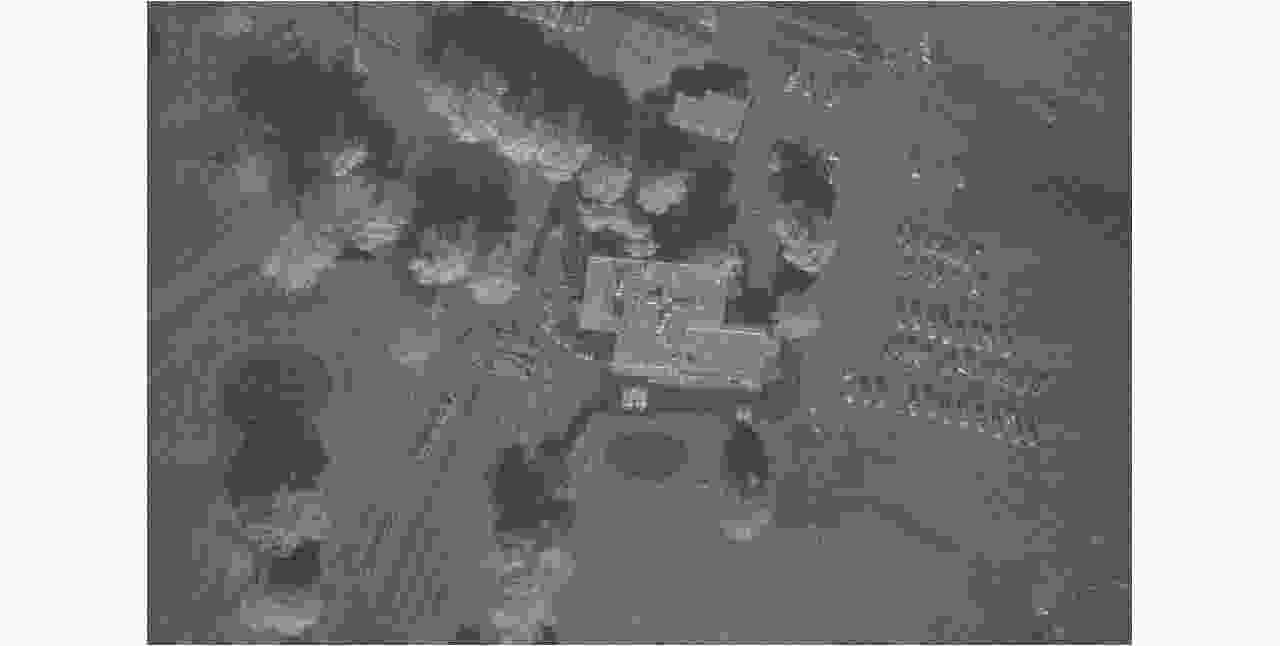

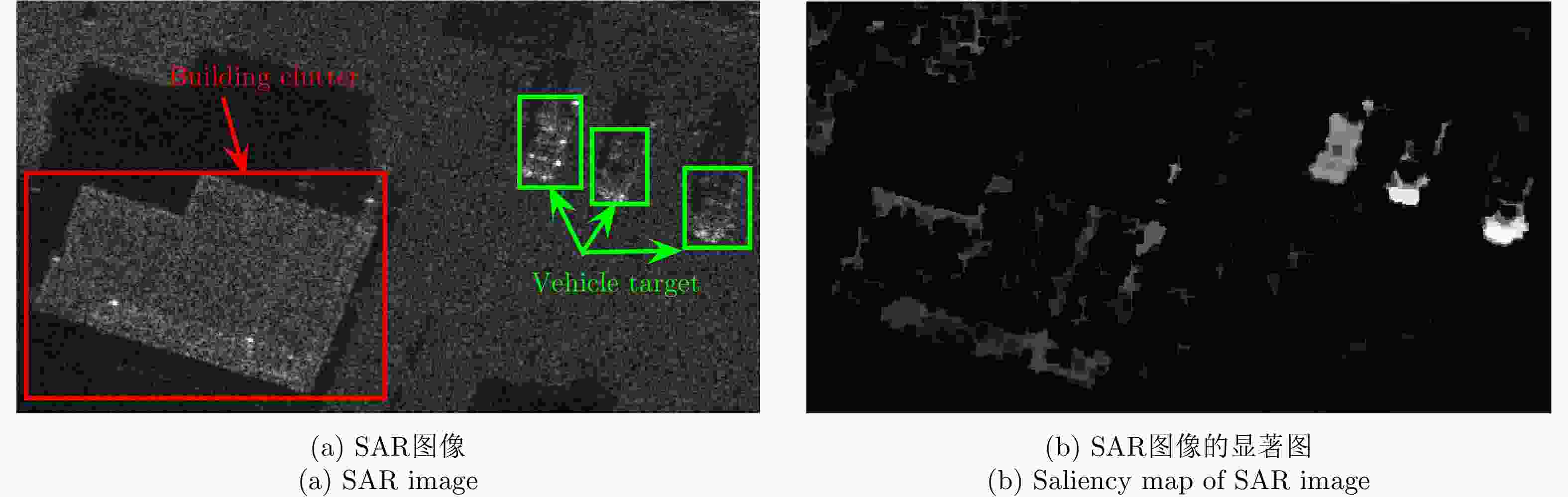

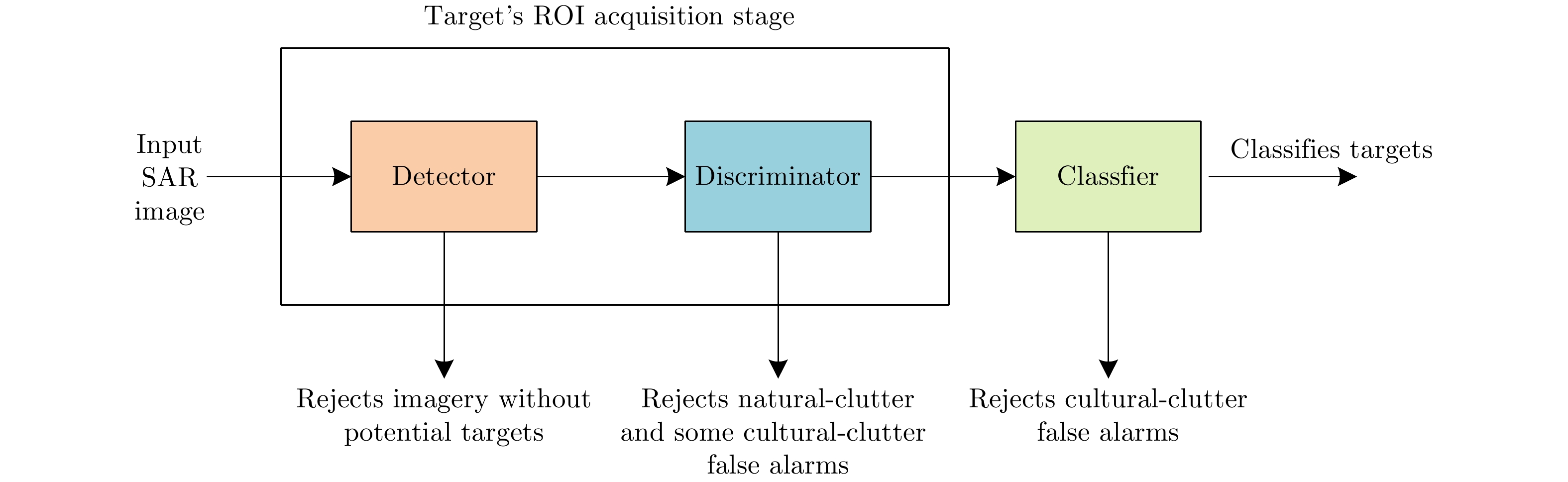

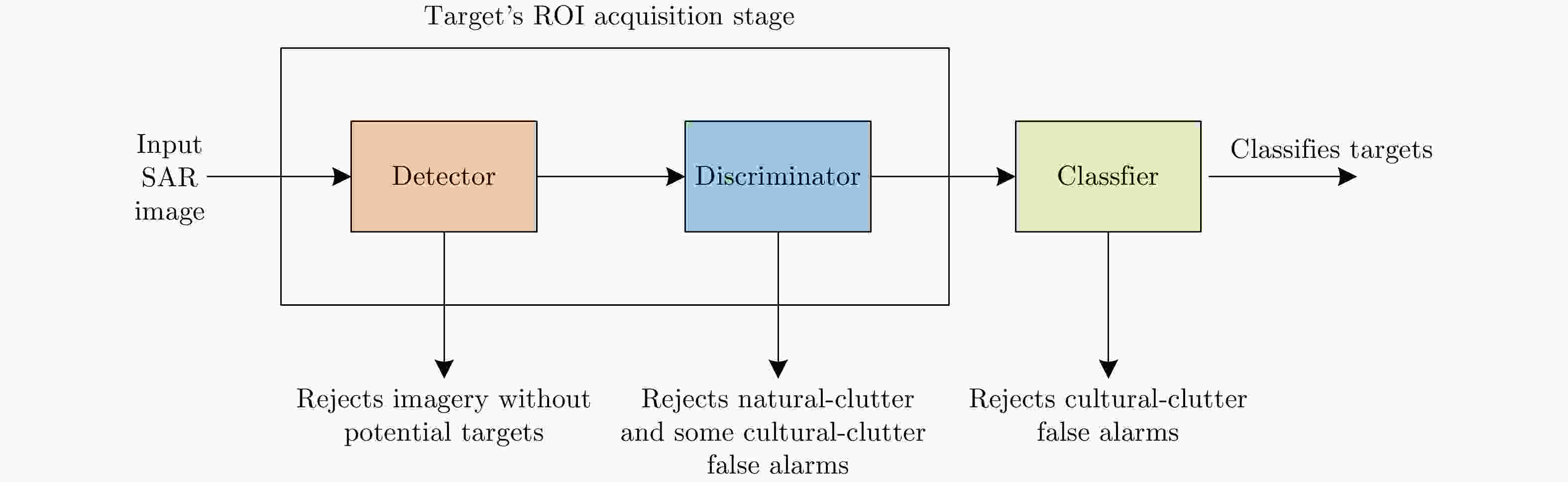

摘要: SAR作为一种主动式微波成像传感器,以其全天时、全天候、作用距离远等独特的技术优势,成为当前对地观测的主要手段之一,在军事和民用领域发挥着十分重要的作用。随着SAR遥感技术的发展,高分辨率、高质量的SAR图像不断产生,仅依靠人工手段对感兴趣的目标进行检测、识别费时费力,因此亟需发展SAR自动目标识别(ATR)技术。典型的SAR ATR系统主要包括检测、鉴别、分类/识别3个阶段,其中,检测和鉴别阶段是整个SAR ATR系统的基础,是国内外雷达界一直开展的SAR应用基础研究之一。针对单通道SAR图像,简单场景下目标检测与鉴别已经取得了不错的结果;而在复杂场景下,杂波散射强度相对高、杂波背景非均匀和目标散射强度相对弱、分布密集等情况,使得SAR目标检测和鉴别依然是一个难点。该文对近十年左右复杂场景下单通道SAR目标检测及鉴别方法的研究进展进行了归纳总结,并分析了各类方法的特点及存在的问题,展望了未来复杂场景下单通道SAR目标检测与鉴别方法的发展趋势。Abstract: As an active microwave imaging sensor, Synthetic Aperture Radar (SAR) has become one of the main means of Earth observation owing to its unique technical advantages of all-day, all-weather operation and long working distance. As such, it plays a very important role in military and civilian fields. With the development of SAR remote-sensing technology, high-resolution, high-quality SAR images are produced continuously. However, manual detection and recognition of targets of interest is time-consuming and laborious, so the development of Automatic Target Recognition (ATR) technology is a matter of urgency. The typical SAR ATR system primarily comprises three stages: detection, discrimination, and classification/recognition. The detection and discrimination stages are the basis of the SAR ATR system, and research on SAR applications in the radar field has been conducted by researchers around the world. For single-channel SAR images, target detection and discrimination from simple scenes yield good results. However, in complex scenes, the clutter scattering intensity is relatively high, the clutter background is heterogenous, the target scattering intensity is relatively weak, and the target distribution is dense. These factors continue to make accurate SAR target detection and discrimination difficult. In this paper, we summarize the recent research progress on single-channel SAR target detection and discrimination methods for complex scenes, analyze the characteristics and problems associated with various methods, and consider the future development trend of single-channel SAR target detection and discrimination methods for complex scenes.

-

表 1 不同SAR目标检测方法比较

Table 1. Comparison of different SAR target detection methods

SAR目标检测方法 优点 缺点 基于恒虚警率 方法简单,简单场景下可以取得良好性能。 实际中很难选择出合适的杂波统计模型且处理非均匀强杂波背景下的目标检测问题时易产生较多虚警和漏警。 基于视觉注意模型 速度较快,复杂场景下可以通过引入先验信息一定程度上抑制强杂波增强目标,有效提升信杂比。 先验信息的引入需要针对具体的问题具体分析,对于不同的检测任务可能需要重新设计算法。 基于复图像 利用SAR目标和杂波的散射特性以及成像机理进行目标检测,从物理机理上更能反映人造目标和自然杂波的区别。 需要原始复数SAR图像数据,目前对人造杂波干扰和感兴趣人造目标的区分能力还有待验证。 表 2 SAR目标鉴别方法总结

Table 2. Summary of SAR target discrimination methods

SAR目标鉴别方法 优点 缺点 基于全监督学习 算法简单、精度较高。 需要大量人工标记的训练数据。 基于半监督、弱监督学习 需要人工标记的信息较少,减轻人类的工作负担。 算法较为复杂,且性能与全监督方法还存在一定的差距。 表 3 SAR目标检测、鉴别2级流程与基于深度学习的检测、鉴别一体化方法比较

Table 3. Comparison of SAR target detection and discrimination based on two stage process with detection and discrimination integration method based on deep learning

SAR目标检测、鉴别方法 优点 缺点 2级流程 结合SAR图像目标、杂波物理特性提取特征或设计分类器。一些传统2级流程方法计算量较小,在相同的平台条件下,运算效率更高,对资源占用也更少,更易于工程实用。 特征和分类器独立设计,二者可能失配,影响最终性能。 基于深度学习的一体化 不用手工设计特征和分类器,检测精度较高。 需要大量有标记的数据支撑,而SAR图像可以得到的有标记数据较少。网络参数较多,对计算、存储资源要求高,通常需要GPU平台。 -

[1] 金亚秋. 多模式遥感智能信息与目标识别: 微波视觉的物理智能[J]. 雷达学报, 2019, 8(6): 710–716. doi: 10.12000/JR19083JIN Yaqiu. Multimode remote sensing intelligent information and target recognition: Physical intelligence of microwave vision[J]. Journal of Radars, 2019, 8(6): 710–716. doi: 10.12000/JR19083 [2] NOVAK L M, OWIRKA G J, and NETISHEN C M. Radar target identification using spatial matched filters[J]. Pattern Recognition, 1994, 27(4): 607–617. doi: 10.1016/0031-3203(94)90040-X [3] NOVAK L M, OWIRKA G J, and NETISHEN C M. Performance of a high-resolution polarimetric SAR automatic target recognition system[J]. The Lincoln Laboratory Journal, 1993, 6(1): 11–24. [4] NOVAK L M, HALVERSEN S D, OWIRKA G J, et al. Effects of polarization and resolution on the performance of a SAR automatic target recognition system[J]. The Lincoln Laboratory Journal, 1995, 8(1): 49–68. [5] 高贵. SAR图像目标ROI自动获取技术研究[D]. [博士论文], 国防科学技术大学, 2007.GAO Gui. The research on automatic acquirement of target’s ROI from SAR imagery[D]. [Ph.D. dissertation], National University of Defense Technology, 2007. [6] 徐恒. SAR目标鉴别算法研究[D]. [硕士论文], 西安电子科技大学, 2012.XU Heng. Research on algorithms of SAR target discrimination[D]. [Master dissertation], Xidian University, 2012. [7] GREENSPAN M, PHAM L, and TARDELLA N. Development and evaluation of a real time SAR ATR system[C]. IEEE Radar Conference, RADARCON’98. Challenges in Radar Systems and Solutions, Dallas, USA, 1998: 38-43. [8] DAI Hui, DU Lan, WANG Yan, et al. A modified CFAR algorithm based on object proposals for ship target detection in SAR images[J]. IEEE Geoscience and Remote Sensing Letters, 2016, 13(12): 1925–1929. doi: 10.1109/LGRS.2016.2618604 [9] WANG Yinghua and LIU Hongwei. A hierarchical ship detection scheme for high-resolution SAR images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2012, 50(10): 4173–4184. doi: 10.1109/TGRS.2012.2189011 [10] SOUYRIS J C, HENRY C, and ADRAGNA F. On the use of complex SAR image spectral analysis for target detection: Assessment of polarimetry[J]. IEEE Transactions on Geoscience and Remote Sensing, 2003, 41(12): 2725–2734. doi: 10.1109/TGRS.2003.817809 [11] OUCHI K, TAMAKI S, YAGUCHI H, et al. Ship detection based on coherence images derived from cross correlation of multilook SAR images[J]. IEEE Geoscience and Remote Sensing Letters, 2004, 1(3): 184–187. doi: 10.1109/LGRS.2004.827462 [12] CHEN Sizhe, WANG Haipeng, XU Feng, et al. Target classification using the deep convolutional networks for SAR images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(8): 4806–4817. doi: 10.1109/TGRS.2016.2551720 [13] PARK J I, PARK S H, and KIM K T. New discrimination features for SAR automatic target recognition[J]. IEEE Geoscience and Remote Sensing Letters, 2013, 10(3): 476–480. doi: 10.1109/LGRS.2012.2210385 [14] 徐丰, 王海鹏, 金亚秋. 深度学习在SAR目标识别与地物分类中的应用[J]. 雷达学报, 2017, 6(2): 136–148. doi: 10.12000/JR16130XU Feng, WANG Haipeng, and JIN Yaqiu. Deep learning as applied in SAR target recognition and terrain classification[J]. Journal of Radars, 2017, 6(2): 136–148. doi: 10.12000/JR16130 [15] 高贵, 周蝶飞, 蒋咏梅, 等. SAR图像目标检测研究综述[J]. 信号处理, 2008, 24(6): 971–981. doi: 10.3969/j.issn.1003-0530.2008.06.018GAO Gui, ZHOU Diefei, JIANG Yongmei, et al. Study on target detection in SAR image: A survey[J]. Signal Processing, 2008, 24(6): 971–981. doi: 10.3969/j.issn.1003-0530.2008.06.018 [16] 高贵. SAR图像目标鉴别研究综述[J]. 信号处理, 2009, 25(9): 1421–1432. doi: 10.3969/j.issn.1003-0530.2009.09.018GAO Gui. Study on target discrimination in SAR images: A survey[J]. Signal Processing, 2009, 25(9): 1421–1432. doi: 10.3969/j.issn.1003-0530.2009.09.018 [17] EL-DARYMLI K, MCGUIRE P, POWER D, et al. Target detection in synthetic aperture radar imagery: A state-of-the-art survey[J]. Journal of Applied Remote Sensing, 2013, 7(1): 071598. doi: 10.1117/1.JRS.7.071598 [18] 王兆成, 李璐, 杜兰, 等. 基于单极化SAR图像的舰船目标检测与分类方法[J]. 科技导报, 2017, 35(20): 86–93. doi: 10.3981/j.issn.1000-7857.2017.20.009WANG Zhaocheng, LI Lu, DU Lan, et al. Ship detection and classification baser on single-polarization SAR images[J]. Science &Technology Review, 2017, 35(20): 86–93. doi: 10.3981/j.issn.1000-7857.2017.20.009 [19] 聂春霞. 基于复杂场景SAR图像的多目标智能检测算法研究[D]. [硕士论文], 南京航空航天大学, 2017.NIE Chunxia. Research on multi-target intelligent detection algorithm based on SAR image of complex scene[D]. [Master dissertation], Nanjing University of Aeronautics and Astronautics, 2017. [20] 余文毅. 复杂场景下的SAR目标检测[D]. [硕士论文], 西安电子科技大学, 2015.YU Wenyi. SAR target detection in the complex scene[D]. [Master dissertation], Xidian University, 2015. [21] WARD K D. Compound representation of high resolution sea clutter[J]. Electronics Letters, 1981, 17(16): 561–563. doi: 10.1049/el:19810394 [22] OLIVER C and QUEGAN S. Understanding Synthetic Aperture Radar Images[M]. Boston, London: Artech House, 1998. [23] FRERY A C, MULLER H J, YANASSE C C F, et al. A model for extremely heterogeneous clutter[J]. IEEE Transactions on Geoscience and Remote Sensing, 1997, 35(3): 648–659. doi: 10.1109/36.581981 [24] ANASTASSOPOULOS V, LAMPROPOULOS G A, DROSOPOULOS A, et al. High resolution radar clutter statistics[J]. IEEE Transactions on Aerospace and Electronic Systems, 1999, 35(1): 43–59. doi: 10.1109/7.745679 [25] TISON C, NICOLAS J M, TUPIN F, et al. A new statistical model for markovian classification of urban areas in high-resolution SAR images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2004, 42(10): 2046–2057. doi: 10.1109/TGRS.2004.834630 [26] 代梦. 背景干扰情况下高分SAR图像车辆目标检测方法研究[D]. [硕士论文], 上海交通大学, 2017.DAI Meng. Research on vehicle target detection method for high resolution SAR images with backgrund disturbances[D]. [Master dissertation], Shanghai Jiao Tong University, 2017. [27] WEISS M. Analysis of some modified cell-averaging CFAR processors in multiple-target situations[J]. IEEE Transactions on Aerospace and Electronic Systems, 1982, AES-18(1): 102–114. doi: 10.1109/TAES.1982.309210 [28] ROHLING H. Radar CFAR thresholding in clutter and multiple target situations[J]. IEEE Transactions on Aerospace and Electronic Systems, 1983, AES-19(4): 608–621. doi: 10.1109/TAES.1983.309350 [29] 何友, 关键, 孟祥伟, 等. 雷达目标检测与恒虚警处理[M]. 2版. 北京: 清华大学出版社, 2011.HE You, GUAN Jian, MENG Xiangwei, et al. Radar Target Detection and CFAR Processing[M]. 2nd ed. Beijing: Tsinghua University Press, 2011. [30] MEZIANI H A and SOLTANI F. Performance analysis of some CFAR detectors in homogeneous and non-homogeneous pearson-distributed clutter[J]. Signal Processing, 2006, 86(8): 2115–2122. doi: 10.1016/j.sigpro.2006.02.036 [31] RITCEY J A and DU H. Order statistic CFAR detectors for speckled area targets in SAR[C]. Proceedings of Conference Record of the Twenty-Fifth Asilomar Conference on Signals, Systems & Computers, Pacific Grove, USA, 1991: 1082–1086. [32] SMITH M E and VARSHNEY P K. VI-CFAR: A novel CFAR algorithm based on data variability[C]. 1997 IEEE National Radar Conference, Syracuse, USA, 1997: 263–268. [33] SMITH M E and VARSHNEY P K. Intelligent CFAR processor based on data variability[J]. IEEE Transactions on Aerospace and Electronic Systems, 2000, 36(3): 837–847. doi: 10.1109/7.869503 [34] LI Jian and ZELNIO E G. Target detection with synthetic aperture radar[J]. IEEE Transactions on Aerospace and Electronic Systems, 1996, 32(2): 613–627. doi: 10.1109/7.489506 [35] LOMBARDO P, SCIOTTI M, and KAPLAN L M. SAR prescreening using both target and shadow information[C]. 2001 IEEE Radar Conference, Atlanta, USA, 2001: 147–152. [36] LEUNG H, DUBASH N, and XIE N. Detection of small objects in clutter using a GA-RBF neural network[J]. IEEE Transactions on Aerospace and Electronic Systems, 2002, 38(1): 98–118. doi: 10.1109/7.993232 [37] LAMPROPOULOS G A and LEUNG H. CFAR detection of small manmade targets using chaotic and statistical CFAR detectors[C]. SPIE 3809, Signal and Data Processing of Small Targets, Denver, USA, 1999: 292–296. [38] NOVAK L M, OWIRKA G J, BROWER W S, et al. The automatic target-recognition system in SAIP[J]. The Lincoln Laboratory Journal, 1997, 10(2): 187–202. [39] GREIG D W and DENNY M. Knowledge-based methods for small object detection in SAR images[C]. The SPIE 4883, SAR Image Analysis, Modeling, and Techniques V, Crete, Greece, 2003: 121–130. [40] HALVERSEN S D, OWIRKA G J, and NOVAK L M. New approaches for detecting groups of targets[C]. 1994 28th Asilomar Conference on Signals, Systems and Computers, Pacific Grove, USA, 1994: 137–140. [41] OWIRKA G J, HALVERSEN S D, HIETT M, et al. An algorithm for detecting groups of targets[C]. The International Radar Conference, Alexandria, USA, 1995: 641–643. [42] GAO Gui, KUANG Gangyao, ZHANG Qi, et al. Fast detecting and locating groups of targets in high-resolution SAR images[J]. Pattern Recognition, 2007, 40(4): 1378–1384. doi: 10.1016/j.patcog.2006.01.019 [43] CUI Yi, ZHOU Guangyi, YANG Jian, et al. On the iterative censoring for target detection in SAR images[J]. IEEE Geoscience and Remote Sensing Letters, 2011, 8(4): 641–655. doi: 10.1109/LGRS.2010.2098434 [44] 陈祥, 孙俊, 尹奎英, 等. 基于CFAR级联的SAR图像舰船目标检测算法[J]. 现代雷达, 2012, 34(9): 50–54, 58. doi: 10.3969/j.issn.1004-7859.2012.09.011CHEN Xiang, SUN Jun, YIN Kuiying, et al. An algorithm of ship target detection in SAR images based on cascaded CFAR[J]. Modern Radar, 2012, 34(9): 50–54, 58. doi: 10.3969/j.issn.1004-7859.2012.09.011 [45] 宋文青, 王英华, 刘宏伟. 高分辨SAR图像自动区域筛选目标检测算法[J]. 电子与信息学报, 2016, 38(5): 1017–1025. doi: 10.11999/JEIT150808SONG Wenqing, WANG Yinghua, and LIU Hongwei. An automatic block-to-block censoring target detector for high resolution SAR image[J]. Journal of Electronics &Information Technology, 2016, 38(5): 1017–1025. doi: 10.11999/JEIT150808 [46] DING Tao, ANFINSEN S N, and BREKKE C. Robust CFAR detector based on truncated statistics in multiple-target situations[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(1): 117–134. doi: 10.1109/TGRS.2015.2451311 [47] YU Wenyi, WANG Yinghua, LIU Hongwei, et al. Superpixel-based CFAR target detection for high-resolution SAR images[J]. IEEE Geoscience and Remote Sensing Letters, 2016, 13(5): 730–734. doi: 10.1109/LGRS.2016.2540809 [48] AO Wei, XU Feng, LI Yongchen, et al. Detection and discrimination of ship targets in complex background from spaceborne ALOS-2 SAR images[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2018, 11(2): 536–550. doi: 10.1109/JSTARS.2017.2787573 [49] LENG Xiangguang, JI Kefeng, XIANG Xiangwei, et al. Area ratio invariant feature group for ship detection in SAR imagery[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2018, 11(7): 2376–2388. doi: 10.1109/JSTARS.2018.2820078 [50] GAO Gui, LIU Li, ZHAO Lingjun, et al. An adaptive and fast CFAR algorithm based on automatic censoring for target detection in high-resolution SAR images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2009, 47(6): 1685–1697. doi: 10.1109/TGRS.2008.2006504 [51] 胡睿, 孙进平, 王文光. 基于α稳定分布的SAR图像目标检测算法[J]. 中国图象图形学报, 2009, 14(1): 25–29. doi: 10.11834/jig.20090105HU Rui, SUN Jinping, and WANG Wenguang. Target detection of SAR images using α stable distribution[J]. Journal of image and Graphics, 2009, 14(1): 25–29. doi: 10.11834/jig.20090105 [52] QIN Xianxiang, ZHOU Shilin, ZOU Huanxin, et al. A CFAR detection algorithm for generalized gamma distributed background in high-resolution SAR images[J]. IEEE Geoscience and Remote Sensing Letters, 2013, 10(4): 806–810. doi: 10.1109/LGRS.2012.2224317 [53] GAO Gui. A parzen-window-kernel-based CFAR algorithm for ship detection in SAR images[J]. IEEE Geoscience and Remote Sensing Letters, 2011, 8(3): 557–561. doi: 10.1109/LGRS.2010.2090492 [54] 张颢, 孟祥伟, 刘磊, 等. 改进的基于Parzen窗算法的SAR图像目标检测[J]. 计算机科学, 2015, 42(11A): 151–154.ZHANG Hao, MENG Xiangwei, LIU Lei, et al. Improved parzen window based ship detection algorithm in SAR images[J]. Computer Science, 2015, 42(11A): 151–154. [55] LENG Xiangguang, JI Kefeng, YANG Kai, et al. A bilateral CFAR algorithm for ship detection in SAR images[J]. IEEE Geoscience and Remote Sensing Letters, 2015, 12(7): 1536–1540. doi: 10.1109/LGRS.2015.2412174 [56] HUANG Yong and LIU Fang. Detecting cars in VHR SAR images via semantic CFAR algorithm[J]. IEEE Geoscience and Remote Sensing Letters, 2016, 13(6): 801–805. doi: 10.1109/LGRS.2016.2546309 [57] 曾丽娜, 周德云, 李枭扬, 等. 基于无训练单样本有效特征的SAR目标检测[J]. 雷达学报, 2017, 6(2): 177–185. doi: 10.12000/JR16114ZENG Li’na, ZHOU Deyun, LI Xiaoyang, et al. Novel SAR target detection algorithm using free training[J]. Journal of Radars, 2017, 6(2): 177–185. doi: 10.12000/JR16114 [58] KANG Miao, LENG Xiangguang, LIN Zhao, et al. A modified faster R-CNN based on CFAR algorithm for SAR ship detection[C]. 2017 International Workshop on Remote Sensing with Intelligent Processing, Shanghai, China, 2017: 1–4. [59] WALTHER D. Interactions of visual attention and object recognition: Computational modeling, algorithms, and psychophysics[D]. [Ph.D. dissertation], California Institute of Technology, 2006. [60] ITTI L, KOCH C, and NIEBUR E. A model of saliency-based visual attention for rapid scene analysis[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1998, 20(11): 1254–1259. doi: 10.1109/34.730558 [61] BORJI A and ITTI L. State-of-the-Art in visual attention modeling[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(1): 185–207. doi: 10.1109/TPAMI.2012.89 [62] KOCH K, MCLEAN J, SEGEV R, et al. How much the eye tells the Brain[J]. Current Biology, 2006, 16(14): 1428–1434. doi: 10.1016/j.cub.2006.05.056 [63] BRUCE N D B and TSOTSOS J K. Saliency based on information maximization[C]. The 18th International Conference on Neural Information Processing Systems, Montreal, Canada, 2005: 155–162. [64] ITTI L and BALDI P. Bayesian surprise attracts human attention[J]. Vision Research, 2009, 49(10): 1295–1306. doi: 10.1016/j.visres.2008.09.007 [65] HOU Xiaodi and ZHANG Liqing. Saliency detection: A spectral residual approach[C]. 2007 IEEE Conference on Computer Vision and Pattern Recognition, Minneapolis, USA, 2007: 1–8. [66] YU Ying, WANG Bin, and ZHANG Liming. Pulse discrete cosine transform for saliency-based visual attention[C]. The IEEE 8th International Conference on Development and Learning, Shanghai, China, 2009: 1–6. [67] CHENG Mingming, MITRA N J, HUANG Xiaolei, et al. Global contrast based salient region detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 569–582. doi: 10.1109/TPAMI.2014.2345401 [68] WANG Zhaocheng, DU Lan, and SU Hongtao. Target detection via bayesian-morphological saliency in high-resolution SAR images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(10): 5455–5466. doi: 10.1109/TGRS.2017.2707672 [69] 王兆成. 复杂场景下SAR图像目标检测及鉴别方法研究[D]. [博士论文], 西安电子科技大学, 2018.WANG Zhaocheng. Study on target detection and discrimination for SAR images in complex scenes[D]. [Ph.D. dissertation], Xidian University, 2018. [70] YU Ying, WANG Bin, and ZHANG Liming. Hebbian-based neural networks for bottom-up visual attention and its applications to ship detection in SAR images[J]. Neurocomputing, 2011, 74(11): 2008–2017. doi: 10.1016/j.neucom.2010.06.026 [71] LIU Shuo, CAO Zongjie, and LI Jin. A SVD-based Visual Attention Detection Algorithm of SAR Image[M]. ZHANG Baoju, MU Jiasong, WAMG Wei, et al. The Proceedings of the Second International Conference on Communications, Signal Processing, and Systems. Cham: Springer, 2014: 479–486. [72] ZHAO Juanping, ZHANG Zenghui, YU Wenxian, et al. A cascade coupled convolutional neural network guided visual attention method for ship detection from SAR images[J]. IEEE Access, 2018, 6: 50693–50708. doi: 10.1109/ACCESS.2018.2869289 [73] WANG Haipeng, XU Feng, and CHEN Shanshan. Saliency detector for SAR images based on pattern recurrence[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2016, 9(7): 2891–2900. doi: 10.1109/JSTARS.2016.2521709 [74] NI Weiping, MA Long, YAN Weidong, et al. Background context-aware-based SAR image saliency detection[J]. IEEE Geoscience and Remote Sensing Letters, 2018, 15(9): 1392–1396. doi: 10.1109/LGRS.2018.2838151 [75] HOU Biao, YANG Wei, WANG Shuang, et al. SAR image ship detection based on visual attention model[C]. 2013 IEEE International Geoscience and Remote Sensing Symposium, Melbourne, Australia, 2013: 2003–2006. [76] WANG Zhaocheng, DU Lan, ZHANG Peng, et al. Visual attention-based target detection and discrimination for high-resolution SAR images in complex scenes[J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(4): 1855–1872. doi: 10.1109/TGRS.2017.2769045 [77] ZHAI Liang, LI Yu, and SU Yi. Inshore ship detection via saliency and context information in high-resolution SAR images[J]. IEEE Geoscience and Remote Sensing Letters, 2016, 13(12): 1870–1874. doi: 10.1109/LGRS.2016.2616187 [78] LI Lu, DU Lan, and WANG Zhaocheng. Target detection based on dual-domain sparse reconstruction saliency in SAR images[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2018, 11(11): 4230–4243. doi: 10.1109/JSTARS.2018.2874128 [79] TU Song and SU Yi. Fast and accurate target detection based on multiscale saliency and active contour model for high-resolution SAR images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(10): 5729–5744. doi: 10.1109/TGRS.2016.2571309 [80] MARINO A, SANJUAN-FERRER M J, HAJNSEK I, et al. Ship detection with spectral analysis of synthetic aperture radar: A comparison of new and well-known algorithms[J]. Remote Sensing, 2015, 7(5): 5416–5439. doi: 10.3390/rs70505416 [81] ARNAUD A. Ship detection by SAR interferometry[C]. IEEE 1999 International Geoscience and Remote Sensing Symposium, Hamburg, Germany, 1999: 2616–2618. [82] LENG Xiangguang, JI Kefeng, ZHOU Shilin, et al. Ship detection based on complex signal kurtosis in single-channel SAR imagery[J]. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(9): 6447–6461. doi: 10.1109/TGRS.2019.2906054 [83] EL-DARYMLI K, MOLONEY C, GILL E W, et al. Nonlinearity and the effect of detection on single-channel synthetic aperture radar imagery[C]. Proceedings of Oceans 14, Taipei, China, 2014: 1–7. [84] EL-DARYMLI K, MCGUIRE P, GILL E W, et al. Characterization and statistical modeling of phase in single-channel synthetic aperture radar imagery[J]. IEEE Transactions on Aerospace and Electronic Systems, 2015, 51(3): 2071–2092. doi: 10.1109/TAES.2015.140711 [85] LENG Xiangguang, JI Kefeng, ZHOU Shilin, et al. Fast shape parameter estimation of the complex generalized gaussian distribution in SAR images[J]. IEEE Geoscience and Remote Sensing Letters, (in press). doi: 10.1109/LGRS.2019.2960095 [86] LENG Xiangguang, JI Kefeng, ZHOU Shilin, et al. Discriminating ship from radio frequency interference based on noncircularity and non-gaussianity in Sentinel-1 SAR imagery[J]. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(1): 352–363. doi: 10.1109/TGRS.2018.2854661 [87] ZHANG Zhimian, WANG Haipeng, XU Feng, et al. Complex-valued convolutional neural network and its application in polarimetric SAR image classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(12): 7177–7188. doi: 10.1109/TGRS.2017.2743222 [88] BURL M C, OWIRKA G J, and NOVAK L M. Texture discrimination in synthetic aperture radar imagery[C]. The Twenty-Third Asilomar Conference on Signals, Systems and Computers, Pacific Grove, USA, 1989: 399–404. [89] GAO Gui. An improved scheme for target discrimination in high-resolution SAR images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2011, 49(1): 277–294. doi: 10.1109/TGRS.2010.2052623 [90] 刘轩, 王卫红, 唐晓斌, 等. 遗传算法在SAR图像目标鉴别特征选择上的应用[J]. 电子科技, 2014, 27(5): 140–144. doi: 10.3969/j.issn.1007-7820.2014.05.041LIU Xuan, WANG Weihong, TANG Xiaobin, et al. Feature selection for target discrimination in SAR images based on genetic algorithm[J]. Electronic Science and Technology, 2014, 27(5): 140–144. doi: 10.3969/j.issn.1007-7820.2014.05.041 [91] 李礼. SAR目标检测与鉴别算法研究及软件设计[D]. [硕士论文], 西安电子科技大学, 2013.LI Li. Research on SAR target detection and discrimination algorithms and software design[D]. [Master dissertation], Xidian University, 2013. [92] AMOON M, REZAI-RAD G A, and DALIRI M R. PSO-based optimal selection of zernike moments for target discrimination in high-resolution SAR imagery[J]. Journal of the Indian Society of Remote Sensing, 2014, 42(3): 483–493. doi: 10.1007/s12524-013-0344-6 [93] 陈琪, 陆军, 王娜, 等. 一种基于SAR图像鉴别的港口区域舰船目标新方法[J]. 宇航学报, 2011, 32(12): 2582–2588. doi: 10.3873/j.issn.1000-1328.2011.12.017CHEN Qi, LU Jun, WANG Na, et al. An SAR images-based new method for ship discrimination in harbor region[J]. Journal of Astronautics, 2011, 32(12): 2582–2588. doi: 10.3873/j.issn.1000-1328.2011.12.017 [94] 王斐. 特征变换方法及其在SAR目标鉴别上的应用[D]. [硕士论文], 西安电子科技大学, 2014.WANG Fei. Feature transformation with applications to SAR target discrimination[D]. [Master dissertation], Xidian University, 2014. [95] DU Lan, DAI Hui, WANG Yan, et al. Target discrimination based on weakly supervised learning for high-resolution sar images in complex scenes[J]. IEEE Transactions on Geoscience and Remote Sensing, 2020, 58(1): 461–472. doi: 10.1109/TGRS.2019.2937175 [96] WANG Zhaocheng, DU Lan, and SU Hongtao. Superpixel-level target discrimination for high-resolution SAR images in complex scenes[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2018, 11(9): 3127–3143. doi: 10.1109/JSTARS.2018.2850043 [97] WANG Ning, WANG Yinghua, LIU Hongwei, et al. Feature-fused SAR target discrimination using multiple convolutional neural networks[J]. IEEE Geoscience and Remote Sensing Letters, 2017, 14(10): 1695–1699. doi: 10.1109/LGRS.2017.2729159 [98] WANG Yan, DU Lan, and DAI Hui. Target discrimination method for SAR images based on semisupervised co-training[J]. Journal of Applied Remote Sensing, 2018, 12(1): 015004. [99] DU Lan, WANG Yan, XIE Weitong, et al. A semisupervised infinite latent Dirichlet allocation model for target discrimination in SAR images with complex scenes[J]. IEEE Transactions on Geoscience and Remote Sensing, 2020, 58(1): 666–679. doi: 10.1109/TGRS.2019.2939001 [100] DENG Li. The MNIST database of handwritten digit images for machine learning research[Best of the Web][J]. IEEE Signal Processing Magazine, 2012, 29(6): 141–142. doi: 10.1109/MSP.2012.2211477 [101] CARVALHO E F and ENGEL P M. Convolutional sparse feature descriptor for object recognition in CIFAR-10[C]. 2013 Brazilian Conference on Intelligent Systems, Fortaleza, Brazil, 2013: 131–135. [102] DENG Jia, DONG Wei, SOCHER R, et al. ImageNet: A Large-Scale Hierarchical Image Database[C]. 2009 IEEE Conference on Computer Vision and Pattern Recognition, Miami, USA, 2009: 248–255. [103] 杜兰, 刘彬, 王燕, 等. 基于卷积神经网络的SAR图像目标检测算法[J]. 电子与信息学报, 2016, 38(12): 3018–3025. doi: 10.11999/JEIT161032DU Lan, LIU Bin, WANG Yan, et al. Target detection method based on convolutional neural network for SAR image[J]. Journal of Electronics &Information Technology, 2016, 38(12): 3018–3025. doi: 10.11999/JEIT161032 [104] WANG Zhaocheng, DU Lan, MAO Jiashun, et al. SAR target detection based on SSD with data augmentation and transfer learning[J]. IEEE Geoscience and Remote Sensing Letters, 2019, 16(1): 150–154. doi: 10.1109/LGRS.2018.2867242 [105] 王思雨, 高鑫, 孙皓, 等. 基于卷积神经网络的高分辨率SAR图像飞机目标检测方法[J]. 雷达学报, 2017, 6(2): 195–203. doi: 10.12000/JR17009WANG Siyu, GAO Xin, SUN Hao, et al. An aircraft detection method based on convolutional neural networks in high-resolution SAR images[J]. Journal of Radars, 2017, 6(2): 195–203. doi: 10.12000/JR17009 [106] COZZOLINO D, DI MARTINO G, POGGI G, et al. A fully convolutional neural network for low-complexity single-stage ship detection in Sentinel-1 SAR images[C]. 2017 IEEE International Geoscience and Remote Sensing Symposium, Fort Worth, USA, 2017: 886–889. [107] 李健伟, 曲长文, 彭书娟, 等. 基于卷积神经网络的SAR图像舰船目标检测[J]. 系统工程与电子技术, 2018, 40(9): 1953–1959. doi: 10.3969/j.issn.1001-506X.2018.09.09LI Jianwei, QU Changwen, PENG Shujuan, et al. Ship detection in SAR images based on convolutional neural network[J]. Systems Engineering and Electronics, 2018, 40(9): 1953–1959. doi: 10.3969/j.issn.1001-506X.2018.09.09 [108] JIAO Jiao, ZHANG Yue, SUN Hao, et al. A densely connected end-to-end neural network for multiscale and multiscene SAR ship detection[J]. IEEE Access, 2018, 6: 20881–20892. doi: 10.1109/ACCESS.2018.2825376 [109] LIU Lei, CHEN Guowei, PAN Zongxu, et al. Inshore ship detection in SAR images based on deep neural networks[C]. 2018 IEEE International Geoscience and Remote Sensing Symposium, Valencia, Spain, 2018: 25–28. [110] 李健伟, 曲长文, 彭书娟, 等. 基于生成对抗网络和线上难例挖掘的SAR图像舰船目标检测[J]. 电子与信息学报, 2019, 41(1): 143–149. doi: 10.11999/JEIT180050LI Jianwei, QU Changwen, PENG Shujuan, et al. Ship detection in SAR images based on generative adversarial network and online hard examples mining[J]. Journal of Electronics &Information Technology, 2019, 41(1): 143–149. doi: 10.11999/JEIT180050 [111] 孙显, 王智睿, 孙元睿, 等. AIR-SARShip-1.0: 高分辨率SAR舰船检测数据集[J]. 雷达学报, 2019, 8(6): 852–862. doi: 10.12000/JR19097SUN Xian, WANG Zhirui, SUN Yuanrui, et al. AIR-SARShip-1.0: High-resolution SAR ship detection dataset[J]. Journal of Radars, 2019, 8(6): 852–862. doi: 10.12000/JR19097 [112] ZHAO Juanping, GUO Weiwei, ZHANG Zenghui, et al. A coupled convolutional neural network for small and densely clustered ship detection in SAR images[J]. Science China Information Sciences, 2019, 62(4): 42301. doi: 10.1007/s11432-017-9405-6 [113] 陈慧元, 刘泽宇, 郭炜炜, 等. 基于级联卷积神经网络的大场景遥感图像舰船目标快速检测方法[J]. 雷达学报, 2019, 8(3): 413–424. doi: 10.12000/JR19041CHEN Huiyuan, LIU Zeyu, GUO Weiwei, et al. Fast detection of ship targets for large-scale remote sensing image based on a cascade convolutional neural network[J]. Journal of Radars, 2019, 8(3): 413–424. doi: 10.12000/JR19041 [114] DU Lan, LI Lu, WEI Di, et al. Saliency-guided single shot multibox detector for target detection in SAR images[J]. IEEE Transactions on Geoscience and Remote Sensing, (in press). doi: 10.1109/TGRS.2019.2953936 [115] 杜兰, 魏迪, 李璐, 等. 基于半监督学习的SAR目标检测网络[J]. 电子与信息学报, 2020, 42(1): 154–163. doi: 10.11999/JEIT190783DU Lan, WEI Di, LI Lu, et al. SAR target detection network via semi-supervised learning[J]. Journal of Electronics &Information Technology, 2020, 42(1): 154–163. doi: 10.11999/JEIT190783 -

作者中心

作者中心 专家审稿

专家审稿 责编办公

责编办公 编辑办公

编辑办公

下载:

下载: