| [1] |

BURL M C, OWIRKA G J, and NOVAK L M. Texture discrimination in synthetic aperture radar imagery[C]. Twenty-Third Asilomar Conference on Signals, Systems and Computers, Pacific Grove, USA, 1989: 399–400.

|

| [2] |

NOVAK L M, BURL M C, and IRVING W W. Optimal polarimetric processing for enhanced target detection[J]. IEEE Transactions on Aerospace and Electronic Systems, 1993, 29(1): 234–244. doi: 10.1109/7.249129 |

| [3] |

AI Jiaqiu, MAO Yuxiang, LUO Qiwu, et al. Robust CFAR ship detector based on bilateral-trimmed-statistics of complex ocean scenes in SAR imagery: A closed-form solution[J]. IEEE Transactions on Aerospace and Electronic Systems, 2021, 57(3): 1872–1890. doi: 10.1109/TAES.2021.3050654 |

| [4] |

LECUN Y, BOTTOU L, BENGIO Y, et al. Gradient-based learning applied to document recognition[J]. Proceedings of the IEEE, 1998, 86(11): 2278–2324. doi: 10.1109/5.726791 |

| [5] |

GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]. 2014 IEEE Conference on Computer Vision and Pattern Recognition, Columbus, USA, 2014: 580–587.

|

| [6] |

GIRSHICK R. Fast R-CNN[C]. 2015 IEEE International Conference on Computer Vision, Santiago, Chile, 2015: 1440–1448.

|

| [7] |

REN Shaoqing, HE Kaiming, GIRSHICK R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[C]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137–1149.

|

| [8] |

REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: Unified, real-time object detection[C]. 2016 IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, USA, 2016: 779–788.

|

| [9] |

LIU Wei, ANGUELOV D, ERHAN D, et al. SSD: Single shot MultiBox detector[C]. 14th European Conference on Computer Vision, Amsterdam, The Netherlands, 2016: 21–37.

|

| [10] |

杜兰, 刘彬, 王燕, 等. 基于卷积神经网络的SAR图像目标检测算法[J]. 电子与信息学报, 2016, 38(12): 3018–3025. doi: 10.11999/JEIT161032DU Lan, LIU Bin, WANG Yan, et al. Target detection method based on convolutional neural network for SAR image[J]. Journal of Electronics & Information Technology, 2016, 38(12): 3018–3025. doi: 10.11999/JEIT161032 |

| [11] |

AI Jiaqiu, TIAN Ruitian, LUO Qiwu, et al. Multi-scale rotation-invariant Haar-like feature integrated CNN-based ship detection algorithm of multiple-target environment in SAR imagery[J]. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(12): 10070–10087. doi: 10.1109/TGRS.2019.2931308 |

| [12] |

ZHANG Shaoming, WU Ruize, XU Kunyuan, et al. R-CNN-based ship detection from high resolution remote sensing imagery[J]. Remote Sensing, 2019, 11(6): 631. doi: 10.3390/rs11060631 |

| [13] |

DU Lan, WEI Di, LI Lu, et al. SAR target detection network via semi-supervised learning[J]. Journal of Electronics & Information Technology, 2020, 42(1): 154–163. doi: 10.11999/JEIT190783 |

| [14] |

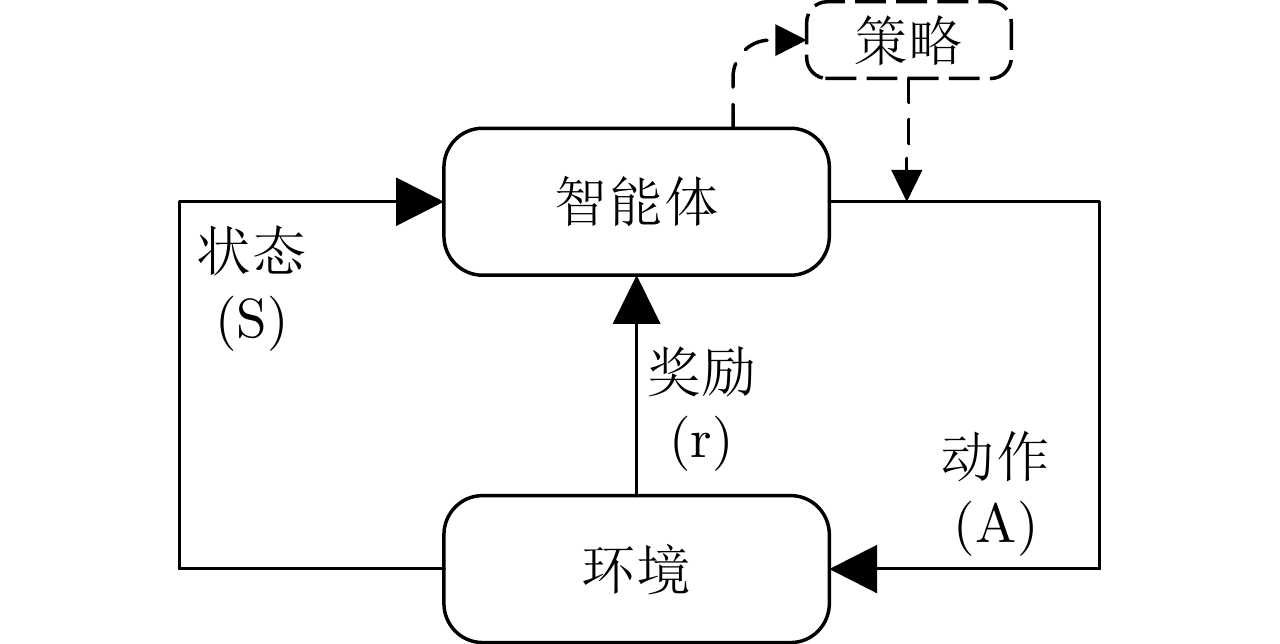

SUTTON R S and BARTO A G. Reinforcement Learning: An Introduction[M]. 2nd ed. Cambridge: MIT Press, 2018: 1–526.

|

| [15] |

CHUNG J. Playing Atari with deep reinforcement learning[J]. arXiv: 1312.5602.

|

| [16] |

BUENO M B, GIRO-I-NIETO X, MARQUÉS F, et al. Hierarchical Object Detection with Deep Reinforcement Learning[M]. HEMANTH D J and ESTRELA V V. Deep Learning for Image Processing Applications. 2017: 164–1276.

|

| [17] |

CAICEDO J C and LAZEBNIK S. Active object localization with deep reinforcement learning[C]. 2015 IEEE International Conference on Computer Vision, Santiago, Chile, 2015: 2488–2496.

|

| [18] |

PIRINEN A and SMINCHISESCU C. Deep reinforcement learning of region proposal networks for object detection[C]. 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, Salt Lake City, USA, 2018: 6945–6954.

|

| [19] |

CHUNG J, GULCEHRE C, CHO K H, et al. Empirical evaluation of gated recurrent neural networks on sequence modeling[J]. arXiv: 1412.3555, 2014.

|

| [20] |

WILLIAMS R J. Simple statistical gradient-following algorithms for connectionist reinforcement learning[J]. Machine Learning, 1992, 8(3/4): 229–256. doi: 10.1023/A:1022672621406 |

| [21] |

KINGMA D P and BA J. Adam: A method for stochastic optimization[C]. 3rd International Conference on Learning Representations, San Diego, USA, 2015.

|

| [22] |

|

| [23] |

AI Jiaqiu, MAO Yuxiang, LUO Qiwu, et al. SAR target classification using the multikernel-size feature fusion-based convolutional neural network[J]. IEEE Transactions on Geoscience and Remote Sensing, 2021, 60: 5214313. doi: 10.1109/TGRS.2021.3106915 |

| [24] |

魏迪. 基于半监督卷积神经网络的SAR图像目标检测方法研究[D]. [硕士论文], 西安电子科技大学, 2020.

WEI Di. The research on target detection of SAR image based on semi-supervised convolutional neural network[D]. [Master dissertation], Xidian University, 2020.

|

| [25] |

WOO S, PARK J, LEE J Y, et al. CBAM: Convolutional block attention module[C]. 15th European Conference on Computer Vision, Munich, Germany, 2018: 3–19.

|

Submit Manuscript

Submit Manuscript Peer Review

Peer Review Editor Work

Editor Work

DownLoad:

DownLoad: