② (中国科学院大学 北京 100190)

② (University of Chinese Academy of Sciences, Beijing 100190, China)

目标重建是合成孔径雷达(Synthetic Aperture Radar, SAR)[1]图像解译的重要应用之一,该应用能够获取目标的姿态、尺寸、轮廓等信息。这些信息能够用在图像解译的其他应用中,如目标检测、目标识别,从而提高目标解译精度,因此目标重建具有重要的研究意义。

然而,在SAR图像中,目标表现为一些强散射点,因此可以利用的信息和特征有限。我们难以像光学目标解译一样利用目标的纹理和轮廓等传统特征信息实现计算机辅助SAR目标解译。研究表明,人类在SAR图像目标解译的过程中通常会借助于先验知识。因此,合理地利用先验信息对于计算机辅助SAR图像目标解译是至关重要的。

其中,如何将先验知识表达为合理的数学表示是亟需解决的难题。研究人员利用的先验信息主要包括强散射点的分布规律,强散射点的强度分布规律,目标形状信息等。在此基础上,Chen等人[2]提出了一种基于关键点检测和特征匹配策略的SAR飞机目标识别方法,该方法将强散射点视为一种关键点特征,然后利用强散射点的分布信息使用模板匹配策略进行目标识别。Chang和Tang等人[3,4]通过SAR图像仿真,研究SAR散射特征规律,从而实现SAR图像目标识别。这些方法虽然取得了一定的成果,但SAR图像中的散射点信息会随着成像条件和参数等信息的变化而变化,并且仅利用散射点难以获得鲁棒的结果。Zhang等人[5]提出了一种自上而下的SAR图像房屋目标重建的方法,该方法成功地将房屋屋顶形状先验融入到目标重建模型中,获得了很好的实验结果。在SAR图像中,我们可以利用强散射点和目标形状对目标进行重建,与单纯利用散射点相比,这类方法的解译鲁棒性较高。然而,对于房屋屋顶这类形状较为简单的目标,我们可以用较为简单的数学模型进行表达,但是对于飞机这类结构较为复杂的目标,形状先验建模较为困难。在SAR图像目标解译研究中,深度学习模型已被广泛用于目标检测[6]、目标提取[7]、目标识别[8,9]等应用中,并取得了很好的解译性能。本文为了解决以上问题,将深度学习模型用于SAR飞机目标形状先验建模中,提出了一种基于深度形状先验的SAR飞机目标重建方法,其主要的创新点和贡献总结如下:

首先,本文引入了深度学习建模方法解决飞机这类复杂目标的形状建模问题,这是SAR图像目标重建过程中第1次引入深度模型建模的形状约束。其中,产生式的深度玻尔兹曼机(Deep Boltzmann Machine, DBM)[10]用来建模飞机目标形状的全局和局部结构以及形状变化。该深度形状先验将由深度玻尔兹曼机的参数来表示,在目标重建阶段,这些参数将被作为形状约束项融入图像能量函数中。

其次,飞机目标在机场中的停靠角度不同,因此SAR图像中的飞机目标存在旋转问题,给目标重建带来了一定的困难。为此,本文提出了一种姿态估计策略,该策略在目标重建之前提出一种姿态估计方法获取候选姿态,并在目标重建中融入局部姿态估计技巧。其中,姿态估计方法分为两步,在粗姿态估计中,我们利用变换不变低秩纹理(Transform Invariant Low-rank Textures, TILT)方法[11]将目标的姿态限定在8个特定的数值中,对应4种对称方式;在精细姿态估计中,变换后的图像利用图像相关性分析方法确定目标的对称方式,得到两个特定的候选姿态。局部姿态估计将姿态变换参数融入能量函数中并采用梯度下降法进行优化。该策略能够有效解决对目标姿态进行穷举搜索而导致的目标重建效率低下问题,并能够提高目标重建的精度。

再次,如何将深度形状先验融入目标重建中是解译的难题,为此本文引入了一种目标重建框架,该框架分为两个主要的步骤。第1步,通过姿态估计得到候选姿态,然后确定候选深度形状先验作为目标重建中的形状先验。第2步,通过融合形状能量项和散射能量项构造目标重建的能量函数。在能量函数优化中,本文采用了基于近似推断和Split Bregman算法的迭代优化方法[12]。

为了验证本文方法的有效性,我们在分辨率为0.5 m和1.0 m的TerraSAR-X数据集上进行目标重建实验。实验结果表明,该方法能够以较高的精度实现SAR飞机目标的重建。此外,我们将该方法与基于轮廓分割的传统方法进行比较,结果显示深度形状先验的使用极大地提高了目标重建的精度。

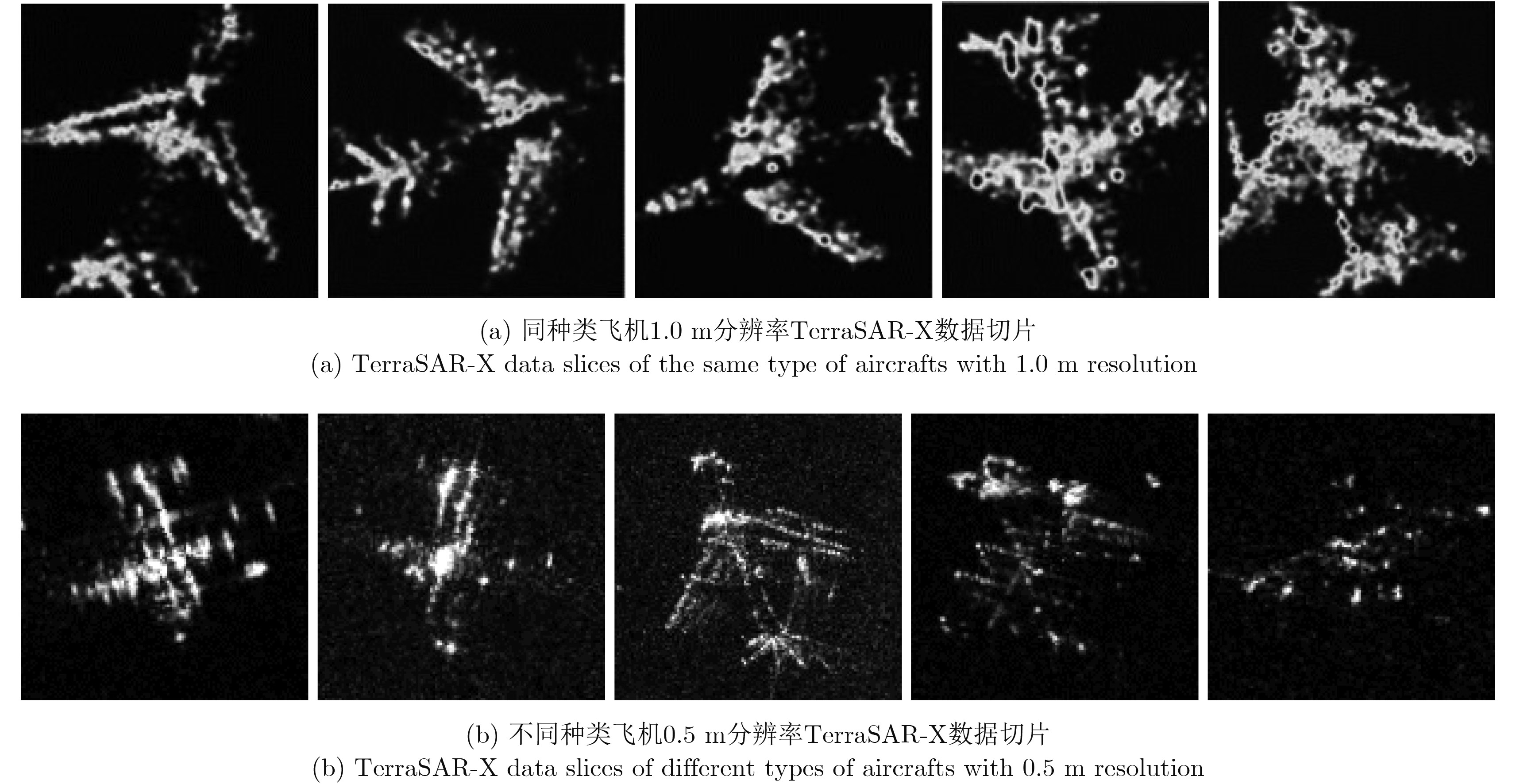

2 数据描述与分析在机场中,飞机停靠角度并不固定。如图1所示,不同目标类型和目标姿态的测试切片来源于0.5 m和1.0 m分辨率的TerraSAR-X图像。分析可知,数据集中的目标姿态多样,具有丰富的目标细节信息,同时也有噪声的干扰。例如,飞机的头部、两翼和尾部等结构清晰,肉眼可区分,这是飞机目标重建的基础。但是,这些部件的部分区域,如机身、两翼等散射特征不明显。因此形状先验成为有缺失或有噪声切片中目标重建的重要信息,能够辅助获取完整的目标轮廓。

|

图 1 TerraSAR-X数据集部分切片展示 Fig.1 Part of the TerraSAR-X data set |

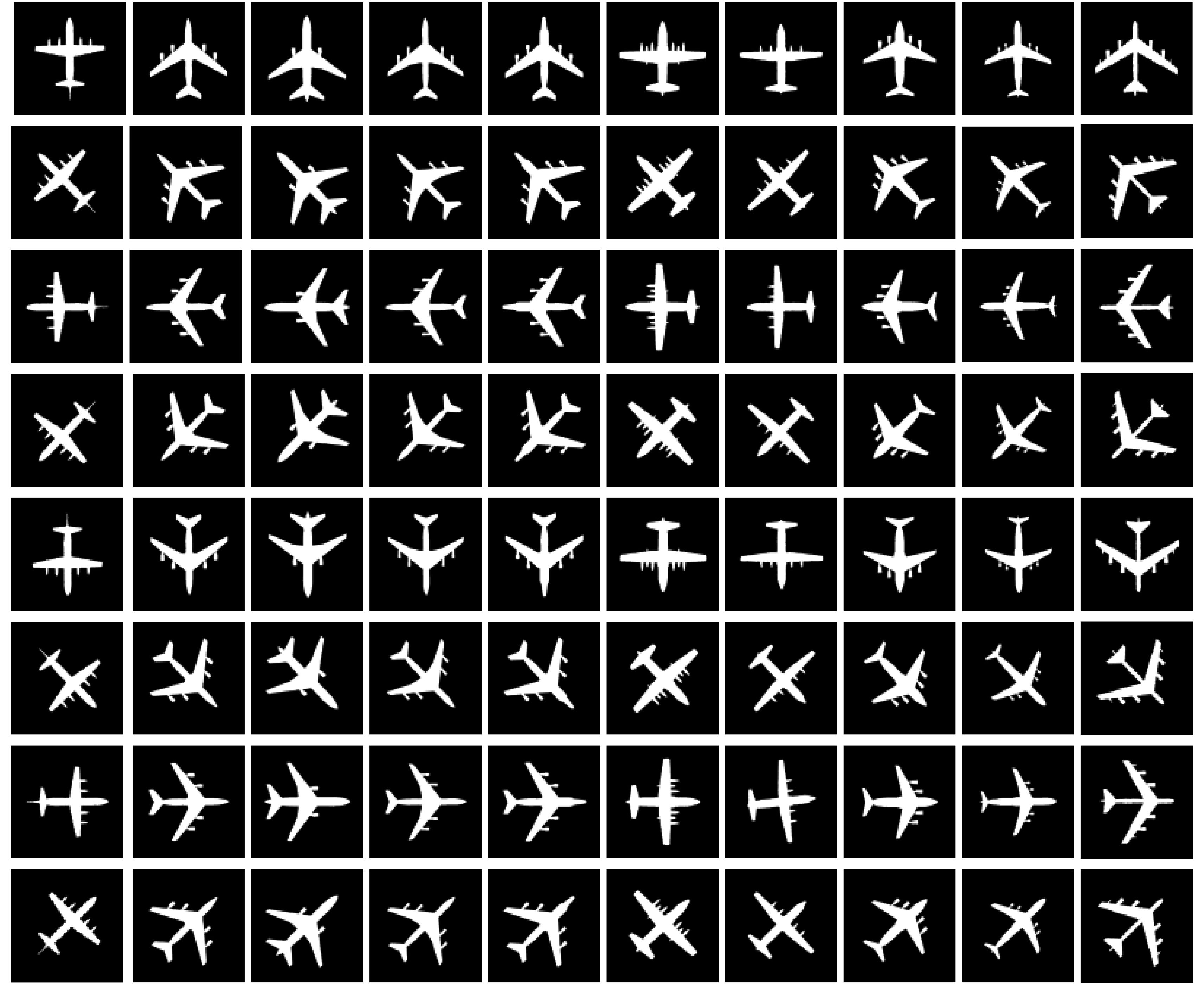

实验使用的形状模板数据集包含10类飞机目标,共8组对应8个角度;测试数据集是从Terra SAR-X图像中获取的约100幅数据切片,分辨率为1.0 m或0.5 m。如图2所示,本文利用的形状先验是飞机目标的黑白二值模板。图中从上而下依次对应目标角度0°, 315°, 270°, 225°, 180°, 135°, 90°和45°,其中机头朝上为0°,按顺时针方向递增。从模板数据分析可得,飞机目标具有相似的十字交叉结构,以及不同的尺寸和部件外观,如两翼后掠角、发动机的有无和分布、头部的形状等。这些明显的结构相似性和结构差异性的存在使得通过多层神经网络对这些形状模板进行建模是有效的。

|

图 2 8种特定角度下10种不同种类的飞机目标黑白二值模板(从上到下角度依次是0°, 315°, 270°, 225°, 180°, 135°, 90°和45°) Fig.2 Original black and white binary templates of ten types of aircrafts in 8 different poses (Poses, from top to bottom, are 0°, 315°, 270°, 225°, 180°, 135°, 90° and 45°) |

本文中,我们利用深度玻尔兹曼机预先训练图2所示的形状模板集合获取深度形状先验模型的参数,8个角度对应8组深度形状模型参数。这些预先得到的参数集合将作为形状先验候选集合,并利用姿态估计结果选择候选形状先验构造图像能量函数的形状能量项。

3 形状先验模型学习在目标解译领域中,形状是一种典型特征,能够用来表征目标的不同结构,也可以用来表征某一类目标的细节结构。研究表明,产生式形状先验模型,能够产生真实样本。因此,深度玻尔兹曼机能够用于形状先验建模并产生形状样本域中有别于训练集形状样本的真实形状[13]。

一般而言,图像的分辨率已知,这意味着形状的尺寸是固定的,因此我们只需要对形状进行对齐操作。本文采用了Liu等人[14]的方法实现二值形状模板的重心对齐操作。重心的计算公式如下:

| ${x_{\rm{c}}} = \frac{{\displaystyle\sum\limits_{i = 1}^m {\sum\limits_{j = 1}^n {{x_{i,j}}S({x_{i,j}})} } }}{{\displaystyle\sum\limits_{i = 1}^m {\sum\limits_{j = 1}^n {S({x_{i,j}})} } }}, \ {y_{\rm{c}}} = \frac{{\displaystyle\sum\limits_{i = 1}^m {\sum\limits_{j = 1}^n {{y_{i,j}}S({y_{i,j}})} } }}{{\displaystyle\sum\limits_{i = 1}^m {\sum\limits_{j = 1}^n {S({y_{i,j}})} } }}$ | (1) |

其中,

| $\left. \begin{array}{l}{s_x} = {\left( {\frac{{\displaystyle\sum\limits_{i = 1}^m {\sum\limits_{j = 1}^n {{{({x_{i,j}} - {x_{\rm{c}}})}^2}S({x_{i,j}})} } }}{{\displaystyle\sum\limits_{i = 1}^m {\sum\limits_{j = 1}^n {S({x_{i,j}})} } }}} \right)^{\scriptsize\displaystyle\frac{1}{2}}}\\{s_y} = {\left( {\frac{{\displaystyle\sum\limits_{i = 1}^m {\sum\limits_{j = 1}^n {{{({y_{i,j}} - {y_{\rm{c}}})}^2}S({y_{i,j}})} } }}{{\displaystyle\sum\limits_{i = 1}^m {\sum\limits_{j = 1}^n {S({y_{i,j}})} } }}} \right)^{\scriptsize\displaystyle\frac{1}{2}}}\end{array} \right\}$ | (2) |

其中,尺度对齐参数用

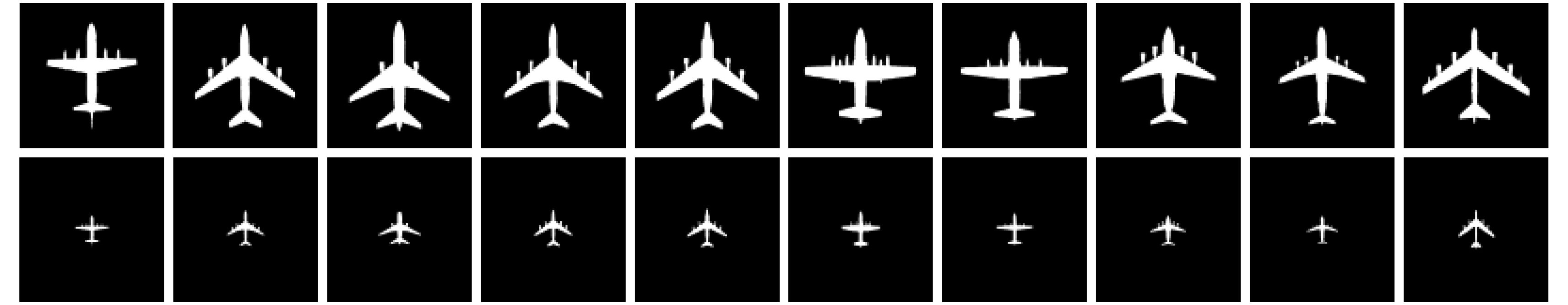

|

图 3 形状对齐结果(第1行和第2行分别表示0°姿态下原始形状模板和形状对齐后的结果图像) Fig.3 Results of shape alignment (The first and second rows represent the original templates and the results of shape alignment respectively) |

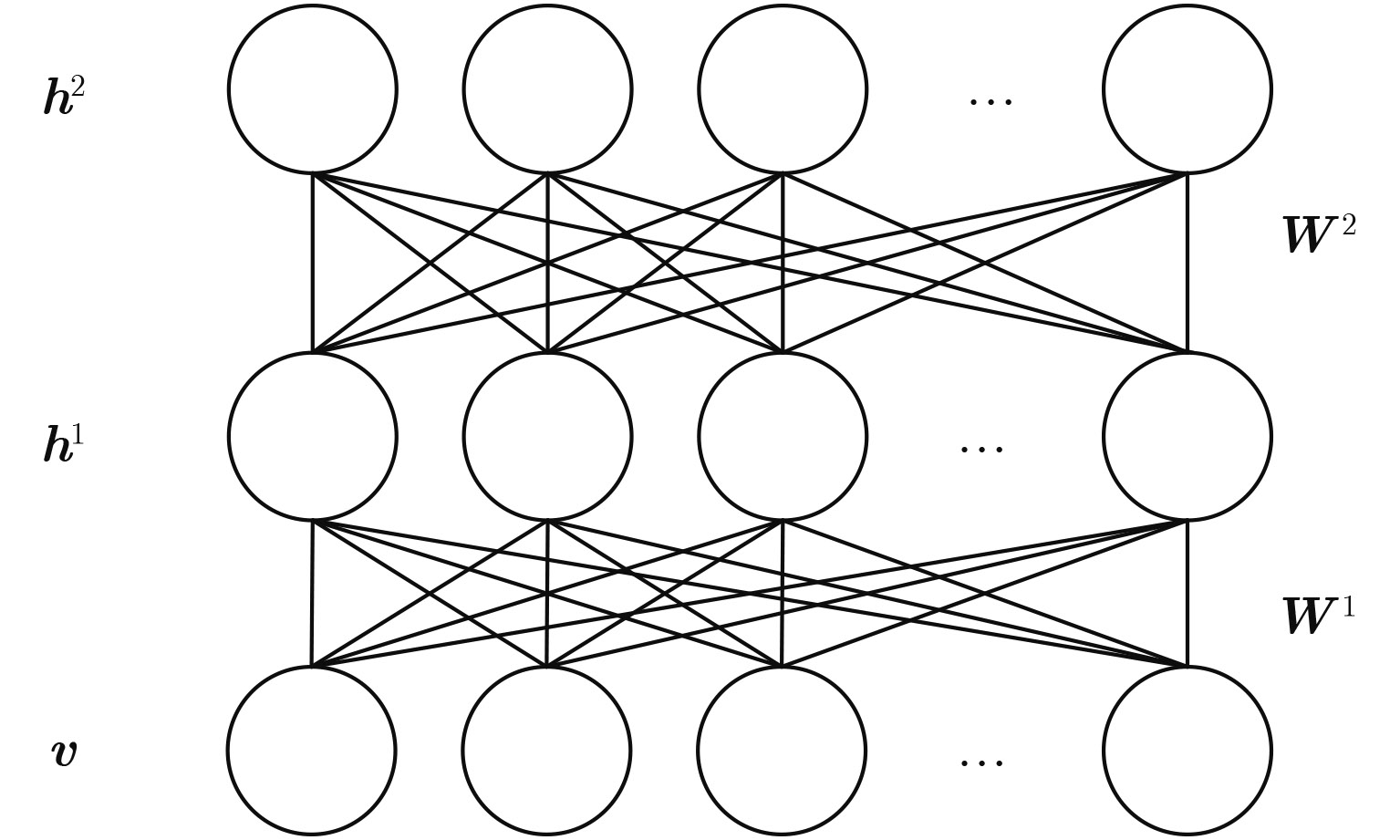

深度玻尔兹曼机是一种产生式的深度模型,模板数据在形状对齐之后输入到3层的深度玻尔兹曼机网络中进行深度形状先验建模,并利用吉布斯采样近似推断方法实现该形状先验模型的预训练,该方法的具体实现原理和步骤请参见[10,15]。该模型结构如图4所示,其中隐藏层节点h1, h2数目均设定为100, W1, W2表示层之间的权重参数。预训练结束后,深度玻尔兹曼机的参数能够用于表征形状模板的局部和全局的结构特征,在目标重建中这些参数将作为形状约束融入到图像能量函数中。

|

图 4 3层深度玻尔兹曼机网络结构 Fig.4 The structure of three-layered deep Boltzmann machine |

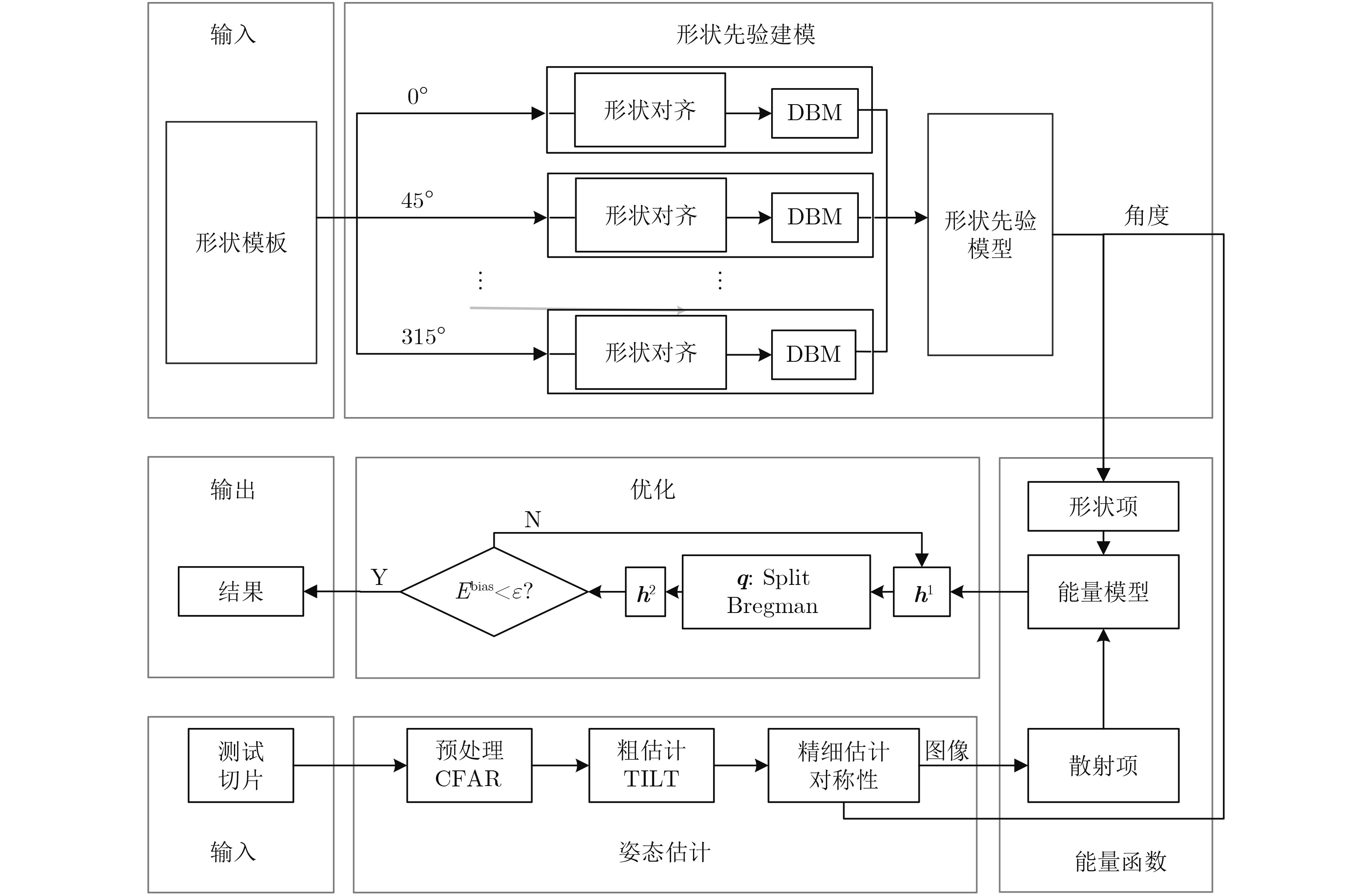

本文提出的方法框架如图5所示,该框架主要分为3个部分。在深度形状先验建模中,深度形状先验通过深度玻尔兹曼机训练得到的参数进行表征,并作为目标重建阶段中的形状约束;在姿态估计阶段,由粗到细的姿态估计方法确定两个候选的姿态,该方法使本文提出的目标重建框架对目标旋转具有较高的鲁棒性;在目标重建阶段,通过融合候选姿态选取的深度形状先验作为形状能量项与姿态估计之后得到的散射能量项构造能量函数,并利用基于近似推断和Split Bregman的迭代优化算法进行能量函数的优化,从而实现目标重建。

|

图 5 本文方法的流程图 Fig.5 The framework of the proposed aircraft reconstruction method |

为了解决目标旋转问题,本文提出了一种由粗到细的姿态估计方法。该方法通过对称变化和对称性检测将目标的姿态限制为两个特定值,其原理是左右对称、上下对称、主对角线对称、副对角线对称分别对应0°和180°, 90°和270°, 135°和315°, 45°和225°,即一种对称方式对应两个角度,且二者之间相差180°。基于上述原理,近似对称图像可以通过变换不变低秩纹理算法变换为上述4种对称模式之一,变换得到的图像记为X,并作为目标重建部分的输入。

粗估计中的对称变换操作仅能够将目标姿态限定在上述8个角度中。如上所述,目标在切片中一般不处于中心位置。因此,在本文的精细估计中,我们利用对称变换和平移变换将图像矩阵X变换为XS,D,随后通过相关系数公式计算二者的相关性,相关性最大的一组变换参数即目标的对称模式和平移距离,对称模式对应的角度即为候选角度。结合上述过程的描述,定义计算公式如下:

| $v(S,D) = \mathop {\max }\limits_S^4 \left\{ {\mathop {\max }\limits_{D = - N}^N {\Big |}{\rm corr}\left( {{X},{{X}_{S,D}}} \right){\Big |}} \right\}$ | (3) |

其中,

如图5所示,变量h1, h2和q分别表示深度玻尔兹曼机第1个隐层和第2个隐层,以及目标形状。DBM和TILT为深度玻尔兹曼机和变换不变低秩纹理的缩写形式。在姿态估计中输入的测试切片利用恒虚警率算法[16]实现背景噪声的去除,该预处理操作能够抑制噪声对重建精度的影响。姿态估计阶段的输出包括目标候选姿态和变换后图像,二者将与形状先验模型一起输入到能量函数中。我们利用候选姿态从深度形状先验集合中选择特定的深度形状先验作为待构造的图像能量的形状先验项,而变换后的图像则通过定义散射区域项和强散射点边缘项构造SAR图像能量函数的目标散射项。本文采用的图像能量函数将以经典的概率形状表示法[15,17]为基础,并融入形状先验项和目标散射项来进行修改和增强,其函数表达式如下:

| $\begin{array}{c}E({q},{{h}^{{1}}},{{h}^{{2}}},φ ;{Θ} ) = \underbrace {\parallel \! \nabla {q}\!{\parallel _{\rm{e}}} + \alpha {{q}^{\rm T}}{s}}_{{\rm{scattering {\scriptsize{-}} term}}} - \underbrace {\beta ({{q}^{\rm T}}{W}_φ^1{{h}^1} + {{h}^1}^{^{\large\rm{T}}}{{W}^2}{{h}^2} + {{a}^1}^{^{\large\rm T}}{{h}^1} + {{a}^2}^{^{\large\rm T}}{{h}^2} + {{q}^{\rm T}}{b})}_{{\rm{shape {\scriptsize{-}} term}}}\end{array}$ | (4) |

其中,形状模型参数

| $φ = \left[\!\! {\begin{array}{*{20}{c}}1&0&x\\0&1&y\end{array}} \!\!\right]\left[\!\! {\begin{array}{*{20}{c}}h&0&0\\0&h&0\\0&0&1\end{array}} \!\!\right]\left[ \!\!{\begin{array}{*{20}{c}}{\cos \theta }&{ - \sin \theta }&0\\{\sin\theta }&\quad {\cos \theta }&0\\0&\quad 0&1\end{array}} \!\!\right]$ | (5) |

其中,局部变换参数

目标散射项中的

| $\parallel \nabla {q}{\parallel _{\rm{e}}} = \int_{Ω} {{{r}_{\rm{e}}} \cdot |\nabla {q}|} {\mathop{\rm d}\nolimits} {x}$ | (6) |

目标散射项中的s是区分目标散射区域和背景区域的差异矩阵,其公式定义如下:

| ${s} = {({c_1} - {u})^2} - {({c_2} - {u})^2}$ | (7) |

其中,变量

本节我们将详细介绍函数优化和目标重建过程中的算法,迭代最小化方法被用于能量函数的优化从而获得目标重建结果。在本文函数优化的整个过程中,通过引入深度玻尔兹曼机的近推断方法[15]计算每一个隐层单元,并通过引入Split Bregman算法计算目标形状。算法1详细阐述了能量函数优化的整个过程,算法2则是算法1步骤2 (b)(iii)中目标形状q最优化问题的Split Bregman算法的实现细节(见表1,表2)。

| 表 1 算法1:目标重建中的优化算法 Tab.1 The optimization algorithm in object reconstruction |

| 表 2 算法:算法1步骤2(b)(iii)算法 Tab.2 The algorithm for step 2(b)(iii) in Tab. 1 |

如算法1中的各个步骤所示,我们首先对变量和参数进行初始化,变换参数中,由于数据分辨率已知,因此尺度h初始化为与目标分辨率相关的特定数值;

本文中上述过程将仅仅被执行两次,并从中选择能量函数值较小的一个对应的姿态和目标重建结果作为本文实验的最终结果。

6 实验结果与分析本节展示本文实验结果并对结果进行分析。为了验证基于深度形状先验的目标重建方法框架的有效性,我们在高分辨率SAR图像目标切片中实现飞机目标的重建,在此基础上本节的实验将分为3个部分,首先,由粗到细的姿态估计方法;其次,本文方法与去除形状先验的本文方法和无形状先验的方法,如GraphCut方法[19]的对比结果;最后,本文方法与非深度形状先验方法,如SG-ACM[14]方法的对比结果。

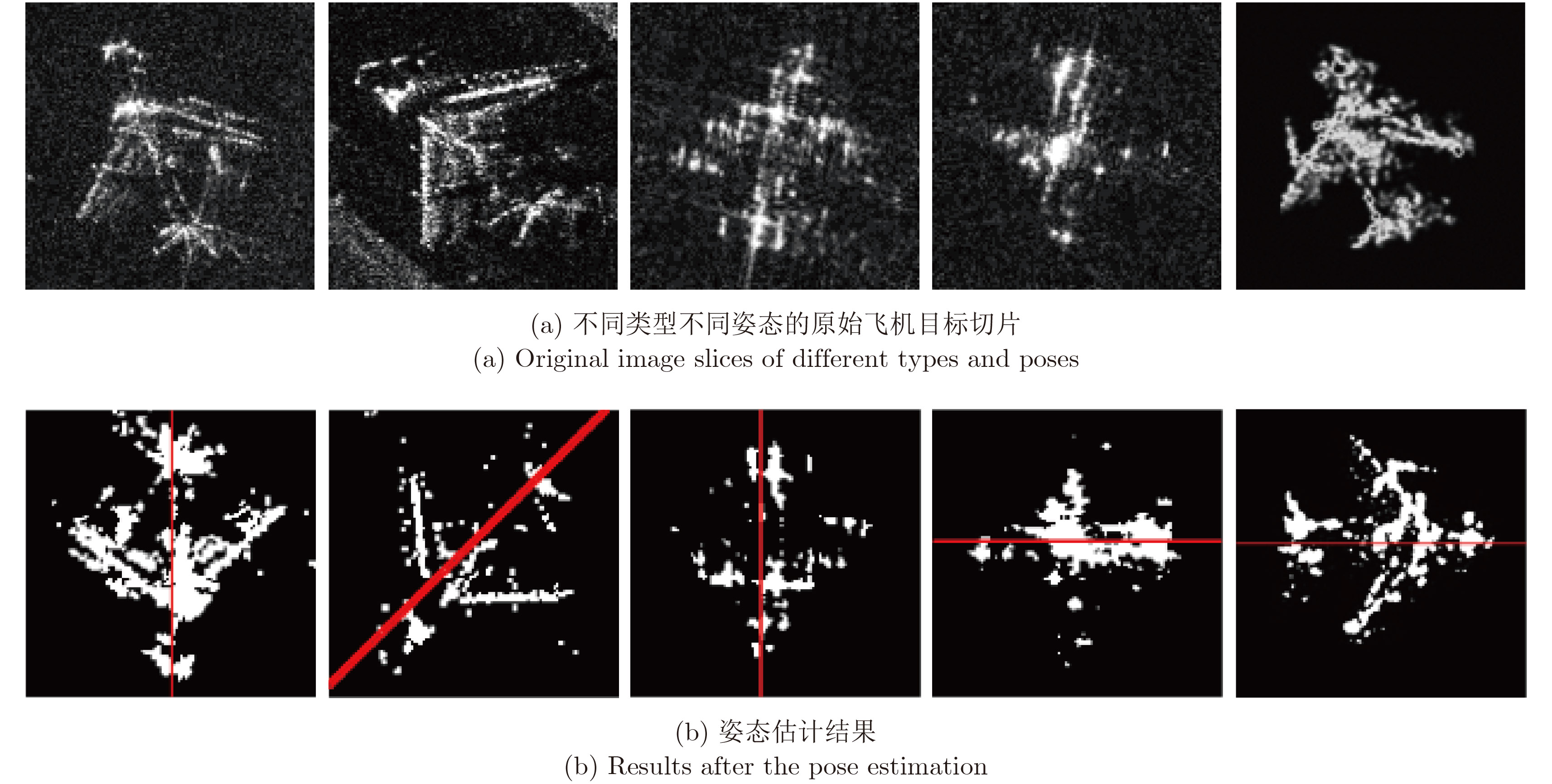

在第1部分的实验中,图6展示的是本文提出的姿态估计方法的实验结果。其中,图6(a)为不同类型和姿态的飞机目标切片,图6(b)是CFAR预处理操作之后进行姿态估计的变换图像,飞机目标均变换到某一对称模式,从而得到两个候选姿态。举例说明,图6(b)第1列的红色实线表示估计得到的目标姿态,对应0°和180°两个候选姿态。后续实验结果表明,该方法简化了目标重建过程,并能够有效解决目标旋转的问题。

|

图 6 姿态估计结果 Fig.6 Results of the pose estimation |

第2部分实验对目标的重建结果进行了定量分析。本文为此从1.0 m和0.5 m分辨率TerraSAR-X项中裁切了100多幅高分辨率飞机目标切片,同时进行人工标注,区分目标区域和背景区域,以便分析目标重建结果的精确性。这些标注后的图像将作为真值与实验结果进行对比。本文采用平均像素误分比[20]作为重建精度的评价标准,其定义如下:

| ${\rm{PMP}} = \left(1 + \frac{{|{B_{\rm{o}}} \cap {B_{\rm{s}}}| + |{F_{\rm{o}}} \cap {F_{\rm{s}}}|}}{{|{B_{\rm{o}}}| + |{F_{\rm o}}|}}\right) \times 100\% $ | (8) |

其中,

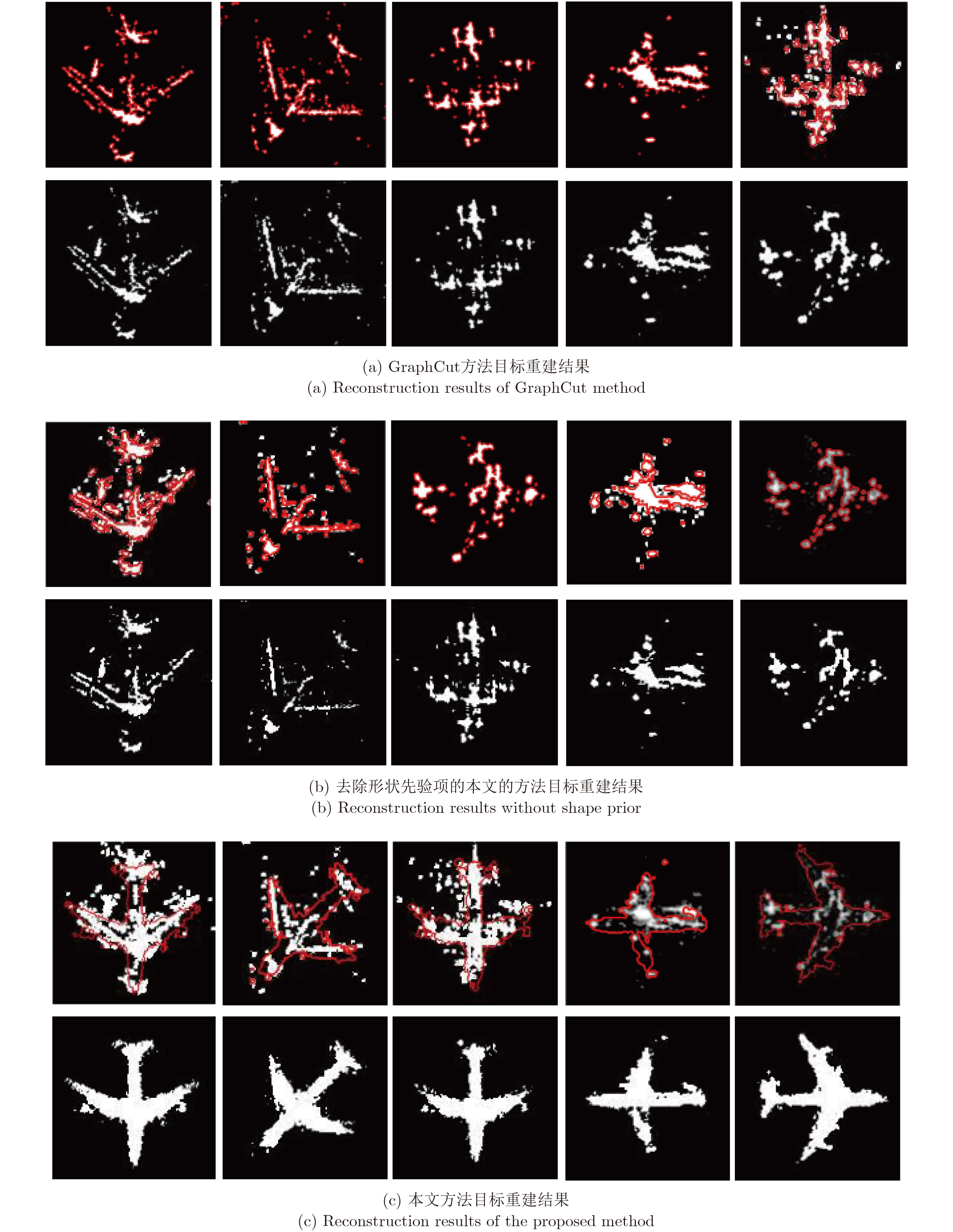

为了验证本文提出的方法框架和形状先验利用的有效性,传统的基于分割GraphCut[19]方法,以及去除先验项的本文的方法将与本文方法进行对比。本节中,我们将从定量和定性两个方面进行实验结果的展示和分析。

为此,表3依次列出了上述两种对比方法和本文方法的重建精确度,图7则更加直观地展示了目标重建的效果,包括目标轮廓图和目标区域图。上述实验结果表明,本文的方法能够准确提取SAR图像中的飞机目标,而GraphCut方法由于无法将SAR图像中目标的强散射点组合起来,从而难以提取出完整的目标轮廓,并且,如果去除形状先验项,本文的方法也将获得与GraphCut方法相近的结果。上述分析表明,本文采用的方法框架和形状先验能够显著地提高目标重建的精确性。另外,如图6所示,本文的姿态估计方法的提出使得目标重建效率很高,并能够用于不同角度数据的目标重建,从而解决了SAR图像中目标旋转的问题。

| 表 3 不同目标重建方法的性能比较 Tab.3 Performance of different reconstruction methods |

|

图 7 不同目标重建方法的结果对比(第1行与第2行分别对应提取目标区域的轮廓图和提取到的目标区域图) Fig.7 Comparison of reconstruction results of different methods (The first and the second rows correspond to the contour of the extracted aircraft area and the extracted aircraft area) |

第3部分实验将验证基于深度学习方法建模形状先验的鲁棒性,本节实验使用的数据与上述实验相同。在该部分实验中,本文方法将与非深度形状先验的SG-ACM方法进行对比,此方法是用主成分分析方法进行形状先验建模。如图8和表3所示,分析可得,SG-ACM方法由于使用了形状先验,因此其重建效果远远好于GraphCut方法和去除形状先验的本文方法,这也验证了形状先验的有效性,但是该方法无法达到本文方法的效果。如上所述SG-ACM方法使用主成分分析方法进行先验建模,实验表明在SAR飞机目标重建应用中,其鲁棒性较差,而本文采用的基于深度学习方法建模形状先验的方法具有较高的鲁棒性。

|

图 8 目标重建结果 Fig.8 Reconstruction results |

另外,SG-ACM不能处理目标旋转的问题,因此,实验中的切片是人工旋转到0°方向的,其效果如图8(a)所示。

7 结束语本文提出了一种基于深度形状先验的高分辨率SAR飞机目标重建方法,该方法主要分为两个阶段。在形状先验建模阶段,本文使用产生式的深度学习方法,深度玻尔兹曼机,对形状模板进行建模,模型训练得到的参数用于表征深度形状先验。在目标重建阶段,本文提出了一种新的目标重建框架。该框架主要分为两步,首先,利用目标的对称特性解决了目标重建中的目标旋转和平移问题实现目标姿态估计,提高了目标重建的效率和精度。然后,由形状能量项和散射能量项组成的能量函数通过深度玻尔兹曼机的近似推断技巧进行迭代函数优化,并在迭代过程中融入了Split Bregman算法解决目标形状的最优化计算。实验结果表明,本文提出的目标重建方法能够以较高的重建准确率得到较为完整的目标形状,同时获取目标的姿态。

在未来的研究中,我们还将研究如何利用目标重建的信息实现目标的识别与检测等应用,同时对形状模板进行扩展。

| [1] |

邓云凯, 赵凤军, 王宇. 星载SAR技术的发展趋势及应用浅析[J].

雷达学报, 2012, 1(1): 1-10. Deng Yunkai, Zhao Fengjun and Wang Yu. Brief analysis on the development and application of spaceborne SAR[J]. Journal of Radars, 2012, 1(1): 1-10. (  0) 0)

|

| [2] |

Chen Jiehong, Zhang Bo and Wang Chao. Backscattering feature analysis and recognition of civilian aircraft in TerraSAR-X images[J].

IEEE Geoscience and Remote Sensing Letters, 2015, 12(4): 796-800. DOI:10.1109/LGRS.2014.2362845 ( 0) 0)

|

| [3] |

Chang Y L, Chiang C Y and Chen K S. SAR image simulation with application to target recognition[J].

Progress in Electromagnetics Research, 2011, 119: 35-57. DOI:10.2528/PIER11061507 ( 0) 0)

|

| [4] |

Tang Kan, Sun Xian, Sun Hao, et al.. A geometrical-based simulator for target recognition in high-resolution SAR images[J].

IEEE Geoscience and Remote Sensing Letters, 2012, 9(5): 958-962. DOI:10.1109/LGRS.2012.2187426 ( 0) 0)

|

| [5] |

Zhang Yue, Sun Xian, Thiele A, et al.. Stochastic geometrical model and Monte Carlo optimization methods for building reconstruction from InSAR data[J].

ISPRS Journal of Photogrammetry and Remote Sensing, 2015, 108: 49-61. DOI:10.1016/j.isprsjprs.2015.06.004 ( 0) 0)

|

| [6] |

王思雨, 高鑫, 孙皓. 基于卷积神经网络的高分辨率SAR图像飞机目标检测方法[J].

雷达学报, 2017, 6(2): 195-203. Wang Siyu, Gao Xin, Sun Hao, et al.. An aircraft detection method based on convolutional neural networks in high-resolution sar images[J]. Journal of Radars, 2017, 6(2): 195-203. (  0) 0)

|

| [7] |

杜康宁, 邓云凯, 王宇. 基于多层神经网络的中分辨SAR图像时间序列建筑区域提取[J].

雷达学报, 2016, 5(4): 410-418. Du Kangning, Deng Yunkai, Wang Yu, et al.. Medium Resolution SAR Image Time-series Built-up Area Extraction Based on Multilayer Neural Network[J]. Journal of Radars, 2016, 5(4): 410-418. (  0) 0)

|

| [8] |

田壮壮, 占荣辉, 胡杰民. 基于卷积神经网络的SAR图像目标识别研究[J].

雷达学报, 2016, 5(3): 320-325. Tian Zhuangzhuang, Zhan Ronghui, Hu Jiemin, et al.. SAR ATR Based on Convolutional Neural Network[J]. Journal of Radars, 2016, 5(3): 320-325. (  0) 0)

|

| [9] |

徐丰, 王海鹏, 金亚秋. 深度学习在SAR目标识别与地物分类中的应用[J].

雷达学报, 2017, 6(2): 136-148. Xu Feng, Wang Haipeng and Jin Yaqiu. Deep learning as applied in sar target recognition and terrain classification[J]. Journal of Radars, 2017, 6(2): 136-148. (  0) 0)

|

| [10] |

Salakhutdinov R and Hinton G. Deep Boltzmann machines[J].

Journal of Machine Learning Research, 2009, 5(2): 448-455. ( 0) 0)

|

| [11] |

Zhang Zhengdong, Liang Xiao, Ganesh A, et al.. TILT: Transform invariant low-rank textures[C]. Proceedings of Asian Conference on Computer Vision, Berlin, Heidelberg, 2010: 314–328.

( 0) 0)

|

| [12] |

Goldstein T, Bresson X and Osher S. Geometric applications of the split bregman method: Segmentation and surface reconstruction[J].

Journal of Scientific Computing, 2010, 45(1): 272-293. ( 0) 0)

|

| [13] |

Eslami S M A, Heess N, Williams C K I, et al.. The shape boltzmann machine: A strong model of object shape[J].

International Journal of Computer Vision, 2014, 107(2): 155-176. DOI:10.1007/s11263-013-0669-1 ( 0) 0)

|

| [14] |

Liu Ge, Sun Xian, Fu Kun, et al.. Interactive geospatial object extraction in high resolution remote sensing images using shape-based global minimization active contour model[J].

Pattern Recognition Letters, 2013, 34(10): 1186-1195. DOI:10.1016/j.patrec.2013.03.031 ( 0) 0)

|

| [15] |

Chen Fei, Yu Huimin, Hu R, et al.. Deep learning shape priors for object segmentation[C]. Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, Portland, OR, USA, 2013: 1870–1877.

( 0) 0)

|

| [16] |

Kuttikkad S and Chellappa R. Non-gaussian CFAR techniques for target detection in high resolution SAR images[C]. Proceedings of IEEE International Conference on Image Processing, Austin, TX, USA, 1994: 910–914.

( 0) 0)

|

| [17] |

Cremers D, Schmidt F R, and Barthel F. Shape priors in variational image segmentation: Convexity, Lipschitz continuity and globally optimal solutions[C]. Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, Anchorage, AK, USA, 2008: 1–6.

( 0) 0)

|

| [18] |

Jones III G and Bhanu B. Recognizing articulated objects in SAR images[J].

Pattern Recognition, 2001, 34(2): 469-485. DOI:10.1016/S0031-3203(99)00218-6 ( 0) 0)

|

| [19] |

Boykov Y Y and Jolly M P. Interactive graph cuts for optimal boundary & region segmentation of objects in N-D images[C]. Proceedings of IEEE International Conference on Computer Vision, Vancouver, BC, Canada, 2001: 105–112.

( 0) 0)

|

| [20] |

Wu Qichang, Diao Wenhui, Dou Fangzheng, et al.. Shape-based object extraction in high-resolution remote-sensing images using deep Boltzmann machine[J].

International Journal of Remote Sensing, 2016, 37(24): 6012-6022. DOI:10.1080/01431161.2016.1253897 ( 0) 0)

|