② (德国宇航局遥感技术研究所 德国韦斯灵 82234)

② (Remote Sensing Technology Institute (IMF), German Aerospace Center (DLR), Wessling 82234, Germany)

合成孔径雷达(Synthetic Aperture Radar, SAR)全天时全天候的优势使其在军用和民用领域中都有着非常广泛的应用。近年来,以卷积神经网络(Convolutional Neural Networks, CNN)[1]为代表的监督学习方法在自然图像理解,如图像分类[2,3]、目标检测[4]、以及自然语言处理[5,6]等领域中取得了显著成功。在SAR图像解译领域,学者们也对CNN应用于SAR图像分类和识别进行了初步尝试[7–13],在MSTAR数据集和地物分类数据集上[12]的测试结果显示CNN能够显著提高SAR目标识别和地物分类的准确率,表明CNN对SAR图像解译同样具有很大潜力。为了解决MSTAR数据规模小和避免过拟合问题,文献[7,10]基于自编码方法进行网络的预训练,文献[11,13]对MSTAR原始数据进行变换来增加样本数量,文献[9]将CNN作为一种特征提取器来提取MSTAR图像深度特征,并结合SVM进行MSTAR车辆目标识别。最近,文献[13]提出了一种全卷积神经网络(A-ConvNets)对MSTAR车辆目标进行识别,识别率达到了99%以上,取得了目前在MSTAR数据集上最好的效果。

虽然CNN在SAR图像分类中取得了较好的效果,但是这种监督学习方法需要大规模、正确标注的训练样本[14]。然而SAR特殊的成像机理(相干成像、主动式、微波波段等)使得图像存在严重的相干斑噪声、几何畸变与结构缺失现象,图像非直观性强、理解难度大,即使经验丰富的判读专家也需要借助丰富的先验信息才能对SAR图像进行准确判读;对于非合作目标,先验信息的缺乏极易导致图像错标。SAR图像中这种观测样本与其标注不一致的现象造成SAR图像解译中的含噪标记问题。在SAR图像分类中,直接使用含噪标记样本进行监督学习,必然会使得分类性能下降、模型复杂度上升和过拟合问题[15]。目前,含噪标记条件下的图像分类问题在计算机视觉和机器学习领域也逐渐引起重视,主要的解决方法是通过改进损失函数的正则化约束项来提高分类器对噪声标记的鲁棒性[15,16],而且这些方法基于人工设计的特征,且特征提取与分类器训练分阶段进行,并不具备特征学习的能力,使得分类性能和对噪声标记的鲁棒性进一步降低。而近年来兴起的CNN等深度模型由于参数多,虽然具有更强特征学习和表达能力,但更容易受到噪声标记的影响。

目前,针对这种SAR图像解译中广泛存在的含噪标记问题还鲜有研究。为解决该问题,克服含噪标记条件下SAR图像的分类识别性能和泛化性能下降问题,本文提出了一种基于概率转移模型的卷积神经网络(Probability Transition CNN, PTCNN)方法,该方法在CNN模型基础上,基于含噪标记与正确标记之间的概率转移模型,建立了噪声标记转移层,构建了一种新的卷积网络模型,其一方面能充分利用CNN较强的图像表征能力,另一方面可潜在地对错误标记进行校正,从而增强了含噪标记条件下CNN模型的鲁棒性,降低了经典CNN方法对训练样本标注质量的要求。本文分别在构建的16类SAR图像地物数据集和美国MSTAR数据集上进行实验,分析了不同噪声比例条件下SAR图像分类性能,并与经典CNN方法和支持向量机(Supported Vector Machine, SVM)算法进行对比,实验结果表明相比于传统模型,本文提出的PTCNN模型具备较好的抗噪性,在含噪标记条件下能够保持较好的分类性能,从而有效降低了SAR图像标注质量对分类器性能的影响。

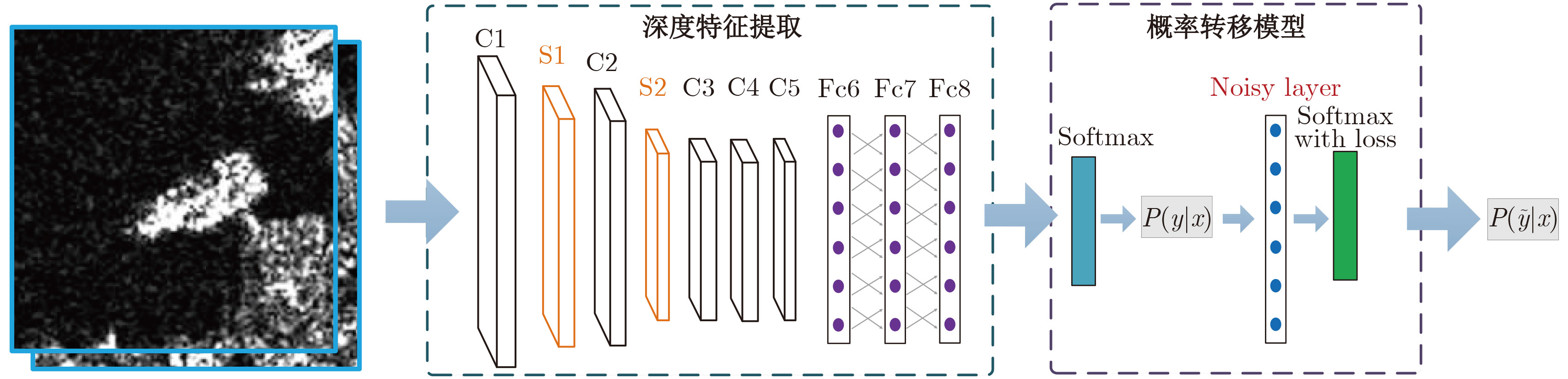

2 网络模型针对含噪标记条件下的SAR图像分类问题,本文PTCNN网络结构如图1所示,该模型主要分为两部分:(1)深度特征提取部分;(2)概率转移模型部分。深度特征提取部分采用经典的CNN模型提取训练样本x的深度特征(图中C1, C2, C3, C4, C5均表示卷积层,S1, S2表示降采样层,Fc6, Fc7, Fc8表示全连接层),概率转移模型通过softmax分类器对深度特征进行分类,提取训练样本真值标注y的后验概率

|

图 1 概率转移卷积神经网络 Fig.1 Probability transition convolutional neural network |

|

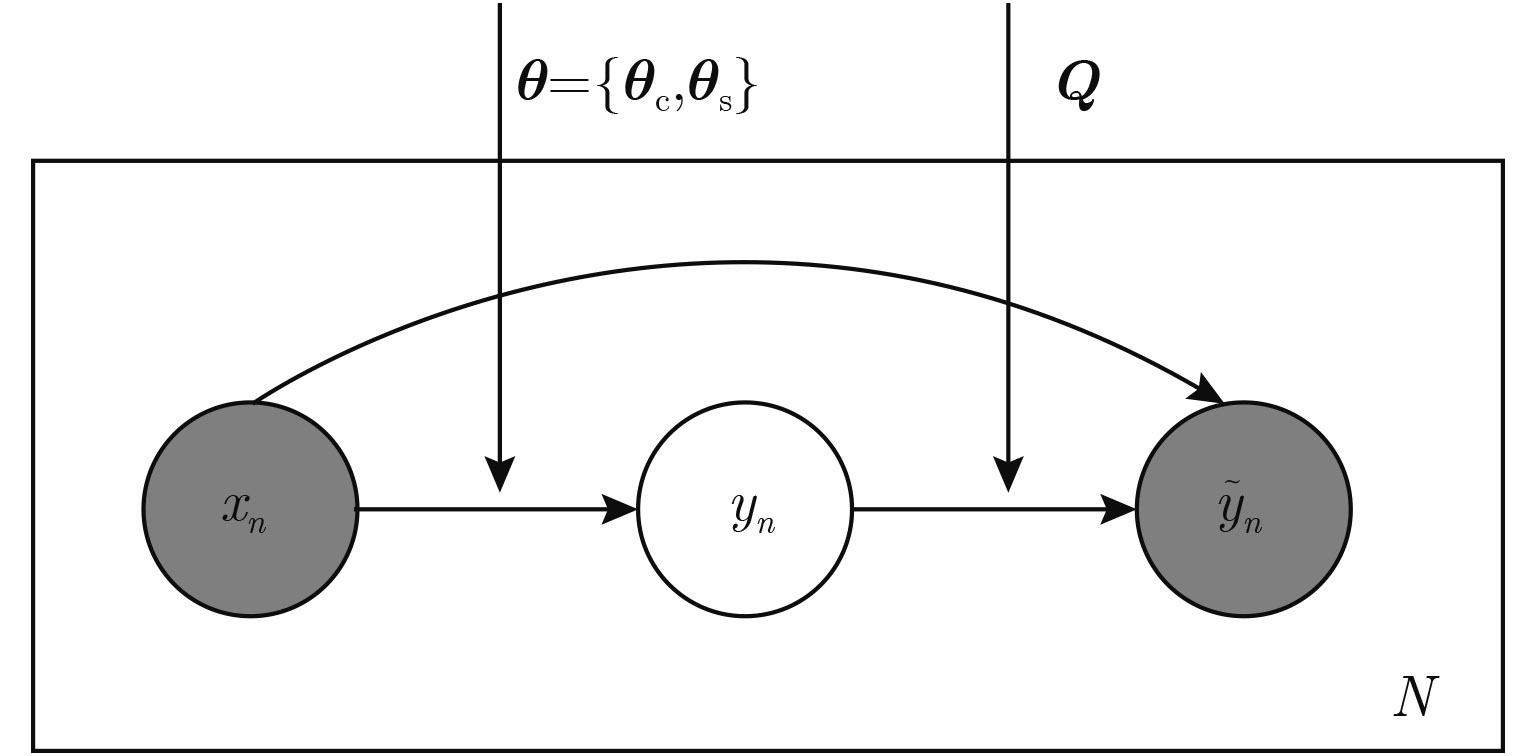

图 2 SAR图像含噪标记模型 Fig.2 Model of SAR image noisy labels |

CNN是一种典型的有监督深度学习方法,其最初是受灵长动物视觉神经机制的启发而设计的一种具有深度学习能力的人工神经网络。CNN直接将原始图像作为网络输入,有效避免了传统算法中的特征提取和数据重建过程,提高了算法效率。但是,CNN并不是一个黑盒子,其内部通过一系列数学运算实现图像表征。

具有局部连接和权值共享特性的卷积层是CNN的核心组成部分,该层每个神经元的输入与前一层的局部感受野(Receptive Field)连接,提取图像局部特征。其中,同一特征图中的神经元提取前一层特征图中不同位置的局部特征,而对单一神经元来说其提取的特征是前一层若干不同特征图中相同位置的局部特征。

为了使神经网络具有非线性拟合能力,需要将卷积等线性运算得到的结果通过一个非线性的激活函数。激活函数为CNN网络引入非线性特征,使其具有非线性拟合能力。激活函数不仅影响数据的映射方式,而且不同的激活函数因梯度不同还会影响反向传播过程。因此,反向传播算法要求激活函数具有连续、可微、单调非递减的性质。常用的激活函数有Sigmoid激活函数、tanh激活函数和ReLU激活函数。

降采样层以采样区域的大小为步长来扫描图像。该网络层在有效减少模型参数的同时保留了图像的结构信息。常用的降采样方法有最大值降采样、均值降采样等。

CNN训练过程中由于有标记样本规模小、网络参数多,模型训练容易过拟合。Dropout层在每次迭代训练过程中随机舍弃一些神经元,仅利用剩下的神经元参与训练,有效减少了模型参数,能够防止过拟合现象发生。

2.2 概率转移模型本文根据SAR图像样本库构建与标注过程中变量之间的实际依赖关系,建立如图2所示的SAR图像含噪标记模型,图中yn,

对于有噪声标记的SAR图像数据集D=

| ${{{f}}_n} = {\rm{CNN}}\left( {{x_n};{{{θ}}_{\rm{c}}}} \right)$ | (1) |

这里,

然后通过softmax分类器获得输入数据真值标注的后验概率

| ${P_n} = \left[ {\begin{array}{*{20}{c}} {P\left( {{y_n} = 0|{x_n},{\theta _{\rm{s}}}} \right)}\\ {P\left( {{y_n} = 1|{x_n},{\theta _{\rm{s}}}} \right)}\\ \vdots \\ {P\left( {{y_n} = K - 1|{x_n},{\theta _{\rm{s}}}} \right)} \end{array}} \right] = \frac{1}{{\sum\limits_{j = 0}^{K - 1} {{e^{\theta _j^{\rm{T}}{f_n}}}} }}\left[ {\begin{array}{*{20}{c}} {{e^{\theta _0^{\rm{T}}{f_n}}}}\\ {{e^{\theta _1^{\rm{T}}{f_n}}}}\\ \vdots \\ {{e^{\theta _{K - 1}^{\rm{T}}{f_n}}}} \end{array}} \right]$ | (2) |

其中,

根据贝叶斯原理,得到含噪标记

| $\begin{aligned}P\left( {{{\tilde y}_n}\! =\! j|{x_n}} \right)\! & =\! \sum\limits_i {P\left( {{{\tilde y}_n} \!= \!j|{y_n} = i} \right)P\left( {{y_n} \!= \!i|{x_n}} \right)}\! \\ & =\sum\limits_i {{q_{ji}}P\left( {{y_n} = i|{x_n}} \right)} \end{aligned}$ | (3) |

其中,

将式(3)表示为矩阵形式

| ${{\tilde{ {P}}}_n}{\rm{ = }}{{Q}}{{{P}}_n}$ | (4) |

这里

| ${{Q}} = \left\{ {{q_{ji}}} \right\} = \left( {\begin{array}{*{20}{c}}{P\left( {{{\tilde y}_n} = 1|{y_n} = 1} \right)} & \cdots & {P\left( {{{\tilde y}_n} = K|{y_n} = 1} \right)}\\ \vdots & \ddots & \vdots \\{P\left( {{{\tilde y}_n} = 1|{y_n} = K} \right)} & \cdots & {P\left( {{{\tilde y}_n} = K|{y_n} = K} \right)}\end{array}} \right) \in {{\mathbb{R}}^{K \times K}}$ | (5) |

最后,通过最小化含噪标记条件下的正则化损失函数

| $L\left( {Ω} \right) = - \frac{1}{N}\sum\limits_{n = 1}^N {\log P\left( {{{\tilde y}_n}|{x_n};{Ω} } \right)} + \lambda {\left\| {Ω} \right\|^2}$ | (6) |

来训练整个网络,其中网络学习参数

| ${\tilde{ {C}}} = {{QC}}$ | (7) |

如果Q=I,则有

对于网络参数

本文实验数据来源于中国武汉地区和上海交通大学闵行校区的两景TerraSAR-X卫星影像,其成像参数如表1所示。

| 表 1 TerraSAR-X卫星成像参数 Tab.1 TerraSAR-X satellite imaging parameters |

针对这两景TerraSAR-X影像,本文构建了一个包含16类地物类型(港口、稀疏建筑区、池塘、桥梁、湿地、舰船、小溪、公路、运动场、沙滩、密集建筑区、河流、森林、道路、绿化带、水体)共5336个正确标记样本的样本库。

本文SAR图像地物样本库构建借助德国宇航局的半自动化人机交互软件平台[20]并结合实地调绘完成。经过多视和上采样处理后的两景影像地距向像元尺寸在0.7 m~0.8 m之间,方位向像元尺寸均在0.6 m~0.7 m之间,因此将两景图像统一标注是合理的。高分辨率SAR图像中200×200的样本尺寸(本数据集中每个切片对应实际地表范围约为150 m×130 m)能够比较全面地反映图像的类别信息[21,22],使得切片具有比较明显的语义含义。表2所示为SAR地物样本库训练集和测试集,其中每类地物类型总量的60%用于训练,其余40%用于测试。

| 表 2 SAR图像地物分类训练与测试数据集 Tab.2 Training and testing set for SAR image land cover classification |

该部分实验数据来源为美国MSTAR计划公布的地面静止军事目标的聚束式SAR实测数据[23]。MSTAR数据集包含了军用和民用的多种静止军事车辆目标,目标方位角覆盖了0°~360°。本文用MSTAR数据中的10类目标并截取中间88×88大小的切片作为训练和测试样本[13],其中训练集和测试集分别用15°方位角和17°方位角下的SAR样本切片,训练数据集和测试数据集如表3所示。

| 表 3 用于训练和测试的MSTAR数据集 Tab.3 Training and testing set of MSTAR database |

为了验证PTCNN模型的有效性,本文利用构建的16类正确标记TerraSAR-X地物数据集和MSTAR数据集仿真两组含噪标记样本库。含噪标记仿真方法为:从每组训练集的每类样本中随机抽取一定比例(本文噪声比例分别选取10%, 20%, 30%, 40%, 50%),将相应类别标记设置为噪声标记,其中标记噪声服从式(8)所示的均匀分布。

| $Q = \left( {\begin{array}{*{20}{c}}{{P_{\rm{e}}}} & {\frac{{1 - {P_{\rm{e}}}}}{{K - 1}}} & \cdots & {\frac{{1 - {P_{\rm{e}}}}}{{K - 1}}}\\{\frac{{1 - {P_{\rm{e}}}}}{{K - 1}}} & {{P_{\rm{e}}}} & \cdots & {\frac{{1 - {P_{\rm{e}}}}}{{K - 1}}}\\ \vdots & \vdots & \ddots & \vdots \\{\frac{{1 - {P_{\rm{e}}}}}{{K - 1}}} & {\frac{{1 - {P_{\rm{e}}}}}{{K - 1}}} & \cdots & {{P_{\rm{e}}}}\end{array}} \right)$ | (8) |

其中,Pe表示训练集中每类样本正确标注的比例,则相应的含噪标记比例为1–Pe。

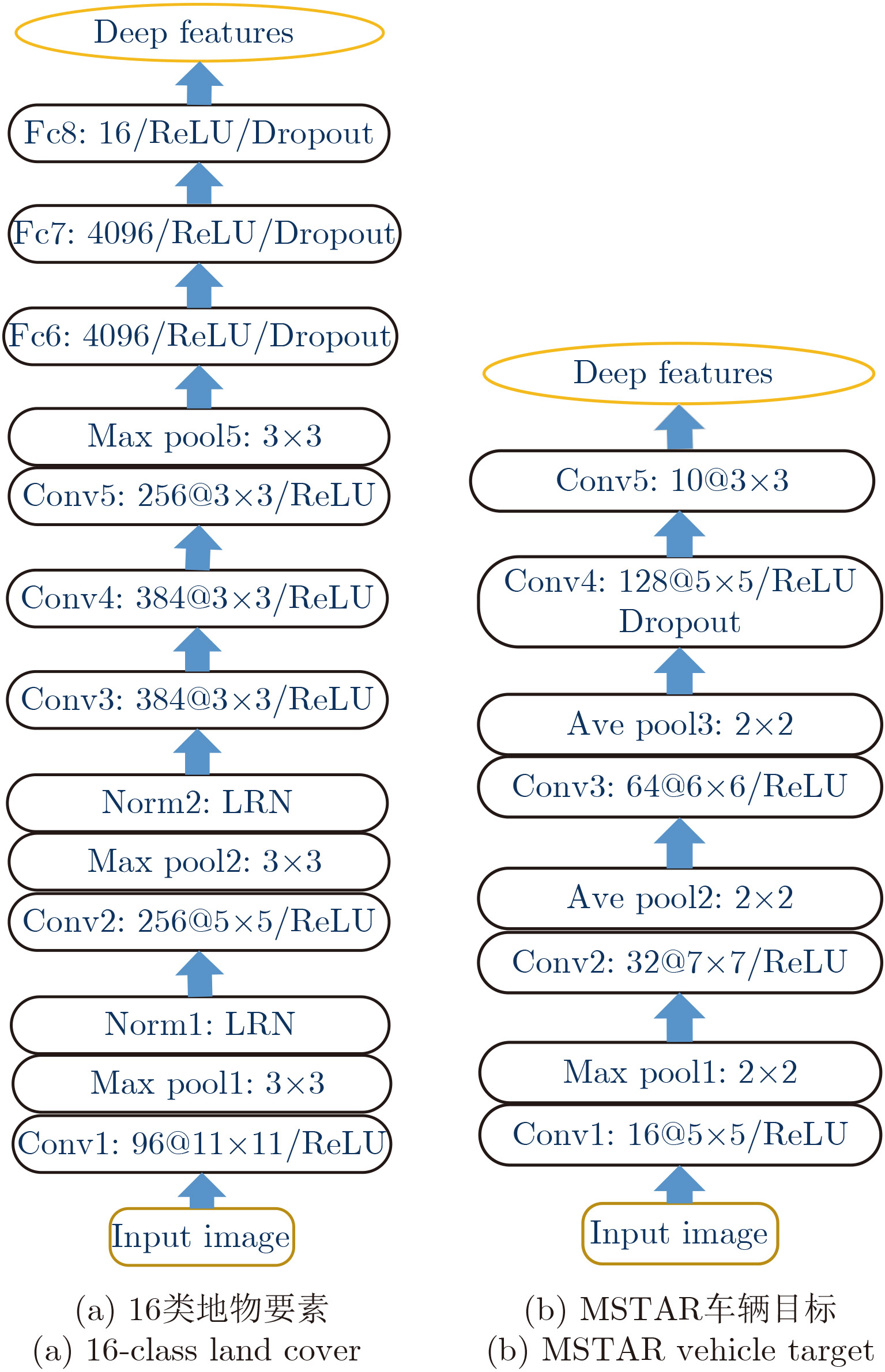

3.2.2 参数初始化本文将CNN作为一种特殊的特征学习方法,通过逐层线性或非线性映射从原始数据中提取图像的深度特征。图3(a)和图3(b)分别为16类地物要素和MSTAR数据集车辆目标的深度特征提取模块网络结构。图3(a)中“Conv1”、“Conv2”、“Conv3”、“Conv4”、“Conv5”层权值初始化为方差0.01的高斯分布,“Conv1”、“Conv3”层偏置设置为常数0, “Conv2”、“Conv4”、“Conv5”层偏置设置为常数1,“Norm1”、“Norm2”层局部窗口大小为5×5,缩放因子

|

图 3 深度特征提取网络结构 Fig.3 Deep feature extraction structure |

为了说明本文方法能够一定程度上解决含噪标记条件下的SAR图像分类问题,降低错误标注对分类器性能的影响,提高分类模型对噪声标记的鲁棒性,本文将PTCNN与经典CNN方法和基于传统特征的SVM算法进行对比。两组数据集中经典CNN方法与PTCNN方法的区别都是仅仅缺少噪声标记转移层。

而由于SVM算法分类性能与特征选择密切相关,对于地物数据集,本文采用基于Gabor特征的SVM分类算法[20],这里提取的Gabor特征为48维(由4个方向、6个尺度下特征图的均值和标准差依次组成),SVM分类器采用RBF核函数,通过网格搜索法得到最佳误差项惩罚参数C=8000.0,最佳核函数系数

对于MSTAR数据集,采用基于PCA特征的SVM算法[24],PCA特征采用图像原始幅度信息,特征维数通过网格搜索寻优法取35维。SVM分类器参数采用5次多项式核函数,通过网格搜索法得到最佳误差项惩罚参数C=1,最佳多项式系数

评价指标采用每种方法在每种噪声比例下的分类准确率、混淆矩阵。

3.3 实验结果与分析 3.3.1 地物数据集实验高分辨率TerraSAR-X影像丰富的地物类型和庞大的数据量为本实验提供了充足的数据源,地物样本数据库通过PTCNN模型,采用迭代优化策略更新模型参数。模型训练采用基于动量(momentum)法的SGD算法,初始学习率为0.001,每迭代400次学习率更新一次,衰减率为0.1,动量设置为0.9,最大迭代次数设置为4000使损失函数收敛。

不同噪声比例下的地物分类准确率如表4所示。从表中可以看出,无论噪声比例如何变化,PTCNN的分类准确率都优于其他两种方法,且经典CNN模型分类准确率优于基于Gabor特征的SVM分类算法。因此,在SAR图像地物要素分类性能方面:PTCNN>经典CNN>Gabor+SVM。

| 表 4 不同标记噪声比例下的地物分类准确率(%) Tab.4 Land cover classification accuracies of different label noise fraction (%) |

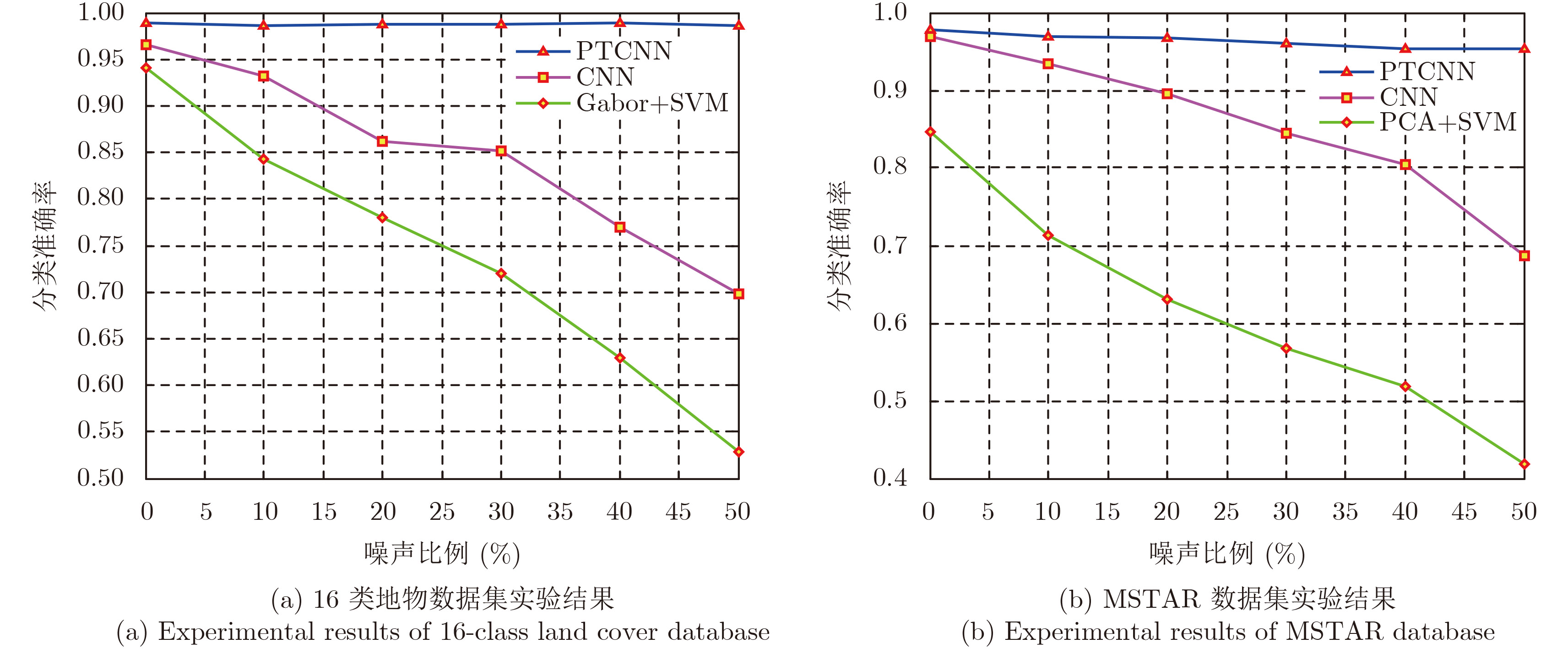

图4(a)显示了3种方法的地物分类准确率随噪声比例的变化曲线。从图中可以看出,本文PTCNN网络在不同噪声比例下地物分类准确率保持在98.80%左右,基本不随噪声比例变化而变化,经典CNN网络和基于Gabor特征的SVM算法分类准确率随着噪声比例的增加下降较明显,其中SVM算法准确率最低且随噪声比例增加下降速度最快。所以在抗噪性能方面:PTCNN>经典CNN>Gabor+SVM。

|

图 4 分类准确率随噪声比例变化曲线 Fig.4 Classification accuracy varies with noise fraction |

图4(b)为3种方法对车辆目标的分类准确率随噪声比例的变化曲线,从图中可以看出,经过20000次迭代更新,PTCNN模型在不同噪声比例下准确率最高,且随噪声比例的变化幅度较小,验证了PTCNN模型对噪声的敏感性较低,体现出其较好的抗噪性能。而基于PCA特征的SVM算法比经典CNN算法随噪声比例变化更缓慢,说明前者比后者抗噪性能好。说明PTCNN模型的抗噪性能最好,SVM算法次之,经典CNN模型抗噪性能最差。

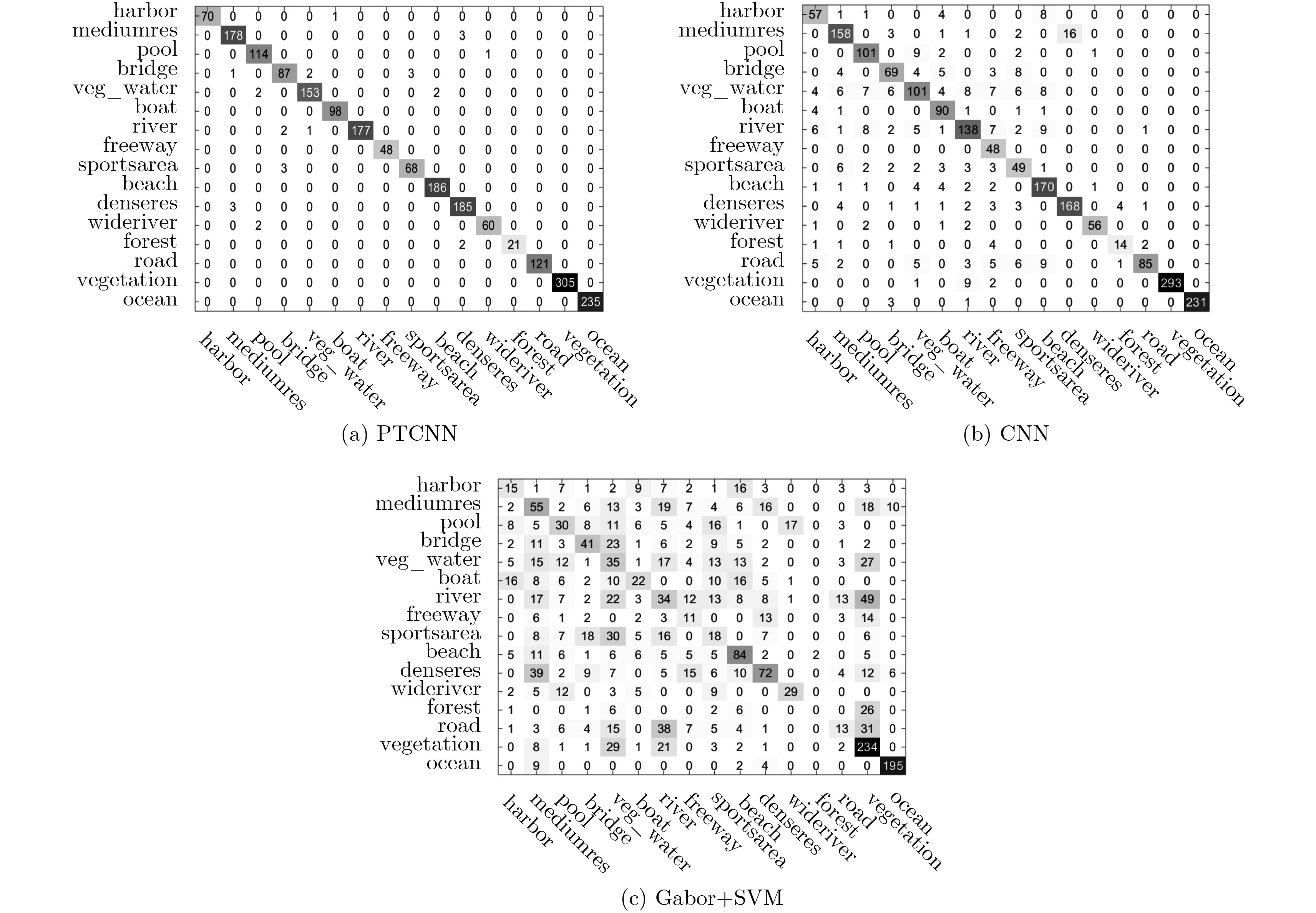

图5(a)、图5(b)、图5(c)分别是训练样本噪声比例为30%时3种算法测试结果的混淆矩阵,明显可以看出PTCNN模型的测试准确率最高,只有极个别样本被错分,经典CNN模型次之,基于Gabor特征的SVM算法测试准确率最低。

|

图 5 类别噪声比例为30%时3种方法的测试混淆矩阵 Fig.5 Confusion matrix of three method with 30% noise fraction |

图5给出了含噪标记条件下SAR图像训练样本的PTCNN特征、CNN特征和Gabor特征,采用t-SNE (t-distributed Stochastic Neighbor Embedding)方法分别将其特征分布映射到2维空间中并可视化(3种方法在不同噪声比例下的特征分布如图6所示,图中不同颜色表示不同的含噪标记,不同聚类表示预测的不同标记)。从图6第1列图6(a1)~图6(f1)可以看出不同标记噪声比例下的错标样本都被重新归类,特征分布基本不随噪声比例变化而变化,从视觉上直观地验证了PTCNN模型较好的抗噪性能和分类性能。同样地,从图6中第2列图6(a2)~图6(f2)可以看出经典CNN特征受噪声影响较大,且特征的可区分性随标记噪声比例的增加越来越差。图6第3列图6(a3)~图6(f3)可以看出传统Gabor特征可区分性比深度特征差,且对噪声比较敏感。

|

图 6 不同标记噪声比例下3种方法的特征分布 Fig.6 Feature distribution of three method with different noise label fractions |

MSTAR数据集对车辆目标分类的过程中,参数衰减系数设置为0.004,网络学习率采用步进式策略,基础学习率设为0.001,每迭代500次学习速率更新1次,各层权重与偏置更新策略采用基于动量(momentum)法的SGD算法,动量设置为0.9,最大迭代次数设置为20000次,直至目标函数收敛。不同噪声比例下MSTAR车辆目标分类准确率如表5所示,同样可以看出,不同噪声比例下PTCNN模型对车辆目标的分类准确率优于经典CNN模型,而经典CNN模型分类性能又优于基于PCA特征的SVM算法。

| 表 5 不同标记噪声比例下MSTAR车辆目标分类准确率(%) Tab.5 Classification accuracies of MSTAR vehicle target with different noise fractions (%) |

SAR图像由于其特殊的成像机理使得图像目视解译困难,直接获取大规模、高质量标注的训练样本非常困难。本文针对含噪标记条件下的SAR图像分类问题,提出了一种基于概率转移模型的卷积神经网络方法(PTCNN),首先提取训练样本的CNN特征,然后基于错误标记与正确标记之间的转移概率模型,建立噪声标记转移层,从而构建了一种新的含噪标记条件下的卷积网络模型。对比实验采用基于传统特征的概率转移模型、采用经典CNN模型和SVM算法,分析不同比例噪声对SAR图像分类性能的影响,对比验证了PTCNN模型相比经典CNN模型,能够利用含噪标记样本训练出分类性能较好的模型,并且能够潜在校正含噪标记,减小了含噪标记对模型训练的影响,从而降低了SAR图像分类任务对训练样本标注质量的要求,具有一定的研究价值与应用前景。

| [1] |

Krizhevsky A, Sutskever I, and Hinton G E. Imagenet classification with deep convolutional neural networks[C]. Advances in Neural Information Processing Systems, 2012: 1097–1105.

( 0) 0)

|

| [2] |

He K, Zhang X, Ren S, et al.. Spatial pyramid pooling in deep convolutional networks for visual recognition[J].

IEEE transactions on pattern analysis and machine intelligence, 2015, 37(9): 1904-1916. DOI:10.1109/TPAMI.2015.2389824 ( 0) 0)

|

| [3] |

Chan T H, Jia K, Gao S, et al.. PCANet: A simple deep learning baseline for image classification?[J].

IEEE Transactions on Image Processing, 2015, 24(12): 5017-5032. DOI:10.1109/TIP.2015.2475625 ( 0) 0)

|

| [4] |

Chen X, Xiang S, Liu C L, et al.. Vehicle detection in satellite images by hybrid deep convolutional neural networks[J].

IEEE Geoscience and remote sensing letters, 2014, 11(10): 1797-1801. DOI:10.1109/LGRS.2014.2309695 ( 0) 0)

|

| [5] |

Kalchbrenner N, Grefenstette E, and Blunsom P. A convolutional neural network for modelling sentences[J]. arXiv Preprint arXiv: 1404. 2188, 2014.

( 0) 0)

|

| [6] |

Kim Y. Convolutional neural networks for sentence classification[J]. arXiv Preprint arXiv: 1408. 5882, 2014.

( 0) 0)

|

| [7] |

Chen S and Wang H. SAR target recognition based on deep learning[C]. 2014 International Conference on Data Science and Advanced Analytics (DSAA), Shanghai, 2014: 541–547.

( 0) 0)

|

| [8] |

Wagner S. Combination of convolutional feature extraction and support vector machines for radar ATR[C]. 17th International Conference on Information Fusion (FUSION), Salamanca, 2014: 1–6.

( 0) 0)

|

| [9] |

田壮壮, 占荣辉, 胡杰民, 等. 基于卷积神经网络的SAR图像目标识别研究[J].

雷达学报, 2016, 5(3): 320-325. Tian Zhuangzhuang, Zhan Ronghui, Hu Jiemin, et al.. SAR ATR Based on Convolutional Neural Networks[J]. Journal of Radars, 2016, 5(3): 320-325. (  0) 0)

|

| [10] |

Li X, Li C, Wang P, et al.. SAR ATR based on dividing CNN into CAE and SNN[C]. 5th Asia-Pacific Conference on Synthetic Aperture Radar (APSAR), Singapore, 2015: 676–679.

( 0) 0)

|

| [11] |

Ding J, Chen B, Liu H, et al.. Convolutional Neural Network With Data Augmentation for SAR Target Recognition[J].

IEEE Geoscience and Remote Sensing Letters, 2016, 13(3): 364-368. ( 0) 0)

|

| [12] |

Zhao J, Guo W, Cui S, et al.. Convolutional neural network for SAR image classification at patch level[C]. International Geoscience and Remote Sensing Symposium (IGARSS), Beijing, 2016: 945–948.

( 0) 0)

|

| [13] |

Chen S, Wang H, Xu F, et al.. Target Classification Using the Deep Convolutional Networks for SAR Images[J].

IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(8): 4806-4817. DOI:10.1109/TGRS.2016.2551720 ( 0) 0)

|

| [14] |

Deng J, Dong W, Socher R, et al.. Imagenet: A large-scale hierarchical image database[C]. IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Miami Beach, Florida, 2009: 248–255.

( 0) 0)

|

| [15] |

Zhu X and Wu X. Class noise vs. attribute noise: A quantitative study[J].

Artificial Intelligence Review, 2004, 22(3): 177-210. DOI:10.1007/s10462-004-0751-8 ( 0) 0)

|

| [16] |

Chang C C and Lin C J. LIBSVM: a library for support vector machines[J].

ACM Transactions on Intelligent Systems and Technology (TIST), 2011, 2(3): 27 ( 0) 0)

|

| [17] |

Jia Y, Shelhamer E, Donahue J, et al.. Caffe: Convolutional architecture for fast feature embedding[C]. Proceedings of the 22nd ACM International Conference on Multimedia, Orlando, 2014: 675–678.

( 0) 0)

|

| [18] |

Hecht-Nielsen R. Theory of the backpropagation neural network[C]. IEEE International Joint Conference on Neural Networks, 1989: 593–605.

( 0) 0)

|

| [19] |

Bottou L. Stochastic gradient learning in neural networks[J].

Proceedings of Neuro-Nımes, 1991, 91(8) ( 0) 0)

|

| [20] |

Cui S, Dumitru C O and Datcu M. Semantic annotation in earth observation based on active learning[J].

International Journal of Image and Data Fusion, 2014, 5(2): 152-174. DOI:10.1080/19479832.2013.858778 ( 0) 0)

|

| [21] |

Popescu A A, Gavat I and Datcu M. Contextual descriptors for scene classes in very high resolution SAR images[J].

IEEE Geoscience and Remote Sensing Letters, 2012, 9(1): 80-84. DOI:10.1109/LGRS.2011.2160838 ( 0) 0)

|

| [22] |

Singh J, Cui S, Datcu M, et al.. A survey of density estimation for SAR images[C]. 20th European of Signal Processing Conference (EUSIPCO), 2012: 2526–2530.

( 0) 0)

|

| [23] |

Ross T D, Worrell S W, Velten V J, et al.. Standard SAR ATR evaluation experiments using the MSTAR public release data set[C]. Aerospace/Defense Sensing and Controls. International Society for Optics and Photonics, 1998: 566–573.

( 0) 0)

|

| [24] |

Wu T, Chen X, Ruang X W, et al.. Study on SAR target recognition based on support vector machine[C]. 2nd Asian-Pacific Conference on Synthetic Aperture Radar, 2009: 856–859.

( 0) 0)

|