② (北京市遥感信息研究所 北京 100192)

② (Beijing Institute of Remote Sensing Information, Beijing 100192, China)

在合成孔径雷达(Synthetic Aperture Rader, SAR)图像目标识别应用中,单一特征难以全面描述目标特性,达到较高的识别精度。SAR图像的特征级融合不仅可以增加图像的特征信息,进行综合分析及融合处理,而且能有效综合各特征之间的优势获得目标更全面的特征表达,最大程度降低训练学习的复杂性。不同的特征组合对特征融合的影响不同,为提高识别的准确率和效率,需要针对SAR目标识别的具体问题选取最有效的识别特征。研究表明[1],在分类识别过程中,人的视觉系统会自动提取图像的局部区域信息和全局结构信息,并对全局和局部信息进行融合。因此,在计算机视觉领域,很多学者探究了全局特征与局部特征的融合在人脸识别、场景分类、目标识别等各个方面的有效性[2–4]。目前,用于SAR目标识别的特征融合算法主要分为3类[5]:第1类是特征组合的方法,即按一定的权值将特征串接或并联成新的特征向量[6,7];第2类是特征选择,利用各种优选方法,选择最优的特征组合,得到区分度更好的低维特征[8];第3类是特征变换,将原始特征变换为新的特征表达方式[9]。传统的特征融合方法融合效率较低,融合后的特征冗余性较大,区分性不高。

栈式自编码器[10](Stacked AutoEncoder, SAE)是一种无监督的学习网络,能通过非线性的简单模型将原始数据转化为更为抽象的表达,再利用最优化的学习算法,实现有效的特征融合。基于SAE的特征融合,能充分减少特征之间的冗余,综合特征之间的互补信息。另外,SAE结构相对简单,能有效适应SAR图像快速解译的需求,在样本较少的情况下训练得到的网络泛化能力更强。因此,在特征融合方面具有高效、鲁棒的特点。目前,很多学者已经在这方面做了研究,文献[11]利用灰度共生矩阵和Gabor小波变换提取SAR图像的纹理特征,利用SAE对纹理特征进行融合优化,提取出更高层的特征。但由于同一图像的纹理特征之间冗余性较大,因而融合后信息量增加较小,融合效果提高不明显。文献[12]中利用主成分分析(Principal Components Analysis, PCA)对高光谱图像的空间特征降维后,再利用SAE将光谱信息与空间特征进行融合,从而达到了较好的分类效果。由于光谱信息未进行处理,因此特征的维度较高,网络结构较复杂。文献[13]采用多层自编码器提取SAR目标和阴影轮廓特征,并融合送入协同神经网络(Synergetic Neural Network, SNN)进行识别,提升了分类精度。该算法需要分割目标阴影区域,预处理较复杂。

本文针对SAR图像的目标识别问题,提取了SAR图像的全局基线特征和TPLBP(Three-Patch Local Binary Patterns)局部纹理特征。一方面,基线特征在提取目标几何特征参数时,将图像进行了二值化处理,能有效减少相干斑噪声的影响,但舍弃了大量的SAR图像灰度信息。而SAR图像的灰度值能反映目标在结构、粗糙度和物理特性上的差异。TPLBP特征通过对比局部区域内SAR图像的灰度值得到图像的纹理特性,能有效弥补基线特征灰度信息的缺失。同时,TPLBP特征通过对比圆形模块之间的纹理特征,能有效应对几何结构特征对方位角变化敏感的问题。另一方面TPLBP在提取特征的过程中,对目标像素和背景像素进行相同的特征提取步骤,对目标特性的描述不够细致,而基线特征综合了多种几何结构参数,针对SAR目标区域的特性进行具体描述。因此,两种特征能实现特征之间的优势互补,在维度较低的情况下,较为全面的描述SAR图像特征。利用SAE对两种特征进行融合,能有效综合特征之间的优势,SAE的无监督学习算法,在样本较少的情况下,能有效防止网络出现过拟合现象,得到更有效的深度融合特征。

2 特征提取为选取冗余性小,互补性大的融合特征,本文提取了SAR图像的100维基线特征与128维的TPLBP (Three-Patch Local Binary Patterns)局部纹理特征。基线特征利用Fisher score[14,15]的方法对SAR图像的几何形状特征进行选择,将最有效的几何形状特征组成图像的基线特征。TPLBP纹理特征则利用图像区域之间LBP码值对比,有效刻画了SAR图像目标的局部纹理特性。

2.1 基线特征基线特征[16]是SAR图像目标的几何形状特征参数的集合,能细致描述目标的结构特性。对于复值SAR图像中(x, y)位置的像素点其幅值可表示为

| $p\left( {x,y} \right) = {\left[ {i\left( {x,y} \right)} \right]^2} + {\left[ {q\left( {x,y} \right)} \right]^2}$ | (1) |

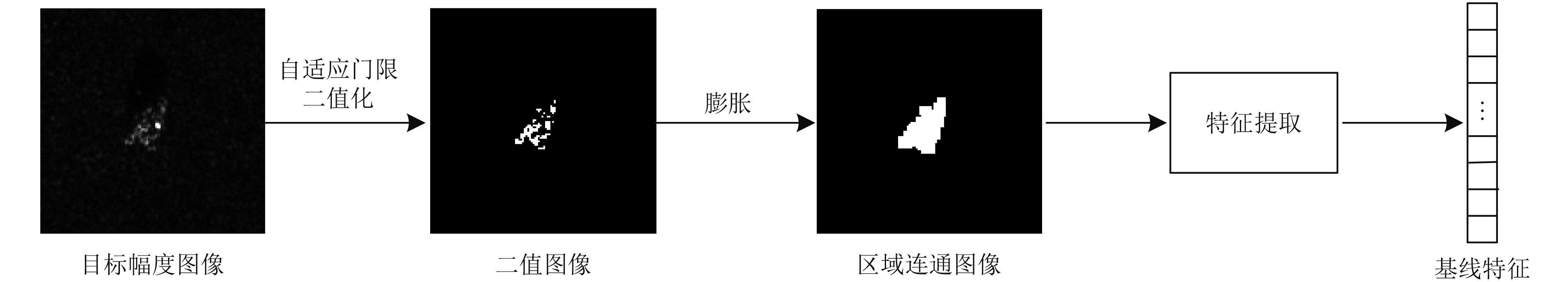

为减少相干斑噪声的影响,利用Kapur等人[17]提出的基于熵的自适应门限,得到二值化的图像,通过形态学的膨胀[18],去除图像区域内部非连通的部分。最后提取出膨胀后的二值图像或原始二值图像的几何形状特征,组成一个多维度的基线特征,如图1所示。

|

图 1 基线特征提取框图 Fig.1 Framework of feature extraction |

再利用Fisher score衡量特征之间的类间与类内距离,对提取出的多个特征进行排序,选择区分性最好的25种特征,组成100维的基线特征向量。具体特征见表1。

| 表 1 基线特征 Tab.1 The selected baseline features |

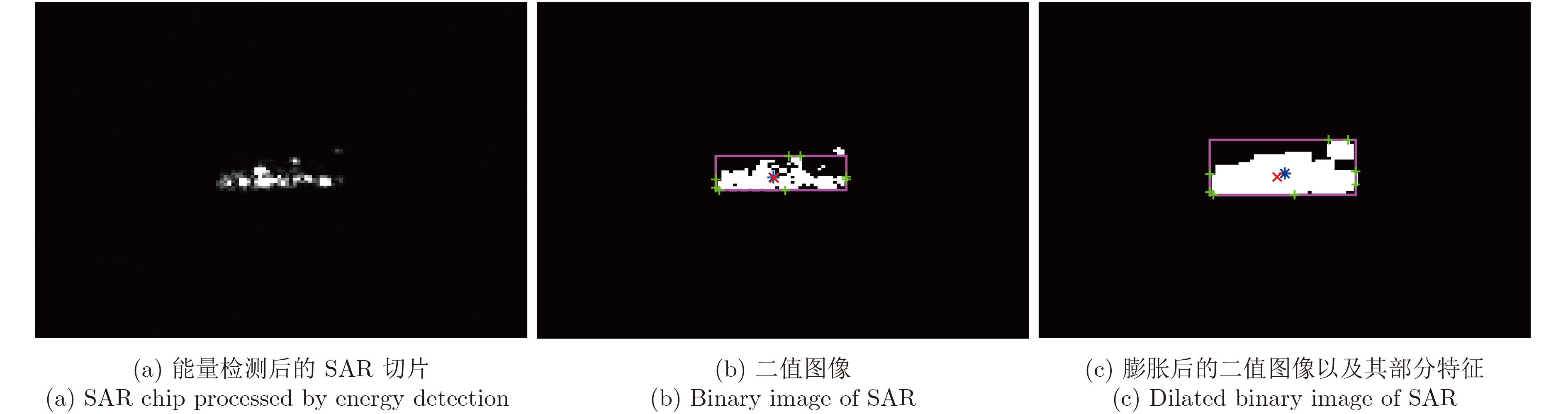

图2为提取的MSTAR数据库中BMP2的SAR切片的部分特征。图中从左至右分别为能量检测后的SAR切片、二值图像和膨胀后的二值图像。同时,图像目标区域的质心、边界矩形、极值和重心分别用蓝、紫、绿和红在图中标出。

|

图 2 部分基线特征 Fig.2 Examples of baseline features |

由于结构、粗糙度和物理特性的不同,目标对雷达回波的反射能力差异较大,在SAR图像中产生丰富的纹理信息。SAR图像纹理反映的目标信息随目标方位角的变化不大,因此可以利用纹理特征进行目标识别。局部二值模式(Local Binary Patterns, LBP)是一种简单有效的局部纹理提取算子,具有灰度不变性和旋转不变性,能有效的利用图像的空间信息,充分反映图像的局部空间相关性。

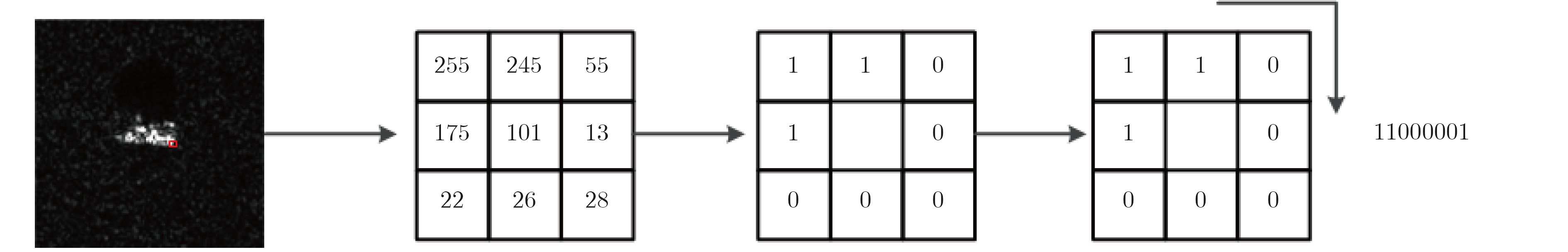

传统的LBP算子定义为在3×3的窗口内,以窗口中心像素灰度值为阈值,将相邻的8个像素的灰度值与其进行比较,若周围像素值大于中心像素值,则该像素点的位置被标记为1,否则为0。这样,3×3邻域内的8个点可产生8 bit的无符号数,即得到该窗口的LBP值,并用这个值来反映该区域的纹理信息。图3为MSTAR数据库中目标切片的LBP值的计算过程。受邻域大小的限制,LBP算子不能描述大尺度的纹理信息,另外原始的LBP算子不具有旋转不变性。因此不适合描述多方位角的SAR图像目标。

|

图 3 SAR目标图像的LBP值 Fig.3 LBP value of SAR image |

Wolf等[19]对LBP算子进行了改进,提出了三斑块局部二值模式 (TPLBP)。首先,对于图像中的每个像素点,以该像素点为中心得到一个w×w大小的模块Cp ,以该模块为中心,在距离半径为r的范围内,生成S个同等大小的模块,每个模块的中心像素点均通过LBP算法生成相应的LBP码值。如图4所示,选取MSTAR数据库中SAR切片的某像素值作为中心点,当S=8, $\omega $=3, $\alpha $=2时,得到S个模块的LBP值。

|

图 4 BMP2的TPLBP编码示意图(S=8, $\omega $=3, $\alpha $=2) Fig.4 TPLBP code of BMP2 (S=8, $\omega $=3, $\alpha $=2) |

从S个模块中取出圆周上间隔a个模块的两个模块,将其中心像素点LBP码值与中心模块的中心像素点LBP码值进行相似度计算。

然后,将两模块与中心模块的中心像素点得到的相似度进行差值计算,从而得到一组二进制串,将其加权计算得到相应的TPLBP码值,其定义如下:

| ${\rm{TPLB}}{{\rm{P}}\!_{r,S,\omega ,\alpha }}\left(p \right) \!\!=\!\! \sum\limits_i \!{f(d({C_i}{\rm{ \!-\! }}{C_p}) \!\!-\!\! d({C_{i + \alpha \ od S}},\!{C_p}))} {{\rm{2}}^i}$ | (2) |

其中,Ci

和

| $f(x) = \left\{ {\begin{array}{*{20}{c}}{\!\!\!1,} & {x \ge \tau }\\{\!\!\!0,} & {x < \tau }\end{array}} \right.$ | (3) |

其中,本文中设定$\tau $=0.01。根据式(2)计算得到图像中每个像素点的TPLBP码值。然后将整幅图像分割成非重叠的同等大小的矩形窗(B×B),并计算每个矩形窗中各TPLBP码值的频率值,即TPLBP码值的统计直方图。最后,将每个矩形窗的直方图向量串联形成整幅图像的TPLBP特征向量。

TPLBP算子将像素间的灰度对比变为模块之间的LBP值的比较,描述了邻域模块LBP编码之间的相互关系,因而能有效抑制SAR相干斑噪声的影响。圆形区域内的模块选取使提取出的特征具有旋转不变性,能有效克服几何结构特征对方位角变化敏感的问题。另外参数r的选取使得TPLBP能够对比不同尺度的区域内的纹理特征值,克服了LBP只能提取局部纹理特征的缺点,能更有效的描述大尺度的SAR图像的纹理特征。

3 特征融合为提取基线特征和TPLBP特征之间的互补信息,实现特征之间的优势互补,本文采用了栈式自编码器和softmax分类器对特征进行融合分类。为使网络达到更好的融合效果,利用逐层贪婪训练法对SAE网络进行预训练,再利用softmax分类器对网络进行微调。

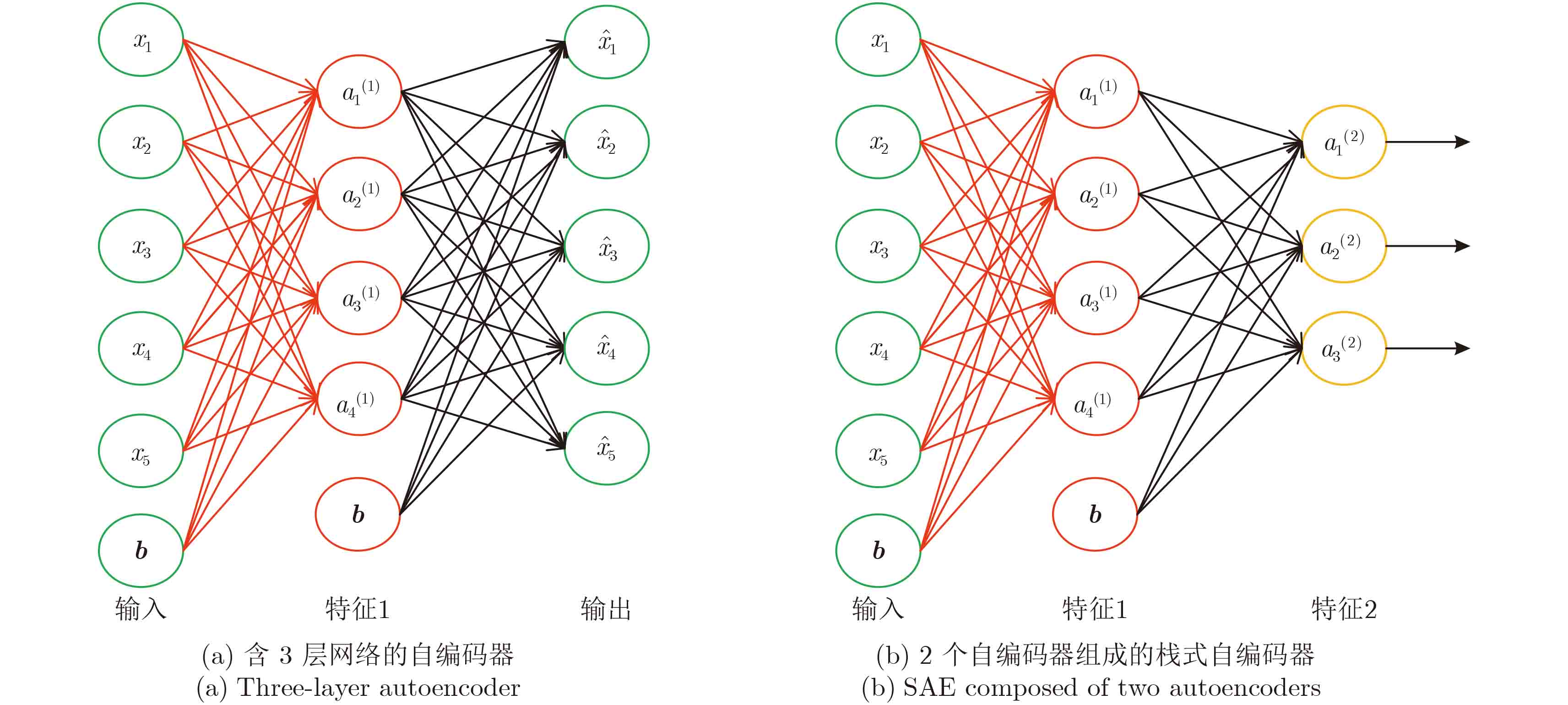

3.1 栈式自编码器自编码人工神经网络是一种无监督的学习网络,由3层网络组成,输入层和隐层组成编码器,将输入信号 x 编码转换为 a 。隐层和输出层之间构成解码器,将编码 a 变换为输出信号 y 。如图5(a)所示,即

| ${{a}} = f({{Wx}} + {{b}})$ | (4) |

| ${{y}} = g({\widehat{ W} a} + {\hat{ b}})$ | (5) |

其中,

W

,

| $J({W},{b}) = \Biggr[\frac{1}{m}\sum\limits_{i = 1}^m {\biggr(\frac{1}{2}{{\left\| {{y_i} - {x_i}} \right\|}^{\rm{2}}}\biggr)} \Biggr]\\ \quad \quad \quad \quad \ \ \, {\rm{ + }}\frac{\lambda }{{\rm{2}}}\sum\limits_{l = 1}^{{{{n}}_l} - 1} {\sum\limits_{i = 1}^{{s_i}} {\sum\limits_{j = 1}^{{s_{i + 1}}} {{{({W_{ji}}^{(l)})}^2}} } } $ | (6) |

其中,xi

和yi

分别表示自编码器第i个样本的输入和输出,

寻找最优的参数

为了实现网络稀疏性限制,需要在优化目标函数中加入一个额外的稀疏惩罚因子,从而使得隐藏神经元的平均活跃度保持在较小范围内。稀疏后的代价函数为:

| ${J_{{\rm{sparse}}}}({W},{b}) = J({W},{b}) + \beta \sum\limits_{j = 1}^{{s_2}} {{\rm{KL}}(\rho ,{{\hat \rho }_j})} $ | (7) |

| $\!\!\!\!\!\!\!{\rm{KL}}(\rho ,{\hat \rho _j}) = \rho \ln \frac{\rho }{{{{\hat \rho }_j}}} + (1 - \rho )\ln \frac{{1 - \rho }}{{1 - {{\hat \rho }_j}}}$ | (8) |

其中$\beta $是控制稀疏性惩罚因子的权重,利用后向传播算法,计算代价函数的偏导数,最后利用批量梯度下降法迭代更新参数 W 和 b 来求解模型的最优解。

将前一层稀疏自编码器的输出作为其后一层自编器的输入,多层稀疏自编码器可组成栈式自编码器。如图5(b)所示。

|

图 5 栈式自编码器结构 Fig.5 The structure of autoencoder and SAE |

采用逐层贪婪训练法进行训练,即在训练某一层的参数时,将其它各层参数保持不变,逐层训练。为得到更好的结果,预训练过程完成之后,利用softmax分类器,对SAE进行微调。通过计算概率:

| $p({y_i} = j\left| {{x_i};{θ} } \right.) = \frac{{{e^{{{θ} _j}\!\!^{\rm{T}}{x_i}}}}}{{\sum\limits_{l = 1}^k {{e^{{{θ} _j}\!\!^{\rm{T}}{x_i}}}} }}$ | (9) |

其中${\theta _j}$为参数向量,输入xi 所属类别为概率最大的类别。利用softmax的分类结果与输入样本的标签,构建分类器的代价函数,通过反向传播算法,微调网络的权值,训练得到最优的模型参数$\theta $。微调过程利用全局监督,使网络进而收敛至全局最小解。因此栈式自编码具有强大的特征表达能力,能更好的学习到输入的特征中的深层特征。与随机初始化网络参数相比,栈式自编码器通过无监督的预训练过程,使网络参数初始化至容易收敛的值,相当于暗示了隐含层需要学习的内容,再引入稀疏性,防止网络过拟合,提高了网络的泛化能力。

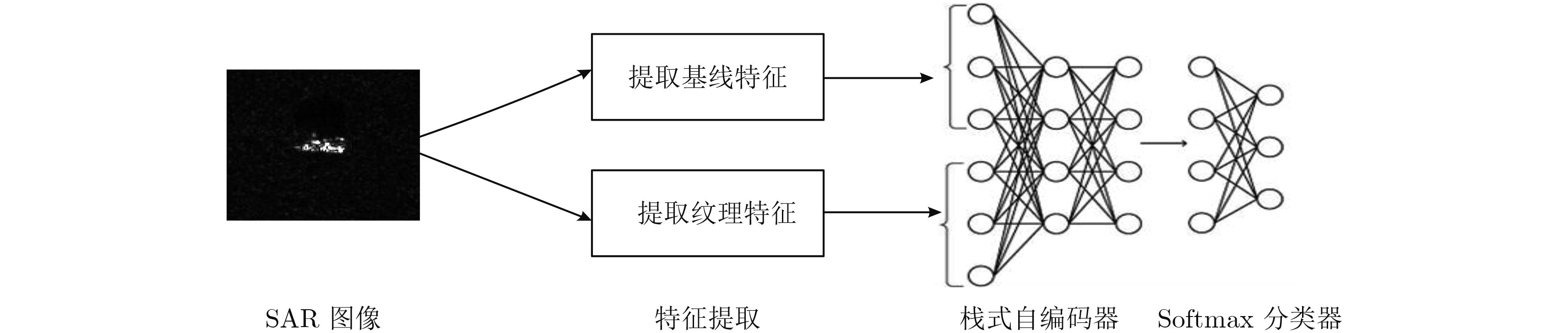

3.2 融合框架本文提出的特征融合框架主要分为三大部分,如图6所示。

|

图 6 特征融合框图 Fig.6 Flowchart of feature fusion |

(1) 特征提取

首先,提取图像的几何形状参数,得到100维的基线特征。再统计SAR图像的TPLBP码值的直方图,将直方图串接成SAR图像的128维纹理特征向量。将基线特征和纹理特征串联成特征向量。

(2) 特征融合

将得到的串联向量作为SAE的输入,利用SAE,融合原始特征中的互补信息,去除冗余信息。采用逐层贪婪训练法,预训练网络。

(3) 分类

预训练结束后,再利用带标签的训练数据,将SAE得到的融合特征送入softmax分类器进行分类,根据分类结果与数据标签之间的距离,利用反向传播算法对网络权值进行微调,得到训练好的网络。最后对测试样本提取特征,送入网络进行分类,得到识别结果。

4 实验结果与分析为验证算法的有效性,本文在MSTAR数据集上做了10类目标的识别实验。该数据集是美国预先研究计划局和空军实验室(DARPA/AFRL)联合资助的面向SAR自动目标识别的公测数据集。利用X波段、HH极化方式聚束式合成孔径雷达采集而来,分辨率为0.3 m×0.3 m。图像大小主要有128×128像素、129×128像素、158×158像素等。该数据集包括BMP2, BRDM2, BTR60, BTR70, D7, T62, T72, ZIL131, ZSU234, 2S1等10类军事目标(见图7),每类目标样本均包含方位角间隔1°的样本数据。本文分别选取了17°和15°俯仰角的SAR图像作为训练样本和测试样本。具体数据见表2。

|

图 7 10类MSTAR机动目标切片与姿态角为40°的SAR图像 Fig.7 Optical and SAR images of ten military targets in MSTAR dataset (40° attitude angle) |

| 表 2 10类目标训练、测试样本数 Tab.2 Number of training samples and test samples |

实验设置:根据文献[2]TPLBP算子的参数设为S=8, $\omega $=3, $\alpha $=1, r=12, $\tau $=0.01, B=64,提取出图像的128维TPLBP特征,再与提取的100维基线特征串联,得到228维的特征向量,送入含两个隐层的SAE中进行特征融合,再利用softmax分类器对网络进行微调,最后利用融合特征分类。本文所有算法均在2.6 GHz CPU, 8 G内存的条件下,使用Matlab R2014a编程实现。

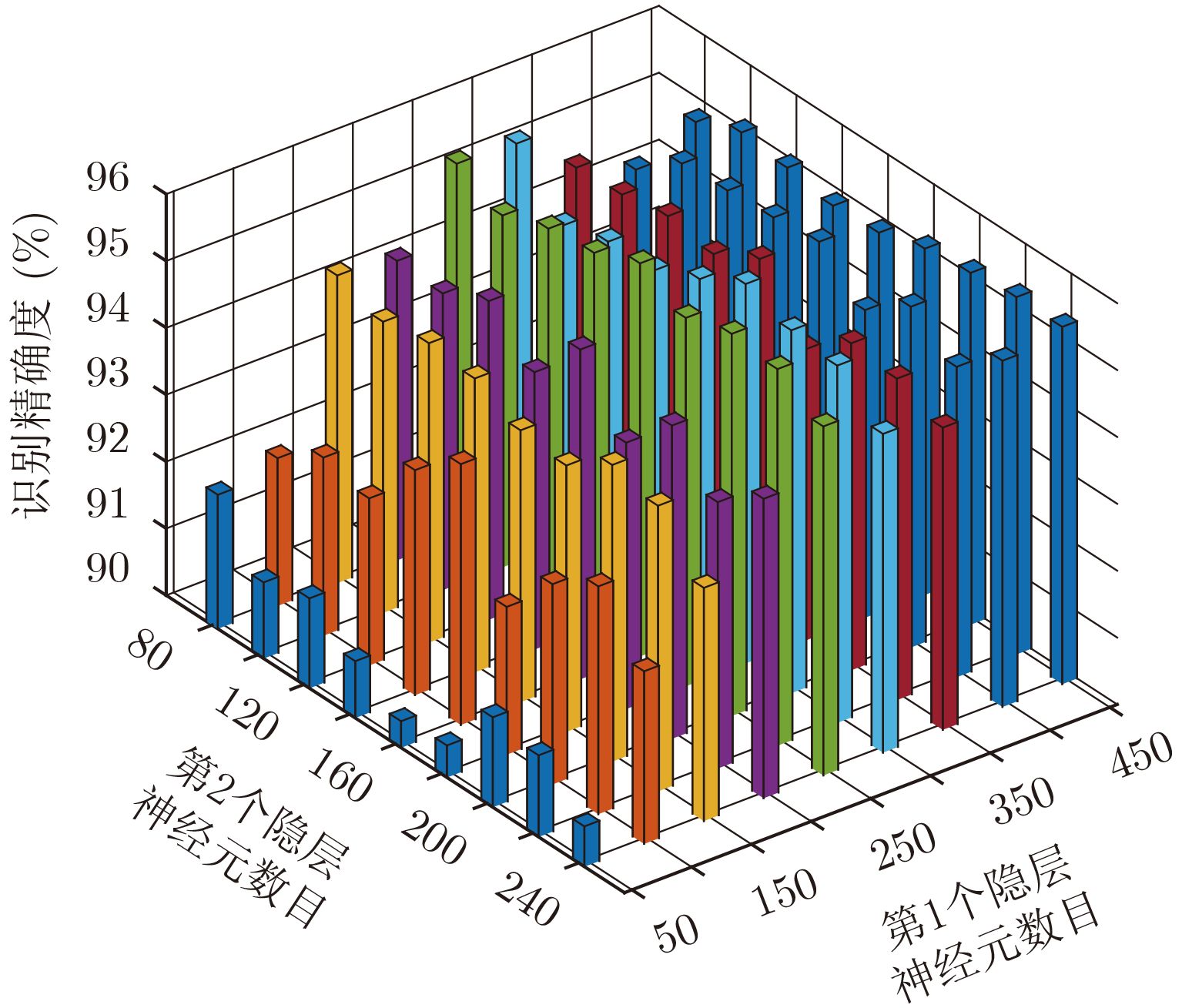

4.1 SAE网络结构对实验结果的影响神经网络在训练中,容易出现“过拟合”和“欠拟合”的问题。网络结构太复杂,网络会将噪声当作信号一起拟合时,网络产生较大的方差,此时网络产生“过拟合”。若需要学习复杂的样本,而网络结构又过于简单时,网络将“欠拟合”。因此本文研究了栈式自编码器结构对网络性能的影响。

在训练样本一定的情况下,网络神经元数目越多,网络结构越复杂,“过拟合”现象越容易产生。因此,在达到相当精度的情况下,网络的层数越少越好。我们选择含两个隐层的自编码器进行特征融合,深入探究各层神经元数目对网络泛化能力的影响。

施彦[20]等人指出,为防止网络“过拟合”,一般来说网络隐层神经元的数目与输入层和输出层数目之和相当比较合适,本文中原始输入特征为228维,因此输入层的数目为228,输出层数目为10。因此设SAE两个隐层的神经元的数目分别为L1, L2,其中

权重衰减参数$\lambda $用于控制代价函数中均方差项和权重衰减项的相对重要性,当$\lambda $较小时,网络偏好最小化原本的代价函数,而$\lambda $较大时网络偏好更小的权值。本文取较小的$\lambda $值(

设置相同的网络参数,将相同的特征数据输入网络,改变自编码器两个隐层神经元数目L1, L2的值,记录分类精度。为保证实验结果的准确性,对于L1, L2的每一组取值,将网络训练和测试过程进行5次,取平均分类精度作为最终的实验结果。结果如图8。

|

图 8 神经元数目对实验结果的影响 Fig.8 Effect of changed neuron’s numbers on classification accuracy |

由结果可知,自编码器各层神经元个数对网络性能有很大影响。当第2个隐层的神经元数目L2固定时,分类准确度随第1个隐层神经元的数目L1变化而变化,当L1取值在250附近时,网络分类性能较好。同理,当L1固定时,L2取值160附近时,网络性能较好。当L1=250, L2=160时,SAE融合得到的特征识别精度最高,达95.878%。从图中我们也可以发现,网络性能随L1的变化起伏较L2而言更大,也就是说,第1个隐层数目对特征融合效果的影响较大。当特征输入栈式自编码器时,若第1个隐层对数据的重构误差较大,则这种误差将会在网络中累积,因此,网络的第1个隐层神经元数目取得相对多时,能增加其对输入数据的拟合程度,有效提升网络整体的性能。另外,在样本数量一定的情况下,网络神经元的数目并不是越多网络性能越好。随着神经元的增加,网络模型的参数会增多,网络参数的自由度增大,更有可能导致网络过拟合。

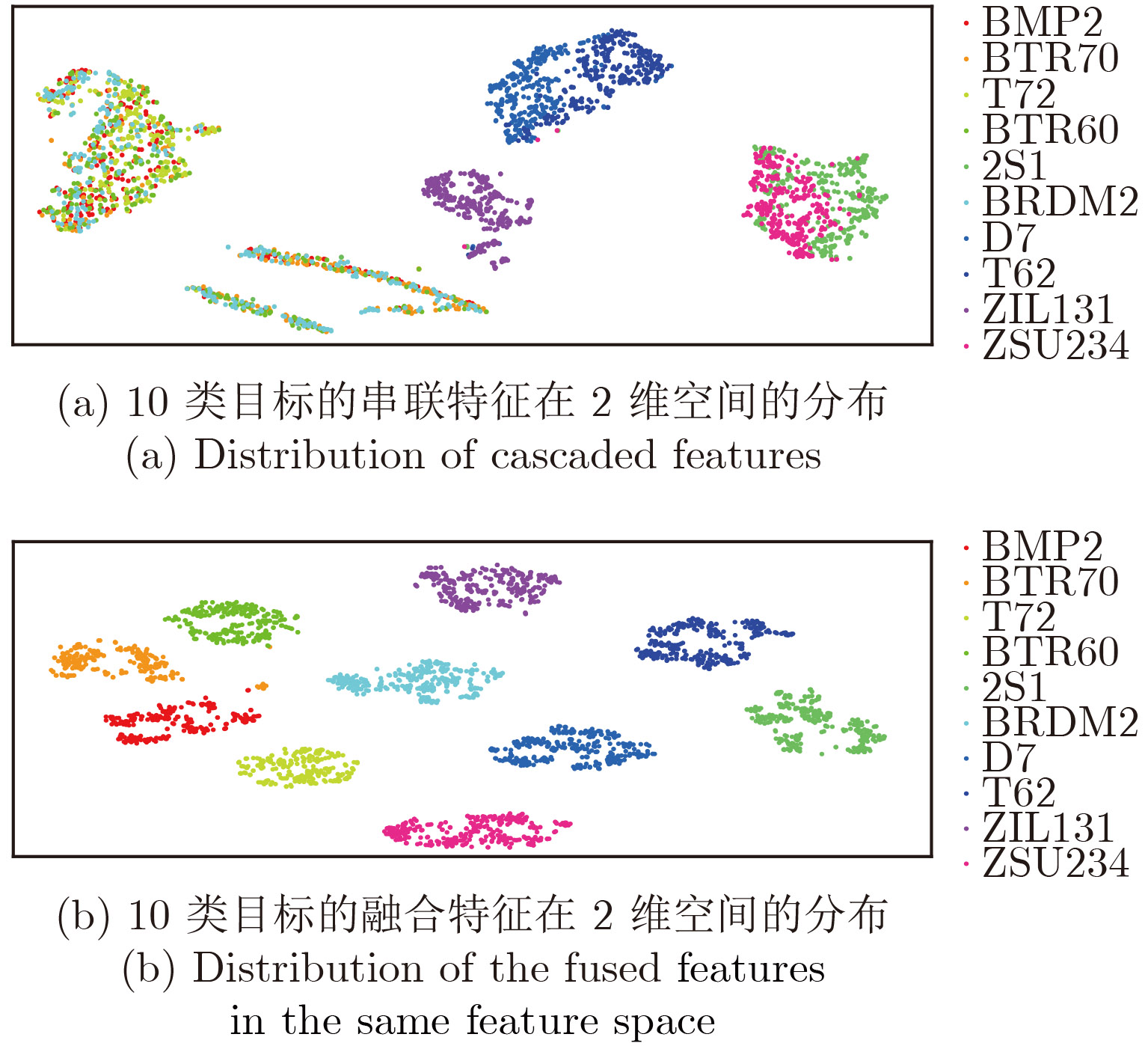

4.2 SAE特征融合前后对比实验为探究基于SAE特征融合的算法有效性,本实验分别提取了MSTAR数据集中17°俯仰角的SAR切片目标的100维基线特征与128维TPLBP特征。将特征串联成228维向量后与SAE融合特征进行比较。利用文献[21]中提出的t分布的随机邻域嵌入(t-distributed stochastic neighbor embeddingt-SEN)将串联特征和融合特征可视化,可以在2维空间中得到特征的分布,结果如图9。

|

图 9 串联特征与融合特征的分布 Fig.9 Distribution of cascaded features and fused features |

从特征分布图中可以看出,串联后的特征在2维空间中存在类间混叠,类内分散。对于外形结构相似性大的目标,如BMP2, BTR70, T72, BRDM2, BTR60这5类目标,串联特征在2维空间中的混叠程度较大,区分性较差。而经过栈式自编码器融合后,10类目标的融合特征在空间分布上类间距离更大,类内距离更加紧凑,彼此之间基本没有混叠。可以看出,SAE改变了原始特征的空间分布,从而实现特征之间的深度融合。而BMP2, BTR70, BTR60这3类目标的融合特征在特征空间中分布仍然相对紧凑,一方面是因为这3类目标在外形结构,纹理特征上较为相似,其特征表达本身相似度也较高。同时,也说明融合后的特征性能受原始特征性能的影响较大。虽然SAE能够通过重构输入特征,从输入数据中挖掘了更有效的信息,实现特征之间的优势互补,但融合后的特征性能仍然受到原始特征的约束。

另外,论文分别利用基线特征、纹理特征作为SAE网络的训练样本,与融合特征的识别性能比较。其中,SAE网络含两个隐层,调整网络结构和参数使分类性能达到最好。结果见表3。

| 表 3 特征分类结果 Tab.3 Classification accuracy of features |

上述结果可以看出,基线特征和TPLBP特征得到的目标识别精度分别为90.19%, 90.40%,融合后的特征识别精度达95.88%,平均识别精度提高了5%以上。除BRDM2与ZSU234之外,其余目标类别的识别精度均高于单特征。另外,TPLBP特征对BTR60具有最差的分类性能,而基线特征在该类别上区分度较好,通过特征融合,该类别的分类精度提高至91.79%。当目标纹理特征区分度不大时,利用基线特征对目标几何结构特性的描述,有效弥补了单一特征在某一类目标上的劣势。说明基于SAE的特征融合充分综合了基线特征中的几何结构信息和TPLBP中的纹理信息,利用两种特征中的互补信息,提高融合特征的可区分度。但总体上,融合特征在各个类别上的分类趋势基本和原始特征保持一致,在BMP2这一类别上,两类特征都表现较差,融合后虽然性能提升了近17%,但与别的类别相比,分类精度仍然最低。这说明特征融合在性能上受原始特征性能的限制,特征融合能实现特征间的优势互补,但不能完全弥补共同的劣势,因此,选择互补性大的特征能在特征维度较低的情况下有效提高融合效果。

4.3 不同特征的融合算法比较为比较不同特征组合之间的融合性能,本文提取了SAR图像的Gabor纹理特征,根据文献[22],设置参数

| 表 4 不同特征融合分类结果 Tab.4 Classification accuracy of different features |

上述结果可以看出,基线特征与Gabor纹理特征的融合结果优于Gabor特征和TPLBP特征的融合结果,原因在于基线特征与Gabor纹理特征分别描述了SAR图像的几何结构属性和纹理特性,不同属性的特征之间互补性较大,融合后的特征能更全面的描述目标。而Gabor特征和TPLBP特征都属于纹理特征,特征之间的冗余性较大,互补性相对较小,因此融合后性能提高较少。而本文提出的将基线特征和TPLBP纹理特征进行融合的方法,融合后的分类结果比基线特征与Gabor特征的融合效果更好。主要原因如下:第一,与Gabor特征相比,TPLBP特征在描述SAR图像的纹理特征上更具优势。TPLBP特征利用模块之间的纹理对比,使得特征抗噪性更强,其对于大尺度的纹理描述也更具优势。第二,TPLBP特征与基线特征具有更强的互补性。TPLBP特征不仅弥补了基线特征在灰度信息上的缺失,其旋转不变性对目标方位角变化不敏感。两种特征在原理上相互补充,因此融合后识别性能提升较大。

4.4 与其他分类算法对比为验证算法的有效性,将本文算法与其他算法进行比较,如表5所示。文献[23]利用稀疏表示(Sparse Representation based Classification, SRC)对MSTAR数据集的10类目标进行了分类,其分类精度为89.76%。将串联的SAR图像的基线特征和TPLBP纹理特征利用支持向量机(Support Vector Machines, SVM)分类器进行分类,得到的平均识别精度为90.73%。与SRC相比,基于SAE的特征融合特征表达更为有效,在分类性能上有所提高。与串联特征直接送入SVM中分类相比,基于栈式自编码器的特征融合算法在特征融合过程中,不仅能降低特征维度,同时通过改变特征在空间上的分布,提取出了区分性更好的融合特征。

| 表 5 不同算法识别精度对比 Tab.5 Classification accuracy comparison of different algorithms |

文献[24]中提出了直接利用卷积神经网络提取SAR图像特征,再训练softmax分类器,得到MSTAR数据集10类目标的分类精度为92.3%。本文利用含两个隐层的SAE网络,直接对SAR图像进行特征提取,经预训练和微调后,得到目标分类精度为93.6%。直接将图片作为神经网络的输入,虽然网络能提取的信息更丰富,但与输入特征相比,其输入数据量大大增加,原始SAR图像切片的大小为128×128,而串联特征的维度为228,复杂的输入数据需要更多的标注样本去拟合。在样本数据一定的情况下,复杂的网络输入,更容易使网络陷入欠拟合,导致网络性能不够稳定。

另外,基于特征融合的SAE算法在时间复杂度也更具优势。直接将SAR图像切片输入SAE中,网络输入层的神经元数目为16384,而融合算法中用到的SAE网络输入层的数目为228,因此,在训练过程中,本文算法需要训练的参数数目大大减少,两种算法的训练时间和测试时间见表6,本文算法再测试时间和训练时间上,速度提高了8~9倍。因此,在训练样本一定的情况下,基于SAE的特征融合能有效的减少神经元的数目,简化网络结构,提高算法效率。

| 表 6 不同算法训练时间与测试时间对比 Tab.6 Training time and testing time of different methods |

本文探讨了基于SAE的特征融合算法在SAR图像自动目标识别问题上的有效性。选取了冗余性小,互补性大的TPLBP局部纹理特征和基线特征,利用栈式自编码器的特征表达能力,将特征进行深度融合,提取出了区分度更大的深度特征。与其他算法相比,基于SAE的特征融合算法在特征选取、分类精度和时间效率上都具有优势。主要具有以下3个方面的特点:第一,选择了互补性大的特征,为SAE提供了更丰富的融合信息,实现了特征之间优势互补,融合效果提升较大。第二,特征提取降低了数据维度,从而简化了SAE的网络结构,降低了算法时间复杂度。第三,SAE的无监督学习算法,降低了深度模型对标注样本的需求,改变了原始特征的空间分布,使特征融合更加有效。融合特征的选择对目标识别具有较大的影响,本文应进一步研究合适的特征选择算法,更深入的探究不同特征之间的关系,从而选择出更具融合价值的特征,进一步提升识别的性能。

| [1] |

Jiang Y, Chen J and Wang R. Fusing local and global information for scene classification[J].

Optical Engineering, 2010, 49(4): 047001-047001-10. DOI:10.1117/1.3366666 ( 0) 0)

|

| [2] |

Liu Z and Liu C. Fusion of color, local spatial and global frequency information for face recognition[J].

Pattern Recognition, 2010, 43(8): 2882-2890. DOI:10.1016/j.patcog.2010.03.003 ( 0) 0)

|

| [3] |

Mohamed R and Mohamed M. A Hybrid feature extraction for satellite image segmentation using statistical global and local feature[C]. Proceedings of the Mediterranean Conference on Information & Communication Technologies 2015. Springer International Publishing, 2016: 247–255.

( 0) 0)

|

| [4] |

Zou J, Li W, Chen C, et al. Scene classification using local and global features with collaborative representation fusion[J].

Information Sciences, 2016, 348: 209-226. DOI:10.1016/j.ins.2016.02.021 ( 0) 0)

|

| [5] |

王大伟, 陈定荣, 何亦征. 面向目标识别的多特征图像融合技术综述[J].

航空电子技术, 2011, 42(2): 6-12. Wang Dawei, Chen Dingrong and He Yizheng. A survey of feature-level image fusion based on target recognition[J]. Avionics Technology, 2011, 42(2): 6-12. (  0) 0)

|

| [6] |

王璐, 张帆, 李伟, 等. 基于Gabor滤波器和局部纹理特征提取的SAR目标识别算法 2015年11月9日[J].

雷达学报, 2015, 4(6): 658-665. Wang Lu, Zhang Fan, Li Wei, et al. A method of SAR target recognition based on Gabor filter and local texture feature extraction[J]. Journal of Radars, 2015, 4(6): 658-665. (  0) 0)

|

| [7] |

Lin C, Peng F, Wang B H, et al. Research on PCA and KPCA self-fusion based MSTAR SAR automatic target recognition algorithm[J].

Journal of Electronic Science Technology, 2012, 10(4): 352-357. ( 0) 0)

|

| [8] |

Huan R, Liang R, and Pan Y. SAR target recognition with the fusion of LDA and ICA[C]. 2009 International Conference on Information Engineering and Computer Science, IEEE, Wuhan, China, 2009: 1–5.

( 0) 0)

|

| [9] |

Chaudhary M D and Upadhyay A B. Fusion of local and global features using stationary wavelet transform for efficient content based image retrieval[C]. 2014 IEEE Students' Conference on Electrical, Electronics and Computer Science (SCEECS), IEEE, Bhopal, India, 2014: 1–6.

( 0) 0)

|

| [10] |

Hinton G E and Salakhutdinov R R. Reducing the dimensionality of data with neural networks[J].

Science, 2006, 313(5786): 504-507. DOI:10.1126/science.1127647 ( 0) 0)

|

| [11] |

Geng J, Fan J, Wang H, et al. High-Resolution SAR image classification via deep convolutional autoencoders[J].

IEEE Geoscience & Remote Sensing Letters, 2015, 12(11): 1-5. ( 0) 0)

|

| [12] |

Chen Y, Lin Z, Zhao X, et al. Deep learning-based classification of hyperspectral data[J].

IEEE Journal of Selected Topics in Applied Earth Observations & Remote Sensing, 2014, 7(6): 2094-2107. ( 0) 0)

|

| [13] |

Sun Z, Xue L and Xu Y. Recognition of sar target based on multilayer auto-encoder and snn[J].

International Journal of Innovative Computing, Information and Control, 2013, 9(11): 4331-4341. ( 0) 0)

|

| [14] |

Chen Y W and Lin C J. Combining SVMs with Various Feature Selection[M]. In Feature Extraction: Foundations and Applications, Guyon I, Gunn S, Nikravesh M, and Zadeh L A Berlin, Germany: Springer, 2006: 315–324.

( 0) 0)

|

| [15] |

Chen Y W. Combining SVMs with various feature selection strategies[D]. [Master. dissertation], National Taiwan University, 2005.

( 0) 0)

|

| [16] |

El Darymli K, Mcguire P, Gill E W, et al. Characterization and statistical modeling of phase in single-channel synthetic aperture radar imagery[J].

IEEE Transactions on Aerospace and Electronic Systems, 2015, 51(3): 2071-2092. DOI:10.1109/TAES.2015.140711 ( 0) 0)

|

| [17] |

Kapur J N, Sahoo P K and Wong A K C. A new method for gray-level picture thresholding using the entropy of the histogram[J].

Computer vision, graphics, and image processing, 1985, 29(3): 273-285. DOI:10.1016/0734-189X(85)90125-2 ( 0) 0)

|

| [18] |

Mathworks. Morphology Fundamentals: Dilation and Erosion[OL]. http://tinyurl.com/q6zf.

( 0) 0)

|

| [19] |

Wolf L, Hassner T, and Taigman Y. Descriptor based methods in the wild[C]. Workshop on Faces in Real-Life Images: Detection, Alignment, and Recognition, 2008.

( 0) 0)

|

| [20] |

施彦, 韩力群, 廉小亲. 神经网络设计方法与实例分析[M]. 北京: 北京邮电大学出版社, 2009: 32–108.

Shi Yan, Han Liqun, and Lian Xiao qin. Neural Network Design and Case Analysis[M]. Beijing: Beijing University of Posts and Telecommunications Press, 2009: 32–108. (  0) 0)

|

| [21] |

Maaten L and Hinton G. Visualizing data using t-SNE[J].

Journal of Machine Learning Research, 2008, 9(Nov): 2579-2605. ( 0) 0)

|

| [22] |

Hu F, Zhang P, Yang R, et al. SAR target recognition based on Gabor filter and sub-block statistical feature[C]. 2009 IET International Radar Conference, 2009: 1–4.

( 0) 0)

|

| [23] |

Song H, Ji K, Zhang Y, et al. Sparse Representation-Based SAR Image Target Classification on the 10-Class MSTAR Data Set[J].

Applied Sciences, 2016, 6(1): 26 DOI:10.3390/app6010026 ( 0) 0)

|

| [24] |

Morgan D A. Deep convolutional neural networks for ATR from SAR imagery[C]. SPIE Defense Security. International Society for Optics and Photonics, 2015: 94750F-94750F-13.

( 0) 0)

|