合成孔径雷达(Synthetic Aperture Radar, SAR)是一种高分辨率成像雷达,与可见光、红外等遥感技术相比,可以全天时、全天候成像探测。合成孔径雷达具有穿透能力,可以监测和侦察隐蔽在植被下的目标[1]。SAR自问世以来已经被广泛应用于地球科学、气候变化研究、环境和地球系统监测、海洋资源利用、行星探测、战场感知侦察等领域,具有极高的民用价值和军用价值[1, 2, 3, 4]。SAR成像时受到系统固有特性的影响,使得其对目标的方位角十分敏感,方位角的变化将会导致差异很大的目标图像;由于特殊的相干成像机理,合成孔径雷达图像存在特有的斑点噪声,因此SAR图像与光学图像在视觉效果上差异很大。目标识别作为SAR应用的一个重要方向,在军事和民用领域都有广泛的应用。近年来,SAR分辨率越来越高,传感器模式增多,工作波段和极化方式越来越多元化,使得SAR图像中信息爆炸性增长,人工判读的工作量超出了人工迅速做出判断的极限,人工判读带来的主观和理解上的错误就难以避免。因此,SAR自动目标识别(Automatic Target Recognition, ATR)技术的研究显得尤为重要[2]。

SAR自动目标识别技术目前主要分为3类:基于模型的识别、基于模板的识别和基于机器学习的识别[5]。基于机器学习的识别技术和前两种方式的原理都不同,这里不作比较。基于模板的SAR ATR系统需要存储海量的目标模板,由于SAR图像不仅具有较强的斑点噪声,而且十分敏感易变,即SAR成像参数、目标姿态、俯仰角、目标配置甚至细微的周围环境的波动,都会使得目标图像特征产生较大差异。模板样本的获取、识别系统的设计和算法效率的提高都面临很大的困难。针对上述困难,基于模型的方法不需要存储大量目标模板,需要的存储空间较小,算法处理速度快,目标分辨能力高,而且在不同的工作条件下都能取得较好的识别效果,一定程度上解决了基于模板的识别方法在扩展工作条件下模板样本无限扩大的问题[6],因此基于模型的SAR ATR成为研究的热点。基于模型的SAR ATR系统不直接存储目标模板,而是通过目标模型实时在线地构造特征参数连续的目标SAR图像用于识别[7],目前使用较多的目标预测是基于3维散射中心模型的[3, 8, 9]。

本文实现了一种简化的基于模型的SAR ATR算法,该算法通过双向解析射线追踪法计算目标CAD模型的电磁散射,仿真并存储所得散射数据。识别时,对待测图像和散射数据所成图像分别提取目标区特征进行搜索匹配来完成识别。文章详细介绍了算法的流程,并分别用实测数据和仿真数据对算法进行了验证。文章接下来的结构如下:第2节介绍了本文所用的算法;第3节分别通过实测和仿真数据验证了算法的准确性;第4节对文章进行了总结。

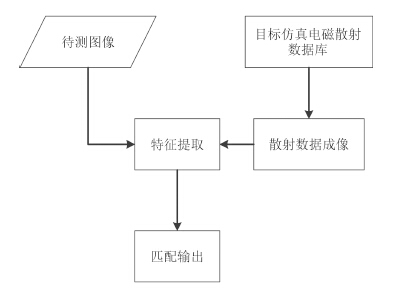

2 算法介绍本文实现的一种简化的基于模型的SAR自动目标识别算法整体流程如图 1所示。算法的整体思想是首先对需要识别的目标通过双向解析射线追踪法计算目标CAD模型的电磁散射,存储所得散射数据。在对目标进行识别时,对待识别目标SAR图像和散射数据成像所得的图像分别进行特征提取,通过搜索匹配得到和待识别目标的SAR图像最相似的仿真图像,从而识别出目标的类型,获取目标的方位角等信息。

|

图 1 基于模型的SAR自动目标识别算法整体流程 Fig.1 Overall process of model-based SAR ATR algorithm |

本文对地面车辆目标BMP2、BTR70、T72建立目标的仿真电磁散射数据库。本文使用一种双向解析射线追踪法[10](Bidirectional Analytic Ray Tracing,BART)来计算目标和粗糙面环境的复合电磁散射及其雷达散射截面(Radar Cross Section,RCS)。其主要思想是:将目标剖分成面元,对目标面元从入射和散射的逆方向两个方向上进行几何光学射线追踪,记录不同阶次的射线在目标面元或者边缘上的照射范围。双向解析射线追踪法相较于单向追踪包含了更多不同的散射机制,具体来说就是对于任意一个面元或边缘上追踪到的一对正反射线都构造一项多次散射项,该散射项由任意面元或边缘上的漫反射/衍射和正反追踪路径上的几何反射组成,计算其对散射场的贡献。双向解析射线追踪法采用多边形大面元或者面片剖分来处理3维电大体目标,通过多边形交并减的几何运算来精确地计算阴影,解析地描述射线的照射和反射;采用粗糙面元剖分来处理粗糙面背景,解析计算时同时考虑粗糙面元散射的相干分量和非相干分量,使得粗糙面的散射可以用类似平面元的方式来处理。因此,双向解析射线追踪法可以大大降低与目标电大尺寸相关的计算复杂度,还可以计算目标和粗糙面共存问题的复合散射。

2.2 SAR图像预处理与特征提取待测SAR图像通常既包含感兴趣的目标,又包含背景杂波,此外,SAR图像往往含有较强的斑点噪声,因此在进行目标识别时需要首先对输入的待检测图像数据进行预处理,将目标从杂波背景中分割出来,增强感兴趣的目标区图像,最大限度地减弱背景杂波和斑点噪声对识别性能的影响。

经过图像预处理后的图像可以进行特征提取。基于模型的SAR自动目标识别技术常用的特征包括目标区或阴影区轮廓特征、量化的目标幅值信息特征和散射特征。目标区或阴影区轮廓特征又叫做“标注特征”,这种特征不需要完整的电磁特征预测,可以有效地将图像像素信息分为目标、阴影或者背景,提取出图像上的很多信息;量化的目标幅值信息特征是将图像的像素信息量化成不同等级,可以提高鲁棒性,减少灰度保真的要求,降低计算相似度的数据的维度;散射特征非常敏感,它依赖于幅度图像的拓扑分析,例如峰值特征、脊特征、边缘特征等[11]。目标区轮廓特征简单易提取,搜索匹配的效果也很好,基于以上分析,本文提取的是目标区特征。

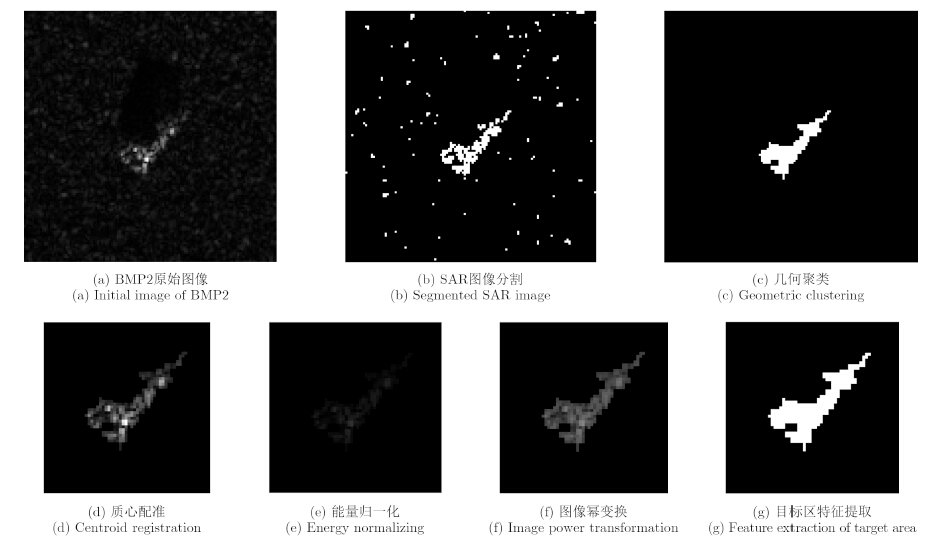

本文采用的SAR图像预处理与特征提取算法流程如图 2所示,其中目标区特征提取之前的图像预处理算法参考文献[4]。

|

图 2 SAR图像预处理与特征提取算法流程图 Fig.2 Overall process of SAR image preprocessing and feature extraction algorithm |

对于高分辨率雷达来说,在俯仰角较低的成像条件下,对于非均质区域的杂波分布可以采用Weibull分布来较好地描述,因此,工程上可以采用基于Weibull分布的模型来进行MSTAR图像的分割,其目标区分割阈值为T:

| $ T = b{( - {\rm{ln}}P)^{1/c}} $ | (1) |

式中,b为尺度因子,c为形状因子,P为背景杂波被检测为目标的虚警概率。

经过分割后,目标区域还存在着部分孤立的小亮点,这是分割过程产生的误差,通常都比较小,可以通过几何聚类的方式消除。目标在图像中的摆放具有随意性,目标在图像中相对位置的不同会对后续的搜索匹配结果产生重要影响,因此必须经过质心配准将目标的位置平移到图像的中心。质心配准分为两步:首先找到目标图像的质心;然后在图像中以目标质心为中心切割出更小尺寸的正方形目标区域,这是因为目标区在整个图像上所占的区域较小,而背景部分对目标识别是不利的。

目标到雷达的距离是不同的,SAR在进行数据采集时得到的回波强度也是不同的,反映到SAR图像上就是目标的灰度值范围有所不同。经过质心配准后可对SAR图像进行能量归一化,将图像灰度值归一化到同一范围内。经过能量归一化后图像幅度信息会减弱,可以采用幂变换来增强SAR图像中有利于鉴别目标的信息。幂变换的过程为:

| ${I^{(p)}}(i,j) = {[{I^{(g)}}(i,j)]^a} ,\begin{array}{*{20}{c}} {}&{} \end{array} 0 < a < 1$ | (2) |

其中,${{I}^{(g)}}$为能量归一化后的SAR图像,${{I}^{(p)}}$为幂变换增强后的图像。

经过前面的步骤,目标区已经分割出来。本文所需要的目标区特征只是目标区的二值化图像,因此直接将幂变换增强后的图像目标区设为1,其余部分设为0,就可以得到目标区特征。

图 3以BMP2的一幅图像作为实例,展示SAR图像预处理与特征提取算法的效果,其中图 3(d)-图 3(g)为质心配准时以质心为中心切割出的更小尺寸的正方形目标区域。

|

图 3 SAR图像预处理与特征提取 Fig.3 Preprocessing and feature extraction of a SAR image |

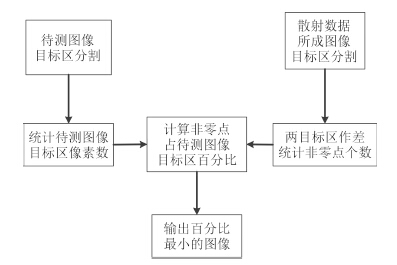

图像经过预处理和特征提取之后就可以进行搜索匹配,本文使用的搜索匹配算法流程如图 4所示。由图 4可知本文定义的匹配率为:

| \[{\rm{匹配率}} = 1 - \frac{待测图像目标区-散射数据所成图像目标区}{待测目标区总像素}\] | (3) |

|

图 4 搜索与匹配算法流程图 Fig.4 Overall process of search and matching algorithm |

待测图像经过预处理和特征提取之后,与目标SAR散射数据所成的图像进行匹配,搜索出匹配率最高的那幅图像输出,可以输出目标的类型和目标的方位角信息。

3 实验验证 3.1 MSTAR数据库简介与预处理参数设置当前用于研究SAR ATR的图像是美国国防高级研究计划署(Defense Advanced Research Project Agency,DARPA)和空军研究室(Air Force Research Laboratory,AFRL)发起的运动与静止目标获取与识别(Moving and Stationary Target Acquisition and Recognition,MSTAR)计划实测获取的地面静止目标SAR图像数据。该数据集利用分辨率为0.3 m×0.3 m的聚束式SAR采集回波数据,得到的地面军事车辆的HH极化的图像集。每幅图像的像素尺寸为128×128。数据库里包含BMP2、BTR70、T72共3大类7种型号的地物目标。同一大类里面不同型号的目标之间互为变形目标,它们的区别在于军事配置不同,如同类坦克上有无防护板、油箱,以及天线是否展开等;同类装甲车上有无炮筒,挡泥板和聚光灯等。考虑到SAR图像对方位因素十分敏感,故而数据库对每类目标都采集了大量不同方位的图像,方位范围为0°~360°,方位间隔约1°~2°[12]。

对于MSTAR数据库中SAR图像采用Weibull分布的双参数CFAR SAR图像分割[4]的依据是:

| $\left\{ \begin{array}{l} \!\! {如果}\mathop x\nolimits_i {\rm{ < }}T, \quad \mathop x\nolimits_i {为背景区域},{令}\mathop x\nolimits_i = 0\\ \!\! {如果}\mathop x\nolimits_i {\rm{ > }}T, \quad \mathop x\nolimits_i {为目标区域},{令}\mathop x\nolimits_i = 1 \end{array} \right.$ | (4) |

本文中背景杂波被检测为目标的虚警概率$P=0.0075$;几何聚类时,设置的面积阈值为15;质心配准时以质心为中心扩展为60×60像素,即可包含MSTAR数据中的目标;图像幂变换时$a=0.4$。

3.2 实测数据验证本节采用15°俯仰角时3大类目标包括BMP2、BTR70、T72在内各一种型号的数据作为待测图像,17°俯仰角时3大类目标包括BMP2、BTR70、T72在内各一种型号的数据作为被搜索图像。待测图像和被搜索图像目标类型和数量如表 1所示。

| 表 1 待测图像和被搜索图像目标类型和数量 Tab. 1 Target type and quantity for the test images and the images to be searched |

将待测图像集中的每一幅图像逐一与被搜索图像进行搜索匹配,统计目标类型识别的正确率。每一类目标识别的正确率及总的正确率如表 2所示。

| 表 2 目标识别正确率统计(不考虑方位角误差) Tab. 2 Target recognition accuracy statistics (Regardless of the azimuth error) |

将待测图像集中的每一幅图像逐一与被搜索图像进行搜索匹配,统计同时满足目标类型正确识别并且待测目标图像与搜索得到的目标图像之间方位角误差<5°(考虑180°模糊)的比率,数据如表 3所示。

| 表 3 目标识别正确率统计(考虑方位角误差) Tab. 3 Target recognition accuracy statistics (Considering the azimuth error) |

基于模型的SAR ATR算法是要实现对于任意一幅实测SAR图像都能在散射数据库中找到与之最匹配的目标,获得待测图像目标类型、方位角等信息。本节将实测图像作为待测图像,与BART计算的散射数据所成图像进行搜索匹配,验证本文算法的可行性。

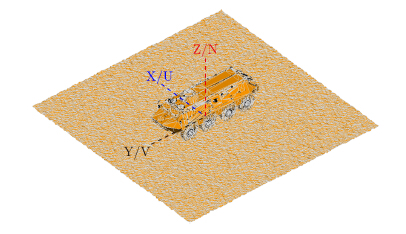

采用BART对BMP2、BTR70、T72模型进行散射模拟。BMP2长宽高为6.72 m×3.15 m×2.45 m,BTR70长宽高为7.53 m×2.80 m×2.32 m,T72长宽高为9.53 m×3.59 m×2.23 m,目标的CAD模型均为真实尺寸。为了使目标仿真环境接近真实场景,仿真时将目标的CAD模型放置在粗糙面场景上。粗糙面场景的参数为:粗糙面场景15 m×15 m,均方根高度1×$\lambda $,相关长度0.5×$\lambda $。以BTR70为例,图 5展示了BTR70在粗糙面上的CAD模型。

|

图 5 BTR70在粗糙面上的CAD模型 Fig.5 The CAD model of BTR70 on rough surface |

采用BART对模型进行数值散射模拟。BART计算参数来自MSTAR数据:

(1) 中心频率9.6 GHz,带宽0.6 GHz,采样128个点;

(2) $\theta $=75°(SAR俯仰角为15°);

(3) 中心角度f=0°,10°,20°,···,140°,145°,150°,155°,160°,170°共20个中心角度,在中心角度-1.79°~1.79°范围内采样128个点(方位向和距离向分辨率均为0.3 m)。

计算并存储3类目标的散射数据,散射数据成像后可以得到60幅仿真图像。

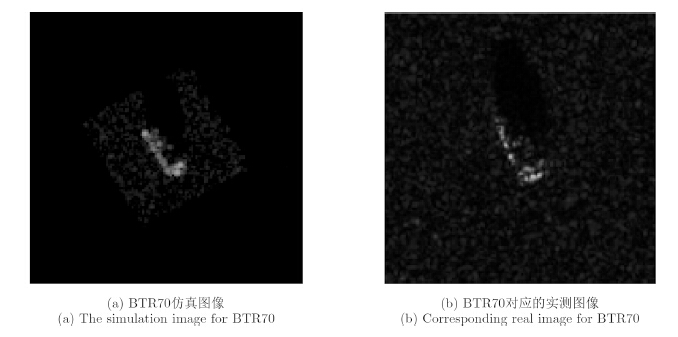

BART仿真得到的散射数据是频域数据,对其进行逆傅里叶变换即可得到时域图像。但是直接进行逆傅里叶变换得到的图像效果不好。本文对散射数据的两个维度分别进行3次样条插值后,加Kaiser窗进行滤波,最后做逆傅里叶变换得到图像。以BTR70为例,散射数据所成图像如图 6所示。

|

图 6 BTR70仿真和实测图像 Fig.6 The simulation image and corresponding real image for BTR70 |

图 6(a)为BTR70仿真图像,其方位角为160°,图 6(b)是其对应的实测图像,其方位角为157.006775°。可以看出仿真图像和实测图像是很相似的,可以进行搜索匹配。

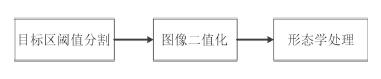

首先进行图像预处理。需要注意的是如果对仿真图像采用2.2节所述目标区分割方式,目标区的提取效果不好,因此对于仿真图像的目标区分割与实测图像的目标区分割方式略微不同,仿真图像目标区分割流程如图 7所示。

|

图 7 仿真图像目标区分割流程图 Fig.7 Overall process of simulation image target area segmentation |

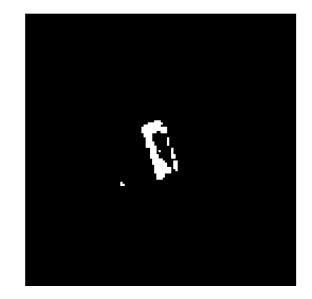

仿真图像有较强的旁瓣,但是图像目标区很明显,可以直接根据目标区和背景区像素值的分布设定一个经验阈值${{T}_{\rm tar}}$,令大于该阈值的区域,像素值不变,其余区域均设为某一背景像素值。令每幅图像像素均值为Ave,经过对60幅散射数据所成图像统计分析后,对BMP2、BTR70、T72分别设定一个自适应阈值Ttar=Ave/1.7,Ttar=Ave/1.985、Ttar=Ave/1.4771。大于${{T}_{\rm tar}}$的区域,像素值不变,其余区域像素值设为-70。以图 6(a)中BTR70为例,经过这一处理之后的图像如图 8所示。

|

图 8 仿真图像目标区阈值分割后图像 Fig.8 Simulation image after threshold segmentation of target area |

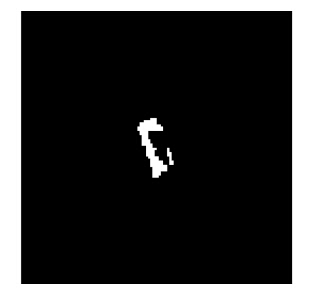

可以看到经过阈值分割后图像保留了目标区信息,去除了没用的背景和旁瓣信息,但是还存在一些小的亮点,需要通过形态学运算来消除。形态学运算是针对二值化图像的,再对上述图像进行二值化,这里同样采取阈值处理的方式,取像素值的最大值为${{t}_{\rm max}}$,每一点的像素值为${{x}_{i}}$,

| $\left\{ \begin{array}{l} \!\! {如果}\mathop x\nolimits_i {\rm{ < }}{0.8{t_{\rm max}}},\quad {令}\mathop x\nolimits_i = 0\\ \!\! {如果}\mathop x\nolimits_i {\rm{ > }}{0.8{t_{\rm max}}},\quad {令}\mathop x\nolimits_i = 1 \end{array} \right.$ | (5) |

这里取阈值为$0.8{{t}_{\rm max}}$,可以较为完整地保留目标区信息,滤除无用的分割误差。对二值化后的图像进行膨胀、腐蚀,保留面积大于10的部分,得到如图 9所示的图像。

|

图 9 仿真图像目标区分割效果图 Fig.9 Simulation image after target area segmentation |

经过目标区分割后的仿真图像采用2.2节所述的处理方式,对图像进行质心配准、能量归一化、图像幂变换和特征提取,之后就可以进行搜索匹配,算法同第2.3节所述。

取出3.2节中15°俯仰角下MSTAR数据库中BMP2、BTR70、T72实测数据作为待测图像,与散射数据所成图像进行搜索匹配,统计类型分类正确的概率。统计结果如表 4所示。

| 表 4 目标识别正确率统计(仅考虑类型正确) Tab. 4 Target recognition accuracy statistics (Considering only the correct type) |

由仿真参数可知,仿真的角度集中在140°~160°,考虑180°模糊,取出上述实测图像中方位角在140°~160°和320°~340°的实测图像作为待测图像,与散射数据所成图像进行搜索匹配,统计类型分类正确的概率,结果如表 5所示。

| 表 5 目标识别正确率统计(仅考虑类型正确)Tab. 5 Target recognition accuracy statistics (Considering only the correct type) |

由表 4和表 5可知,BMP2和T72的类型识别效果很好,BTR70在角度受限的范围内类型识别效果很好,但是对于196幅实测数据识别时正确率很低,这是由于BTR70的自适应阈值在140°~160°范围内对仿真图像的分割效果较好,而在远离该角度范围时,分割效果变差,识别出错的概率增大。

在表 5结果基础上,统计同时满足类型分类正确并且待测图像与搜索得到的图像之间方位角误差<10°的比率,结果如表 6所示。

| 表 6 目标识别正确率统计(考虑方位角误差)Tab. 6 Target recognition accuracy statistics (Considering the azimuth error) |

由表 4~表 6可知,T72不仅类型分类正确率高,而且要求待测图像与搜索得到的图像之间方位角误差<10°时的识别效果也很好,可以证明本文提出的算法是有效可行的。

BMP2类型分类正确率高,但是要求待测图像与搜索得到的图像之间方位角误差<10°时正确率迅速下降。由BMP2和BTR70的识别效果可知,实测数据搜索仿真数据还存在很大困难,CAD仿真模拟的效果对识别率的影响很大,仿真有待进一步完善。

取出BMP2、BTR70和T72中心角度f=10°,30°,50°,··· ,150°,170°的散射数据,取出3.2节中15°俯仰角下MSTAR数据库中BMP2、BTR70、T72实测数据作为待测图像,与散射数据所成29幅图像进行搜索匹配,统计类型分类正确的概率。统计结果如表 7所示。

| 表 7 目标识别正确率统计(仅考虑类型正确)Tab. 7 Target recognition accuracy statistics (Considering only the correct type) |

对比表 4与表 7可以看出,仿真的角度越多,仿真数据越充分,待测图像分类正确的概率越大。

4 结论基于模型的SAR自动目标识别算法不需要存储大量的模板,可以部分地解决扩展工作条件下的目标识别问题,是SAR自动目标识别的研究趋势。本文实现的简化的基于模型的SAR自动目标识别算法简单易实现,算法所需时间短,目标分类识别的效果较好,在识别目标类型的同时还可以获得目标的方位角信息。当然,本文还存在着不足之处,本文考虑扩展工作条件不足,另外对于仿真图像的搜索很大程度上依赖于仿真图像的效果,如果仿真效果不好,对识别效果影响很大。后期还需进一步完善仿真,算法流程里还可以考虑在搜索匹配之前加入方位角估计,缩小搜索范围,提高速度。

| [1] | 张红, 王超, 张波, 等. 高分辨率SAR 图像目标识别[M]. 北 京:科学出版社, 2009: 4-7. Zhang Hong, Wang Chao, Zhang Bo, et al.. High-Resolution SAR Image Target Recognition[M]. Beijing: Science Press, 2009: 4-7.( 2) 2) |

| [2] | Moreira A, Prats-Iraola P, Younis M, et al.. A tutorial on synthetic aperture radar[J]. IEEE Geoscience and Remote Sensing Magazine, 2013, 1(1): 6-43.( 2) 2) |

| [3] | 程肖. 基于散射中心模型的 SAR 图像自动目标识别[D]. [硕士 论文], 国防科学技术大学, 2009. Cheng Xiao. SAR ATR algorithm based on the scattering center model[D]. [Master dissertation], National University of Defense Technology, 2009.( 2) 2) |

| [4] | 裴季方. 基于邻域判别嵌入的SAR 自动目标识别研究[D]. [硕 士论文], 电子科技大学, 2013. Pei Ji-fang. SAR ATR research based on neighborhood judging embedded method[D]. [Master dissertation], University of Electronic Science and Technology of China, 2013.( 3) 3) |

| [5] | Zhou J, Shi Z, Cheng X, et al.. Automatic target recognition of SAR images based on global scattering center model[J]. IEEE Transactions on Geoscience and Remote Sensing, 2011, 49(10): 3713-3729.( 1) 1) |

| [6] | 张锐, 洪峻, 明峰. 基于目标CSAR回波模型的SAR自动目标 识别算法[J]. 电子与信息学报, 2011, 33(1): 27-32. Zhang Rui, Hong Jun, and Ming Feng. SAR ATR algorithm based on the CSAR echo model[J]. Journal of Electronics & Information Technology, 2011, 33(1): 27-32.( 1) 1) |

| [7] | Chiang H C, Moses R L, and Potter L C. Model-based classification of radar images[J]. IEEE Transactions on Information Theory, 2000, 46(5): 1842-1854.( 1) 1) |

| [8] | Jones G and Bhanu B. Recognition of articulated and occluded objects[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1999, 21(7): 603-613.( 1) 1) |

| [9] | Boshra M and Bhanu B. Predicting performance of object recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2000, 22(9): 956-969.( 1) 1) |

| [10] | Xu F and Jin Y Q. Bidirectional analytic ray tracing for fast computation of composite scattering from electric-large target over a randomly rough surface[J]. IEEE Transactions on Antennas and Propagation, 2009, 57(5): 1495-1505.( 1) 1) |

| [11] | Wissinger J, Ristroph R, Diemunsch J R, et al.. MSTAR’s extensible search engine and model-based inferencing toolkit[C]. Proceedings SPIE Algorithms for Synthetic Aperture Radar Imagery VI, 1999, 3721: 554-570.( 1) 1) |

| [12] | Ross T D, Worrell S W, Velten V J, et al.. Standard SAR ATR evaluation experiments using the MSTAR public release data set[C]. Proceedings SPIE Algorithms for Synthetic Aperture Radar Imagery V, 1998, 3370: 566-573.( 1) 1) |

2015, Vol. 4

2015, Vol. 4